阅读之前看这里👉:博主是正在学习数据分析的一员,博客记录的是在学习过程中一些总结,也希望和大家一起进步,在记录之时,未免存在很多疏漏和不全,如有问题,还请私聊博主指正。

博客地址:天阑之蓝的博客,学习过程中不免有困难和迷茫,希望大家都能在这学习的过程中肯定自己,超越自己,最终创造自己。

目录

1.决策树原理

1.1原理

决策树呈树形结构,在分类问题中,表示基于特征对实例进行分类的过程。可以认为是if-then规则的集合,也可以认为是定义在特征空间与类空间上的概率分布。学习时,利用训练数据,根据损失函数最小化的原则建立决策树模型;预测时,对新的数据,利用决策模型进行分类。

定义:分类决策树模型是一种描述对实例进行分类的树形结构。决策树由结点和有向边组成。结点有两种类型:内部结点和叶结点。内部结点表示一个特征或属性,叶结点表示一个类。

自己的理解:决策树算法,无论是哪种,其目的都是为了让模型的不确定性降低的越快越好,基于其评价指标的不同,主要是ID3算法,C4.5算法和CART算法,其中ID3算法的评价指标是信息增益,C4.5算法的评价指标是信息增益率,CART算法的评价指标是基尼系数。

1.2如何学习一棵决策树?

决策树的学习本质上就是从训练数据集中归纳出一组分类规则,使它与训练数据矛盾较小的同时具有较强的泛华能力。从另一个角度看,学习也是基于训练数据集估计条件概率模型。

决策树的损失函数通常是正则化的极大似然函数,学习的策略是以损失函数为目标函数的最小化(说完了策略,该说算法了)。

由于这个最小化问题是一个NP完全问题,现实中,我们通常采用启发式算法(这里,面试官可能会问什么是启发式算法,要有准备,SMO算法就是启发式算法)来近似求解这一最优化问题,得到的决策树是次最优的。

该启发式算法可分为三步:

- 特征选择

- 模型生成

- 决策树的剪枝

1.3能具体谈谈这三个步骤吗?

从总体上看,这三个步骤就是一个递归地选择最优特征,并根据该特征对训练数据进行分割,使得对各个子数据集有一个最好的分类的过程,这个过程就是划分特征空间,构建决策树的过程。

1.4如何选择最优特征呢?

简单讲,根据特征的分类能力去选择最优特征,特征分类能力的衡量通常采用信息增益或信息增益比。

1.5递归的终止条件是什么呢?

通常有两个终止条件,一是所有训练数据子集被基本正确分类。二是没有合适的特征可选,即可用特征为0,或者可用特征的信息增益或信息增益比都很小了。

2.谈谈对信息增益和信息增益率的理解?

特征选择的准则就是信息增益和信息增益比。

首先给出信息熵和条件熵的定义:

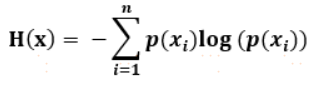

从概率统计的角度看,信息熵是对随机变量不确定性的度量,也可以说是对随机变量的概率分布的一个衡量。

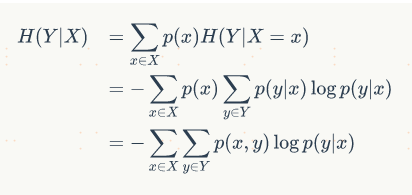

条件熵,即为随机事件x发生的条件下y事件的信息熵的期望,即表示在已知随机变量下x的条件下随机变量y的不确定性的期望,强调的是随机事件x对随机事件y的不确定性的影响。

当熵和条件熵的概率由数据估计(极大似然估计)得到时,所对应的熵与条件熵分别成为经验熵和经验条件熵。

信息增益(互信息):表示得知特征x的信息而使得类y的信息的不确定性减少的程度。定义为随机变量y的信息熵减去考虑随机变量x的y的条件熵,衡量在考虑随机变量x的情况下y的不确定性减少的程度:

特征 A A A对训练数据集 D D D的信息增益为 g ( D , A ) g(D,A) g(D,A),定义为集合 D D D的经验熵 H ( D ) H(D) H(D)与特征 A A A给定条件下 D D D的经验条件熵 H ( D ∣ A ) H(D|A) H(D∣

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

372

372

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?