0. 前言

上一课讲到了过拟合。什么是过拟合、过拟合什么时候发生、怎么处理过拟合等。其中有一种解决过拟合的方法是Regularized,这一节课我们将会讲解这种方法。

1. Regularization Hypothesis

- 我们知道,多阶多项式包含低阶多项式。

那么在高阶多项式中加入一些限定条件,使它近似为低阶多项式即可。这种函数近似曾被称之为不适定问题(ill-posed problem)。 - 如何进行近似呢?首先十阶多项式和二阶多项式的形式为:

若果我们将 w2,w3,...w10 w 2 , w 3 , . . . w 10 变成0,那么高阶就会变成了低阶。 - 我们为什么要这么做呢?直接使用低阶多项式不是更加方便吗?这样做的目的是拓展我们的视野,为即将讨论的问题做准备。刚刚我们讨论的限制是

H10

H

10

高阶部分的权重w限制为0,这是比较苛刻的一种限制。下面,我们把这个限制条件变得更宽松一点,即令任意8个权重w为0,并不非要限定

w3∼w10

w

3

∼

w

10

为0,这个Looser Constraint可以写成:

∑q=010(wq≠0)≤3 ∑ q = 0 10 ( w q ≠ 0 ) ≤ 3

也就只是限定了w不为0的个数,并不限定必须是高阶的w。这种hypothesis记为 H'2 H ′ 2 ,称为sparse hypothesis set,它与 H2 H 2 和 H10 H 10 的关系为:

H2⊂H′2⊂H10 H 2 ⊂ H 2 ′ ⊂ H 10 - 事实上这一种方法是NP-hard的,我们没法知道哪几项为0比较好。所以,还要转换为另一种易于求解的限定条件。那么,我们寻找一种更容易求解的宽松的限定条件Softer Constraint,即:

∑q=010w2q=∥w∥2≤C ∑ q = 0 10 w q 2 = ‖ w ‖ 2 ≤ C

其中,C是常数,也就是说,所有的权重w的平方和的大小不超过C,我们把这种hypothesis sets记为H(C)。 - H'2 H ′ 2 与H(C)的关系是,它们之间有重叠,有交集的部分,但是没有完全包含的关系,也不一定相等。对应H(C),C值越大,限定的范围越大,即越宽松。当C无限大的时候,即限定条件非常宽松,相当于没有加上任何限制,就与H10没有什么两样。H(C)称为regularized hypothesis set,这种形式的限定条件是可以进行求解的,我们把求解的满足限定条件的权重w记为 wREG w R E G 。接下来就要探讨如何求解 wREG w R E G 。

2. Weight Decay Regularization

- 我们的目的是:

- 采用梯度下降算法,以及拉格朗日求约束条件下的极值问题,得到最优结果需要满足条件:

其中 λ λ 就是拉格朗日系数,我们的目标就变成了求解上述公式。

已知∇Ein是Ein对wREG的导数,而2λNwREG也可以看成是λNw2REG的导数。那么平行等式左边可以看成一个函数的导数,导数为零,即求该函数的最小值。也就是说,问题转换为最小化该函数:

-

λ

λ

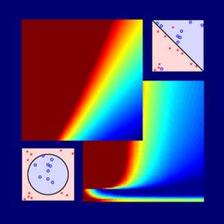

的值也会影响得到的曲线:

λ λ 一般取比较小的值就能达到良好的拟合效果,过大过小都有问题,但究竟取什么值,要根据具体训练数据和模型进行分析与调试。

3. Regularization and VC Theory

- VC维与Regularization的关系:根据VC Dimension理论,整个hypothesis set的

dVC=d˘+1

d

V

C

=

d

˘

+

1

,这是因为所有的w都考虑了,没有任何限制条件。而引入限定条件的情况下,当

λ>0

λ

>

0

时,有

deff(H,A)≤dVC d e f f ( H , A ) ≤ d V C

当 λ=0 λ = 0 时,此时VC维是最大的,随着 λ λ 的增加而不断减小。

4. General Regularizer

- 那么通用的Regularizers,即Ω(w)(Ω(w)为

Ein和Eout

E

i

n

和

E

o

u

t

的差值),应该选择什么样的形式呢?一般地,我们会朝着目标函数的方向进行选取。有三种方式:

接下来,介绍两种Regularizer:L2和L1:

- 下面来看一下λ如何取值,首先,若stochastic noise不同,那么一般情况下,λ取值有如下特点:

从图中可以看出,stochastic noise越大,λ越大。

另一种情况,不同的deterministic noise,λ取值有如下特点:

从这两张图片可以看出,噪声越大或者目标函数复杂度越高,那么所需要的 λ λ 就越大,得到的结果也更差。但是大多数情况下,noise是不可知的,这种情况下如何选择λ?这部分内容,我们下节课将会讨论。

5. 总结

这节课主要讲解了Regularization,我们在高阶多项式中加上限制条件之后,将问题转化为 Eaug E a u g 最小化问题。其实这一过程就是减小VC维的过程。最后,介绍regularization是通用的机器学习工具,设计方法通常包括target-dependent,plausible,friendly等等。选取合适的 λ λ 能够得到最佳的 Eout E o u t ,但是如何找到最佳的 λ λ 仍是个问题,下节课我们将会介绍。

292

292

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?