A Dual-Stage Attention-Based

Recurrent Neural Network for Time Series Prediction

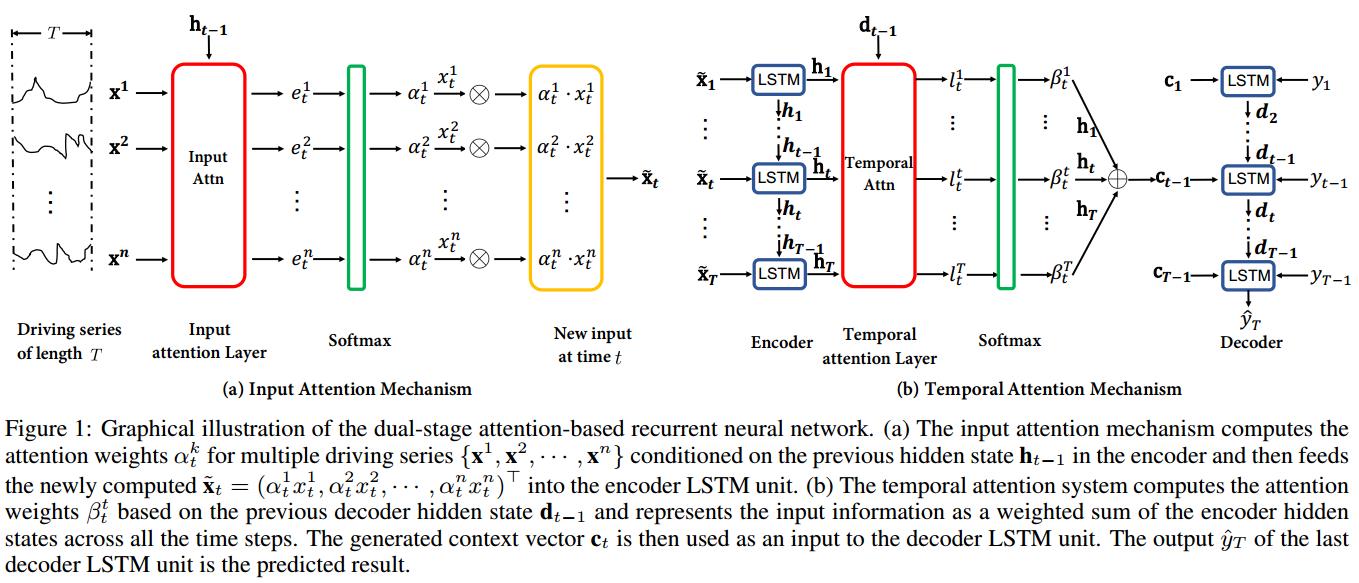

论文提出了基于注意力机制的两阶段循环神经网络(DA-RNN),在第一阶段(encoder),引入input attention mechanism对每一时刻的外部输入自适应性地提取相关性;在第二阶段(decoder),引入temporal attention mechanism捕获encoder的长期时序依赖信息。

任务

时间序列预测,给定1~T-1时刻的目标序列以及1~T-1时刻的外部序列,预测T时刻的目标值。

模型结构

encoder

1.使用LSTM作为encoder和decoder,其中状态更新如下:

论文提出了一种名为DA-RNN的双阶段注意力循环神经网络,用于时间序列预测。该模型在encoder阶段采用input attention机制关注外部输入的相关性,而在decoder阶段通过temporal attention机制捕捉长期时序依赖。在多个数据集上与ARIMA、NARX RNN等模型对比,DA-RNN表现最佳。

论文提出了一种名为DA-RNN的双阶段注意力循环神经网络,用于时间序列预测。该模型在encoder阶段采用input attention机制关注外部输入的相关性,而在decoder阶段通过temporal attention机制捕捉长期时序依赖。在多个数据集上与ARIMA、NARX RNN等模型对比,DA-RNN表现最佳。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3575

3575

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?