Practical Lessons from Predicting Clicks on Ads at Facebook

整体思路

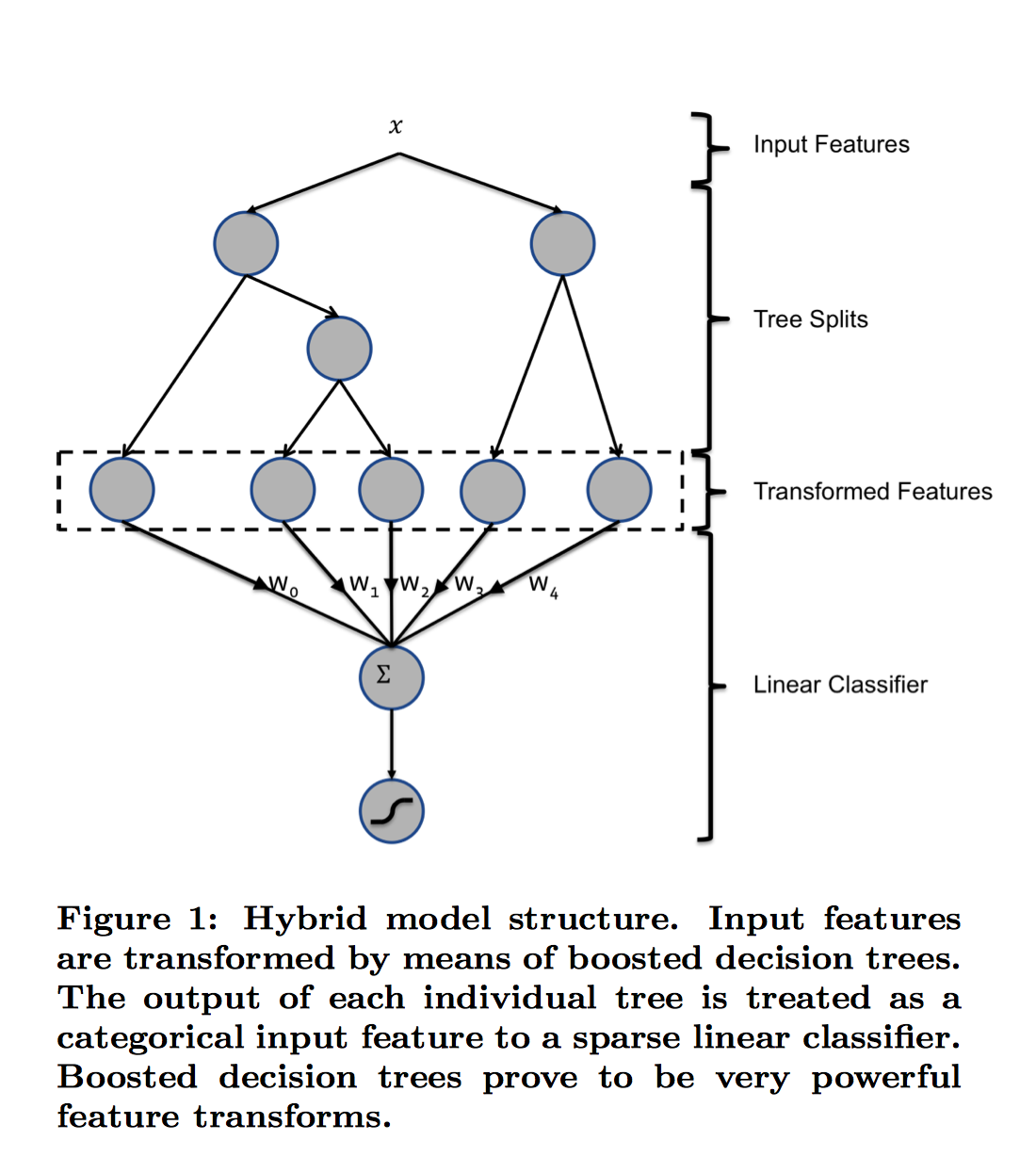

文章主要将gbdt与lr融合,效果得到较大的提升。

图中共有两棵树,x为一条输入样本,遍历两棵树后,x样本分别落到两颗树的叶子节点上,每个叶子节点对应LR一维特征,那么通过遍历树,就得到了该样本对应的所有LR特征。构造的新特征向量是取值0/1的。举例来说:上图有两棵树,左树有三个叶子节点,右树有两个叶子节点,最终的特征即为五维的向量。对于输入x,假设他落在左树第一个节点,编码[1,0,0],落在右树第二个节点则编码[0,1],所以整体的编码为[1,0,0,0,1],这类编码作为特征,输入到LR中进行分类。

评价指标

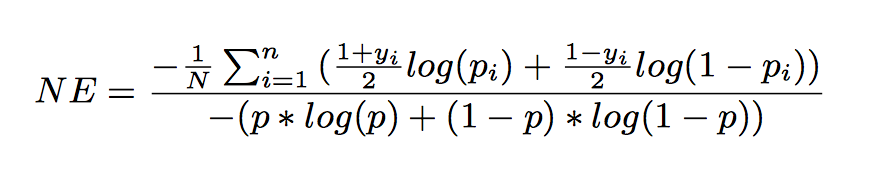

在本文中,用的是Normalized Entrophy(NE)和Calibration.

Normalized entrophy

- NE等于预测的log loss除以background CTR的熵

- NE越小模型性能越好

- 除去background CTR的熵,使得NE对background CTR不敏感

- p代表平均经验CTR

Calibration

- Calibration校准是平均预测CTR与经验CTR的比值,它是一个比例。

- Calibration越接近1,模型性能越好

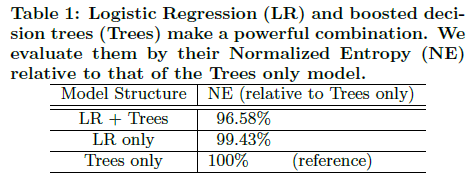

从最后的实验结果来看:将LR和GBDT进行组合模型的性能指标(NE)相比于没有经过树进行特征转化的标准交叉熵(NE)提升超过了3.4%(相比于特征工程只能在千分位上对NE进行降低,可以看出,GBDT+LR这种组合具有一个非常显著的提升)!

可以参考我的github来看看源代码,如有错误,欢迎交流。

958

958

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?