最近要做行级别的手写文件检测工作,将CASIA-HWDB2.x(offline)数据进行合并,生成了page level的数据集,还带有相应的bbox。如果大家想交流ocr相关的工作可以加群(文章末尾):

CASIA-HWDB2.x(offline)数据集下载地址:http://www.nlpr.ia.ac.cn/databases/handwriting/Download.html

我所下载的是这一部分:

CASIA-HWDB2.x(offline)数据集解析可以参考:https://www.freesion.com/article/6894959465/

解析完后HWDB2.xTrain_images下的图片:

图片预览:

001-P16_0.jpg:

解析完后HWDB2.xTrain_label下的label:

label预览:

001-P16_0.txt:

2002年以来,国内企业家包括许多著名企业家在内涉嫌违法犯罪被捕入

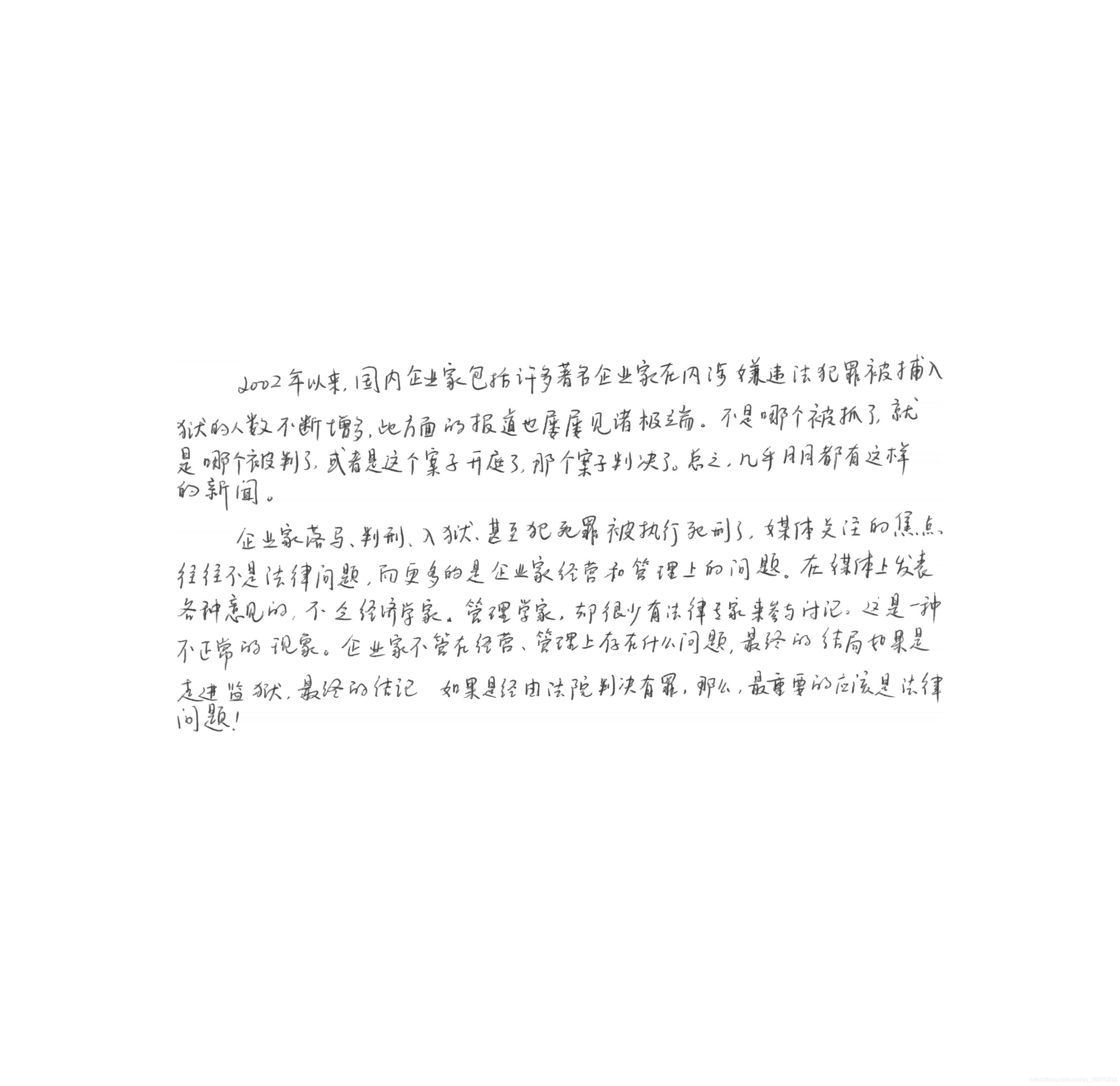

现在进入主题,将解析好的图片拼接成整页的形式:

001-P16,page结果预览:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1638

1638

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?