感知机模型

感知机是一种二类分类的线性模型,它是由误分类驱动的,属于判别模型。说白了,它的实质就是输入空间或特征空间中的一个分离超平面。

《统计学习方法》中的定义:

学习策略

假设训练数据集是线性可分的,感知机学习的目标是求得一个能够将训练集正实例点和负实例点完全分开的分离超平面。

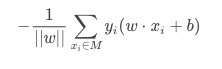

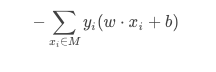

在这里,损失函数选择误分类点到超平面S的总距离:

其中M表示误分类点的集合。不考虑1/||w||,得到最终的感知机损失函数:

学习算法

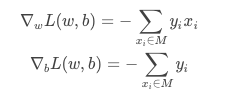

我们上面选择的损失函数是可导的,因此可以采用一般的梯度下降法对感知机的参数进行学习,这里我们采用随机梯度下降法。首先我们可以推导得到损失函数对于参数w与b的梯度:

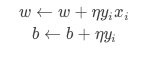

对于随机梯度下降法而言,我们选取一个误分类点(xi,yi),得到w和b的更新式:

这种学习算法的几何意义是:当一个实例点被误分类时,即位于分离超平面的错误一侧时,则调整w和b的值,使得分离超平面向该误分类点的一侧移动,以减少误分类点与超平面的距离,直至超平面越过该误分类点使其被正确分类。

算法的收敛性

Novikoff定理表明,对于线性可分数据集感知机学习算法原始形式收敛,即经过有限次迭代可以得到一个将训练数据集完全正确划分的分离超平面及感知机模型。

对(2)中的R

与γ进行理解。如果R越大,也就是max||x^i||越大,此时相当于有一个点距离原点很远,在初始化时,我们常常初始化w=0,b=0,所以我们要到达正确的分界面所需要的迭代次数也就越多,因此上界越大;如果γ越小,即min{yi(wopt⋅xi+bopt)}

越小,也就是说,对于点xi,yi来说,虽然它被正确分类,但是它离最优分界面wopt,bopt很近,所以很容易就因为在对其它点进行更新时,导致这个点被误分类,因而迭代次数的上界越大。

1057

1057

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?