L2 正则化的目的就是为了让权重衰减到更小的值,在一定程度上减少模型过拟合的问题,所以权重衰减也叫 L2 正则化。

参考:

- https://blog.csdn.net/weixin_44936889/article/details/103705435

- https://microstrong.blog.csdn.net/article/details/80867468

1、L2 正则化与权重衰减系数

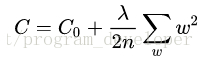

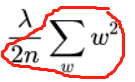

L2 正则化就是在代价函数后面再加上一个正则化项:

其中C0代表原始的代价函数,后面那一项就是L2正则化项,它是这样来的:所有参数 w 的平方的和,除以训练集的样本大小 n。λ 就是正则项系数,权衡正则项与 C0 项的比重。另外还有一个系数1/2,1/2。 1/2 经常会看到,主要是为了后面求导的结果方便,后面那一项求导会产生一个 2,与 1/2 相乘刚好凑整为 1。系数 λ 就是权重衰减系数。

2、为什么可以对权重进行衰减

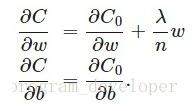

我们对加入 L2 正则化后的代价函数进行推导,先求导:

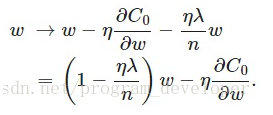

可以发现L2正则化项对 b 的更新没有影响,但是对于 w 的更新有影响:

在不使用 L2 正则化时,求导结果中 w 前系数为 1,现在 w 前面系数为1-ηλ/n,因为 η、λ、n 都是正的,所以 1-ηλ/n 小于 1,它的效果是减小 w,这也就是权重衰减(weight decay)的由来。当然考虑到后面的导数项,w 最终的值可能增大也可能减小。

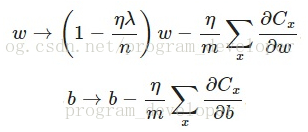

另外,需要提一下,对于基于 mini-batch 的随机梯度下降,w和b更新的公式跟上面给出的有点不同:

对比上面 w 的更新公式,可以发现后面那一项变了,变成所有导数加和,乘以 η 再除以 m,m 是一个 mini-batch 中样本的个数。

3、权重衰减(L2正则化)的作用

作用: 权重衰减(L2正则化)可以避免模型过拟合问题。

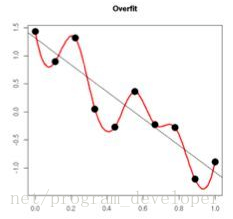

思考: L2正则化项有让w变小的效果,但是为什么w变小可以防止过拟合呢?

原理:

(1)从模型的复杂度上解释:更小的权值w,从某种意义上说,表示网络的复杂度更低,对数据的拟合更好(这个法则也叫做奥卡姆剃刀),而在实际应用中,也验证了这一点,L2正则化的效果往往好于未经正则化的效果。

(2)从数学方面的解释:过拟合的时候,拟合函数的系数往往非常大,为什么?如下图所示,过拟合,就是拟合函数需要顾忌每一个点,最终形成的拟合函数波动很大。在某些很小的区间里,函数值的变化很剧烈。这就意味着函数在某些小区间里的导数值(绝对值)非常大,由于自变量值可大可小,所以只有系数足够大,才能保证导数值很大。而正则化是通过约束参数的范数使其不要太大,所以可以在一定程度上减少过拟合情况。

4、TensorFlow 版本的 weight decay 源码实现

参考:https://blog.csdn.net/weixin_44936889/article/details/103705435

其中的 tf.nn.l2_loss(weights) 指的是

5、PyTorch 实现

参考:https://blog.csdn.net/qq_39463274/article/details/105296890

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?