1.算力市场选择适合自己的显卡

2.这里选择3090显卡,点击7卡可租。

3.选择计费规则,计费规则有四种,按量计费、包日、包周、包月。这里选择按量计费,随开随用。

4.设置环境的基础镜像,可选AutoDL的基础镜像,也可选社区提供的某个开源项目的镜像,也可是自己保存的镜像。这里选择基础镜像。然后点击立即创建,等待环境创建。

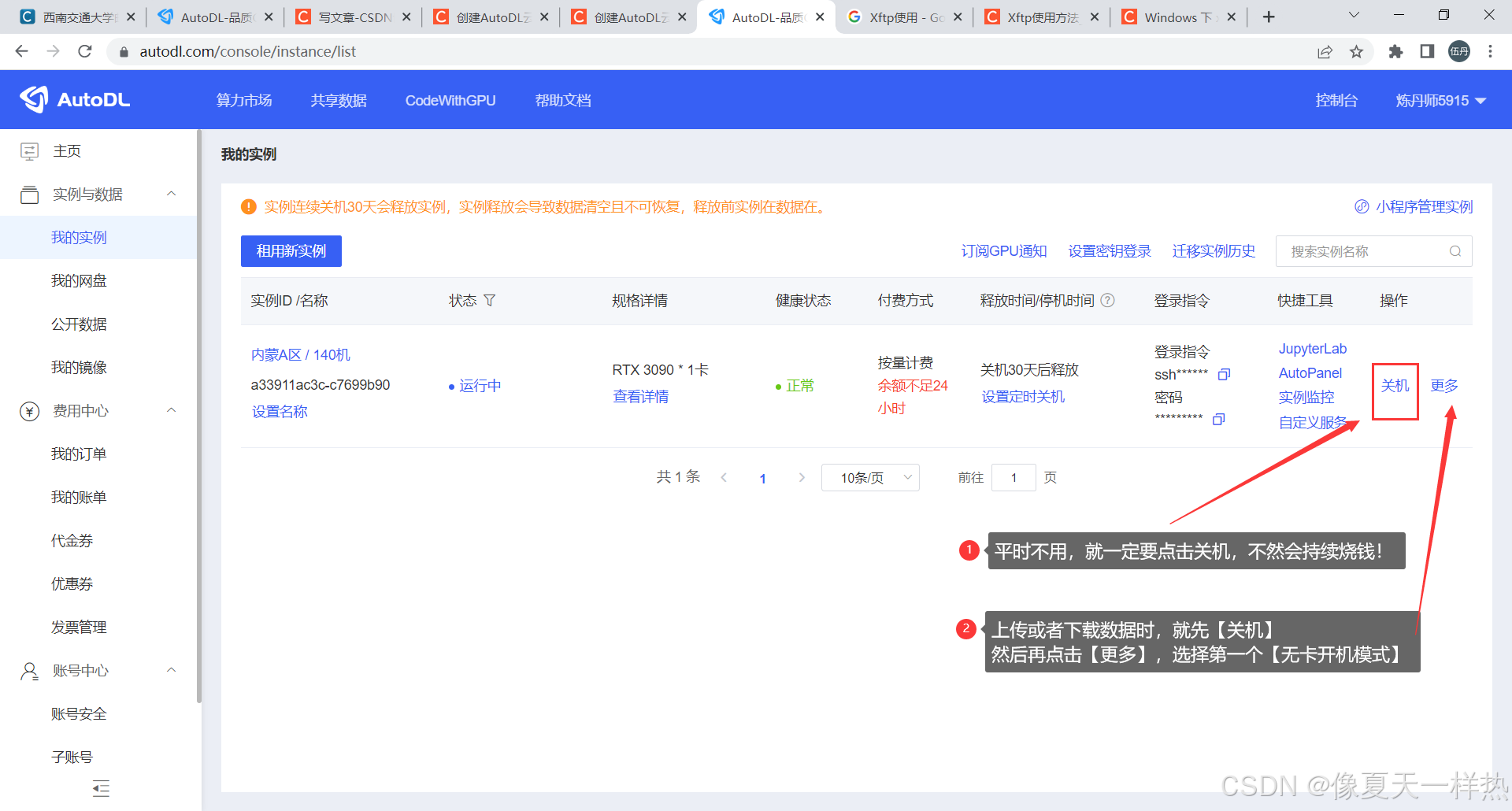

5.点击jupyterLab可以进入交互平台。

6.上传自己的项目可以通过带有ssh链接的工具进行,比如xftp、vscode等。

7.连接vscode。打开vscode点击+号。

8.输入6.中登陆指令。

9.陆续选择linux->continue然后输入6.中密码即可连接成功。

4199

4199

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?