-

首先通过一张图来了解注意力机制。

我们对于任何一张图,首先关注的就是关键信息,例如上图中的兔子。

Attention的3大优点

-

参数少

-

模型复杂度跟CNN、RNN相比,复杂度更小,参数也更少。所以对算力的要求更小。

-

-

速度快

-

Attention解决了RNN不能并行计算的问题。Attention机制每一步计算不依赖于上一步的计算结果,因此可以和CNN一样并行处理。

-

-

效果好

-

在Attention机制引入之前,由于长距离的信息会被弱化,记忆力差。Attention是挑重点,就算文本比较长,也能从中间抓住重点,不丢失重要的信息。

-

Attention的原理

-

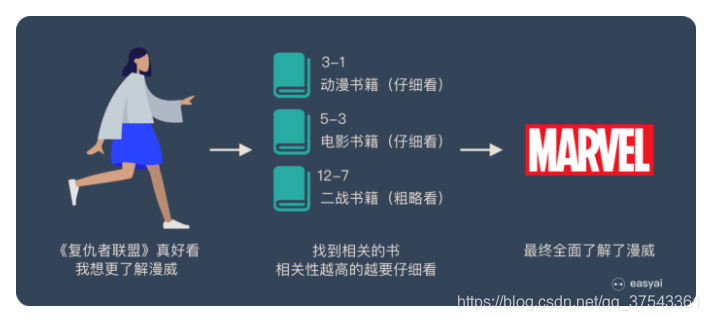

用这个例子来解释attention的原理:

图书馆(source)里有很多书(value),为了方便查找,我们给书做了编号(key)。当我们想要了解漫威(query)的时候,我们就可以看看那些动漫、电影、甚至二战相关的书籍。

为了提高效率,并不是所有的书都会仔细看,针对漫威来说,动漫,电影相关的会看的仔细一些(权重高),但是二战的就只需简单扫一下即可(权值低)。

注意力机制模型

本文详细介绍了注意力机制,包括其优点、原理、不同类型以及在CNN和LSTM中的应用,强调了其在处理长距离信息和提高模型效果上的优势。

本文详细介绍了注意力机制,包括其优点、原理、不同类型以及在CNN和LSTM中的应用,强调了其在处理长距离信息和提高模型效果上的优势。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?