Context-Aware Visual Compatibility Prediction

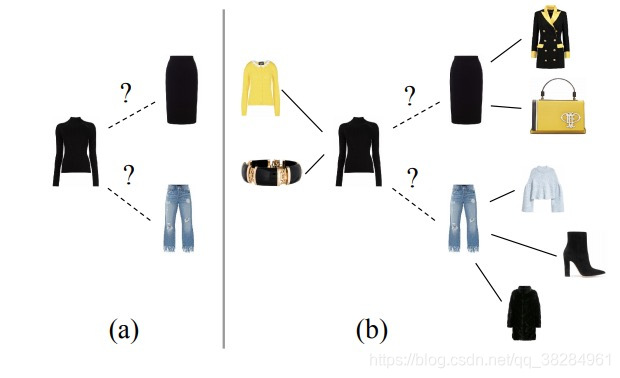

本文主要解决,根据两种衣服的上下文来判定两种衣服是否适配的问题,和以前网络不同的是,文中所用的网络为图网络(一般输入数据满足图结构的网络成为图网络)。

例如左边的是以往模型的风格匹配,右边的是本文中图结构的风格匹配。

网络结构

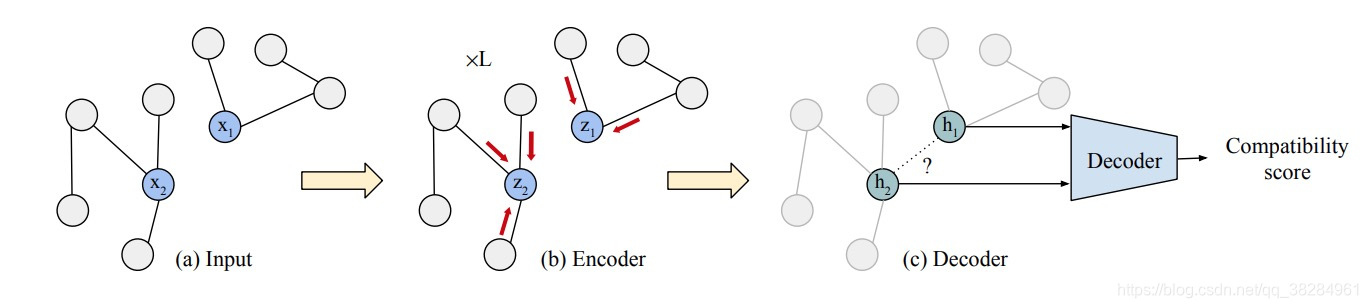

最初使用的方法是,直接使用卷积抽取嵌入向量进行举例匹配,之后有人使用孪生网络进行改进,再后来使用triple Loss来进行运算,最近的改进主要是基于有文本条件的嵌入。 本文主要的图网络结构如下

两种图输入,然后使用encoder生成向量,然后在使用decoder计算分数。

具体方法

本文使用的图网络是 图自动编码网络GAE,编码器会针对图的每个节点生成嵌入向量,解码器会根据这些嵌入向量预测图中丢失的边界。

假设输入是一个N节点的无环图,同种每一个节点都使用F维度的代表向量,那么图就可以使用一个N X F维度的矩阵X代表,再定义一个链接N x N矩阵当i 和j两个节点是有链接的那么A(i,j)=1 否则就等于0。

其中编码器可以抽象成H = f_enc( X, A) 解码器可以抽象为A = f_dec(H)经过编码器将X变成N x F1矩阵H,对于解码器来说他就是重构链接矩阵A,f_dec(Hi, Hj) 给出两点之间的概率值。

Encoder部分

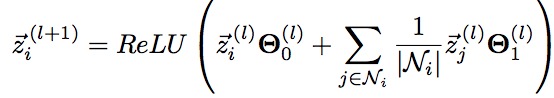

初始化的向量矩阵X,主要是通过卷积网络对图片提取特征。然后在选取目标节点i中紧邻节点

![]()

那么节点encoder计算如下

![]()

网络使用的是GCN 含有多个隐藏层,对于单个隐藏层有如下公式

其中Z表示输入输出。

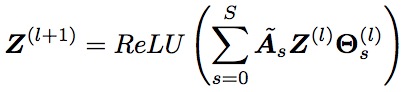

多层的表示公式如下

其中初始化的z就是X,

![]()

![]()

其中对角矩阵D

![]()

在文中S表示连接的深度,也就是几次连接到大目标点。 本文所有的我试验都是选择s = 1

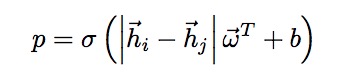

Decoder

Decoder部分主要是对物体匹配的度量,文中提到了相似性和匹配性是两种完全不同的问题,所以不建议将相似性和匹配性一起处理。

训练

模型训练过程中,可以对数据移除一些链接,生成新的无环矩阵A1,然后通过网络计算Loss, loss为较差熵。

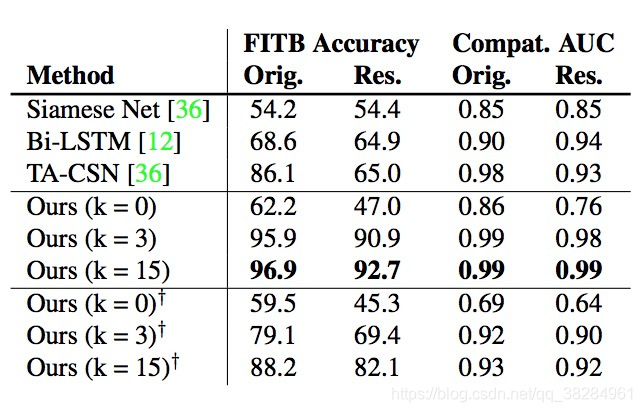

试验结果,当关联深度约高,准确率越高。

3310

3310

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?