Multi-Attention Multi-Class Constraint for Fine-grained Image Recognition

文中贡献概览

文中首次使用了对每一张图片多attention区域特征提取。这种提取基于OSME,并且应用到度量学习中。 MAMC将相同attention 中的相同类别更加接近,不同attention 或者不同类别差别较大。

OSMAE展示

与以往网络不同,本文使用目标区域代替整张图片作为特征处理实例,第二,在计算的时候考虑区域以及类别属性。

网络结构

网络结构,有两个attention 学习的分支,batch中有两个类别,每个类别有两个图片,共四个图像,测试剪短,MAMC以及softmax losses使用一个单纯的softmax loss代替。

结构细节

结构主要分成两个部分,第一个是OSME抽取各个attention区域的局部特征。第二个是MAMC度量学习。这个这个结构可以端到端训练。

OSME

文中使用的特征抽取器是soft-attention,并且使用了senet结构描述判别区域。

OSMAE 的结构比较简单,就是类似于senet一样对最后的feature map 学习一个权重,并将这个权重与resnet最后的输出相乘。得出新的带权重的feature map,然后通过一个全链接网络学习一个f。

想要对少个f,需要建立多少个类似于senet的结构。

MAMC

OSME过后,接下来关键的问题,如何引导抽取的attention 特征到正确的分类标签中。 原始的方法一般是将特征concat后再进行softmax,但是softmax loss并不能体现各个feature map的相关性。

本文使用一种新的方法,能够更大能力的抽取出各个区域,各个类别的相关信息。

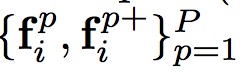

首先选择出N个图片对如下

经过OSME抽取后每一对图像得到

也就说给定N个图片对,进过OSME之后或得2NP个f。

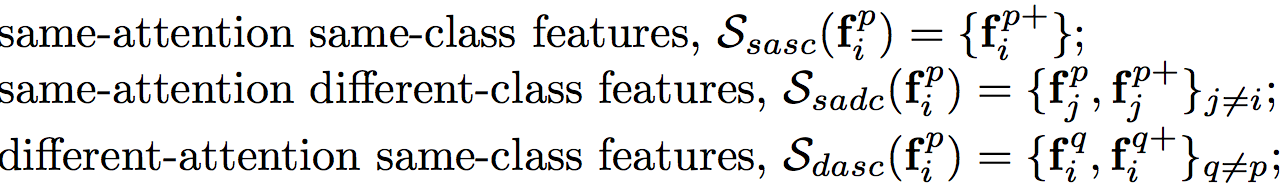

规定 属于第i类,第p个attention。如果以此作为anchor的话,那么剩余的f将会划分为以下群体

属于第i类,第p个attention。如果以此作为anchor的话,那么剩余的f将会划分为以下群体

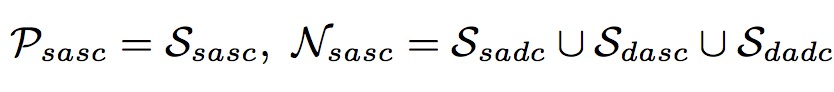

然后再根据这些集合分成积极集合以及消极集合

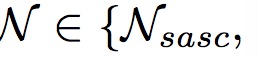

然后给定两个集合

那么我们需要使用度量学习实现

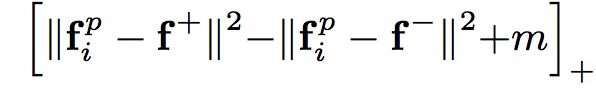

为了实现这一度量,使用triplet-loss

但是triplet loss有写缺陷

使用N-pair loss

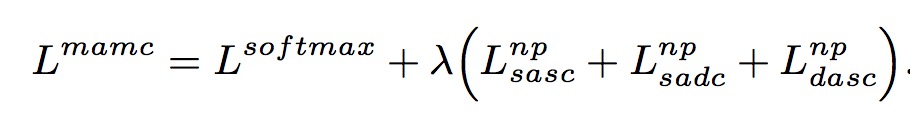

总的loss

836

836

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?