官网Ollama

下载地址:Download Ollama on Windows

建议使用下载加速工具,极大提高下载速度

运行下载后的安装包

1.1 1点击“Install”开始安装

1.2 验证是否安装成功

我们也可以通过windows命令窗口查看是否安装成功

打开命令窗口的方法:

在运行中输入 cmd

然后输入:ollama ,显示有很多可选命令表示安装成功了

1.3下载 deepseek-r1模型

下载地址:deepseek-r1:1.5b

Ollama默认要求安装在C盘不可以修改

但是:模型下载位置是可以修改的

下载模型前,可以设置模型存储位置

1.3.1 修改模型默认存放位置

在此电脑鼠标右键,点击“属性”

1.3.2 选中下拉选项,然后点击复制下载命令

1.3.3 打开电脑命令窗口, 然后粘贴命令到窗口,回车

打开命令窗口的方法:

在运行中输入 cmd

输入:ollama run deepseek-r1:1.5b

下载完成模型后,可以直接在命令窗口进行提问

模型默认下载存放位置在

C:\Users\xxxx\AppData\Roaming\anythingllm-desktop\storage\models\ollama\blobs

退出命令是 ctrl+d或者输入斜杠+bye 也可以直接关闭窗口

1.3.4 卸载模型方法

如果你安装了多个模型,需要卸载某个模型,方法如下:

打开命令窗口,输入 ollama rm xxxxxx (xxxxx是模型全称)

二、CherryStudio + Ollama

1.下载Cherry Studio

下载地址:Cherry Studio 官方网站 - 全能的AI助手

官网下载比较慢推荐地址:https://download.csdn.net/download/qq_38382365/90539378

1.2 安装

选择好安装目录 一直下一步安装就好

1.3 配置

2.3.1配置硅基流动:

注册地址:硅基流动用户系统,统一登录 SSO

注册登录后,点击左侧API密钥

点击“新建API密钥”,创建好后点击复制密钥

在cherryStudio点击设置,在硅基流动右侧点击“检查”

2.3.2配置本地部署的DeepSeek

在设置->模型服务

点击“Ollama”,点击“管理”

点击本地添加的模型后面“+”

设置默认模型

回到聊天页面进行聊天

即可实现本地DeepSeek模型对话

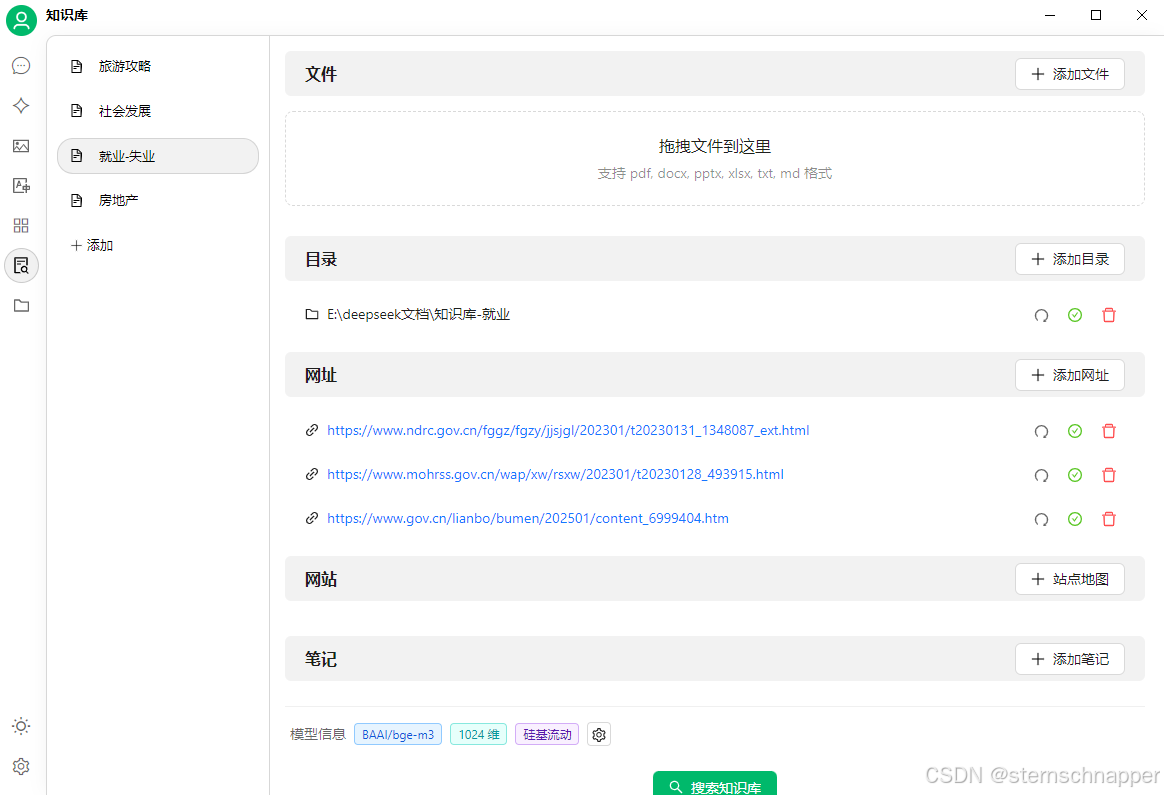

2.3.3本地知识库

3.3.1添加知识库之前,请先去把模型设置为嵌入模型

3.3.2创建知识库

3.3.3选择本地文件或者目录,添加网络文章地址

3.3.4使用知识库

在聊天时记住一定要选择你的知识库,选择了知识库的会是彩色的按钮

2452

2452

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?