代码:https://github.com/Hyperparticle/one-pixel-attack-keras

1.文章主要解决什么问题;

以前的大多数攻击没有考虑到对抗性攻击的极端有限的场景,即修改可能过多(即修改像素的数量相当大),以至于人眼可以察觉。此外,调查在极端有限的场景下创建的敌对图像可能会给关于DNN模型在高维空间的几何特征和整体行为的新见解。例如,接近决策边界的对抗性图像的特征可以帮助描述决策边界的形状.。

2.它是如何工作的?

在这套攻击中,我们使用了 Cifar10 dataset。数据集的任务是将 32X32 像素的图片进行正确分类,分类池有十个选项(如鸟、鹿、卡车等)。这个黑盒(black-box)攻击仅需要由神经网络输出的概率标签(每个分类的概率值)即可。我们通过选择一个像素并且将其修改为某种颜色来生成伪分类。

3.解决的思路是什么;

基于N. Narodytska and S. Kasiviswanathan. Simple black-box adversarial

attacks on deep neural networks. In 2017 IEEE Conference on Computer

Vision and Pattern Recognition Workshops (CVPRW), pp.1310–1318.

IEEE, 2017.(其实不是修改1个像素而是利用本地搜索的策略去找多个像素,不同的是,他们只是利用它作为起点来导出进一步的半黑盒攻击,这需要修改更多的像素(例如,1024个像素中大约有30个像素),而没有考虑一个像素攻击的情况。此外,他们既没有系统地测量攻击的有效性,也没有获得定量的评估结果。对单像素攻击的几何特征分析较少,对其意义的探讨也较少。)提出的。

我们通过差分进化只扰动一个像素,在唯一可用信息是概率标签的情况下,提出了一种黑盒DNN攻击。

与之前的工作相比,我们的建议主要有以下优点:

①有效性:在Kaggle CIFAR-10数据集上,仅修改三个常见深度神经网络结构上的一个像素就能够发起非目标攻击,成功率分别为68.71%、71.66%和63.53%。我们还发现,每个自然图像可以被扰动到其他类的1.8、2.1和1.5。在具有更有限攻击场景的原始CIFAR- 10数据集上,我们显示了22.60%、35.20%和31.40%的成功率。在ImageNet数据集上,同样通过改变一个像素对BVLC AlexNet模型进行非目标攻击,表明16.04%的测试图像可以被攻击。

②半黑盒攻击—只需要黑盒反馈(概率标签),不需要目标dnn的内部信息,如梯度和网络结构。我们的方法也比现有的方法简单,因为它没有将搜索扰动问题抽象到任何明确的目标函数,而是直接关注于增加目标类的概率标签值。

③灵活性-可以攻击更多类型的dnn(例如,网络不可微或梯度计算是困难的)。

4.核心的知识点有哪些;

Fig1:使用本文提出的算法创建的一个像素攻击,成功地欺骗了三种类型的dnn训练的CIFAR-10数据集:所有卷积网络(AllConv),网络在网络(NiN)和VGG。原始类标签为黑色,目标类标签及其置信度为黑色。

问题描述:生成敌对的图像可以形式化为一个有约束的优化问题。我们假设输入图像可以用一个向量表示,其中每个标量元素代表一个像素。设f是接收n维输入的目标图像分类器,x = (x1, … xn)为正确分类为t类的原始自然图像。因此,x属于t类的概率为ft(x)。向量e(x) = (e1, …)是根据x、目标类adv和最大修正量L的限制的加性对抗性扰动。注意L总是由向量e(x)的长度测量。在有针对性的攻击情况下,对手的目标是找到以下问题的优化解e(x):

这个问题涉及到找到两个值:(a)哪些维度需要被扰动,以及(b)每个维度的相应修改强度。在我们的方法中,方程略有不同:

其中d是一个小数。在1像素攻击的情况下,d = 1。以前的工作通常修改所有维度的一部分,而在我们的方法中,只有d维度被修改,e(x)的其他维度为零。

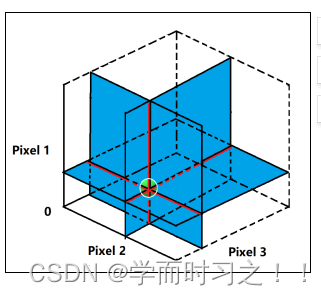

fig4:在三维输入空间中(即图像有 3 个像素),使用 1 个和 2 个像素扰动攻击的示意图,绿点表示一个自然图片进行扰动。在一个像素进行扰动时,搜索空间为自然图像三条相交线,且每一条线都相互垂直,图中用红线和黑线表示。在 2 个像素的情况下,搜索空间为三个二维相交平面,且每一个平面都相互垂直,图中用蓝色平面表示。总而言之,1 个和 2 个像素攻击搜索了 3 维输入空间中 1 维和 2 维子空间内的扰动。此外,黄圈表示使用 L^p 范数正则化前面定义的搜索空间以控制总体的修正空间。相比之下,少量像素攻击可以搜索更多的区域。

差分优化DE

是求解复杂多模态优化问题[的基于种群的优化算法。DE属于进化算法(EA)的一般类别。

①首先,生成几个对抗样本,随机修改一个像素点,用神经网络运行图像。

②接下来,将改变后的图像和先前的像素位置和颜色结合在一起,从产生更多的对抗样本,然后继续通过神经网络运行这些样本。如果上一步,有像素降低了神经网络的置信度,那就将它们替换为当前的 best know 解决方案。

③重复上述的步骤并进行几次迭代;在最后一步返回对抗图像,最大程度的降低神经网络的置信度。如果成功了,置信度会大大降低,以至于新的(不正确的)类别现在具有最大概率的可信度。

基于DE算法进行对抗图像的生成有以下几个优点:

①可以以更大的概率找到全局最优解。DE不像梯度下降或者贪婪算法那样受局部影响较大(保持多样性的机制及子候选解集影响)。本文中有一个很强的限制条件,(只允许修改一个像素)使问题变得更加复杂。

②需要得信息更少。DE不需要梯度下降,拟牛顿法等优化方法需要的信息进行优化求解。这对于对抗图片的生成是至关重要的。(1)有些网络是无法进行区分的(2)为了求解梯度信息需要获得目标系统更多的信息,有时是无法获得的。

③简易性 。本文提出的方法与分类器无关,获得类别的概率就足够。

DE,具体来说,就是每次迭代的过程中,根据当前总体(父代)生成另一组方案(子代),然后将这些子代与附带比较,只有这些子代的效果优于父代,才能够被选中。DE不用梯度优化,因此不需要目标函数具有可微性。

其中,r1,r2,r3为随机值。xi是候选的元素。F是一个范围参数,文章中设置为0.5.g是当前的的迭代次数。子代生成后,将会与父代的成效进行竞争。

具体来说,通过随机参数来修改像素来生成400个对抗样本,输入到神经网络中。该随机参数包括五个部分,(x,y,δR,δGδB)。然后,将这些修改像素的位置和颜色结合起来,再生成400个对抗样本,输入到神经网络中;接下来,如果某个新样本与父代相比,降低了神经网络对正确类别的置信度,就将用这个样本上修改的像素替换父代,作为目前已知的最优解。

评价指标

①成功率——在非目标攻击的情况下,它被定义为被目标系统成功分类为任意目标类的对抗图像的百分比。在有目标攻击的情况下,它被定义为自然图像扰动到特定目标类的概率。

②对抗概率标签(置信度)-对每个成功扰动累积目标类的概率标签值,然后除以成功扰动的总数。该度量表示对敌方图像进行误分类时目标系统给出的平均置信度。

③目标类的数量-计算成功扰动到目标类的一定数量(即从0到9)的自然图像的数量。特别地,通过计算不能被任何其他类干扰的图像的数量,可以评估非目标攻击的有效性。

④原始目标类对数-统计每个原始目标类对被攻击的次数。

实验

我们在CIFAR-10数据集上训练3种常见的网络:全卷积网络、网络中的网络和VGG16网络作为目标图像分类器。考虑了目标攻击和非目标攻击两种情况。针对三种类型神经网络的攻击,从Kaggle CIFAR-10测试数据中随机选取500幅自然图像。

在全卷积网络上进行实验,生成500幅经过3、5像素修改的对抗图像。目标是比较1像素攻击与3像素和5像素攻击。

非针对性攻击的有效性是根据有针对性的攻击结果来评估的。也就是说,如果一幅图像在总共9个类中至少能被扰动到一个目标类,则对该图像的非目标攻击成功。

通过使用一个适应度函数来启动对ImageNet的非目标攻击,该适应度函数旨在降低真实类的概率标签。

3个CIFAR-10网络和BVLC网络上1像素摄动的成功率和对抗概率标签(置信度confidence)如上表所示.originalAcc是在自然测试数据集上的准确性。Targeted/Non-targeted表示进行有针对性/非针对性攻击的准确性。置信度是目标类的平均概率。

对allconv进行三像素攻击和五像素攻击的结果。

5.程序功能分块说明;

暂时还没有读代码.

参考https://segmentfault.com/a/1190000013825488

6.存在的问题;

可能还不够精确。

7.有哪些改进的思路!

本研究使用的进化策略DE属于进化策略的大类算法,其中还包括其他变体如Adaptive DE和协方差矩阵适应进化策略(CMA-ES)。可以进一步改进现有的方法,使攻击更有效、更准确。但是目前还不了解其他的优化算法,不知道怎么改进!!

参考:

[1]https://www.cnblogs.com/fourmi/p/10117832.html

[2]http://blog.leanote.com/post/shaobaobaoer/%E5%AF%B9%E6%8A%97%E6%A0%B7%E6%9C%AC%E5%B8%B8%E8%A7%81%E6%94%BB%E5%87%BB%E7%AE%97%E6%B3%95%E4%B8%8E%E6%A8%A1%E6%8B%9F%E2%80%94%E2%80%94%E5%8D%95%E5%83%8F%E7%B4%A0%E6%94%BB%E5%87%BB

[3]https://blog.csdn.net/Uwr44UOuQcNsUQb60zk2/article/details/78372154

本文介绍了一种使用差分进化算法在仅修改一个像素的情况下对深度神经网络(DNN)进行黑盒攻击的方法。研究集中在CIFAR-10和ImageNet数据集上,成功实现了非目标攻击,对多个DNN模型产生了高成功率的误导。这种方法不需要内部网络信息,如梯度,仅依赖概率标签,并展示了在极端有限的修改情况下对DNN行为的洞察力。

本文介绍了一种使用差分进化算法在仅修改一个像素的情况下对深度神经网络(DNN)进行黑盒攻击的方法。研究集中在CIFAR-10和ImageNet数据集上,成功实现了非目标攻击,对多个DNN模型产生了高成功率的误导。这种方法不需要内部网络信息,如梯度,仅依赖概率标签,并展示了在极端有限的修改情况下对DNN行为的洞察力。

781

781

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?