循环神经网络(RNN)主要面临梯度消失和梯度爆炸两个核心问题,这严重影响了其处理长期依赖的能力。此外,还存在一些其他的技术挑战。

一、两个主要问题

(1)梯度消失和梯度爆炸问题

这是RNN中最显著的问题之一。由于RNN在时间上反向传播误差,如果序列很长,那么梯度可能会随着时间的推移变得非常小(消失)或非常大(爆炸),导致网络难以学习。下面具体说说。

① 梯度消失

在训练过程中,特别是处理长序列数据时,RNN中的梯度有可能随着反向传播的时间步增加而指数级减小,导致网络较早时间步的权重几乎不更新,无法学习到长期依赖关系。

② 梯度爆炸

与梯度消失相反,某些情况下梯度可能会随时间步增长而指数级增大,这导致权重更新幅度过大,使模型训练不稳定,甚至导致数值溢出。梯度爆炸问题相对梯度消失来说好解决。

(2)长期依赖问题

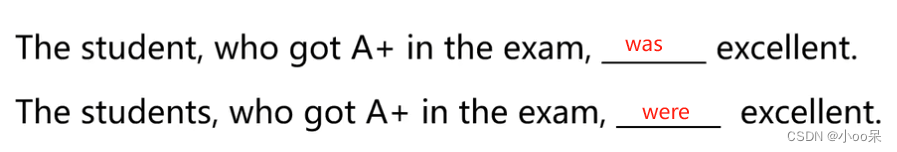

RNN在理论上有能力捕捉序列中的长期依赖,但实际上由于梯度消失现象,它往往难以有效地学习这种依赖关系。例如下面这个句子:

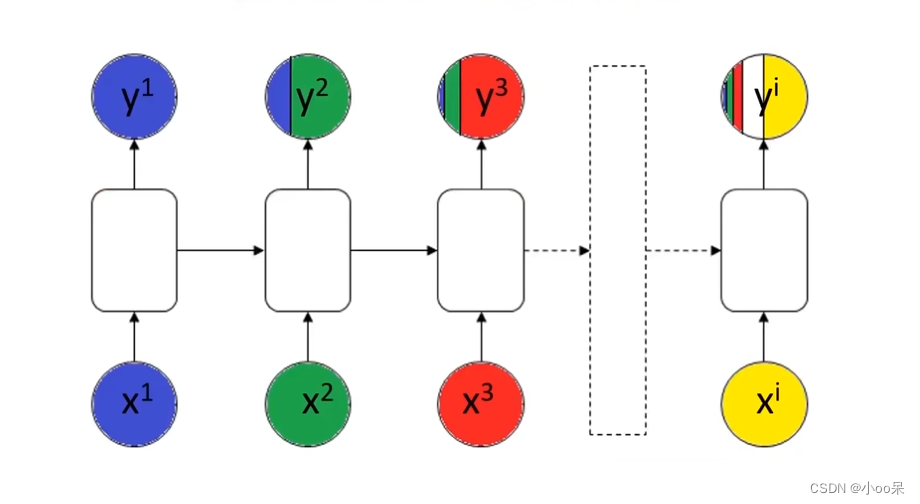

只有在记住最前面的student是复数还是单数才能准确得到后面的结果

第1个时间步的信息随着时间推移变得越来越小,对应在图中就是紫色部分几乎在后面的时间步中无法体现。也就是没记住长期的信息。

二、其他问题

(1)输入序列长度限制

传统RNN在处理不同长度的输入序列时,通常需要固定序列长度或进行序列截断及填充,这限制了模型处理灵活性。

(2)计算复杂度和训练时间较大

RNN由于其循环特性,计算量较大,尤其是在长序列上,这可能导致训练时间较长且资源消耗较多。

三、那该怎么解决呢?

关于如何解决这些问题本文简单提一下,后续会写具体的文章来介绍。解决这些问题的方法包括但不限于:

- 使用具有门控机制的RNN变种,如LSTM(长短期记忆网络)和GRU(门控循环单元),它们能够更好地管理单元状态,缓解梯度消失问题。

- 应用技巧如梯度裁剪(Gradient Clipping)来防止梯度爆炸。

- 引入注意力机制(Attention Mechanisms)和外部记忆模块(如Memory Networks)来增强模型处理长期依赖的能力。

- 动态RNN结构,允许输入序列长度可变。

- 优化算法和正则化技术,如权重衰减(L2正则化),可以帮助稳定训练过程。

5461

5461

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?