HOTPOTQA A Dataset for Diverse, Explainable Multi-hop Question Answering

论文:https://arxiv.org/pdf/1809.09600.pdf

一个多样的,可解释的多跳问答数据集。

任务

现有的问答数据集不能训练QA系统进行复杂的推理并提供答案的解释。提出hotpot数据集,提供支持事实使模型能够改进性能并做出可解释的预测。

HOTPOTQA介绍

HOTPOTQA是一个新的数据集,拥有113k个基于Wikipedia的问答对,具有以下四个关键特性:

- 这些问题需要在多个支持文档上找到答案并进行推理。

- 问题是多样的,不局限于任何预先存在的知识库或知识模式。

- 提供推理所需的句子级支持事实,允许QA系统在强监督下推理并解释预测。

- 提出了一种新的factoid comparison questions来测试QA系统提取相关事实和进行必要比较的能力。

数据集

数据集划分

single-hop数据集:The train-easy set contains 18,089 mostly single-hop examples.

将hard examples随机划分为4个子集:

- train-hard, dev, test-distractor, test-fullwiki

two benchmark settings

-

distractor

8 paragraphs from Wikipedia + 2 gold paragraphs

-

full wiki

要求模型回答所有Wikipedia文章的第一段给出的问题。

两种设置使用不同数据集的原因:distractor设置中的模型可以使用gold paragraphs,但full wiki设置中不可以使用gold paragraphs。

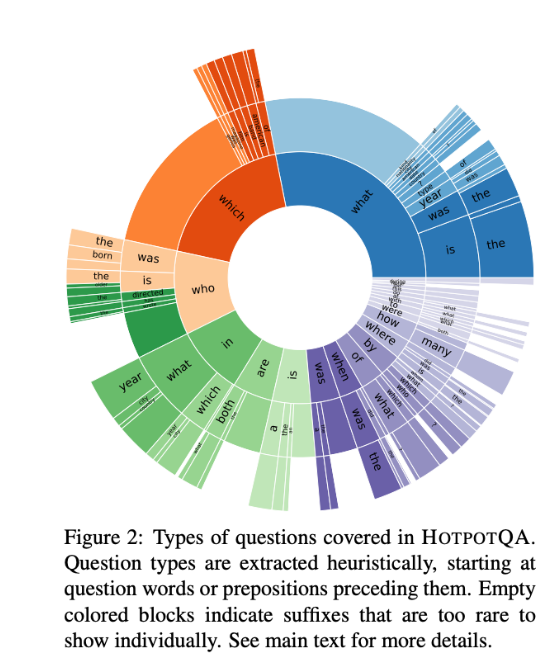

Question Types

Answer Types

- 68%的回答实体相关。

模型结构

- 对于每个句子,在第一个和最后一个位置连接selfattention layer的输出,并使用binary linear classifier来预测当前句子成为支持事实的概率。

- 将此分类器的二进制交叉熵损失最小化。 在多任务学习环境中,该目标与正常问答目标共同得到优化,并且它们共享相同的low-level representations。

- 使用该分类器,还可以在支持事实预测的任务上评估模型以评估其可解释性 。

性能水平

评估指标

-

exact match (EM) and F1

-

计算F1

P ( j o i n t ) = P ( a n s ) P ( s u p )

HOTPOTQA是一个113k条目的多跳问答数据集,强调多样性与可解释性。它需要模型通过多个文档进行推理并提供证据。数据集分为single-hop和full wiki两种设置,后者更具挑战性。模型结构利用selfattention层预测支持事实,评估指标包括精确匹配(EM)和F1分数。研究发现,模型在比较问题上的性能有待提升。

HOTPOTQA是一个113k条目的多跳问答数据集,强调多样性与可解释性。它需要模型通过多个文档进行推理并提供证据。数据集分为single-hop和full wiki两种设置,后者更具挑战性。模型结构利用selfattention层预测支持事实,评估指标包括精确匹配(EM)和F1分数。研究发现,模型在比较问题上的性能有待提升。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

647

647

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?