全球麦穗检测是植物表型分析领域的一个挑战,主要目标是检测图像中的小麦麦穗。这种检测在农业领域具有重要意义,可以帮助农民评估作物的健康状况和成熟度。然而,由于小麦麦穗在视觉上具有挑战性,准确检测它们是一项艰巨的任务。

全球麦穗检测的挑战在于准确识别不同品种、不同生长环境、不同光照条件、不同拍摄角度下的麦穗。由于小麦麦穗经常重叠、颜色和外观变化多样,这使得检测更具挑战性。为了解决这些问题,研究者们采用机器学习和计算机视觉技术来开发麦穗检测算法。

目前,全球麦穗检测的常用方法包括基于单级和两级检测器的目标检测方法(如Yolo和Faster-RCNN)。这些方法通过训练深度神经网络来识别和定位图像中的麦穗。然而,即使使用大型数据集进行训练,仍然存在对训练区域的偏差,因此需要不断改进和优化算法以提高检测准确性。

全球麦穗检测对于农业生产和科学研究具有重要意义。准确估计不同品种的小麦麦穗密度和大小可以帮助农民更好地评估作物健康状况和产量。此外,这种检测还可以用于研究小麦生长和发育的规律,以及开发新的种植技术和品种。通过改进麦穗检测算法,可以为农业生产的智能化和精细化提供有力支持。

本文介绍了基于深度学习yolov8的麦穗头检测系统,包括训练过程和数据准备过程,同时提供了推理的代码和GUI。

模型在线体验:模型乐园

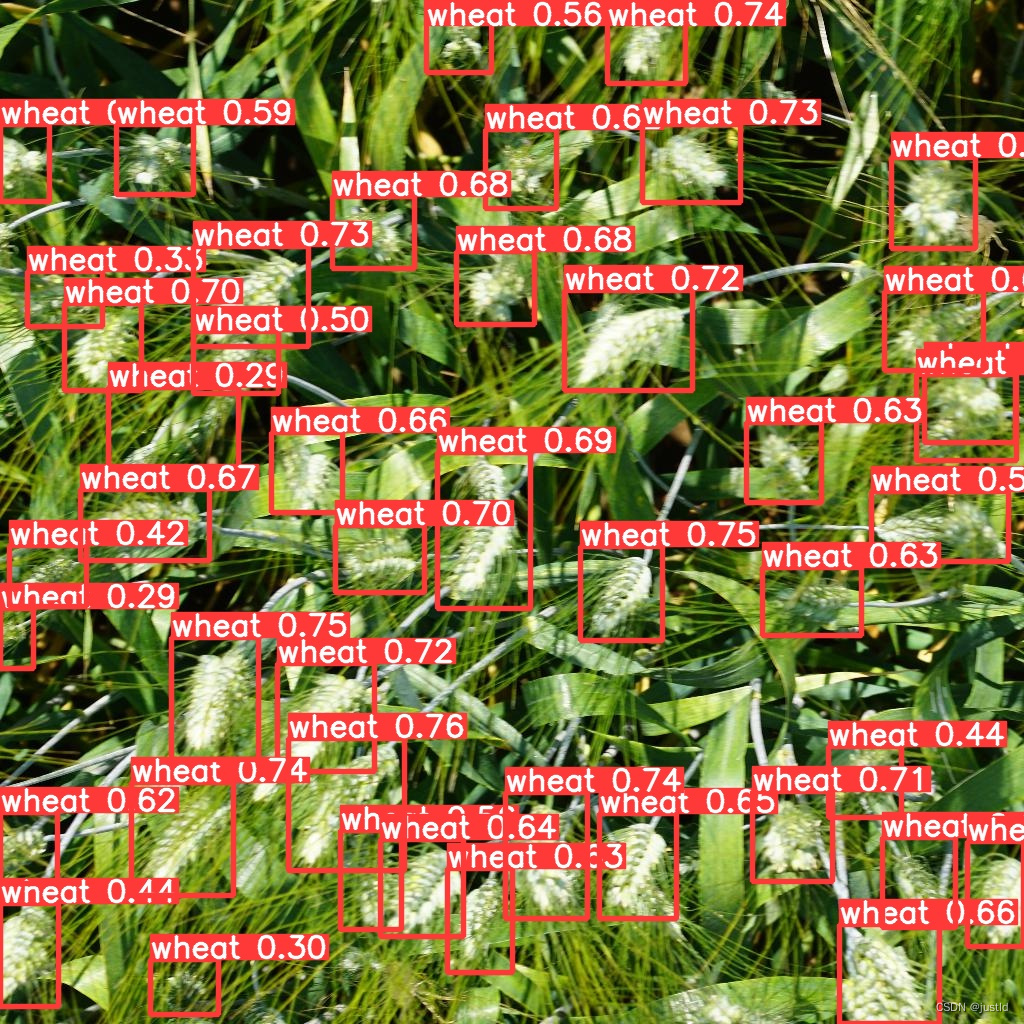

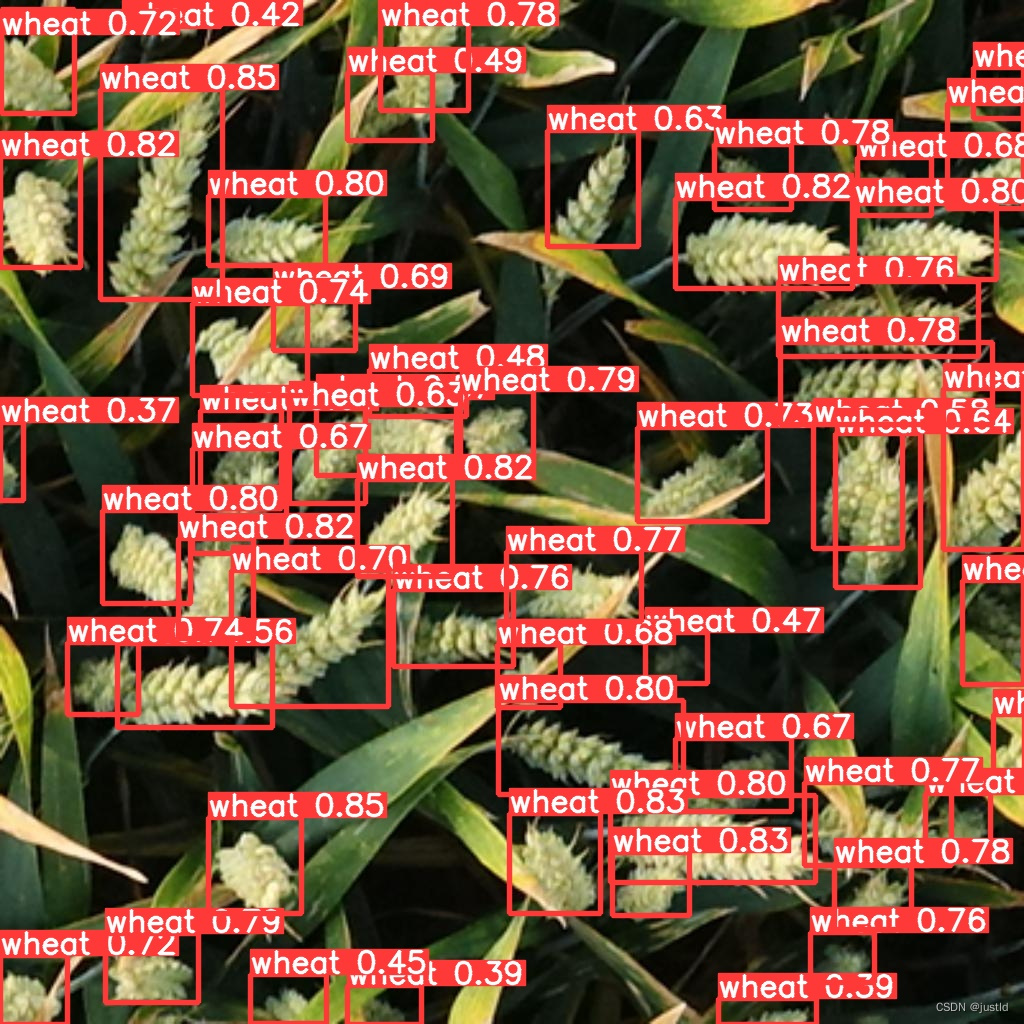

检测结果如下图:

一、安装YoloV8

yolov8官方文档:主页 - Ultralytics YOLOv8 文档

安装部分参考:官方安装教程

二、数据集准备

本文使用的数据集来自全球小麦头检测数据集,检测小麦穗是一项重要任务,可以估计相关性状,包括穗种群密度和穗特征,如卫生状况、大小、成熟阶段和芒的存在。几项研究开发了从高分辨率 RGB 图像中检测小麦头的方法。它们基于计算机视觉和机器学习,通常在有限的数据集上进行校准和验证。然而,观察条件、基因型差异、发育阶段、头部方向的可变性代表了计算机视觉的挑战。此外,由于运动或风和密集人群头部之间的重叠可能导致的模糊使这项任务更加复杂。通过联合国际协作努力,我们建立了一个大型、多样化且标记良好的数据集,即全球小麦头检测 (GWHD) 数据集。它包含 4,700 张高分辨率 RGB 图像和 190,000 个标记的小麦头,这些小麦头采集自世界各地不同生长阶段的不同基因型的多个国家。

数据示例如下:

全球麦穗检测数据集yoloV8格式,采用8:2划分训练集和验证集,包含2698个训练数据和675个验证数据,本文提供整理后的全球麦穗检测数据集yoloV8格式。

三、模型训练

1、数据集配置文件

在ultralytics/ultralytics/cfg/datasets目录下添加wheat.yaml,添加以下内容(path修改为自己的路径):

# Ultralytics YOLO 🚀, AGPL-3.0 license

# COCO 2017 dataset http://cocodataset.org by Microsoft

# Example usage: yolo train data=coco.yaml

# parent

# ├── ultralytics

# └── datasets

# └── coco ← downloads here (20.1 GB)

# Train/val/test sets as 1) dir: path/to/imgs, 2) file: path/to/imgs.txt, or 3) list: [path/to/imgs1, path/to/imgs2, ..]

path: datasets/wheat_det_yolo8 # dataset root dir

train: images/train # train images (relative to 'path') 118287 images

val: images/val # val images (relative to 'path') 5000 images

test: images/val # 20288 of 40670 images, submit to https://competitions.codalab.org/competitions/20794

# Classes

names:

0: wheat

2、修改模型配置文件

新建ultralytics/cfg/models/wheat/yolov8_wheat.yaml ,添加以下内容:,添加以下内容:

# Ultralytics YOLO 🚀, AGPL-3.0 license

# YOLOv8 object detection model with P3-P5 outputs. For Usage examples see https://docs.ultralytics.com/tasks/detect

# Parameters

nc: 1 # number of classes

scales: # model compound scaling constants, i.e. 'model=yolov8n.yaml' will call yolov8.yaml with scale 'n'

# [depth, width, max_channels]

n: [0.33, 0.25, 1024] # YOLOv8n summary: 225 layers, 3157200 parameters, 3157184 gradients, 8.9 GFLOPs

s: [0.33, 0.50, 1024] # YOLOv8s summary: 225 layers, 11166560 parameters, 11166544 gradients, 28.8 GFLOPs

m: [0.67, 0.75, 768] # YOLOv8m summary: 295 layers, 25902640 parameters, 25902624 gradients, 79.3 GFLOPs

l: [1.00, 1.00, 512] # YOLOv8l summary: 365 layers, 43691520 parameters, 43691504 gradients, 165.7 GFLOPs

x: [1.00, 1.25, 512] # YOLOv8x summary: 365 layers, 68229648 parameters, 68229632 gradients, 258.5 GFLOPs

# YOLOv8.0n backbone

backbone:

# [from, repeats, module, args]

- [-1, 1, Conv, [64, 3, 2]] # 0-P1/2

- [-1, 1, Conv, [128, 3, 2]] # 1-P2/4

- [-1, 3, C2f, [128, True]]

- [-1, 1, Conv, [256, 3, 2]] # 3-P3/8

- [-1, 6, C2f, [256, True]]

- [-1, 1, Conv, [512, 3, 2]] # 5-P4/16

- [-1, 6, C2f, [512, True]]

- [-1, 1, Conv, [1024, 3, 2]] # 7-P5/32

- [-1, 3, C2f, [1024, True]]

- [-1, 1, SPPF, [1024, 5]] # 9

# YOLOv8.0n head

head:

- [-1, 1, nn.Upsample, [None, 2, 'nearest']]

- [[-1, 6], 1, Concat, [1]] # cat backbone P4

- [-1, 3, C2f, [512]] # 12

- [-1, 1, nn.Upsample, [None, 2, 'nearest']]

- [[-1, 4], 1, Concat, [1]] # cat backbone P3

- [-1, 3, C2f, [256]] # 15 (P3/8-small)

- [-1, 1, Conv, [256, 3, 2]]

- [[-1, 12], 1, Concat, [1]] # cat head P4

- [-1, 3, C2f, [512]] # 18 (P4/16-medium)

- [-1, 1, Conv, [512, 3, 2]]

- [[-1, 9], 1, Concat, [1]] # cat head P5

- [-1, 3, C2f, [1024]] # 21 (P5/32-large)

- [[15, 18, 21], 1, Detect, [nc]] # Detect(P3, P4, P5)3、训练模型

使用如下命令训练模型,相关路径更改为自己的路径,建议绝对路径:

yolo detect train project=deploy name=yolov8_wheat exist_ok=True optimizer=auto val=True amp=True epochs=100 imgsz=640 model=ultralytics/cfg/models/wheat/yolov8_wheat.yaml data=ultralytics/cfg/datasets/wheat.yaml

4、验证模型

使用如下命令验证模型,相关路径根据需要修改:

yolo detect val imgsz=640 model=deploy/yolov8_wheat/weights/best.pt data=ultralytics/ultralytics/cfg/datasets/wheat.yaml

精度如下:

Ultralytics YOLOv8.1.0 🚀 Python-3.9.18 torch-2.1.0+cu118 CUDA:0 (NVIDIA GeForce RTX 4090, 24210MiB)

YOLOv8_wheat summary (fused): 168 layers, 3005843 parameters, 0 gradients, 8.1 GFLOPs

val: Scanning /home/yq/aitools/datasets/wheat_det_yolo8/labels/val.cache... 675 images, 0 backgrounds, 0 corrupt: 100%|██████████| 675/675 [00:00<?, ?it/s]

Class Images Instances Box(P R mAP50 mAP50-95): 100%|██████████| 43/43 [00:14<00:00, 3.04it/s]

all 675 29351 0.915 0.878 0.938 0.555

Speed: 0.6ms preprocess, 1.6ms inference, 0.0ms loss, 1.0ms postprocess per image

Results saved to /home/yq/ultralytics/runs/detect/val17

💡 Learn more at https://docs.ultralytics.com/modes/val四、推理

训练好了模型,可以使用如下代码实现推理,将权重放到同级目录:

from PIL import Image

from ultralytics import YOLO

# 加载预训练的YOLOv8n模型

model = YOLO('best.pt')

image_path = 'test.jpg'

results = model(image_path) # 结果列表

# 展示结果

for r in results:

im_array = r.plot() # 绘制包含预测结果的BGR numpy数组

im = Image.fromarray(im_array[..., ::-1]) # RGB PIL图像

im.show() # 显示图像

im.save('results.jpg') # 保存图像五、界面开发

使用pyqt5开发gui界面,支持图片、视频、摄像头输入,支持导出到指定路径,其GUI如下图(完整GUI代码可在下方链接下载):

六、代码下载

1、本文数据集下载

本文探讨了全球麦穗检测的挑战,特别是在复杂环境下利用机器学习和YOLov8进行精确检测的方法。通过介绍数据集准备、模型配置与训练,以及如何通过改进算法提高检测准确性的过程,展示了YOLov8在实际应用中的潜力和效果。

本文探讨了全球麦穗检测的挑战,特别是在复杂环境下利用机器学习和YOLov8进行精确检测的方法。通过介绍数据集准备、模型配置与训练,以及如何通过改进算法提高检测准确性的过程,展示了YOLov8在实际应用中的潜力和效果。

1639

1639

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?