简述一下Unet网络

UNet网络和FCN都是Encoder-Decoder结构

Encoder由卷积操作和下采样操作组成,统一使用3✖️3的卷积核,padding为0,striding为1,所以每次卷积之后feature map的H和W变小了,在skip-connection时要注意feature map的维度。下采样使用的是最大池化

feature map经过Decoder恢复原始分辨率,该过程除了卷积比较关键的步骤就是上采样和skip-connection

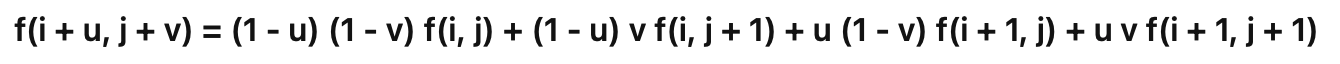

上采样常用的方式有两种:反卷积和双线性插值

反卷积

1.直接进行full卷积

2.先进行上池化,再进行valid卷积

双线性插值

分割网络要想获得好效果,skip-connection 必不可少。Unet 中这一关键步骤融合了底层特征的位置信息与深层特征的语义信息

FCN与CNN最大的区别

FCN将传统卷积网络后面的全连接层换成了卷积层

1.不含全连接层(fc)的全卷积(fully conv)网络,可适应任意尺寸输入。

2.增大数据尺寸的反卷积(deconv)层,能够输出精细的结果。

3.结合不同深度层结果的跳级(skip)结构,同时确保鲁棒性和精确性。

分割出来的结果通常会有不连续的情况,怎么处理?

开运算 闭运算

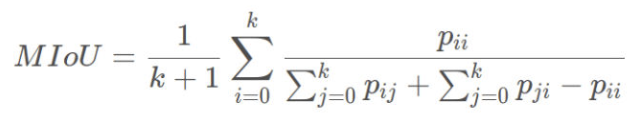

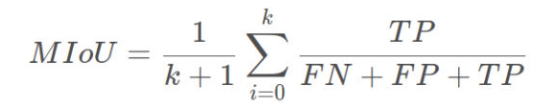

mIOU的计算方式

空洞卷积的具体实现

Dilated convolution就是为了在不使用pooling操作损失信息也能增加感受野。空洞卷积:有两种实现方式,第一,卷积核填充0,第二,输入等间隔采样。空洞卷积的rate,代表传统卷积核的相邻之间插入rate-1个空洞数。

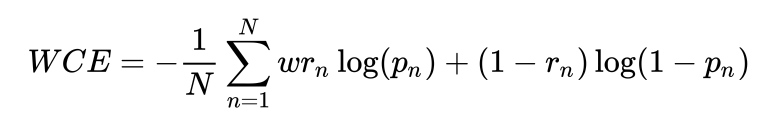

带权重的交叉熵:

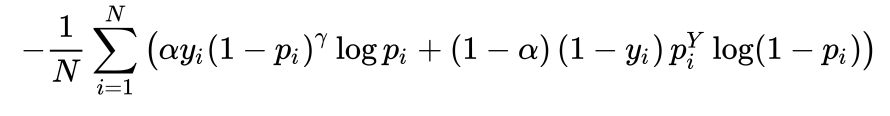

focal loss:

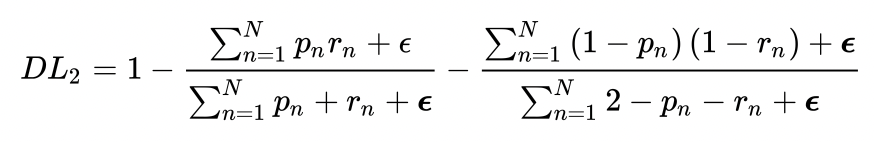

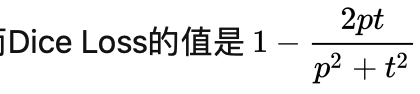

Dice loss:

laplace smoothing:

将分子分母全加上1

好处:

1.避免分母为0的情况

2.减少过拟合(模型下降到同一个损失值时,加laplace smoothling的DIce系数要比不加laplace的Dice系数小)

优点:

1.代理函数就是优化目标函数

2.解决样本不平衡问题

缺点:

1.训练误差曲线非常混乱,很难看出关于收敛的信息

2.在正样本是小目标的时候,一旦有一部分预测错误,loss就会发生大幅度的变化

3.

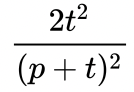

pt简化成一个值再来求梯度

梯度为

如果p、t过小则会导致梯度变化剧烈,导致训练困难

747

747

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?