1.消息传递范式

本文主要参考:DataWhale图神经网络组队学习

消息传递范式是一种聚合邻居节点信息来更新中心节点信息的范式。

此范式包含三个步骤:(1)邻接节点的信息变换(2)邻接节点信息聚合到中心节点(3)聚合信息变换。

PyG文档中给出消息传递图神经网络的公式描述如下:

creating message passing networks.

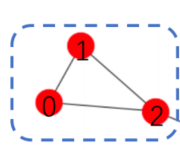

对于一个图(添加自环):

消息传递步骤1(

ϕ

(

k

)

\phi^{(k)}

ϕ(k))如下:

上图体现边上的源节点(0,1,2)进行线性变换后往目标节点(0)发送特征信息。

步骤2(

□

j

∈

N

(

i

)

\square_{j \in \mathcal{N}(i)}

□j∈N(i))如下:

目标节点(0)对收到的特征信息进行聚合(aggregate)。

最后一步(

γ

(

k

)

\gamma^{(k)}

γ(k))将聚合之后的信息进行变换,可以利用多层感知机等方法。

PyG中MessagePassing基类

Pytorch Geometric(PyG)提供了MessagePassing基类,它实现了消息传

播的自动处理,继承该基类可使我们方便地构造消息传递图神经网络,我

们只需定义函数,即message() 函数

ϕ

\phi

ϕ,和函数

γ

\gamma

γ,即 update()函数,以及使用的消息聚合方案,即aggr=“add” 、aggr="mean"或aggr=“max” 。

GCNConv示例

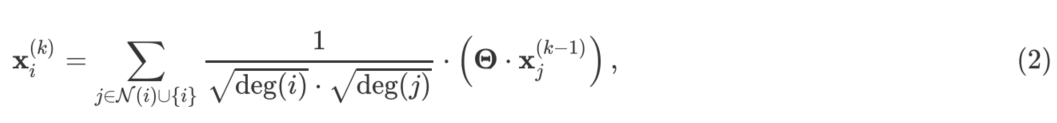

其中,相邻节点的特征首先通过权重矩阵

Θ

\Theta

Θ进行转换,然后按端点的度进

行归一化处理,最后进行加总。这个公式可以分为以下几个步骤:

- 向邻接矩阵添加自环边。

- 线性转换节点特征矩阵。

- 计算归一化系数。

- 归一化 中的节点特征。

- 将相邻节点特征相加("求和 "聚合)。

作业

1.请总结MessagePassing基类的运行流程。

2.请复现一个一层的图神经网络的构造,总结通过继承MessagePassing基类来构造自己的图神经网络类的规范。

总结MessagePassing基类的运行流程

运行流程:1.边上源节点往目标节点发送特征,其中发送的特征是经过线性转换以及利用计算得到的归一化系数处理之后的。 2.目标节点对收到的特征进行聚合,聚合的方式有很多种,例如mean,max,sum聚合。3.将聚合之后的信息再次进行变换,例如通过MLP进行变换。(可以没有第三步,例如GCN采用了前两步)

继承MessagePassing基类来构造自己的图神经网络类的规范。

构建自己的图神经网络如下:

x

i

(

k

)

=

1

∣

N

(

i

)

+

1

∣

∑

j

∈

N

(

i

)

∪

{

i

}

2

⋅

d

e

g

(

i

)

deg

(

i

)

⋅

deg

(

j

)

⋅

(

Θ

⋅

x

j

(

k

−

1

)

)

\mathbf{x}_{i}^{(k)}= \frac{1} {|\mathcal{N}(i)+1|}\sum_{j \in \mathcal{N}(i) \cup\{i\}} \frac{2 \cdot {deg}(i)}{\sqrt{\operatorname{deg}(i)} \cdot \sqrt{\operatorname{deg}(j)}} \cdot\left(\boldsymbol{\Theta} \cdot \mathbf{x}_{j}^{(k-1)}\right)

xi(k)=∣N(i)+1∣1∑j∈N(i)∪{i}deg(i)⋅deg(j)2⋅deg(i)⋅(Θ⋅xj(k−1))

可以看到上述的图神经网络在传递信息的时候不仅用到了源节点的信息,还用到了两倍的目标节点的度的信息,并且聚合采用的是mean聚合。

下面进行代码实现:

自定义设计好的图神经网络

class My_GCN(MessagePassing):

def __init__(self, in_channels, out_channels):

super(My_GCN, self).__init__(aggr='mean')

self.lin = torch.nn.Linear(in_channels, out_channels)

def forward(self, x, edge_index):

# 添加自环

edge_index, _ = add_self_loops(edge_index, num_nodes=x.size(0))

# 将输入的节点特征进行线性变换

x = self.lin(x)

# 计算归一化系数norm

row, col = edge_index

deg = degree(col, x.size(0), dtype=x.dtype)

deg_inv_sqrt = deg.pow(-0.5)

norm = deg_inv_sqrt[row] * deg_inv_sqrt[col]

# 执行消息传递

return self.propagate(edge_index, x=x, norm=norm, deg=deg.view(-1,1))

def message(self, x_j, norm, deg_i):

# 利用计算得到的归一化系数norm来归一化节点特征

return norm.view(-1,1) * x_j * 2 * deg_i

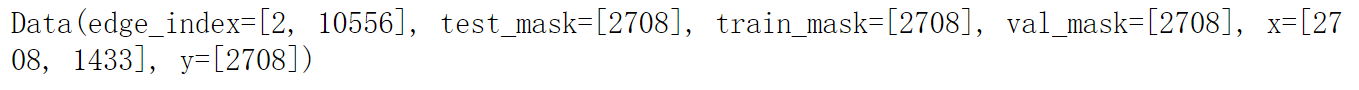

加载数据

from torch_geometric.datasets import Planetoid

dataset = Planetoid(root='dataset/Cora', name='Cora')

dataset

data = dataset[0]

data

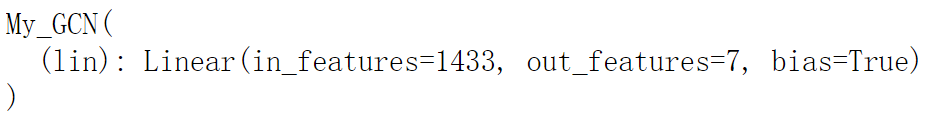

初始化网络

Net = My_GCN(dataset.num_features,dataset.num_classes)

Net

利用初始化好的网络进行节点更新

out_nodes_features = Net(data.x, data.edge_index)

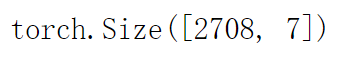

out_nodes_features.shape

可以看到,节点特征由一开始的1433维,经过图神经网络之后降维成定义的节点类别7.

查看分类准确率

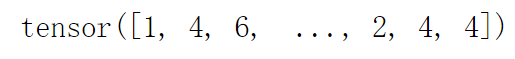

pred = out_nodes_features.argmax(dim=1)

pred

其中pred为每一个节点的预测类别。

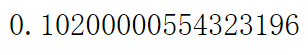

Accuracy = int((pred[data.test_mask] == data.y[data.test_mask]).sum()) / data.test_mask.sum()

Accuracy = Accuracy.item()

Accuracy

(此处只是演示,该网络并没有进行训练,因此这里生成的节点表示用于分类,其准确率肯定很低)

959

959

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?