WGAN介绍

1. 论文基本信息

(1) 作者:Martin Arjovsky, Soumith Chintala, Leon Bottou

(2) 题目:Wasserstein GAN

(3) 出处:International Conference on Machine Learning(ICML)

(4) 年份:2017

2. 论文背景及针对的问题

生成对抗网络(GAN)是一种无监督的深度学习模型,通过框架中的两个模块:生成模型和判别模型的相互博弈学习来得到较好的输出。但是原始的GAN网络采用的是迭代的方式进行训练,训练过程很困难,通常需要设计启发式算法以及精心设计网络架构,不具有通用性,且生成器与判别器的损失函数无法指示训练过程,同时还存在着生成样本缺乏多样性的问题。该论文主要针对原始GAN网络的这些问题对GAN网络进行了改进,提出了Wasserstein GAN(WGAN)。

3. 论文主要创新点及贡献

针对上述问题,论文中引入了Wasserstein距离来替代JS 散度和KL散度来作为优化目标,基于Wasserstein距离相对于KL散度与JS散度具有优越的平滑特性,从根本上解决了原始GAN的梯度消失问题。同时改进了训练流程,解决了GAN训练不稳定以及模式崩溃的问题,同时提供了可以指示训练进程的数值,网络不再需要精心设计。

4. 论文主要原理及算法介绍

(1) GAN网络基础介绍

GAN包含生成器G和判别器D两个部分,其结构如图所示

GAN的训练目标为

(2)WGAN的改进

论文作者分析了GAN训练不稳定问题的来源:原始GAN训练目标的形式等价于在最优判别器下最小化生成分布与真实分布的KL散度及JS散度,但如果两个分布不存在不可忽略的重叠,而这种情况时常出现,其梯度变为常数,导致无法训练。作者引入了Wasserstein距离来替代原始的JS和KL散度,其定义为:

其中 是两个分布的联合分布,即对每个可能的联合分布,从中采样真实样本x和生成样本y,计算该分布下距离的期望,所有期望的下界即为Wasserstein距离。作者推导得到Wasserstein距离更加平滑,提供了更有意义的梯度。

但实际中Wasserstein距离定义中下界无法求解,作者引入了Lipschitz连续限制,将其形式变换为

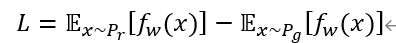

近似模拟Wasserstein距离,其中K即为对应的Lipschitz常数。因此可以构造一个参数为w,最后一层不是非线性激活层的判别器网络f_w,在限制参数w不超过某一范围下,最大化

与原始GAN的目标函数相比,只是将判别器最后一层sigmoid去掉,不取log,该损失函数可以指示训练的进程,其数值越小,说明真实分布与生成分布的Wasserstein距离越小,训练越好。同时作者在训练过程中还采取了将判别器参数更新后的绝对值截断到一定范围内以及不采用基于动量的优化算法等来优化训练过程,解决了训练不稳定问题。作者在实验部分进行了不少实验验证,证实了WGAN的有效性。

5. 不足

WGAN中采用权重截断的方式来满足Lipschitz连续性条件,但实际操作中采用这种方式可能会导致大部分权重最终都落在上下界限附近,因此神经网络的权重大部分可能只有两个数,极大限制了其拟合能力,导致梯度消失或爆炸。因此后续Ishaan等针对这一问题提出了WGAN-GP,采取了梯度惩罚解决了这一问题。

2750

2750

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?