作者原repo链接

https://github.com/linwhitehat/ET-BERT

0.资料总库

1.数据集

包含fine-tuning数据集(cstnet-tls 1.3)与公开数据集(USTC-TFC、VPN-app、VPN-service的数据包级和流级)目录链接

1.1 微调-数据集组成

即fine-tuning_dataset目录下的数据集,fine-tuning的数据集是tsv的

1.2 预训练-数据包级-组成

即Open-Datasets目录下的数据集

1.3 预训练-流级-组成

即Open-Datasets\flow-level目录下的数据集

1.4 预训练-组成(不在总资料库的数据集)

这部分应该是预训练使用的数据集(不太确定,等我看看代码先:(

cstnet-tls 1.3 dataset

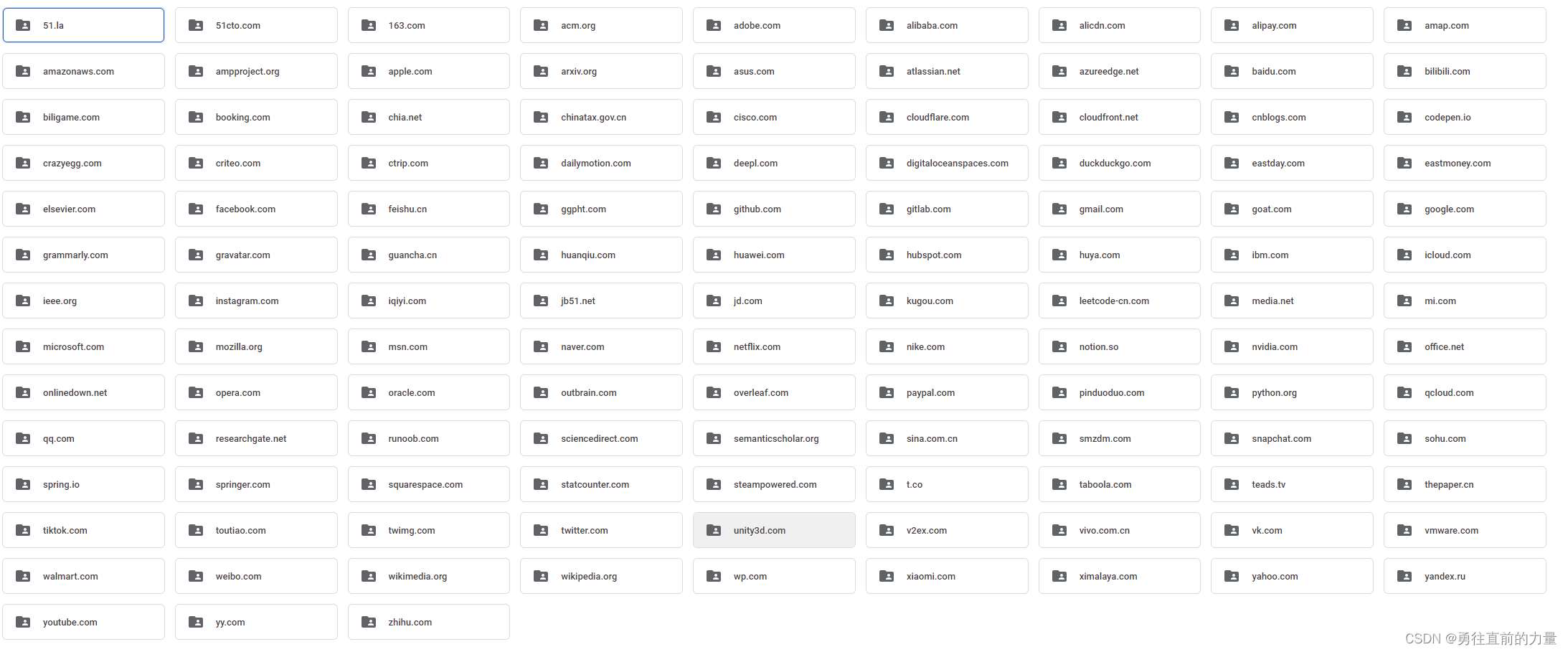

下面是cstnet-tls 1.3 dataset的label:

该数据集包含两个压缩文件,一个是flow级别的,另一个是packet级别的:

以flow_dataset为例:

CSTNET-TLS 1.3的流级别的数据集

- 该数据集有120个类别

- 每个类别有500个样本

- 数据部分以x_开头,标签部分以y_开头

- 有5种数据类型,包括direction, length, message type, time and datagram

- 不同的数据文件分别被划分为train, test, valid三种

514

514

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?