- 博客(11)

- 收藏

- 关注

原创 机器学习十——SVM二(自己学习与理解知识点梳理)

目录SVM的软间隔模型软间隔求解线性不可分的数据SMQ——序列最小优化算法SVRSVM的软间隔模型如果有异常点导致我们的数据线性不可分,也就是不满足下面条件了。下面条件就是预测对的数据都在支持向量的两侧。所以我们引入了软间隔的模型。硬间隔: 上一篇中我们讲到的svm的距离划分就是硬间隔。在线性可分的svm中要求函数距离一定大于1的就是上图的条件,为硬间隔条件。这里的松弛因子越大表示点里分割平面越近,允许的偏差越大。如果松弛因子大于1表示允许样本分错,如果松弛因子等于0表示是支持向量或者分对的样本

2020-06-01 15:18:59

296

296

原创 机器学习十——SVM(自己学习与理解知识点梳理)

目录点到直线的距离公式无约束的最优化求解(梯度下降)有约束的最优化求解对偶问题KKT条件串一下思路svm流程总结点到直线的距离公式无约束的最优化求解(梯度下降)用于求解没有限制(这里的限制指的是θ)的凸函数的极小值。是一中迭代的算法,因为凸函数只有一个极值点,所以求出来的极值就是最小值。导数:一个函数在某一点的导数,描述这个函数在这个点附近的变化率(也就是切线的斜率),导数值越大,变化率越大。导数大于0表示随着x增大y减小。这里我们希望差值(实际值和预测值的mse)减小,所以就减小x。在这个函数

2020-05-28 10:51:49

439

439

原创 机器学习九——集成学习之聚类算法Kmeans(自己学习与理解知识点梳理)

目录聚类算法相似度的计算聚类的思想损失函数Kmeans的思考Kmeans的问题Kmeans代码二分K-Means算法K-Means++算法Min Batch K-Means聚类算法聚类算法和分类算法一样,都是将样本类别划分,区别在于:分类算法是有监督的算法。去寻找x的特征和y的映射关系,在根据这个关系去做x的划分。聚类算法是无监督的算法。也就是说没有标签y,只有特征属性x。模型是通过找x特征的关系将x划分常用的聚类算法就是Kmeans、GMM高斯混合聚类。作为前期的数据处理过程中的一种数据标注的

2020-05-25 21:26:26

1420

1420

1

1

原创 机器学习七——集成学习之GBDT(自己学习与理解知识点梳理)

目录梯度提升迭代树(GBDT)直观理解GBDT原理代码梯度提升迭代树(GBDT)直观理解GBDT的底层必须是决策树,不支持其他算法。而且都是回归树,哪怕做分类也是回归树,所以GBDT的回归能力好,Adaboost的分类能力好。GBDT中不像Aeqboost中修改样本权重和模型权重去,而是根据梯度减少误差。比如我们预测年龄,直接拿到样本的特征输入到第一个模型中,得到的预测可能是20(每个模型前面有惩罚系数不会一上来就预测的很准,防止过拟合),然后计算真实值和预测值的差值来作为实际值输入到下一个模型中,

2020-05-22 22:08:05

475

475

原创 机器学习六——集成学习之Boosting(自己学习与理解知识点梳理)

目录Boosting的思想AdaboostAdaboost算法构建过程Adaboost(接着上一个Adaboost看)Boosting的思想每一步都产生一个弱分类器,并且加权累计形成总的模型。如果每一步产生的弱分类器是依据梯度的,那么就称之为梯度提升(GBDT)首先基于M个样本训练一个弱学习器,根据这个弱学习器对M个样本做修改,然后训练得到一个弱学习器2,依次下去,把各个弱学习器做一个权重的融合。融合的是各个模型结果的融合不是参数的融合AdaboostAdaboost是一种迭代算法,每一次在数据

2020-05-22 16:17:25

361

361

原创 机器学习五——集成学习之Bagging(自己学习与理解知识点梳理)

目录集成学习思想Bagging的思想Bagging中封装好的算法——随机森林 Random Forest随机森林的变种随机森林的总结代码集成学习思想我们如论如何调参数(网格交叉验证)也不能得到满意的模型,可能是模型本身的限制,这时候我们可以用集成学习的思想来做。注意多个学习器组合的时候要选用同一类,比如同是分类器并且一般是弱学习器集成思想的关键在于保留了每个学习器的特性。集成不稳定的算法也会有较大提升。比如说树结构中如果构造的过深会造成过拟合,把一些异常点也学进去,但是在集成学习中每个学习器是用总样

2020-05-21 17:41:27

852

852

原创 机器学习四——决策树(自己学习与理解知识点梳理)

目录比特化信息熵条件熵决策树的构建损失函数代码决策树可视化剪枝分类树和回归树的区别比特化假设变量有N个,每个用2个比特位表示,那么一个就要用2N个比特位来表示N个变量。这里的2是如何计算来的。是因为第一个图中说是等概率的,有四种变量,每种出现的概率就是1/4.所以21/4+21/4+21/4+21/4=2。在下面的图中,A出现的概率比较大,D出现的概率比较小,所以A用短的序列表示,D用长的序列表示。所以下图平均每个变量是用1.75个比特位。这里用几个比特位表示,其实是和概率有关系的。-log

2020-05-21 00:16:12

302

302

原创 机器学习三——KNN(自己学习与理解知识点梳理)

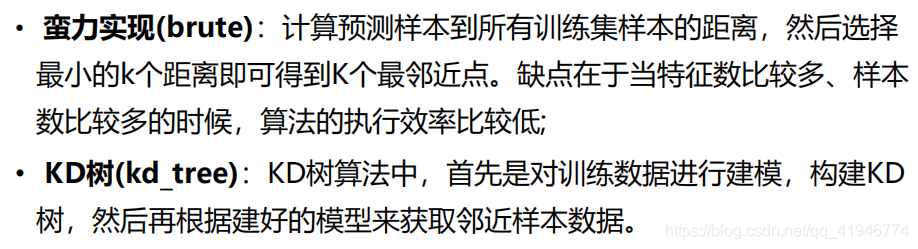

目录KNN的三要素KNN实现方式KD Tree的构建KD Tree寻找最近邻代码KNN的三要素KN

2020-05-20 12:07:18

262

262

原创 机器学习二——逻辑回归(自己学习与理解知识点梳理)

目录逻辑回归似然函数softmax代码逻辑回归似然函数在这里可以看作是线性回归+sigmoid函数。sigmoid函数的作用就是把我们线性回归计算出来的结果映射到0到1之间。这是逻辑回归的似然函数,因为似然函数时取极大值我们添加符号就可以变为求最小值,方便后面求导取最小值。当y的标签为1时后面部分为1,当y的标签为0时前面部分为1.取对数变为相加的结构在求导,取的最小值softmax逻辑回归是用于二分类问题,softmax是用于多分类问题。softmax的函数为分母上是各个概率

2020-05-19 22:47:09

260

260

原创 机器学习算法一:线性回归(本人学习与理解粗略知识点)

这里写自定义目录标题分类模型评估指标回归模型评估指标线性回归极大似然估计求解正则惩罚项梯度下降求解线性回归(后面单独写)局部加权回归代码部分K折交叉验证分类模型评估指标召回率(覆盖率/查全率)和精准率(查准率):召回率指的是你预测正确的正样例占样本中正样例的个数,所以可以理解为你在样本的正样例中预测对的有多少。精准率指的是你预测为正的样本中有多少是预测对的。分母不一样,导致他们两个的侧重点不一样。比如举例一个场景,在癌症病人预测问题中,我们要用召回率还是准确率。我们把一个有病的人预测为没

2020-05-19 16:52:03

540

540

空空如也

空空如也

TA创建的收藏夹 TA关注的收藏夹

TA关注的人

RSS订阅

RSS订阅