B站up主“刘二大人”视频 笔记

说在前面:

这部分内容有不少更新指出:

(1)构建数据集用到了torch中的Tensor;

(2)通过创建python中的线性模型类,并实例化它,来构建模型;

(3)损失函数通过torch.nn库调用其中的MSELoss;

(4)优化器通过调用torch.optim库中的SGD实现;

(5)训练过程稍有变化,这里面第一次出现了梯度清零这个问题,用到的是优化库optim中的zero_grad()方法;

详细过程:

本课程的主要任务是利用torch包的requires_grad自动求导,构建反向传播模型:

导入numpy、matplotlib、os、torch库;

导入数据 x_data 和 y_data,注意这里有变化,用到了torch中的Tensor格式,与04课程相同,所以才会出现data和grad的重要区别;

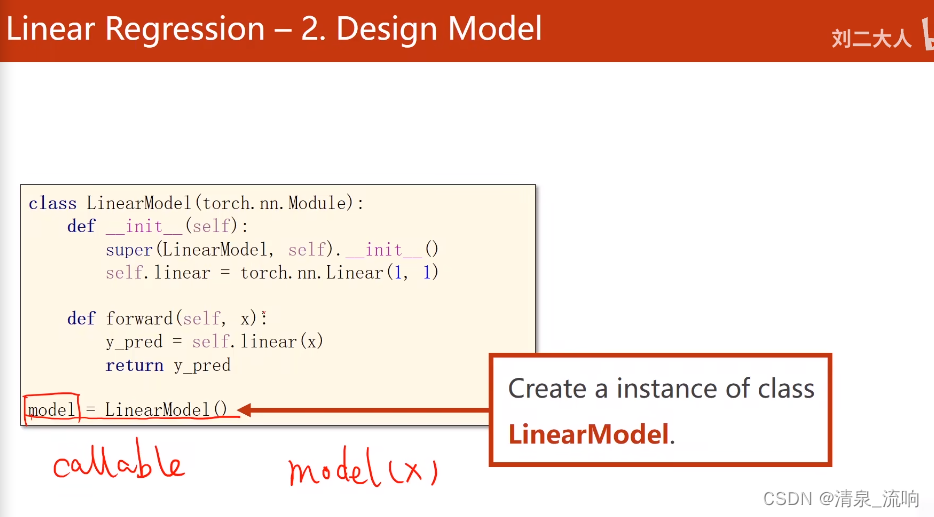

创建LinearModel类模型:

初始化init中,只有一个linear函数;注意要提前继承(这一步直接写,不深究);

前向传播forward方法,这是把之前的前向传播函数,拿进来做了类中的一个方法,返回预测值;

实例化一个模型model;

创建损失函数:通过调用torch.nn库中的MSELoss实现;

创建优化器:通过调用torch.optim库中的SGD实现;

创建两个空列表,因为后面绘图的时候要用:

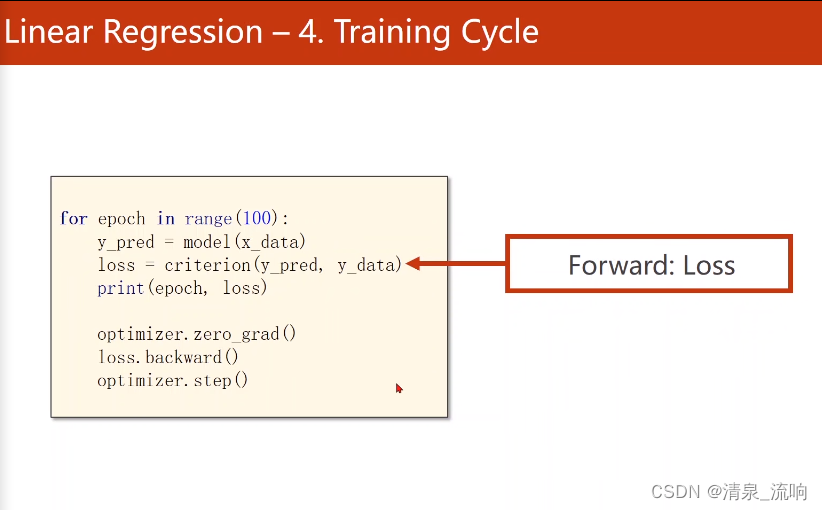

创建循环,开始训练:循环的次数epoch可以自定义

y_hat用模型model计算;

损失loss用创建好的损失函数计算;

先用优化器对梯度清零(重要,要清楚什么时候该清零,为什么清零,原理是什么);

令损失反向传播loss.backward;

执行一步权重更新操作,用到的函数optimizer.step( )很奇特,这里非常关键,理解起来不容易,见下面的链接;

在循环中要把计算的结果,放进之前的空列表,用于绘图;

在获得了打印所需的数据列表只有,模式化地打印图像。

程序如下:

import torch

x_data = torch.Tensor([[1.0], [2.0], [3.0]]) # 3*1矩阵

y_data = torch.Tensor([[2.0], [4.0], [6.0]])

class LinearModel(torch.nn.Module): # LinearModel类继承父类Module

def __init__(self):

super(LinearModel, self).__init__()

self.linear = torch.nn.Linear(1, 1, bias=True) # 类nn.Linear包含了2个tensor对象:权重w,偏置b。Linear也是继承Module

# nn表示neural network,self.linear是个对象

def forward(self, x):

y_pre = self.linear(x)

return y_pre

model = LinearModel()

criterion = torch.nn.MSELoss(size_average=False) # 构造损失函数

optimizer = torch.optim.SGD(model.parameters(), lr=0.01) # 构造优化器 lr为学习率

for epoch in range(1000):

y_pre = model(x_data) # 在前馈算y_hat

loss = criterion(y_pre, y_data) # 算损失

print(epoch, loss)

optimizer.zero_grad() # 把所有权重的梯度归零

loss.backward() # 反馈

optimizer.step() # 更新

print('w= ', model.linear.weight.item())

print('b= ', model.linear.bias.item())

x_test = torch.Tensor([[4.0]]) # 1*1矩阵

y_test = model(x_test)

print('y_pre= ', y_test.data)运行结果如下:

前馈算损失,反馈算梯度。

行表示样本个数,列表示特征

callable(可调用的)

273

273

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?