B站UP主“我是土堆”视频内容

torch.nn是专门为神经网络设计的模块化接口. nn构建于autograd之上,可以用来定义和运行神经网络。

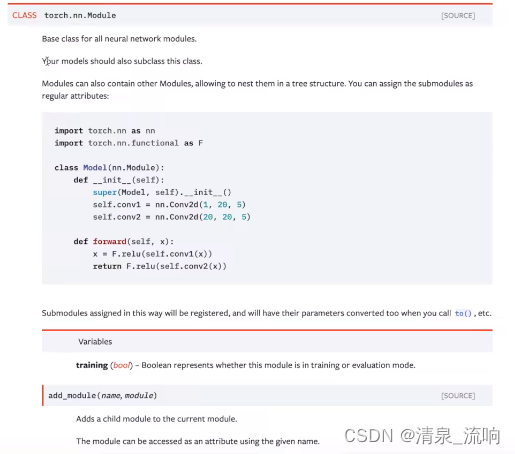

nn.Module是nn中十分重要的类,包含网络各层的定义及forward方法。

如何定义自己的网络:

需要继承nn.Module类,并实现forward方法。继承nn.Module类之后,在构造函数中要调用Module的构造函数, super(Linear, self).init()

一般把网络中具有可学习参数的层放在构造函数__init__()中。

不具有可学习参数的层(如ReLU)可放在构造函数中,也可不放在构造函数中(而在forward中使用nn.functional来代替)。可学习参数放在构造函数中,并且通过nn.Parameter()使参数以parameters(一种tensor,默认是自动求导)的形式存在Module中,并且通过parameters()或者named_parameters()以迭代器的方式返回可学习参数。

只要在nn.Module中定义了forward函数,backward函数就会被自动实现(利用Autograd)。而且一般不是显式的调用forward(layer.forward), 而是layer(input), 会自执行forward().

在forward中可以使用任何Variable支持的函数,毕竟在整个pytorch构建的图中,是Varible在流动。还可以使用if, for, print, log等python语法。

值得注意的是:

Pytorch基于nn.Module构建的模型中,只支持mini-batch的Variable输入方式。比如,只有一张输入图片,也需要变成NxCxHxW的形式。

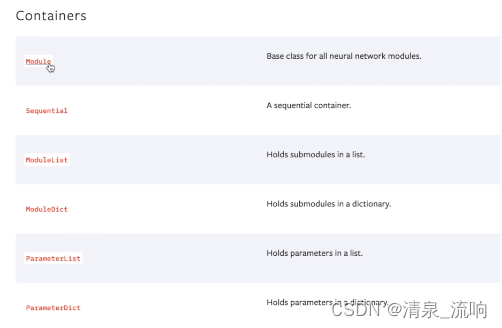

神经网络主要的工具在torch.nn里面

程序如下:

import torch

from torch import nn

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

def forward(self, input):

output = input+1

return output

tudui = Tudui()

x = torch.tensor(1.0)

output = tudui(x)

print(output)参考文献:

3631

3631

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?