本系列文章如果没有特殊说明,正文内容均解释的是文字上方的图片

机器学习 | Coursera

吴恩达机器学习系列课程_bilibili

9 神经网络:Learning

9-1 应用于神经网络的代价函数

- 用 L L L表示神经网络的总层数(Layers)

- 用 s l s_l sl表示第 l l l层单元(神经元)的数量(不包括偏置单元)

- h Θ ( x ) ∈ R K h_\Theta(x)\in\mathbb{R}^K hΘ(x)∈RK( h Θ ( x ) h_\Theta(x) hΘ(x)为 K K K维向量,即神经网络输出层共有 K K K个神经元,即有 K K K个输出)

- ( h Θ ( x ) ) i = i t h o u t p u t (h_\Theta(x))_i=i^{th} output (hΘ(x))i=ithoutput( ( h Θ ( x ) ) i (h_\Theta(x))_i (hΘ(x))i表示第 i i i个输出)

应用于神经网络的代价函数为:

J ( Θ ) = − 1 m [ ∑ i = 1 m ∑ k = 1 K y ( i ) l o g ( h Θ ( x ( i ) ) ) k + ( 1 − y k ( i ) ) l o g ( 1 − ( h Θ ( x ( i ) ) ) k ) ] + λ 2 m ∑ l = 1 L − 1 ∑ i = 1 s l ∑ j = 1 s l + 1 ( Θ j i ( l ) ) 2 J(\Theta)=-\frac{1}{m}\left[\sum_{i=1}^m\sum_{k=1}^Ky^{(i)}log(h_\Theta(x^{(i)}))_k+(1-y_k^{(i)})log(1-(h_\Theta(x^{(i)}))_k)\right] +\frac{λ}{2m}\sum_{l=1}^{L-1}\sum_{i=1}^{s_l}\sum_{j=1}^{s_{l+1}}(\Theta_{ji}^{(l)})^2 J(Θ)=−m1[i=1∑mk=1∑Ky(i)log(hΘ(x(i)))k+(1−yk(i))log(1−(hΘ(x(i)))k)]+2mλl=1∑L−1i=1∑slj=1∑sl+1(Θji(l))2

- 第二项中的 ∑ i = 1 s l ∑ j = 1 s l + 1 \sum_{i=1}^{s_l}\sum_{j=1}^{s_{l+1}} ∑i=1sl∑j=1sl+1指的是将 s l + 1 s_{l+1} sl+1行 s l s_l sl列的矩阵 Θ j i ( l ) \Theta_{ji}^{(l)} Θji(l)中的每一个元素相加起来

- 第二项中的 ∑ l = 1 L − 1 \sum_{l=1}^{L-1} ∑l=1L−1指的是将输入层和隐藏层的矩阵都求和

9-2 反向传播算法

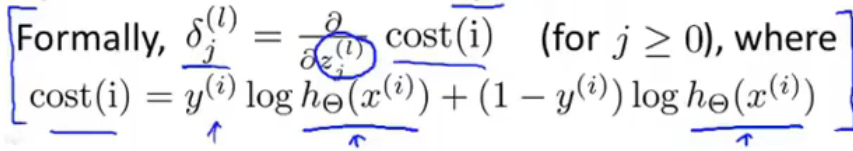

-

δ

j

(

l

)

\delta_j^{(l)}

δj(l)定义为第

l

l

l层第

j

j

j个神经元的偏差(“error”)

以上图的四层的神经网络为例 - δ j ( 4 ) = a j ( 4 ) − y j \delta_j^{(4)}=a_j^{(4)}-y_j δj(4)=aj(4)−yj( y j y_j yj指第 j j j个输出在数据集中的值, a j ( 4 ) a_j^{(4)} aj(4)指神经网络的第 j j j个输出, a j ( 4 ) a_j^{(4)} aj(4)也可表示为 ( h Θ ( x ) ) j (h_\Theta(x))_j (hΘ(x))j)

- 用向量方法表示上式可表示为 δ ( 4 ) = a ( 4 ) − y \delta^{(4)}=a^{(4)}-y δ(4)=a(4)−y,也可表示为 δ ( 4 ) = h Θ ( x ) − y \delta^{(4)}=h_\Theta(x)-y δ(4)=hΘ(x)−y

-

δ

(

3

)

=

(

Θ

(

3

)

)

T

δ

(

4

)

⋅

g

′

(

z

(

3

)

)

\delta^{(3)}=(\Theta^{(3)})^T\delta^{(4)}\cdot g^{\prime}(z^{(3)})

δ(3)=(Θ(3))Tδ(4)⋅g′(z(3))

其中 g ′ ( z ( 3 ) ) = a ( 3 ) ⋅ ( 1 − a ( 3 ) ) g^{\prime}(z^{(3)})=a^{(3)}\cdot (1-a^{(3)}) g′(z(3))=a(3)⋅(1−a(3)) -

δ

(

2

)

=

(

Θ

(

2

)

)

T

δ

(

3

)

⋅

g

′

(

z

(

2

)

)

\delta^{(2)}=(\Theta^{(2)})^T\delta^{(3)}\cdot g^{\prime}(z^{(2)})

δ(2)=(Θ(2))Tδ(3)⋅g′(z(2))

其中 g ′ ( z ( 2 ) ) = a ( 2 ) ⋅ ( 1 − a ( 2 ) ) g^{\prime}(z^{(2)})=a^{(2)}\cdot (1-a^{(2)}) g′(z(2))=a(2)⋅(1−a(2))

点乘结果是一个数,叉乘结果是一个向量

-

∂

∂

Θ

i

j

(

l

)

J

(

Θ

)

=

a

j

(

l

)

δ

i

(

l

+

1

)

\frac{\partial}{\partial \Theta_{ij}^{(l)}}J(\Theta)=a_j^{(l)}\delta_i^{(l+1)}

∂Θij(l)∂J(Θ)=aj(l)δi(l+1)

这里忽略了正则化项,即认为 λ = 0 \lambda=0 λ=0

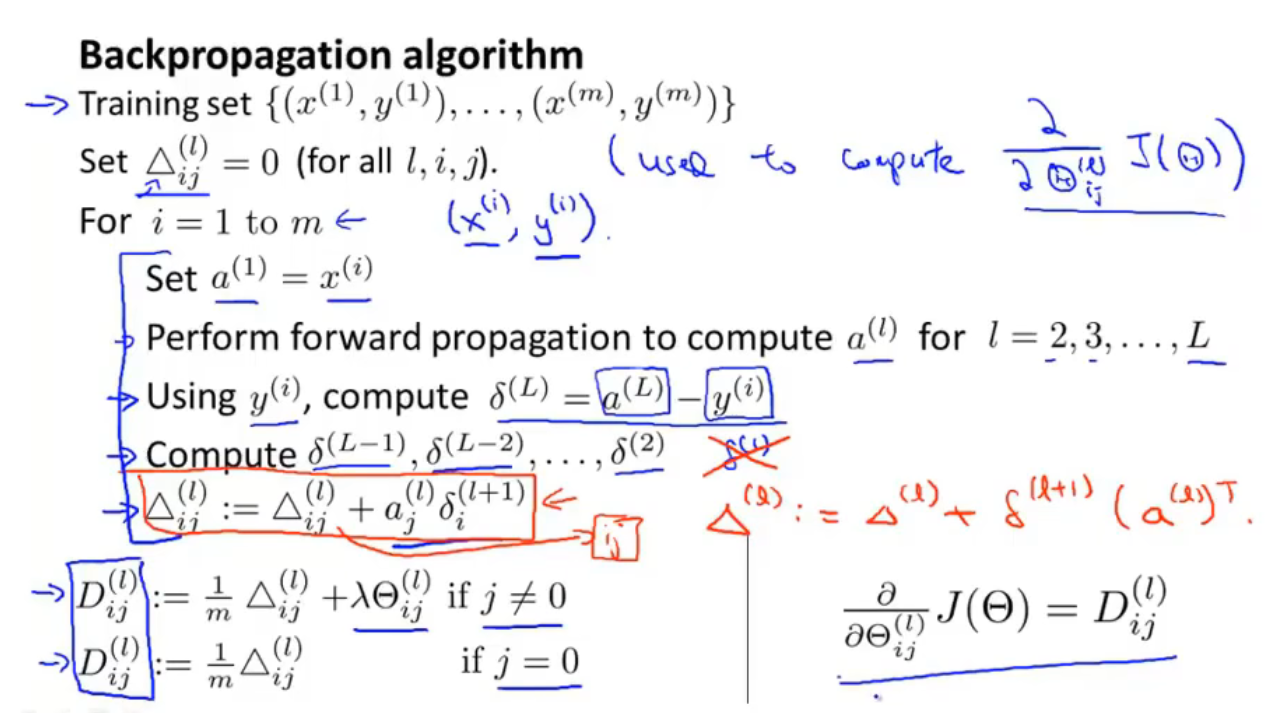

- 上图是反向传播算法的流程,最后可以得到 ∂ ∂ Θ i j ( l ) J ( Θ ) = D i j ( l ) \frac{\partial}{\partial \Theta_{ij}^{(l)}}J(\Theta)=D^{(l)}_{ij} ∂Θij(l)∂J(Θ)=Dij(l),然后进行梯度下降算法

9-3 理解反向传播

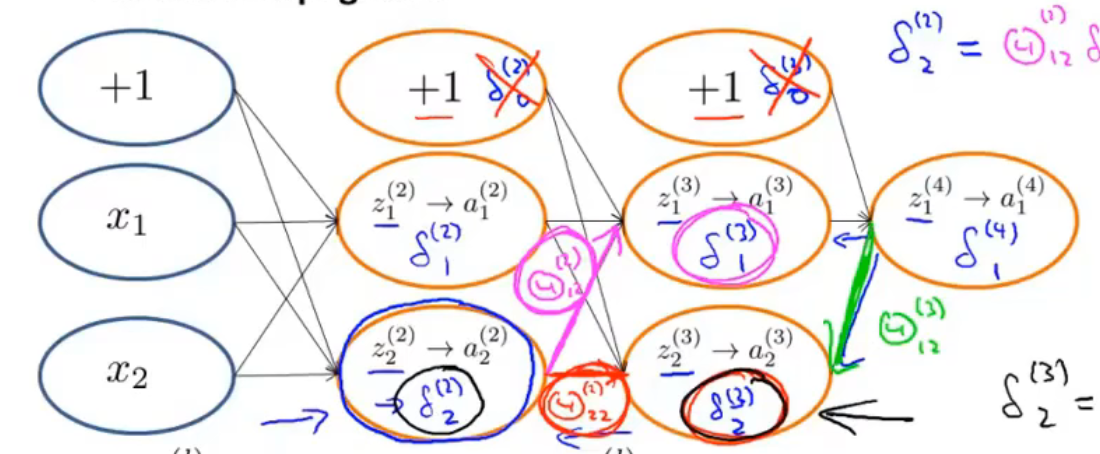

以上图的神经网络为例

- δ 2 ( 2 ) = Θ 12 ( 2 ) δ 1 ( 3 ) + Θ 22 ( 2 ) δ 2 ( 3 ) \delta_2^{(2)}=\Theta_{12}^{(2)}\delta_1^{(3)}+\Theta_{22}^{(2)}\delta_2^{(3)} δ2(2)=Θ12(2)δ1(3)+Θ22(2)δ2(3)

- δ 2 ( 3 ) = Θ 12 ( 3 ) δ 1 ( 4 ) \delta_2^{(3)}=\Theta_{12}^{(3)}\delta_1^{(4)} δ2(3)=Θ12(3)δ1(4)

9-4 展开参数

9-5 梯度检测

要估计代价函数

J

(

Θ

)

J(\Theta)

J(Θ)上点

(

θ

,

J

(

Θ

)

)

(\theta,J(\Theta))

(θ,J(Θ))处的导数值,可以运用

d

d

θ

J

(

θ

)

≈

J

(

θ

+

ε

)

−

J

(

θ

−

ε

)

2

ε

(

ε

=

1

0

−

4

为

宜

)

\frac{\mathrm{d} }{\mathrm{d} \theta}J(\theta)\approx\frac{J(\theta+\varepsilon)-J(\theta-\varepsilon)}{2\varepsilon}(\varepsilon=10^{-4}为宜)

dθdJ(θ)≈2εJ(θ+ε)−J(θ−ε)(ε=10−4为宜)求得导数

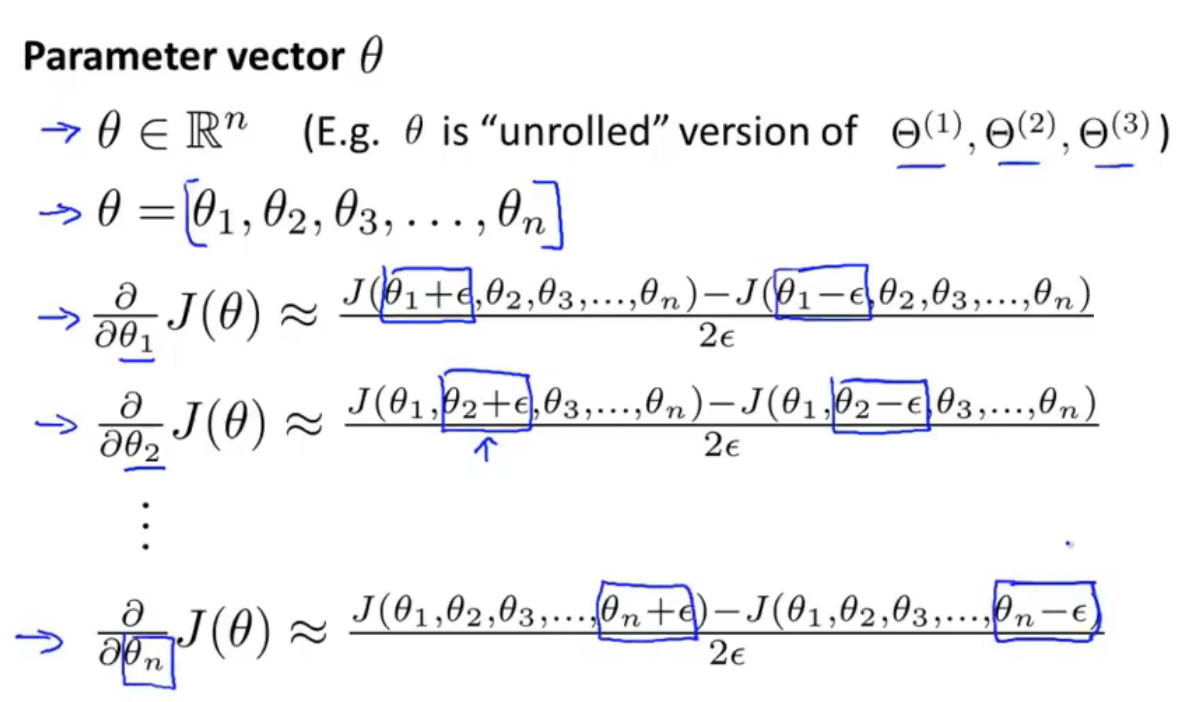

扩展到向量中,如上图

- θ \theta θ是一个 n n n维向量,是矩阵 Θ ( 1 ) , Θ ( 2 ) , Θ ( 3 ) , . . . \Theta^{(1)},\Theta^{(2)},\Theta^{(3)},... Θ(1),Θ(2),Θ(3),...的展开

- 可以估计 ∂ ∂ θ n J ( θ ) \frac{\partial}{\partial \theta_{n}}J(\theta) ∂θn∂J(θ)的值

将估计得到的偏导数值与反向传播得到的偏导数值比较,如果两个值非常近,就可以验证计算是正确的

一旦确定反向传播算法计算出的值是正确的,就应该关掉梯度检验算法

9-6 随机初始化

如果在程序开始时令

Θ

\Theta

Θ中所有元素均为0,会导致多个神经元计算相同的特征,导致冗余,这成为对称权重问题

所以在初始化时要令

Θ

i

j

(

l

)

\Theta^{(l)}_{ij}

Θij(l)等于

[

−

ϵ

,

ϵ

]

[-\epsilon,\epsilon]

[−ϵ,ϵ]中的一个随机值

9-7 回顾总结

训练一个神经网络:

1.随机一个初始权重

2.执行前向传播算法,得到对所有

x

(

i

)

x^{(i)}

x(i)的

h

Θ

(

x

(

i

)

)

h_\Theta(x^{(i)})

hΘ(x(i))

3.计算代价函数

J

(

Θ

)

J(\Theta)

J(Θ)

4.执行反向传播算法,计算

∂

∂

Θ

j

k

(

l

)

J

(

Θ

)

\frac{\partial}{\partial\Theta_{jk}^{(l)}}J(\Theta)

∂Θjk(l)∂J(Θ)

(get

a

(

l

)

a^{(l)}

a(l) and

δ

(

l

)

\delta^{(l)}

δ(l) for

l

=

2

,

.

.

.

,

L

l=2,...,L

l=2,...,L)

5.通过梯度检验算法得到估计的

J

(

Θ

)

J(\Theta)

J(Θ)的偏导数值,将估计得到的偏导数值与反向传播得到的偏导数值比较,如果两个值非常近,就可以验证反向传播算法的计算结果是正确的;验证完后,关闭梯段检验算法(disable gradient checking code)

6.运用梯度下降算法或其他更高级的优化方法,结合反向传播计算结果,得到使

J

(

Θ

)

J(\Theta)

J(Θ)最小时的参数

Θ

\Theta

Θ的值

425

425

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?