反卷积(deconvolution),也叫转置卷积,分部卷积(fractionally-strided convolution),在论文中也叫upconv。

1. Pytorch中2D卷积和反卷积的函数

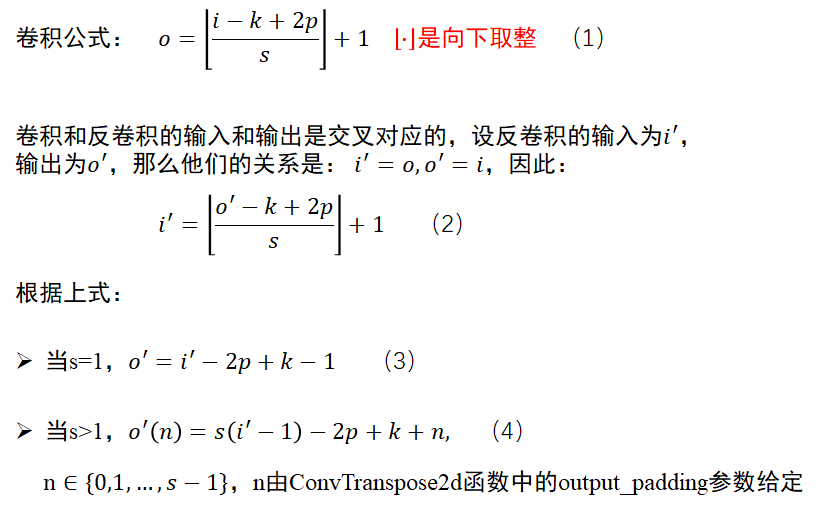

class torch.nn.Conv2d(in_channels, out_channels, kernel_size, stride=1, padding=0, groups=1, bias=True)

class torch.nn.ConvTranspose2d(in_channels, out_channels, kernel_size, stride=1, padding=0, output_padding=0, bias=True)

2. 卷积和反卷积的关系

这里参考PyTorch中反卷积的用法

3. 反卷积事例1——s=1

这里参考验证torch中卷积和反卷积的计算

代码

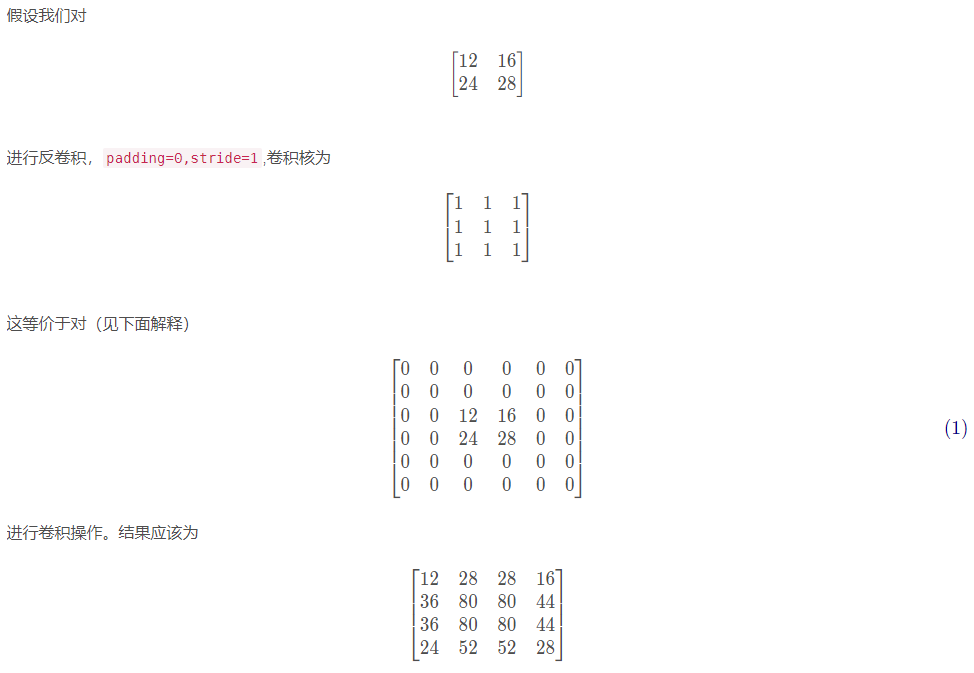

model = nn.ConvTranspose2d(in_channels=1, out_channels=1, kernel_size=3,stride=1,padding=0)

x = torch.tensor([[[12,16],[24,28]]], dtype=torch.float32).unsqueeze(0)

model.weight.data = torch.tensor([[[[1,1,1],[1,1,1],[1,1,1]]]], dtype=torch.float32)

model.bias.data = torch.zeros(1)

print(model(x))

结果

tensor([[[[12., 28., 28., 16.],

[36., 80., 80., 44.],

[36., 80., 80., 44.],

[24., 52., 52., 28.]]]], grad_fn=<SlowConvTranspose2DBackward>)

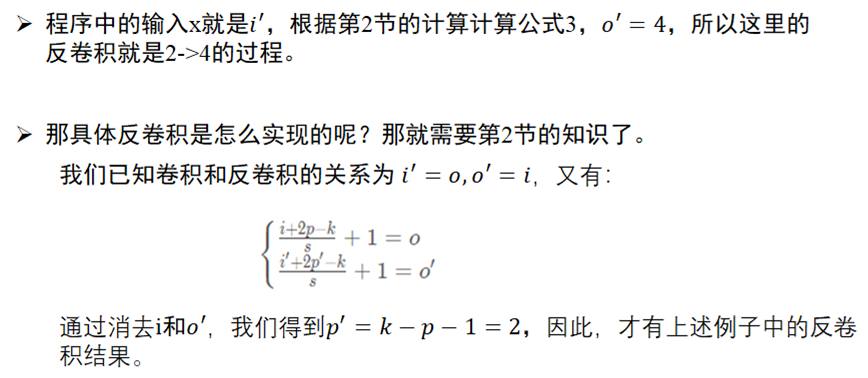

过程分析

4. 反卷积事例2——s>1

这里参考了Pytorch中的卷积与反卷积详解(conv2d和convTranspose2d)

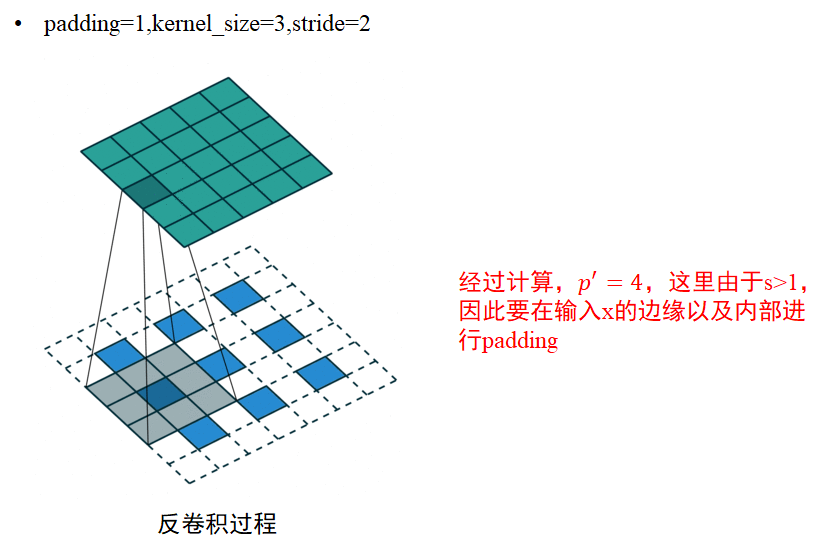

import torch

import torch.nn as nn

x = torch.randn(1,1,3,3)

l = nn.ConvTranspose2d(1,1,3,stride=2,padding=1)#Conv2d(1, 1, kernel_size=3,stride=2,padding=1)

y = l(x) # y.shape:[1,1,5,5]

5. 总结

其实我们可以看到,卷积和反卷积的唯一区别就是:卷积只在输入x的外部进行padding,而反卷积在s>1时需要在x的边缘和内部进行padding。

所以,如果要使用反卷积,那么对于s=1的情况,反卷积操作直接可以用卷积代替;而对于s>1的情况,才需要用反卷积。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?