Stable Diffusion 模型存放路径

.\stable-diffusion-webui\models\Stable-diffusion

Stable Diffusion 模型下载路径

https://www.liblib.ai/

VAE存放路径

.\stable-diffusion-webui\models\VAE

VAE下载网站

https://civitai.com/

放大算法存放路径

./stable-diffusion-webui/models/ESRGAN

放大算法下载网站

https://upscale.wiki/wiki/Model_Database

LORA训练工具kohya_ss安装–通过阿里云EAS部署服务

创建OSS

创建buket

lora训练

source model设置

folders设置

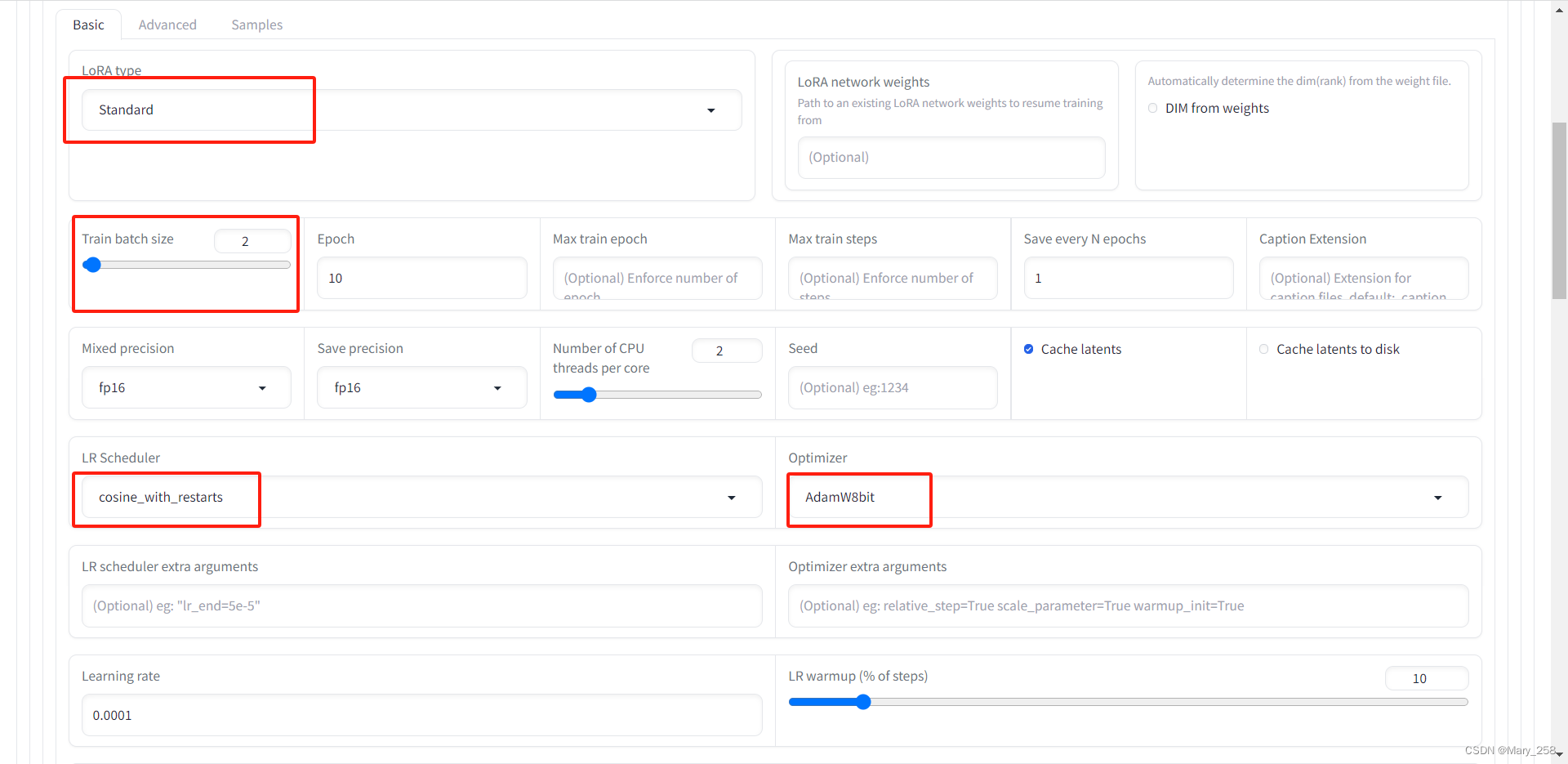

parameters

Train batch size:一次性单次送入模型的图片数 (A 10,不能超过4)

save every N epochs

LR Scheduler学习率

Network Rank (Dimension):学习的纬度

Network Alpha:创意

2 Network Alpha ≤ Network Rank (Dimension)

人脸推荐:128,64

Dataset Preparation

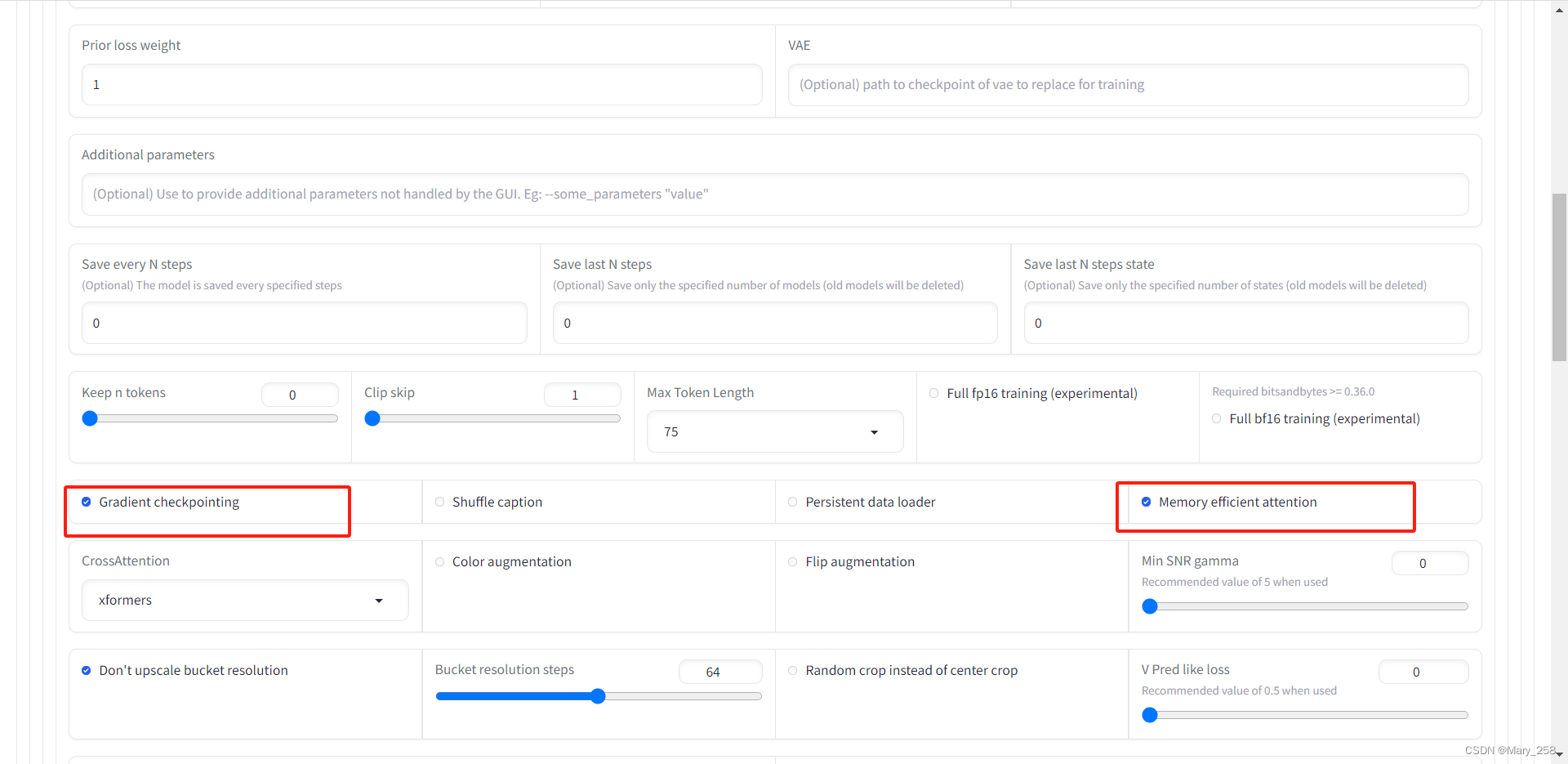

advanced

print training command:打印参数

start training:开始训练

图片打标签的方式

LoRA训练设置

将生成的lora模型放在 ./model/Lora文件夹下,选择合适的checkpoints

x,y轴值的初始值与选择的模型的初始值保持一致

3081

3081

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?