BEVWorld:基于统一 BEV 潜伏空间的自动驾驶多模态世界模型(https://www.zhihu.com/search?q=%E4%B8%96%E7%95%8C%E6%A8%A1%E5%9E%8B&search_source=Entity&hybrid_search_source=Entity&hybrid_search_extra=%7B%22sourceType%22%3A%22article%22%2C%22sourceId%22%3A712524999%7D))

Abstract

世界模型因其对未来潜在场景的预测能力而在自动驾驶领域受到越来越多的关注。在本文中,我们提出了 BEVWorld,这是一种新方法,将多模态传感器输入标记到一个统一且紧凑的鸟瞰图(BEV)潜在空间中,用于环境建模。世界模型由多模态标记器和潜在 BEV 序列扩散模型两部分组成。多模态标记器首先对多模态信息进行编码,解码器能够将潜在的 BEV 标记重构为 LiDAR 和图像观测,通过光线投射渲染以自监督的方式进行。然后,潜伏 BEV 序列扩散模型以动作令牌为条件预测未来场景。实验证明了 BEVWorld 在自动驾驶任务中的有效性,展示了其生成未来场景的能力,并有利于感知和运动预测等下游任务。代码将在 zympsyche/BevWorld (github.com) 上提供。

1 Introduction

近年来,自动驾驶取得了长足的进步,但仍面临一些挑战。首先,训练一个可靠的自动驾驶系统需要大量精确标注的数据,这是资源密集型和耗时的。因此,探索如何在自监督学习范式中利用未标记的多模态传感器数据至关重要。此外,可靠的自动驾驶系统不仅需要对环境的感知能力,还需要对环境信息的全面理解,以便做出决策。

我们认为,应对这些挑战的关键是构建自动驾驶的多模态世界模型。通过对环境进行建模,世界模型可以预测未来的状态和行为,使自主代理能够做出更复杂的决策。最近,一些世界模型已经证明了它们在自动驾驶中的实际意义 [12,42,40]。然而,大多数方法都基于单一模式,无法适应当前的多传感器、多模式自动驾驶系统。由于多模态数据的异构性,将它们集成到一个统一的生成模型中并无缝适应下游任务仍然是一个悬而未决的问题。

在本文中,我们引入了 BEVWorld,这是一种多模态世界模型,它将多样化的多模态数据转换为统一的鸟瞰图(BEV)表示,并在这个统一的空间内执行动作条件的未来预测。我们的 BEVWorld 由两部分组成:多模态标记器网络和潜伏 BEV 序列扩散网络。

多模态标记器的核心能力在于将原始多模态传感器数据压缩到一个统一的 BEV 潜在空间中。这是通过将视觉信息转换为 3D 来实现的,使用**自动编码器结构以自监督方式将视觉语义信息与激光雷达几何信息对齐**。为了反转这一过程并重建多模态数据,从 BEV 潜伏构建 3D 体积表示,以使用基于射线的渲染技术预测高分辨率图像和点云 [39]。

Latent BEV Sequence Diffusion 网络旨在预测未来的图像帧和点云。在多模态标记器的帮助下,这项任务变得更容易,从而可以准确预测未来的 BEV。具体来说,我们使用了一种基于扩散的方法和**时空转换器**,该方法将顺序噪声的 BEV 潜伏物转换为基于动作条件的干净的未来 BEV 预测。

总而言之,本文的主要贡献是:

• 我们引入了一种新颖的多模态标记器,它将视觉语义和 3D 几何集成到统一的 BEV 表示中。通过创新地应用基于渲染的方法来恢复 BEV 的多传感器数据,确保了 BEV 表示的质量。BEV 表示的有效性通过消融研究、可视化和下游任务实验得到了验证。

• 我们设计了一个基于潜在扩散的世界模型,可以同步生成未来的多视图图像和点云。在 nuScenes 和 Carla 数据集上进行的大量实验展示了多模态数据领先的未来预测性能。

2 Related Works

2.1 World Model

本部分主要回顾 World Model 在自动驾驶领域的应用,重点介绍场景生成以及规划和控制机制。如果按照关键应用进行分类,我们将涌现出来的世界模型作品分为两类。

(1)驾驶场景生成。自动驾驶的数据收集和标注成本高,有时还存在风险。相比之下,世界模型由于其固有的自监督学习范式,找到了另一种方法来丰富无限、多样化的驾驶数据。GAIA-1[12] 采用在现实世界中收集的多模态输入,基于不同的提示(如天气变化、场景、交通参与者、车辆行为)以自回归预测的方式生成多样化的驾驶场景,显示出其对世界的理解能力。ADriver-I[13] 将多模态**大语言模型与视频潜在扩散模型相结合,对未来场景和控制信号进行预测,显著提高了决策的可解释性,证明了 World Model 作为基础模型的可行性。MUVO [3] 在视频之外集成了 LiDAR 点云,以在图像、点云和 3D 占用率的表示中预测未来的驾驶场景。此外,Copilot4D [42] 利用在 BEV 代币上运行的离散扩散模型来执行 3D 点云预测,而 OccWorld [45] 采用类似 GPT 的生成架构进行 3D 语义占用预测和运动规划**。DriveWorld [27] 和 UniWorld [26] 将 World Model 作为 4D 场景理解任务进行预训练,用于下游任务的预训练。

(2)计划与控制。MILE[11] 是采用基于模型的模仿学习方法进行自动驾驶联合动力学、未来环境和驾驶策略学习的开创性工作。DriveDreamer [33] 提供了一个全面的框架,利用 HDMap 和 3D box 等 3D structural information 来预测未来的驾驶视频和驾驶动作。除了单一前视图生成之外,DriveDreamer-2 [44] 还根据用户描述生成多视图驾驶视频。TrafficBots [43] 通过促进 BEV 视角的动作预测,为多模态运动预测和端到端驾驶开发了一个 World Model。Drive-WM[34] 生成可控的多视图视频,并将 World Model 应用于安全驾驶规划,根据基于图像的奖励确定最优轨迹。

2.2 Video Diffusion Model

World model 可以看作是 a sequence-data generation task,属于视频预测的范畴。许多早期方法 [11,12] 采用 VAE [17]和 auto-regression [6] 来生成未来预测。然而,VAE 的生成质量不尽如人意,自回归方法存在累积误差问题。因此,许多研究人员转向研究 diffusion-based 的未来预测方法 [44,20],该方法最近在 video generation 领域取得了成功并具有同时预测多个未来帧的能力。本部分主要综述视频扩散模型的相关方法。

标准 video diffusion 模型 [10] 以时间噪声为输入,采用具有时间关注的 UNet[29] 来获得去噪视频。然而,这种方法需要 high training costs,the generation quality 需要进一步提高。后续的方法主要是沿着这两个方向进行改进。针对 high training costs 的问题,LVDM[9] 和 Open-Sora[18] 方法通过 VAE 或 VideoGPT[37] 等方案将视频压缩到 latent space 中,从空间和时间维度上降低了视频容量。为了提高视频的生成质量,stable video diffusion [2] 提出了一种多阶段训练策略,该策略采用图像和低分辨率视频预训练来加速模型收敛并提高生成质量。GenAD [38] 在 UNet 中引入了因果掩码(the causal mask)模块,以预测时间因果关系之后的似是而非的未来。VDT [24] 和 Sora [4] 用 a spatial-temporal(时空) transformer structure. 取代了传统的 UNet。Transformer 强大的放大能力使模型能够更好地拟合数据并生成更合理的视频。

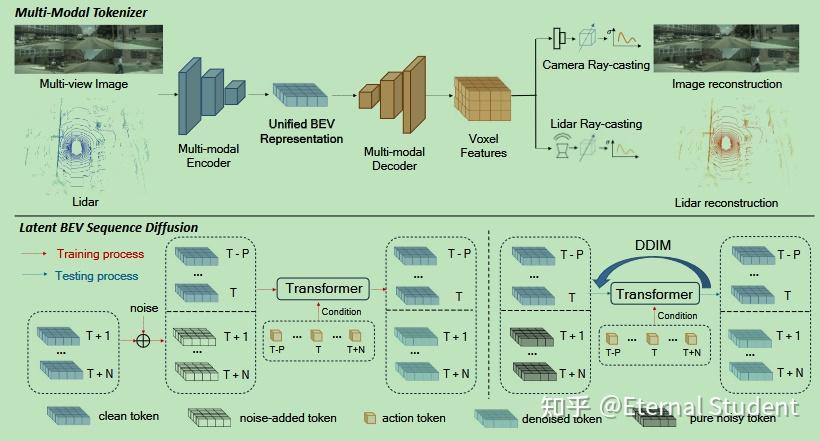

图 1:我们的方法 BEVWorld 概述。BEVWorld 由(multi-modal tokenizer,多模态标记器)和(the latent BEV sequence diffusion model,潜在 BEV 序列扩散模型)组成。The tokenizer 首先将图像和激光雷达观测值编码为 BEV 标记,然后通过 NeRF 渲染策略将统一的 BEV 标记解码为重建的观测值。Latent BEV sequence diffusion model 通过 (Spatial-Temporal Transformer, 时空转换器) 预测具有相应动作条件的未来 BEV tokens。多帧未来 BEV tokens 通过单次推理得到,避免了 auto-regressive 方法的累积误差。

3 Method

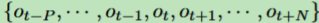

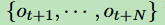

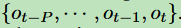

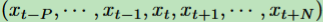

在本节中,我们描绘了 BEVWorld 的模型结构。overall architecture 如图 1 所示。给定一系列 multi-view image 和激光雷达观测值

, 其中 Ot 是当前观测值,+/− 代表未来 / 过去的观测值,P/N 是过去 / 未来观测值的数量,我们的目标是预测

with the condition

. 针对在原始观测空间中学习 orld model 计算成本高昂的问题,该文提出一种多模态标记器,将多视角图像和激光雷达信息逐帧压缩到一个统一的 BEV 空间中。(The encoder-decoder structure and the self-supervised reconstruction loss, 编码器 - 解码器结构和自监督重构损失) 保证了 BEV 表示中能够很好地存储正确的几何和语义信息。这种设计恰好为 world model 和其他 (other downstream tasks, 下游任务) 提供了足够简洁的表示。我们的世界模型被设计为一个基于扩散的网络,以避免错误以 auto-regressive 方式积累的问题。它需要 (ego motion, 自我运动) and

, i.e. the BEV representation of

, as condition to learn the noise

added to

在 training process 中。在测试过程中,应用 DDIM [32] 调度器从纯噪声中恢复未来的 BEV token。接下来,我们使用 multi-modal tokenizer 的解码器来渲染未来的多视图图像和激光雷达帧。

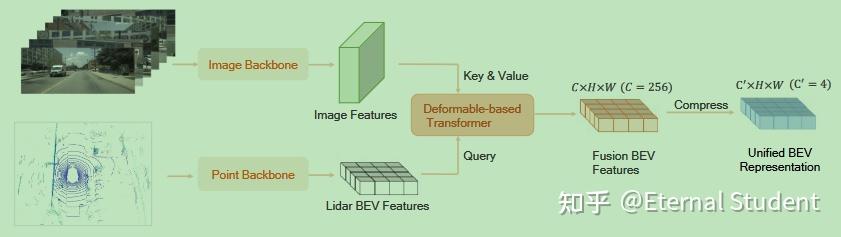

图 2:BEV 编码器的详细结构。编码器将多视图多模态传感器数据作为输入。使用可变形的注意力融合多模态信息,将 BEV 特征进行通道压缩以与扩散模型兼容。

3.1 Multi-Modal Tokenizer

我们设计的多模态分词器包含三个部分:BEV 编码器网络、BEV 解码器网络和多模态渲染 (multi-modal rendering) 网络。BEV 编码器网络的结构如图 2 所示。为了使多模态网络尽可能均匀,我们采用 Swin-Transformer [22] 网络作为图像骨干来提取多图像特征。对于激光雷达特征提取,我们首先在 BEV 空间上将 point cloud 分割成 pillars [19]。然后,我们以 SwinTransformer 网络作为激光雷达骨干网,提取激光雷达 BEV 特征。我们将激光雷达 BEV 特征和 multi-view images features 与基于 deformable-based transformer [46] 融合在一起。具体来说,我们在 pillars 的高度维度中对 K(K = 4)点进行采样,并将这些点投影到图像上,以对相应的图像特征进行采样。In the deformable attention calculation,采样的图像特征被视为 values,而激光雷达 BEV 特征则作为 queries 提供。考虑到未来的预测任务需要低维输入,我们进一步将融合的 BEV 特征压缩为低维(C′ = 4)的 BEV 特征。

对于 BEV decoder,由于融合的 BEV 特征缺少 height information,因此在直接使用解码器恢复图像和激光雷达时存在歧义问题。为了解决这个问题,我们首先通过上采样和 swin-blocks 的堆叠层将 BEV tokens 转换为 3D (voxel features, 体素特征)。然后,我们使用基于 (voxelized, 体素化) 的 NeRF 的光线渲染来恢复多视图图像和激光雷达点云。多模态渲染网络可以优雅地划分为两个不同的组成部分,图像重建网络和激光雷达重建网络。对于图像重建网络,我们首先得到光线 r(t)=o+ td,它从相机中心 o 向 d 方向向像素中心射击。然后,我们沿着光线对一组点进行均匀采样

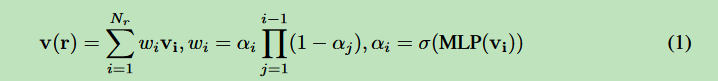

,其中 Nr(Nr = 150) 是沿射线采样的点总数。给定一个采样点(xi、yi、zi),根据体素特征的位置,从体素特征中得到相应的特征 vi。然后,将射线中的所有采样特征聚合为像素级特征描述符(式 1)。

我们遍历所有像素并得到图像的 2D 特征图

。2D 特征通过 CNN 解码器转换为 RGB 图像

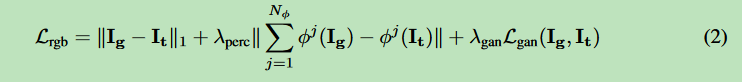

。为了提高生成图像的质量,增加了三种常见的损失,即感知损失 [14]、GAN 损失 [8] 和 L1 损失。我们图像重建的全部目标是:

其中 It 是 Ig 的真值,φj 表示预训练 VGG [31]模型的第 j 层,Lgan(Ig, It)的定义可以在 [8] 中找到。

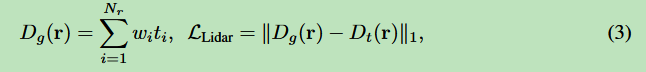

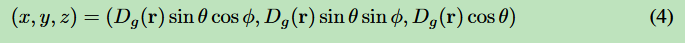

对于激光雷达重建网络,光线是在球面坐标系中定义的,倾角为θ,方位角为φ,θ和φ是通过从激光雷达中心向激光雷达点的当前帧进行射击得到的。我们以与图像重建相同的方式对点进行采样并获得相应的特征。由于激光雷达对深度信息进行编码,因此计算采样点的预期深度 Dg(r) 以进行激光雷达仿真。深度模拟过程和损失函数如式 3 所示。

其中,ti 表示从激光雷达中心开始的采样点的深度,Dt(r)是激光雷达观测计算出的深度地面实况。点云的笛卡尔坐标可以通过以下方式计算:

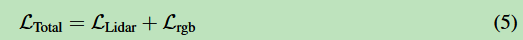

总体而言,multi-modal tokenizer 是端到端训练的,总损失在方程 5 中:

3.2 Latent BEV Sequence Diffusion

现有的 world models [42, 12] 大多采用 autoregression 策略来获得更长的未来预测,但该方法容易受到累积误差的影响。相反,我们提出了 latent sequence diffusion 框架,该框架输入多帧噪声 BEV tokens,并同时获取所有未来的 BEV tokens。

潜序列扩散的结构如图 1 所示。在训练过程中,首先从传感器数据中获取低维 BEV tokens

。该过程仅涉及多模态 tokenizer 中的 BEV 编码器,多模态 tokenizer 的参数被冻结。为了便于 world models 模块学习 BEV tokens 特征,我们沿通道维度

。最新历史 BEV tokens 和当前框架 BEV tokens

用作条件标记,而

扩散到噪声较大的 BEV 标记

噪声为

,其中 KaTeX parse error: Undefined control sequence: \wedget at position 1: \̲w̲e̲d̲g̲e̲t̲\wedget

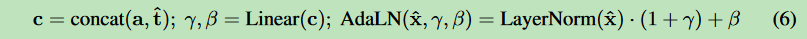

是扩散过程的时间戳。去噪过程是通过一个时空转换器执行的,该转换器包含一系列变压器模块,其架构如图 4 所示。时空转换器的输入是 condition BEV tokens 和 noisy BEV tokens

的串联。这些 tokens 与车辆运动和转向的动作 tokens

进行调制,它们共同构成了时空转换器的输入。更具体地说,输入 tokens 首先传递给时间注意力块,以增强时间流畅性。为了避免时间混淆问题,我们在时间注意力中加入了因果掩码。然后,将时间注意力块的输出发送到空间注意力块以获得准确的详细信息。空间注意力块的设计遵循标准的变压器块准则 [24]。动作 tokens 和扩散时间戳

作为扩散模型的条件

连接起来,然后发送到 AdaLN [28] (6)来 modulate token 特征。

其中

是一个变压器块的输入特性,γ,β 是 C 的刻度和位移。

时空变压器的输出为噪声预测

,损耗如式 7 所示。

在测试过程中,归一化历史帧和当前帧 BEV tokens

和 pure noisy tokens

作为输入串联到 world model 中。ego motion tokens

,从时刻 T−P 到 T+N ,作为条件输入。我们采用 DDIM [32] 时间表来预测后续的 BEV tokens。随后,将非规范化运算应用于预测的 BEV tokens,然后将其输入到 BEV 解码器和渲染网络中,从而产生一组全面的预测多传感器数据。

4 Experiments

4.1Dataset

NuScenes :[5] NuScenes 是一个广泛使用的自动驾驶数据集,它包含多模态数据,例如来自 6 个摄像头的多视图图像和激光雷达扫描。它总共包括 700 个 training videos 和 150 个 validation videos。每个视频包括 20 秒,帧速率为 12Hz。

Carla [7] : 训练数据是在开源的 CARLA 模拟器中以 2Hz 收集的,包括 8 个城镇和 14 种天气。我们用四个摄像头(1600 × 900)和一个激光雷达(32p)收集 3M 帧进行训练,并在 Carla Town05 基准上进行评估,该基准测试与 [30] 的设置相同。

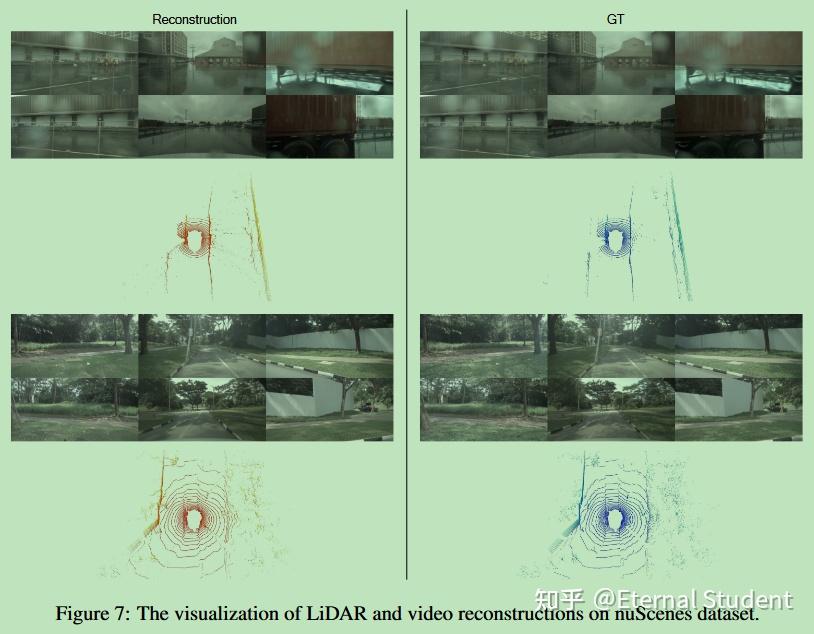

4.2 Multi-modal Tokenizer

在本节中,我们探讨了不同设计决策对所提出的 multi-modal tokenizer 的影响,并展示了其在下游任务中的有效性。多模态重建可视化结果请参考图 7 和图 8。

4.2.1 Ablation Studies

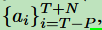

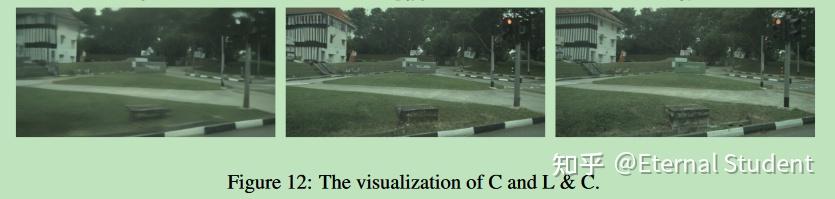

各种输入模式和输出模式。所提出的 multi-modal tokenizer 支持各种输入和输出模态的选择。我们测试了不同模态的影响,结果如表 1 所示,其中 L 表示激光雷达模态,C 表示多视角相机模态,L&C 表示多模态模态。激光雷达和摄像头的结合实现了最佳的重建性能,这表明使用多模态可以产生更好的 BEV 特征。我们发现,在比较 ground truth images 和预测图像时,PSNR 指标有些失真。这是由 PSNR 指标的平均特性引起的,该指标不能很好地评估锐化和模糊(sharpening and blurring)。如图 12 所示,尽管多模态的 PSNR 略低于单摄像头模态方法,但正如 FID 指标所示,多模态的可视化效果优于单摄像头模态

渲染方法。要将 BEV 特征转换为多个传感器数据,主要挑战在于不同传感器的位置和方向不同,以及成像(点和像素)的差异。我们比较了两种类型的渲染方法:

a)基于注意力的方法,通过全局注意力机制将几何投影隐式编码到模型参数中;

b) 基于射线的采样方法,明确利用传感器的姿态信息和成像几何形状。

方法(a)和(b)的结果如表 2 所示。方法(a)在多视图重建中人脸性能明显下降,表明我们的基于射线的采样方法降低了视图转换的难度,使得实现训练收敛变得更容易。因此,我们采用基于射线的采样方法来生成多个传感器数据。

4.2.2 Benefit for Downstream Tasks

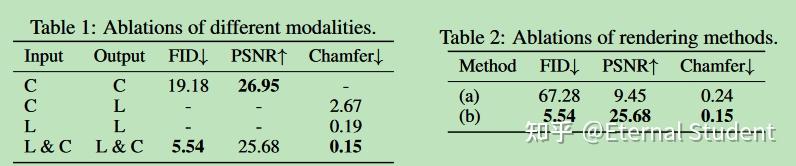

3D Detection。为了验证我们提出的方法在预训练阶段使用时对下游任务是否有效,我们在 nuScenes 3D 检测基准上进行了实验。对于模型结构,为了最大限度地实现我们的多模态 tokenizer 结构的复用,下游 3D 检测任务中的编码器与 3 中描述的标记器的编码器保持一致。我们使用连接到标记器编码器的 BEV 编码器来进一步提取 BEV 特征。我们设计了一个 UNet 风格的网络,其中 Swin transformer [22] 层作为 BEV 编码器。在检测头方面,我们采用 query-based head [21],它包含 500 个 object queries,搜索整个 BEV 特征空间,并使用匈牙利算法匹配预测框和真值框。我们报告单帧和两帧结果。我们将历史 0.5s BEV 未来到当前帧在两帧设置中,以获得更好的速度估计。请注意,我们不会专门针对检测任务进行微调,所有这些都是为了保持设置的简单性和清晰度。例如,在 nuScenes 数据集中,常规检测范围为 [-60.0m, -60.0m, -5.0m, 60.0m, 60.0m, 3.0m],而在多模态重建任务中,常规检测范围为 [-80.0m, -80.0m, -4.5m, 80.0m, 80.0m, 4.5m],这将导致 BEV 网格更粗糙,精度更低。同时,我们的实验设计避免了数据增强技术的使用和点云帧的分层。我们在 8 个 A100 GPU 上训练 30 个 epoch,起始学习率为 5e−4,随着余弦退火策略的改变而衰减。我们主要关注从头开始训练和使用我们提出的自监督标记器作为预训练模型之间的相对性能差距。如表 3 所示,很明显,使用我们的多模态标记器作为预训练模型,在单帧和多帧场景中都能显著提高性能。具体来说,通过两帧配置,我们在 NDS 指标上实现了令人印象深刻的 8.4% 的改进,在 mAP 指标上实现了 13.4% 的大幅改进,这归因于我们的多模态 tokenizer 预训练方法。

Motion Prediction.。我们进一步验证了使用我们的方法作为预训练模型在运动预测任务上的性能。我们将运动预测头连接到 3D 检测头上。运动预测头由 6 层交叉注意力(CA)和前馈网络(FFN)堆叠而成。对于第一层,the trajectory queries 是从 3D 检测头中选择的前 200 个得分最高的对象查询中初始化的。然后,对于每一层,the trajectory queries 首先与 CA 中的时态 BEV 未来交互,并由 FFN 进一步更新。我们在 3D 探测头中重复使用匈牙利匹配结果,将预测和轨迹 ground truth 配对。我们预测了五种可能的轨迹模式,并选择最接近 ground truth 的一种进行评估。对于训练策略,我们在 8 个 A100 GPU 上训练 24 个 epoches,起始学习率为 1e−4。其他设置与检测配置相同。我们在表 3 中显示了运动预测结果。我们观察到,在预训练阶段使用 tokenizer 时,在两帧设置下,minADE 减少了 0.455 米,minFDE 减少了 0.749 米。这一发现证实了自监督多模态 tokenizer 预训练的有效性。

4.3 Latent BEV Sequence Diffusion

在本节中,我们将介绍 latent BEV Sequence diffusion 的训练细节,并将该方法与其他相关方法进行比较。

4.3.1 Training Details.

NuScenes。我们采用三阶段训练来预测未来的 BEV。

1)Next BEV pretraining.。该模型使用 {xt−1,xt} 条件预测下一帧。在实践中,我们采用 nuScenes 的扫描数据来降低时间特征学习的难度。该模型训练了 20000 个迭代器,批量大小为 128。

2)短序列训练。该模型预测 N (N = 5) 个扫描数据的未来帧。在这个阶段,网络可以学习如何执行短期(0.5s)特征推理。该模型训练了 20000 个迭代器,批量大小为 128。3)长序列微调。该模型使用 {xt−2, xt−1, xt} 条件预测关键帧数据的 N (N = 6) 未来帧 (3s)。该模型训练了 30000 个迭代器,批处理大小为 128。三个阶段的学习率为 5e-4,优化器为 AdamW [23]。请注意,我们的方法在训练过程中没有引入无分类器指导 (CFG) 策略,以便更好地与下游任务集成,因为 CFG 需要额外的网络推理,这会使计算成本翻倍。

Carla.。该模型使用批处理大小为 32 的 nuScenes 预训练模型对 30000 次迭代进行了微调。初始学习率为 5e-4,优化器为 AdamW [23]。在训练过程中不会引入 CFG 策略,遵循相同的 nuScenes 设置。

4.3.2 Lidar Prediction Quality

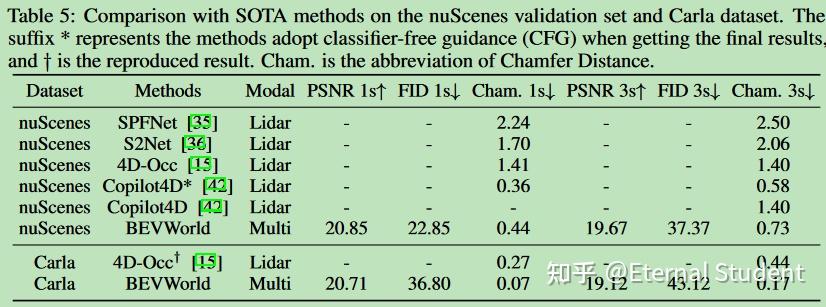

NuScenes。我们将激光雷达的预测质量与现有的 SOTA 方法进行了比较。我们遵循 [42] 的评估过程,并在表 5 中报告了倒角 1s/3s 结果,其中度量是在感兴趣区域内计算的:x 轴和 y 轴为 -70m 至 +70m,z 轴为 -4.5m 至 +4.5m。我们提出的方法在倒角度量上大大优于 SPFNet、S2Net 和 4D-Occ。与 Copilot4D[42] 相比,考虑到多模态输入的大内存成本,我们的方法使用较少的历史条件帧,并且没有 CFG 计划设置。我们的 BEVWorld 只需要 3 个过去的帧来进行 3 秒的预测,而 Copilot4D 在相同的持续时间内使用 6 帧。我们的方法表现出卓越的性能,在无 CFG 计划设置下,倒角距离为 0.73,而倒角距离为 1.40,确保了公平和可比的评估。

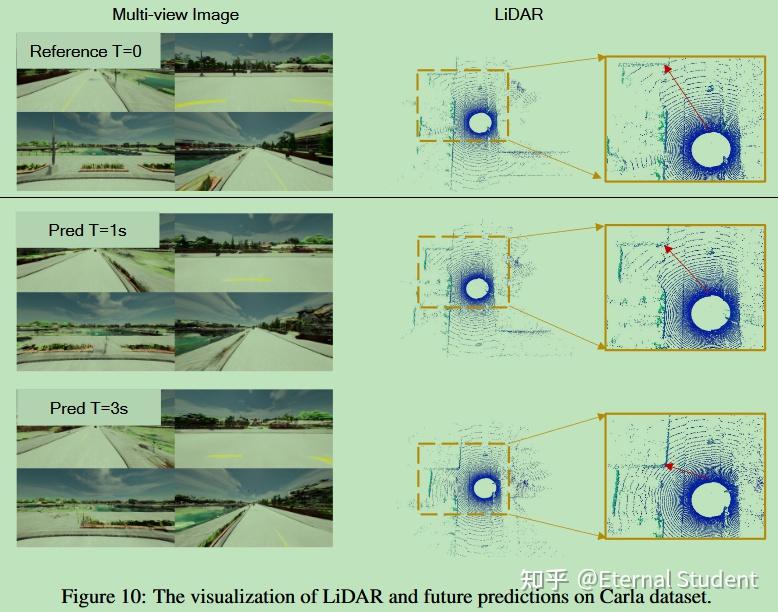

Carla。我们还在 Carla 数据集上进行了实验,以验证我们方法的可扩展性。定量结果如表 5 所示。我们在 Carla 上重现了 4D-Occ 的结果,并将其与我们的方法进行了比较,在 nuScenes 数据集上得到了与此类似的结论。我们的方法在 1 秒和 3 秒的预测结果上都明显优于 4D-Occ。

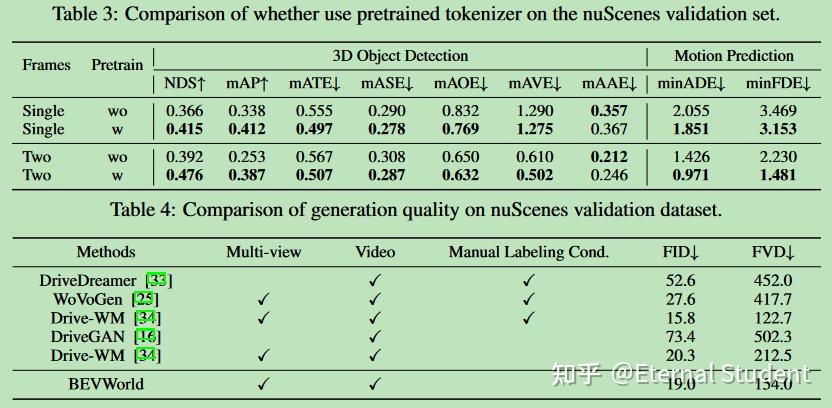

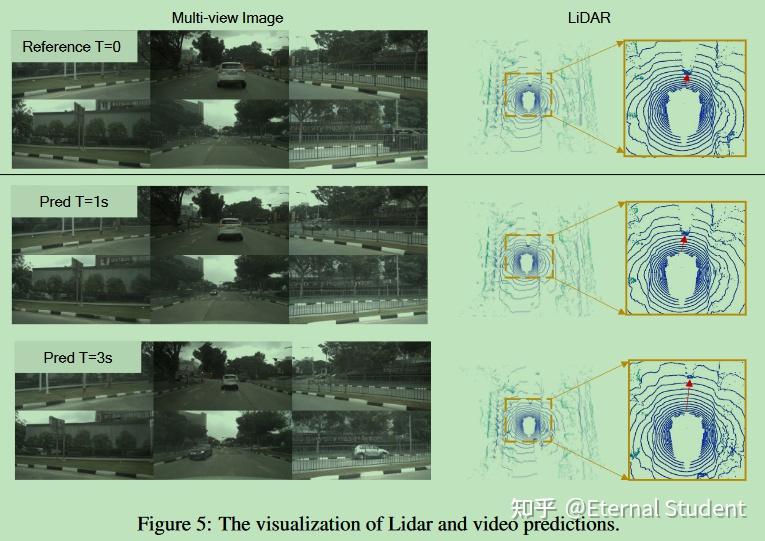

4.3.3 Video Generation Quality

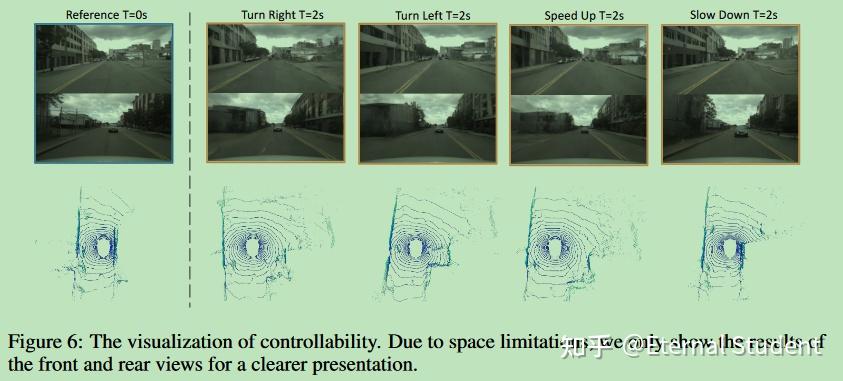

NuScenes。我们将视频生成质量与过去的单视图和多视图生成方法进行了比较。现有的方法大多采用手动标记条件,如布局或对象标记,以提高生成质量。但是,使用注释会降低世界模型的可扩展性,从而难以使用大量未标记的数据进行训练。因此,我们不使用手动注释作为模型条件。结果如表 4 所示。所提方法在不使用手动标记条件的方法中取得了最佳的 FID 和 FVD 性能,并且与使用额外条件的方法具有相当的结果。激光雷达和视频预测的视觉结果如图 5 所示。此外,发电量可以通过动作条件来控制。我们将动作令牌转换为左转、右转、加速和减速,生成的图像和激光雷达可以根据这些指令生成。可控性的可视化如图 6 所示。

Carla。Carla 的生成质量与 nuScenes 数据集的生成质量相似,证明了我们的方法在不同数据集上的可扩展性。视频预测的定量结果如表 4 所示,分别为 36.80(FID 1s)和 43.12(FID 3s)。视频预测的定性结果显示在附录中。

4.3.4 Benefit for Planning Tasks

在 nuScenes 数据集上,我们进一步验证了潜在扩散网络预测的未来 BEV 特征在玩具下游开环规划任务 [41] 中的有效性。请注意,我们在这里不在未来的帧中使用自我汽车的动作,我们采用 x0 参数化 [1] 进行快速推理。我们采用四个向量,历史轨迹、命令、感知和可选的未来 BEV 向量,作为规划头的输入。历史轨迹向量编码从最后一帧到当前帧的自我运动。命令向量是指路由命令,例如向左转或向右转动。感知向量是从检测头中的对象查询中提取的,该对象查询与所有检测查询交互。未来的 BEV 向量是从固定扩散模型的池化 BEV 特征中得到的。当使用未来的 BEV 向量时,PNC L2 3s 度量从 1.030m 减少到 0.977m,这验证了来自世界模型的预测 BEV 有利于规划任务。

5 Conclusion

我们提出了 BEVWorld,这是一个创新的自动驾驶框架,它利用统一的鸟瞰潜在空间来构建多模态世界模型。BEVWorld 的自监督学习范式使其能够有效地处理大量未标记的多模态传感器数据,从而对驾驶环境进行全面理解。我们验证了 BEVWorld 在下游自动驾驶任务中的有效性。此外,BEVWorld 在利用潜在扩散网络的多模态未来预测中取得了令人满意的结果,通过在真实世界(nuScenes)和模拟(carla)数据集上的实验展示了其能力。我们希望本文中介绍的工作能够刺激和促进自动驾驶世界模型领域的未来发展。

Appendix

A Qualitative Results

在本节中,给出了定性结果,以证明所提方法的性能。

A.1 Tokenizer Reconstructions

Tokenizer 重建的可视化如图 7 和图 8 所示。所提出的分词器可以恢复具有统一 BEV 特征的图像和激光雷达。

A.2 Multi-modal Future Predictions

Diverse generation.。所提出的基于扩散的世界模型能够在不同的驱动条件下产生高质量的未来预测,并且动态和静态目标都能得到正确的生成。定性结果如图 9 和图 10 所示。

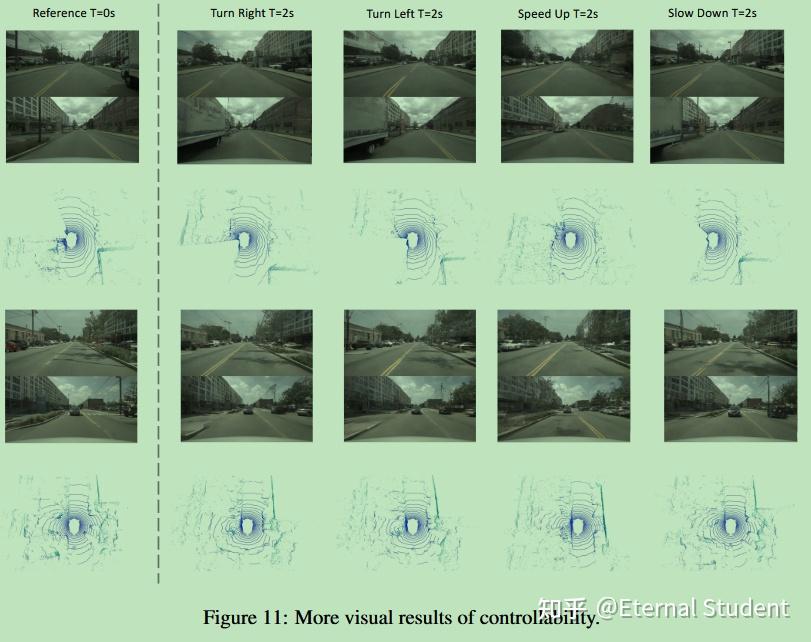

Controllability. 我们在图 11 中展示了更直观的可控性结果。生成的图像和激光雷达与动作表现出高度的一致性,这表明我们的世界模型具有成为模拟器的潜力。

PSNR metric。PSNR 度量存在无法区分模糊和锐化的问题。如图 12 所示,L&C 的图像质量优于 C,而 L&C 的 psnr 度量比 C 差。

B Implementation Details

Training details of tokenizer. 我们使用 32 个 GPU 训练模型,每张卡的批量大小为 1。我们使用 AdamW 优化器,学习率为 5e-4,beta1=0.5,beta2=0.9,遵循余弦学习率衰减策略。多任务损失函数包括 0.1 的感知损失权重、1.0 的激光雷达损失权重和 1.0 的 RGB L1 重建损失权重。对于 GAN 训练,我们采用了热身策略,在 30,000 次迭代后引入 GAN 损失。鉴别器损失权重设置为 1.0,发电机损失权重设置为 0.1。

C Broader Impacts

世界模型的概念在自动驾驶领域具有重要的相关性和多样化的应用。它是一种多功能工具,可用作模拟器、长尾数据生成器以及用于后续任务的预训练模型。我们提出的方法引入了一个多模态 BEV 世界模型框架,旨在与现有自动驾驶模型中固有的多传感器配置无缝对齐。因此,将我们的方法整合到当前的自动驾驶方法中将产生巨大的好处。

D Limitations

人们普遍认为,推断扩散模型通常需要大约 50 个步骤才能获得去噪结果,这一过程的特点是缓慢且计算成本高。令人遗憾的是,我们遇到了类似的挑战。作为探索构建多模态世界模型的先驱,我们的主要关注点在于驾驶场景中的生成质量,并将其置于计算开销之上。认识到效率的重要性,我们认为采用一步扩散是所提方法未来改进的关键方向。关于生成图像的质量,我们注意到图像中的动态物体有时会出现模糊现象。为了解决这个问题并进一步提高它们的清晰度和一致性,未来可能需要专门为动态对象定制的专用模块。

1091

1091

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?