视觉关系检测的多任务组合网络

Multi-task Compositional Network for Visual Relationship Detection

视觉关系检测的多任务组合网络

摘要

-

我们提出了一种新的视觉关系检测子任务,即显著性检测,作为目标检测和谓词检测的补充

-

同时,我们提出了一种新的多任务组合网络(MCN),它可以同时执行目标检测、谓词组合网络检测和显著性检测

1 Introduction

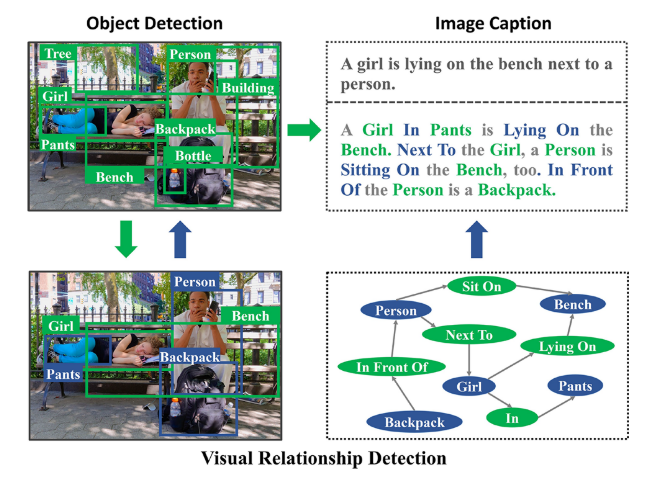

这张图显示了视觉关系检测对其他视觉识别任务的好处。在不丧失一般性的前提下,我们以低级任务目标检测和高级任务图像字幕为例。对于目标检测,视觉关系检测依赖于目标检测,但反过来,目标之间的连接有助于检测的精度。对于图像字幕,视觉关系检测提供了图像中目标之间的详细交互,从而改进了对仅由目标检测生成的图像的描述

2 Related Work

3 The MCN(多任务组合网络)

多任务组合网络(MCN)是一种同时执行目标检测、谓词检测和显著性检测的视觉关系检测方法。

3.1 The Probabilistic Model of MCN

假设s、p和o分别表示一个关系r中的主语、谓词和对象。视觉关系检测中常用的概率模型的数学公式可以写为:

P® = P(p|s, o)P(s|Bs)P(o|Bo). (1)

Bs and Bo主体和对象的两个单独的检测盒;**P(s|Bs) and P(o|Bo)**表示对象框和对象框属于一个对象类别的概率;P(p|s, o) 是object pair(s,o)属于一个谓词类别的概率

一些对象对不包含任何关系,例如建筑和树。有些物体对不是被人类标记的,比如建筑和人。我们将这些对象对称为不太重要的关系( less-significant relationships)。

- 如果有k个检测到的对象,用于谓词检测的对象对的数量将是k(k−1),在等式中(1),隐式解决方案是期望较不显著的关系的P(s|Bs)或P(o|Bo)得分较低。

- 在视觉关系检测中,应该直接考虑识别对象对是否包含重要的关系。我们将这个任务称为显著性检测。

因此,对MCN的概率模型进行了改进如下:

P® = P(c|s, o)P(p|s, o)P(s|Bs)P(o|Bo) (2)

P(c|s, o)表示手动选择一个对象对的显著性概率。通过引入P(c|s, o),MCN通过允许不显著的关系,减轻了不显著关系的负面影响

3.2 The Architecture of MCN

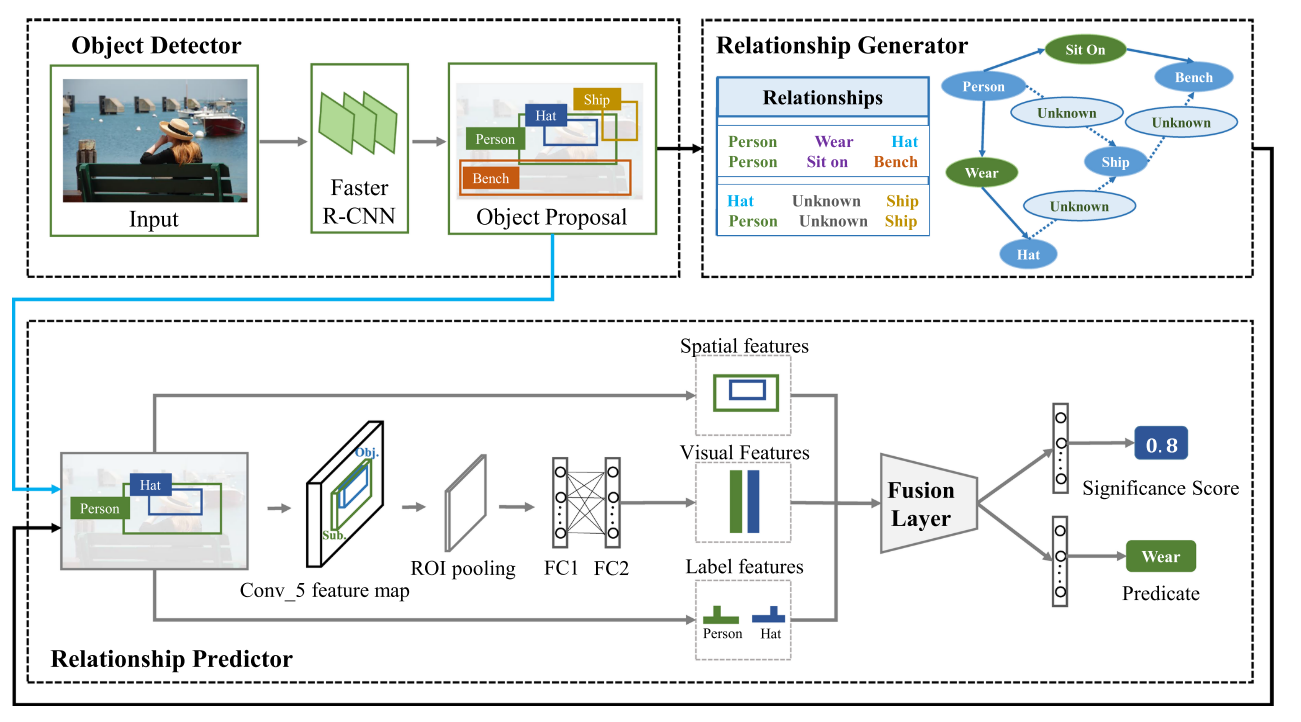

MCN网络由三个相关模块组成:对象检测器、关系发生器和关系预测器。

3.2.1 Object Detector

MCN uses Faster R-CNN with the VGG-16 network as the object detector;MCN可以与任何包含目标分类器的目标检测网络相结合,如Fast R-CNN(Girshick等人2014年)、YOLO(Redmon等人2016年)和SSD(Liu等人2016年)。

3.2.2 Relationship Generator

我们将关系分为两类:确定关系和不确定关系。MCN使用了由Zhan等人(2019年)修订的快速关系生成器,以自动产生有用的确定关系和不确定关系。

请注意,用于训练的对象对是由检测到的对象和人工标记的对象混合生成的。在测试中,对象对仅从检测到的前50个对象中生成。此外,具有错误检测对象的对象对也将被归类为未确定关系。因此,使用确定关系和不确定关系在一定程度上缓解了对象检测器错误检测对象的问题。

3.2.3 Relationship Predictor

- 在关系预测器中,首先从对象对中提取三种特征:视觉特征、空间特征和标签特征。

- 在此基础上,提出了一种新的多模态特征融合策略来融合这些互补特征。

- 最后,建立了两个独立的子网来进行谓词检测和显著性检测。

该网络中的多模态特征融合策略。我们首先从主题和对象中融合相同模式的特征。然后,我们使用MFB对 对象对的视觉、空间和标签特征进行双峰特征融合。最后的多模态特征是三种双模态特征融合特征的组合

3.2.4 Correlated Loss Function

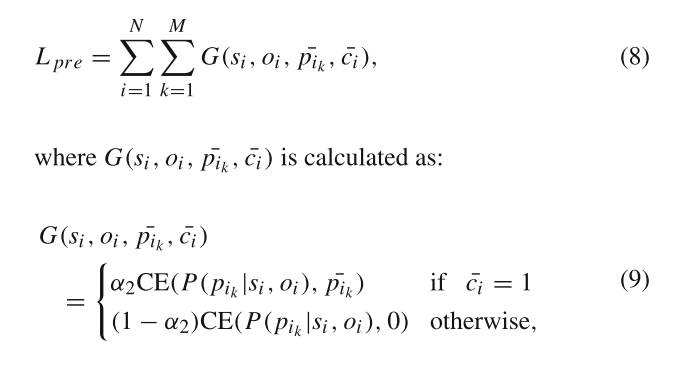

具体标识表示的意思请移步原文查看(原文3.2.4节)

谓词检测损失计算如下:

所选权重的定义如下:

wsel = (P(c|s, o)P(s|Bs)P(o|Bo))1/γ1 (10)

最终的相关损失函数的计算方法为:

Lrela = Lobj + λ(L pre + Lsig) (13)

4 Experiments

4.1 Datasets, Evaluation Tasks, and Performance Metrics

采用了两个常用的视觉关系检测数据集,即视觉关系检测(VRD)数据集(Lu et al. 2016)和视觉基因组(VG)数据集(Krishna et al. 2017)——Visual Relationship Detection (VRD) dataset (Lu et al. 2016) and the Visual Genome (VG) dataset (Krishna et al. 2017).。

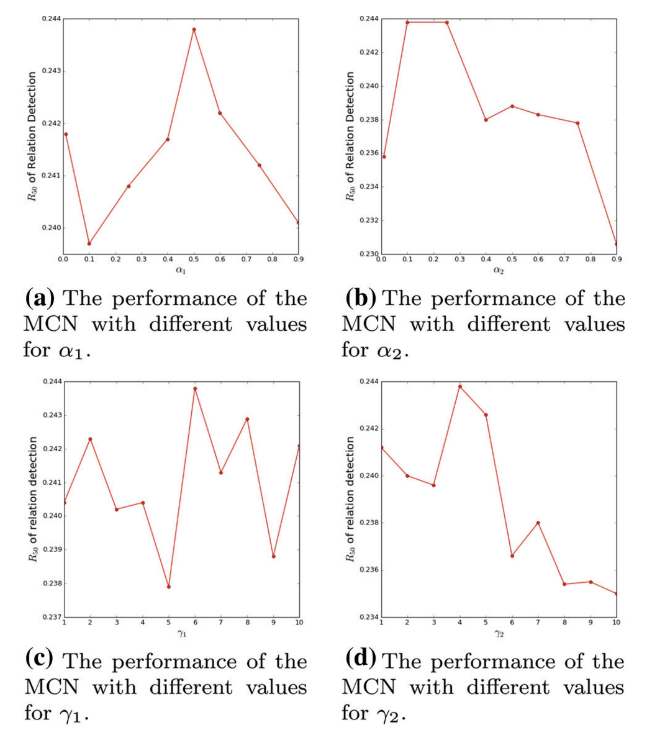

4.4 Ablation Experiments and Parameter Analysis

具有不同参数值的MCN在VRD数据集上的性能

4.4.1 Discussion of Significance Detection

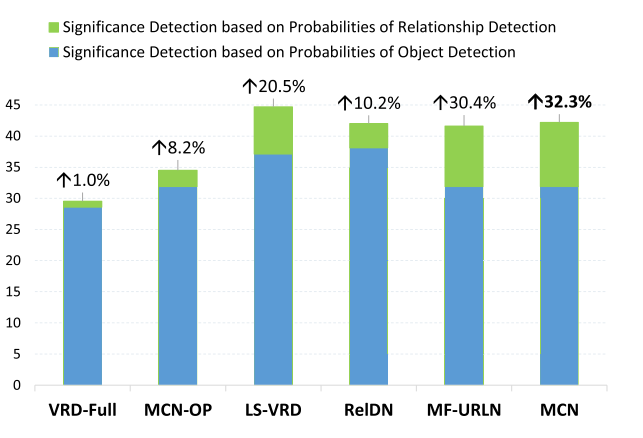

图为不同显著性检测方法之间的比较

上面对应的条形图与基于目标检测概率的显著性检测得分相比,提供了基于关系检测概率的显著性检测的增量。

“MCN-OP”是指仅基于对象检测和谓词检测的视觉关系检测。因此,它被用作基线方法。

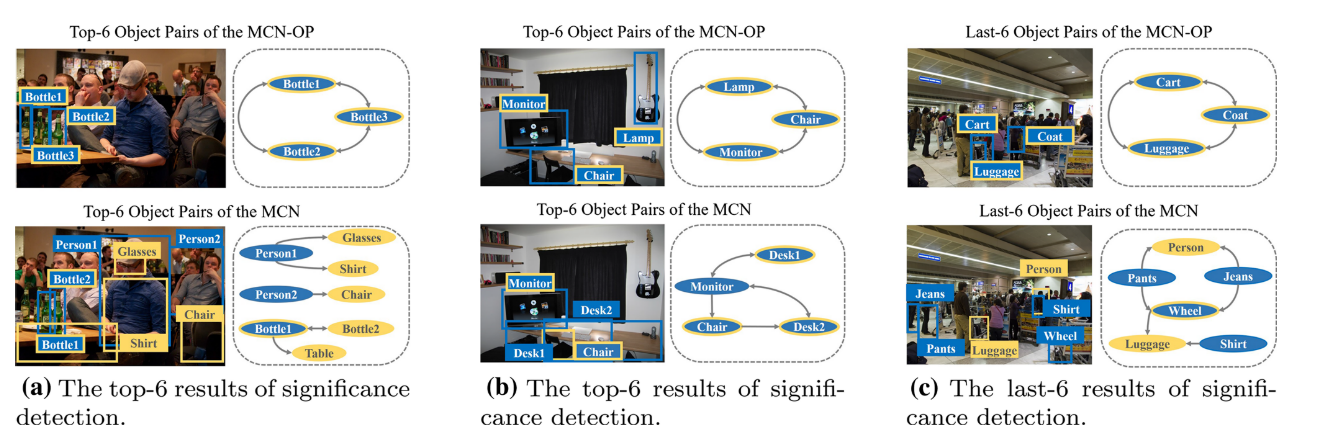

显著性检测的定性比较。我们比较了“MCN-op”和MCN在显著性检测上的前6名和后6名的结果。以三张图像为例。主题和对象被表示为主题→对象

在MCN中,由于显著性检测,错误检测到的“灯”被其他更显著的关系所忽略。这一结果表明,显著性检测可以解决目标检测对象的问题。

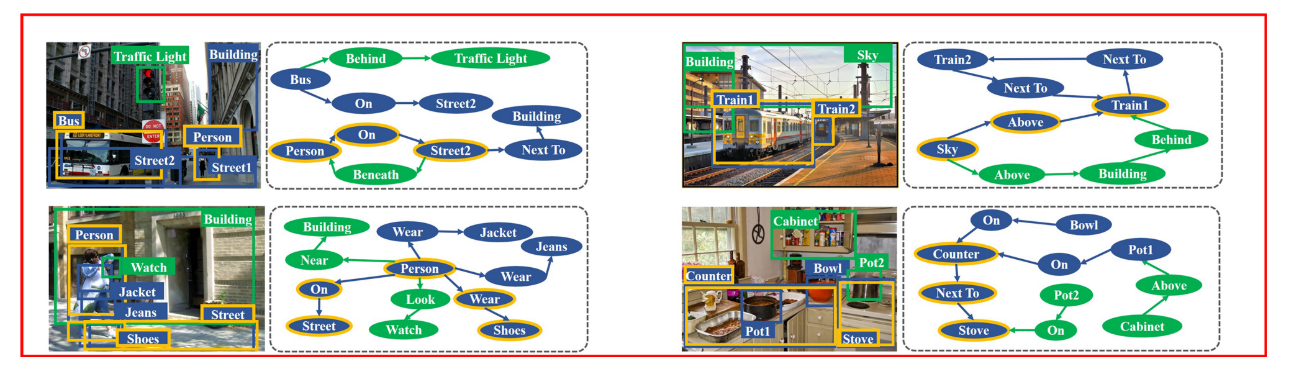

“MCN-op”与MCN之间关系检测的定性比较。我们比较了“MCN-op”和MCN在关系检测上的前50个结果。提供了四幅图像及其基本真实关系。黄色表示由“MCN-OP”检测到的关系。蓝色表示由MCN检测到的关系。绿色表示未被检测到的关系。这些关系被表示为主题→谓词→对象

MFURLN与MCN之间关系检测的定性比较。我们比较了MF-URLN和MCN在关系检测方面的前50个结果。提供了三幅图像及其基本真实关系。黄色表示MF-URLN检测到的关系。蓝色表示由MCN检测到的关系。绿色表示未被检测到的关系。这些关系被表示为主题→谓词→对象(在线颜色图)

MCN的两次故障。这两种例在前50名关系检测结果“MCN-op”中检测到,但在MCN前50名中未检测到

5 Conclusion

在本文中,我们将视觉关系检测视为目标检测、显著性检测和谓词检测这三个相关子任务的组成部分。我们提出了一种新的视觉关系检测网络,即mcn,它深度结合了目标检测、谓词检测和显著性检测。MCN由连接的三个模块组成,一个用来检测对象的对象检测器,一个关系产生器来产生确定关系和不确定关系的关系,以及一个关系预测器来决定显著性得分和预测谓词。

此外,我们还提出了一种新的MCN相关损失函数,以进一步探索生成的关系和高度相关的目标检测、显著性检测和谓词检测。

我们在两个视觉关系检测数据集上验证了MCN:VRD和VG数据集。比较MCN与最先进的方法的实验验证了MCN的竞争力。此外,我们将显著性检测应用到另一种视觉关系检测方法中,得到了很大的改进。MCN的高性能和其他方法的巨大改进说明了显著性检测对视觉关系检测的必要性和实用性。

最后,虽然我们的方法取得了令人满意的性能,但仍有改进的空间。例如,相关性,如一个人和衣服的共存,可以提高检测相关物体的效率。如何将这些对象之间的交互应用于更好地进行视觉关系检测仍然是一项困难但有用的未来工作。

1233

1233

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?