在此声明:本次爬虫数据仅作为学术探讨,不用于商业。如有侵权,联系立删!!!

准备工作

爬虫所需的库和浏览器驱动

- 本次爬虫所需要的库

selenium

#可使用pip命令安装

pip install selenium

csv

re

time

- 安装浏览器驱动

以谷歌浏览器为例,在浏览器地址栏中输入chrome://version/查看浏览器版本

谷歌的驱动:chromedriver.exe

驱动版本与Chrome版本对应的目录:

http://npm.taobao.org/mirrors/chromedriver/2.32/notes.txt

驱动各版本的下载地址:http://npm.taobao.org/mirrors/chromedriver

from selenium import webdriver

bs=webdriver.Chrome('C:\Program Files (x86)\Google\Chrome\Application\chromedriver')

hrome的首字母要大写,chromedriver要放到chrome.exe的目录下,调用时要给出chromedriver的全目录包括文件名‘chromedriver.exe’

网页分析工作

首先进入淘宝首页:https://www.taobao.com/

请认真阅读下面这一段文字:

本次爬虫我们要完成的效果是代码运行后,我们手动输入一个关键词,程序会自动给我们打开谷歌浏览器,在输入框中填写该关键词并按下搜索按钮(这是程序自动帮我们完成的)。我们以“U盘”关键词为例,程序运行后会进入这一页面:

下面请手动扫描二维码(程序不会自动登录),因为总所周知淘宝的登录反爬机制太变态。扫描进入后程序就又会自动工作了:

本次爬虫我们会爬取淘宝某类商品100页的数据,内容包括:

商品名称

商品价格

商品付款人数

商家店名

网页分析

以关键字“U盘”进行搜索为例,打开https://s.taobao.com/search?q=U%E7%9B%98,按下F12或者鼠标右键点击检查,我们可以在源代码中分析得出以下内容:

输入框:

即输入框可以有id =‘q’得到

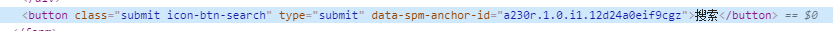

搜索按钮:

搜索按钮可由class属性得到

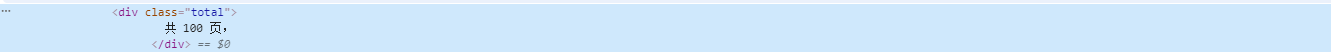

页数:

复制该标签对应的xpath为://*[@id="mainsrp-pager"]/div/div/div/div[1]

商品数据:

翻页操作:

第一页URL:https://s.taobao.com/search?q=U%E7%9B%98

第二页URL:https://s.taobao.com/search?q=U%E7%9B%98&s=44

第三页URL:https://s.taobao.com/search?q=U%E7%9B%98&s=88

可以看出每翻一次页s参数的值加了44

好的,以上就是我们的准备工作

代码实操

import re

import csv

import time

from selenium import webdriver

def search_product(key):

driver.find_element_by_id('q').send_keys(key)

driver.find_element_by_class_name('btn-search').click()

driver.maximize_window()

time.sleep(15)

page = driver.find_elements_by_xpath('//*[@id="mainsrp-pager"]/div/div/div/div[1]').text #页数

page = re.findall('(\d+)',page)[0]

return page

def get_product():

'''解析所需要的数据'''

divs = driver.find_elements_by_xpath('//div[@class="items"]/div[@class="item J_MouserOnverReq "]')

# print(divs)

for div in divs:

info = div.find_element_by_xpath('.//div[@class="row row-2 title"]/a').text #商品名称

price = div.find_element_by_xpath('.//strong').text + '元' #商品价格

deal = div.find_element_by_xpath('.//div[@class="deal-cnt"]').text #商品付款人数

name = div.find_element_by_xpath('.//div[@class="shop"]/a').text #商家店名

print(info,price,deal,name, sep="|")

with open('data.csv',mode='a',newline='') as fp:

csvwriter = csv.writer(fp,delimiter=',')

csvwriter.writerow([info,price,deal,name])

def main():

print('正在爬取第一页数据')

page = search_product(keyword)

get_product()

page_num = 1

while page_num != page:

print('*'*10)

print('正在爬取第{}页数据 '.format(page_num+1))

print('*' * 10)

driver.get('https://s.taobao.com/search?q={}&s={}'.format(keyword,page_num*44))

driver.implicitly_wait(10)

get_product()

page_num += 1

if __name__=='__main__':

keyword = input("请输入你要搜索的关键字:")

driver = webdriver.Chrome()

driver.get('https://www.taobao.com/')

main()

效果展示

待程序执行完成,会在项目目录下生成一个data.csv文件,里面保存了100页的数据

综上就是今天的全部内容,感谢观看,喜欢就点个关注吧!!!❤🧡❤

3501

3501

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?