文章目录

- 1、标签(label)

- 2、 特征(feature)

- 3、样本(example)

- 4、模型(model)

- 5、回归模型(regression model)

- 6、分类模型(classification model)

- 7、训练(training)

- 8、泛化(generalization)

- 9、过拟合(overfitting)

- 10、预测(perdition)

- 11、平稳性(stationarit)

- 12、训练集(training set)

- 13、 验证集(validation set)

- 14、测试集(test set)

- 15、类别(class)

- 16、收敛(convergence)

- 17、准确率(accuracy)

- 18、精确率(precision)

- 19、凸集(convex set)

- 20、凸函数(convex function)

- 21、凸优化(convex optimization)

- 22、激活函数(activation function)

- 23、反向传播算法(backpropagation)

- 24、批次(batch)

- 25、批次大小(batch size)

- 26、偏差(bias)

- 27、推断(inference)

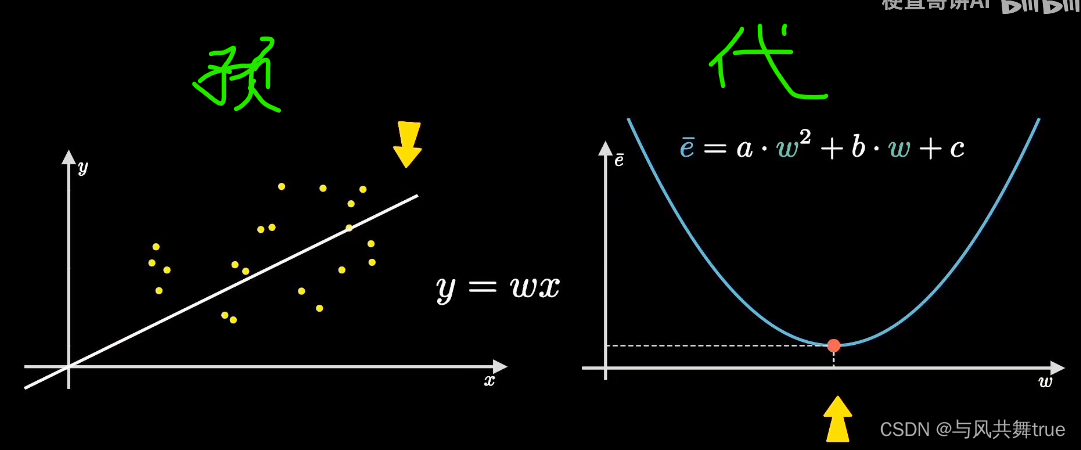

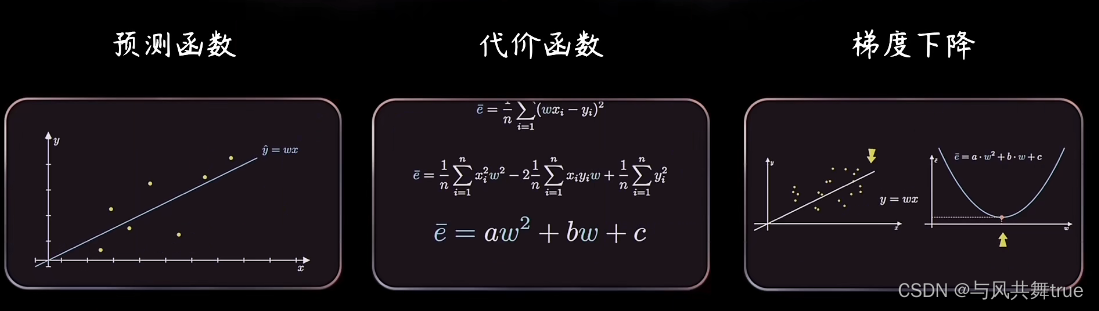

- 28、线性回归(linear regression)

- 29、权重(weight)

- 30、经验风险最小化(ERM,empirical risk minimization)

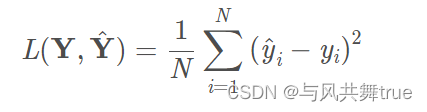

- 31、均方误差(MSE,Mean Squared Error)

- 32、平方损失函数(squared loss)

- 33、损失(Loss)

- 34、梯度下降法(gradient descent)

- 35、随机梯度下降(SGD)

- 36、批量梯度下降法(BGD)

- 37、参数(parameter)

- 38、超参数(hyperparameter)

- 39、学习率(learning rate)

- 40、特征工程(feature engineering)

- 41、离散特征(discrete feature)

- 42、独热编码(one-hot-encoding)

- 43、表示法(representation)

- 44、合成特征(synthetic feature)

- 45、特征组合(feature cross)

- 46、L1正则化(L1 regularization)

- 47、L2正则化(L2 regularization)

- 48、感知机

- 49、多层感知机

- 50、神经网络常用模型结构

- 51、前向传播和反向传播

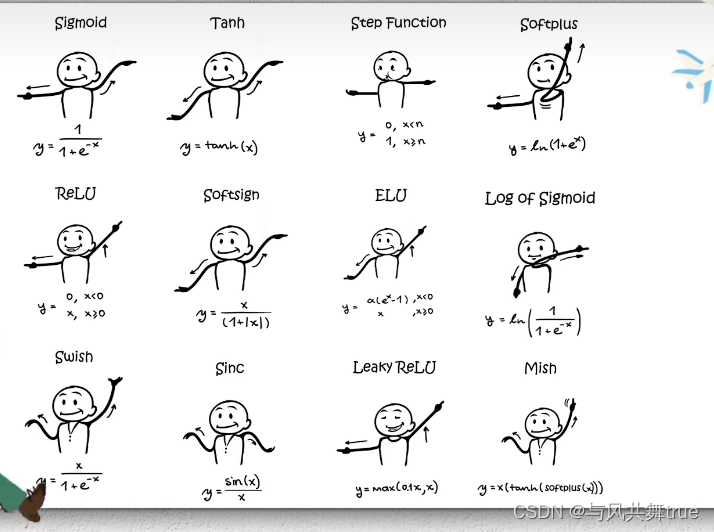

- 52、激活函数

- 53、损失函数

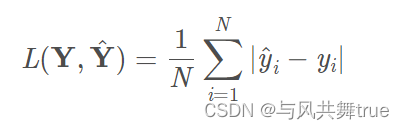

- 54、回归损失函数

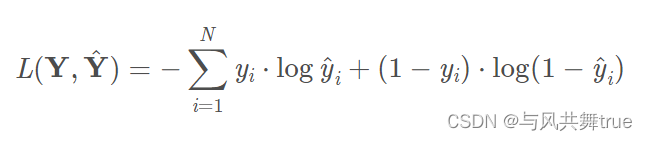

- 55、分类损失函数

- 56、神经网络中常用的损失函数

- 57、激活函数、损失函数、优化函数的区别

- 58、CNN卷积神经网络

- 60、深度学习

1、标签(label)

标签是我们要预测的事物,在分类任务中的类别,比如是猫或狗;

简单线性回归中的y变量;。

标签可以是小麦未来的价格、图片中显示的动物品种、音频剪辑的含义或任何实物。

在监督学习中,标签值是样本的“答案”或“结果”部分。

2、 特征(feature)

在进行预测时使用的输入变量。

特征是输入变量,即简单线性回归中的x变量;在分类任务中的输入图像特征。

简单的机器学习项目可能会使用单个特征,而比较复杂的机器学习项目可能会使用数百万个特征,按如下方式制定:

在垃圾邮箱检测器示例中,特征可能包括:

- 电子邮件文件中的字词

- 发件人的地址

- 发送电子邮件的时段

- 电子邮箱包含“一些敏感词”

3、样本(example)

数据集的一行。

在监督学习的样本中,一个样本既有特征,也有标签。

在无监督学习的样本中,一个样本只有特征。

样本是指数据的特定示例:x。(x表示一个矢量)将样本分为以下两类:

- 有标签样本

- 无标签样本

有标签样本同时包含特征的标签,即:

labeled examples: {features, label}: (x, y)

我们使用有标签样本训练模型;在垃圾邮件检测器示例中,有标签样本是用户明确标记为“垃圾邮件”或“非垃圾邮件”的各个电子邮件。

无标签样本包含特征,但不包含标签,即:

unlabeled examples: {features, ?}: (x, ?)

在使用有标签样本训练模型之后,我们会使用该模型预测无标签样本的标签。在垃圾邮件检测器示例中,无标签样本是用户尚未添加标签的新电子邮件。

4、模型(model)

模型定义了特征与标签之间的关系。

比如,垃圾邮件检测模型可能会将某些特征与“垃圾邮件”紧密联系起来。

模型生命周期的两个阶段:

- 训练是指创建或学习模型。即:向模型展示有标签样本,让模型逐渐学习特征与标签之间的关系。

- 推断是指将训练后的模型应用于无标签样本。即:使用经过训练的模型做出有用的预测.在推断期间,可以针对新的无标签样本预测。

5、回归模型(regression model)

一种模型,能够输出连续值(通常为浮点值)。

回归模型可预测连续值。

例如,回归模型做出的预测可回答如下问题:

- xxx地方的一栋房产的价值是多少?

- 用户点击此广告的概率是多少?

6、分类模型(classification model)

用于区分两种或多种离散类别。

分类模型可预测离散值。

例如,分类模型做出的预测可回答如下问题:

- 某个指定电子邮件是垃圾邮件还是非垃圾邮件?

- 这是一张狗或是猫的图像?

7、训练(training)

构成模型中理想参数的过程;训练一个好的模型,主要是得到模型中的参数,包括权重w和偏置b等。

8、泛化(generalization)

是指模型依据训练时采用的模型,针对未见过的新数据做出争取预测的能力。

9、过拟合(overfitting)

创建的模型与训练数据过于匹配,以至于模型无法根据新数据做出正确的预测。

10、预测(perdition)

模型在收到数据样本后的输出。

11、平稳性(stationarit)

数据集中数据的一种属性,表示数据分布在一个或多个维度保持不变。这种维度最常见的是时间,即:表明平稳性的数据不随时间而变化。

12、训练集(training set)

数据集的子集,用于训练模型。与验证集和测试集相对。Classfier直接根据训练集来调整自身获得更好的分类效果

13、 验证集(validation set)

数据集的一个子集,从训练集分离而来,用于调整超参数。与训练集和测试集相对。用于在训练过程中检验模型的状态,收敛情况。验证集通常用于调整超参数,根据几组模型验证集上的表现决定哪组超参数拥有最好的性能。

同时验证集在训练过程中还可以用来监控模型是否发生过拟合

14、测试集(test set)

数据集的子集,用于在模型经过验证集的初步验证后,进行测试模型。与训练集和验证集相对。

测试集用来评价模型泛化能力,即之前模型使用验证集确定了超参数,使用训练集调整了参数,最后使用一个从没有见过的数据集来判断这个模型是否Work。

形象上来说训练集就像是学生的课本,学生 根据课本里的内容来掌握知识,验证集就像是作业,通过作业可以知道 不同学生学习情况、进步的速度快慢,而最终的测试集就像是考试,考的题是平常都没有见过,考察学生举一反三的能力。

15、类别(class)

类别是标签枚举的一组目标值中的一个。比如:在二分类中,标签组一共有两个,分别为猫、狗;其中“猫”是一个类别;“狗”也是一个类别。

16、收敛(convergence)

是指在训练期间达到的一种状态,模型达到稳定状态,即经过一定次数的迭代之后,训练损失和验证损失在每次迭代中的变换都非常小或根本没有变化。

17、准确率(accuracy)

通常用于分类模型,表示分类模型的正确预测所占的比例。在多分类中,定义:

acc是指准确率;n是指正确分类的个数;sum是指总样本数。

比如:一共有100个数据样本,模型正确预测出98个,有2个预测错误了,那么该模型的准确率为:acc = 98 / 100 = 0.98 ,即:98%

18、精确率(precision)

一种分类模型的指标,是指模型正确预测正类别的频率,即:

pre是指精确率;TP(正例)是指实际为正,预测为正;FP(假正例)是指实际为负,预测为正。

精确率针对的是正类别,一共预测了若干个正类别(正例 + 假正例),其中有多少个是预测正确的。

准确率针对的是整体数据,包括正类别、负类别(正例 + 负类 +假正例 + 假负例),在整体数据中有多少是预测正确的。

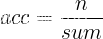

19、凸集(convex set)

欧几里得空间的一个子集,其中任意两点之间的连线仍完成落在该子集内。

比如,椭圆,长方形,正方形等

不是凸集的

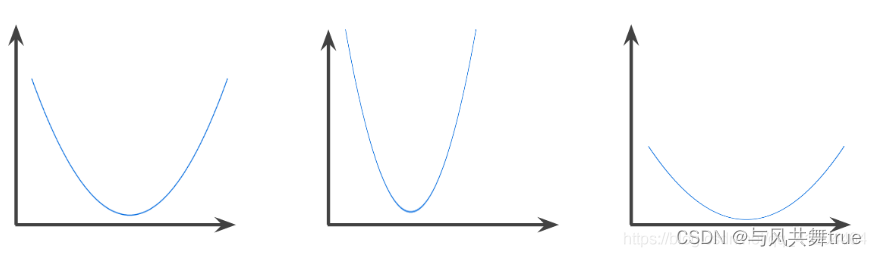

20、凸函数(convex function)

函数图像以上的区域为凸集,典型凸函数的形状类似于字母U,以下是几种凸函数:

相反,以下函数则不是凸函数,请注意图像上方的区域不是凸集:

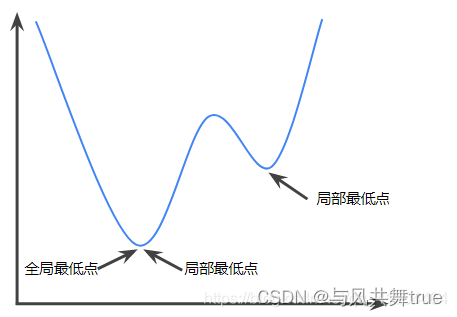

严格凸函数只有一个局部最低点,改点也是全局最低点。

常见的函数都是凸函数:

- L2损失函数

- 对数损失函数

- L1正则化

- L2正则化

梯度下降法的很多变体都一定能找到一个接近严格图函数最小值的点。

随机梯度下降法的很多变体都很高可能(并非一定能找到)接近严格凸函数最小值的点。

两个凸函数的和也是凸函数,比如L2损失函数+L1正则化。

深度模型绝不会是凸函数。但专门针对凸优化设计的算法往往总能在深度网络上找到非常好的解决方案,虽然这些解决方案并不一定对应全局最小值。

21、凸优化(convex optimization)

使用数学方法寻找凸函数最小值的过程。

机器学习方面的大量研究都是专注于如何通过公式将各种问题表示为凸优化问题,以及如何高效解决这些问题。

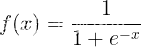

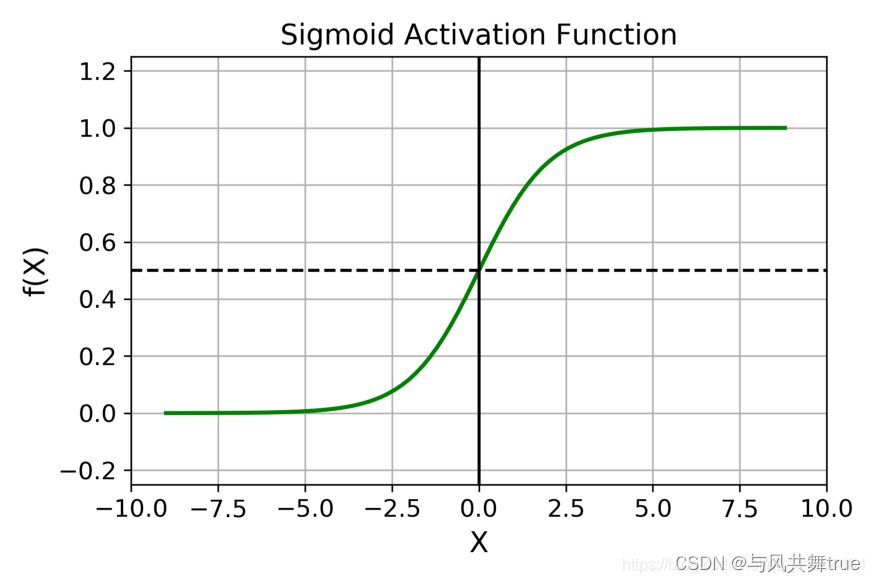

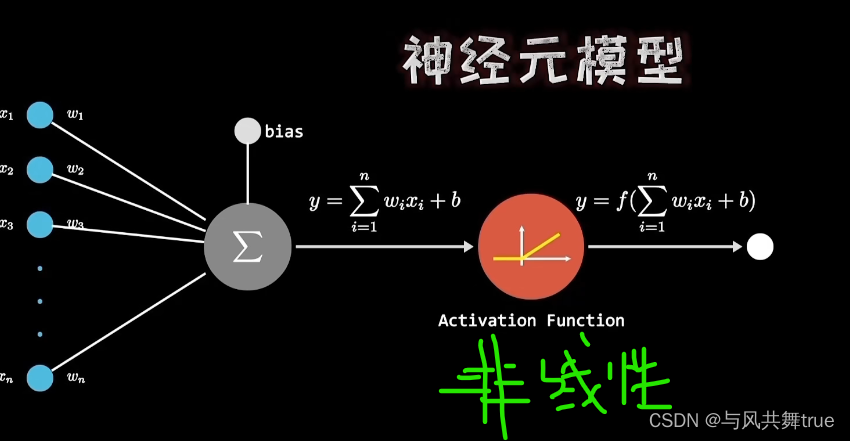

22、激活函数(activation function)

本质是一种函数,通常把输入值映射为另一个值,映射的方式有:线性映射、非线性映射;

比如:在线性映射中,假设激活函数为 y = 2x,输入值x, 映射后的输出值y;当输入值为3,经过激活函数映射后,输出值为6。

在非线性映射中,假设激活函数为

,输入值x, 映射后的输出值y;输入值为0时,经过激活函数映射后,输出值为0.5。

其实这个非线性映射的激活函数是比较常见的Sigmoid函数,看看它的图像:

23、反向传播算法(backpropagation)

该算法会先按前向传播方式计算(并缓存)每个节点的输出值,然后再按反向传播遍历图的方式计算损失函数值相对于每个参数的偏导数。

24、批次(batch)

模型训练的一次迭代(一次梯度更新)中使用的样本集。

25、批次大小(batch size)

一个批次中的样本数。比如,在随机梯度下降SGD算法中,批次大小为1;在梯度下降算法中,批次大小为整个训练集;

批量梯度下降算中,批次大小可以自定义的,通常取值范围是10到1000之间。比如:训练集为40000个样本,设置批次大小为32,训练一次模型,使用到32个样本。

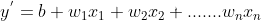

26、偏差(bias)

距离原点的截距或偏移。偏差(也称为偏差项)在机器学习模型中用b或w_{0}表示。例如,在下面的公式中,偏差为b

在这里插入图片描述

27、推断(inference)

在机器学习中,推断通常指以下过程:通过将训练过的模型应用于无标签样本来做出预测

28、线性回归(linear regression)

一种回归模型,通过将输入特征进行线性组合输出连续值。

29、权重(weight)

模型中特征的系数,或深度网络中的边。训练模型的目标是确定每个特征的理想权重。如果权重为0,则相应的特征对模型来说没有任何影响。

30、经验风险最小化(ERM,empirical risk minimization)

用于选择函数,选择基于训练集的损失降至最低的函数。与结构风险最小化相对。

31、均方误差(MSE,Mean Squared Error)

每个样本的平均平方损失。MSE的计算方法是平方损失除以样本数。

32、平方损失函数(squared loss)

在线性回归中使用的损失函数(也称为L2损失函数)。改行可计算模型为有标签样本预测的值,和标签的真实值之差的平方。 由于取平方值,该损失函数会放大不佳预测的影响。与L1损失函数相对,平方损失函数对离群值的反应更强烈。

33、损失(Loss)

一种衡量指标,用于衡量模型的预测偏离其标签程度。要确定此值,模型需要定义损失函数。例如:线性回归模型参与均方误差MAS损失函数,分类模型采用交叉熵损失函数。

34、梯度下降法(gradient descent)

一种通过计算梯度,并且将损失将至最低的技术,它以训练数据为条件,来计算损失相对于模型参数的梯度。梯度下降法以迭代方式调整参数,逐渐找到权重和偏差的最佳组合,从而将损失降至最低。

35、随机梯度下降(SGD)

梯度下降法在大数据集,会出现费时间、价值不高等情况。**如果我们可以通过更少的计算量得出正确的平均梯度,效果更好。**通过从数据集中随机选择样本,来估算出较大的平均值。

原理 它每次迭代只使用一个样本(批量大小为1)。

如果进行足够的迭代,SGD也可以发挥作用,但过程会非常杂乱。“随机”这一术语表示构成各个批量的一个样本都是随机选择的。

36、批量梯度下降法(BGD)

它是介于全批量迭代与随机选择一个迭代的折中方案。全批量迭代(梯度下降法);随机选择一个迭代(随机梯度下降)。

原理 它从数据集随机选取一部分样本,形成小批量样本,进行迭代。小批量通常包含10-1000个随机选择的样本。BGD可以减少SGD中的杂乱样本数量,但仍然波全批量更高效。

37、参数(parameter)

机器学习系统自行训练的模型变量。例如,权重。它们的值是机器学习系统通过连续的训练迭代逐渐学习到的;与超参数相对。

38、超参数(hyperparameter)

在模型训练的连续过程中,需要人工指定和调整的;例如学习率;与参数相对。

超参数是在开始学习过程之前设置值的参数,而不是通过训练得到的参数数据。通常情况下,需要对超参数进行优化,给学习机选择一组最优超参数,以提高学习的性能和效果。

- 定义关于模型的更高层次的概念,如复杂性或学习能力。

- 不能直接从标准模型培训过程中的数据中学习,需要预先定义。

- 可以通过设置不同的值,训练不同的模型和选择更好的测试值来决定

超参数具体来讲比如算法中的学习率(learning rate)、梯度下降法迭代的数量(iterations)、隐藏层数目(hidden layers)、隐藏层单元数目、激活函数( activation function)都需要根据实际情况来设置,这些数字实际上控制了最后的参数和的值,所以它们被称作超参数。

39、学习率(learning rate)

在训练模型时用于梯度下降的一个标量。在每次迭代期间,梯度下降法都会将学习速率与梯度相乘;得出的乘积称为梯度步长。

40、特征工程(feature engineering)

是指确定哪些特征可能在训练模型方面非常有用,然后将日志文件及其他来源的原始数据转换为所需的特征。特征工程有时称为特征提取。

41、离散特征(discrete feature)

一种特征,包含有限个可能值。例如,某个值只能是“动物”、或“蔬菜”的特征,这是都能将类别列举出来的。与连续特征相对。

42、独热编码(one-hot-encoding)

一种稀疏二元向量,其中:

- 一个元素设为1.

- 其他所有元素均设为0 。

独热编码常用语表示拥有 有限个可能值的字符串或标识符。

43、表示法(representation)

将数据映射到实用特征的过程。

44、合成特征(synthetic feature)

一种特征,不在输入特征之列,而是从一个或多个输入特征衍生而来。合成特征包括以下类型:

- 对连续特征进行分桶,以分为多个区间分箱。

- 将一个特征值与其他特征值或本身相差(或相除)。

- 创建一个特征组合。

仅通过标准化或缩放创建的特征不属于合成特征。

45、特征组合(feature cross)

通过将单独的特征进行组合(求笛卡尔积),形成的合成特征。特征组合有助于表达非线性关系。

46、L1正则化(L1 regularization)

一种正则化,根据权重的绝对值的总和,来惩罚权重。在以来稀疏特征的模型中,L1正则化有助于使不相关或几乎不相关的特征的权重正好为0,从而将这些特征从模型中移除。与L2正则化相对。

47、L2正则化(L2 regularization)

一种正则化,根据权重的平方和,来惩罚权重。L2正则化有助于使离群值(具有较大正值或较小负责)权重接近于0,但又不正好为0。在线性模型中,L2正则化始终可以进行泛化。

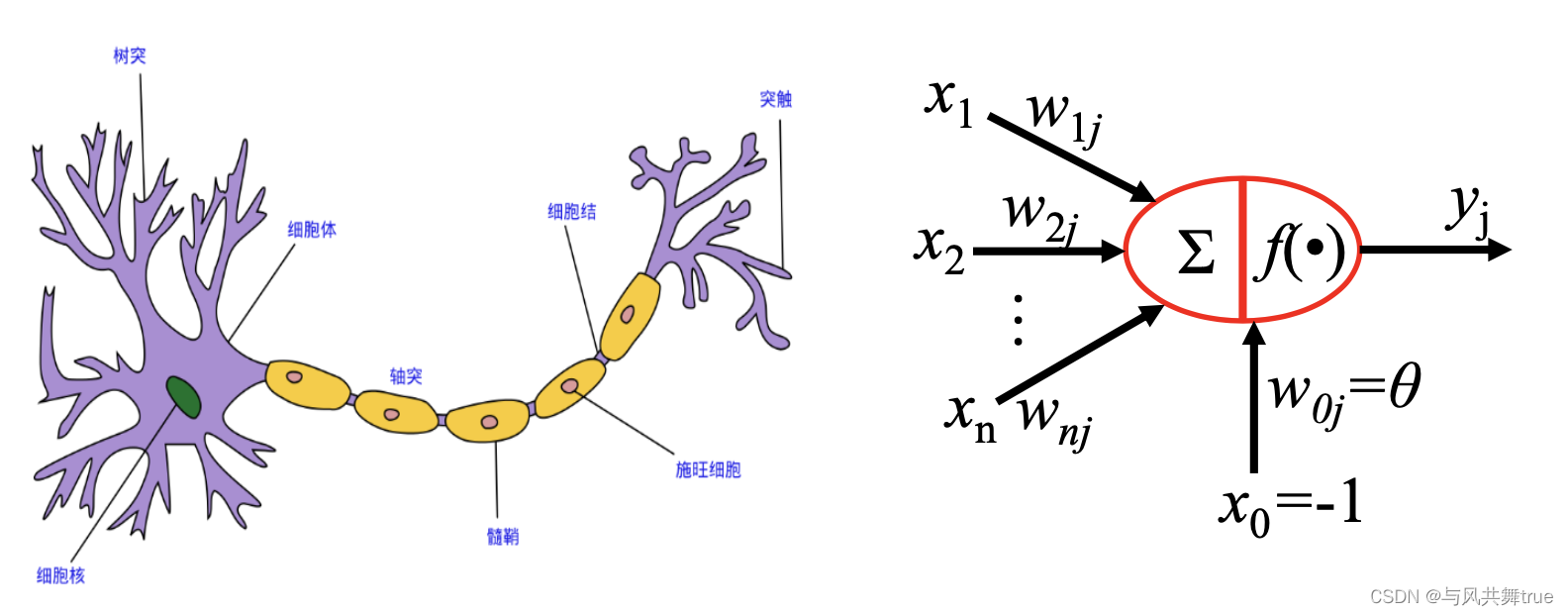

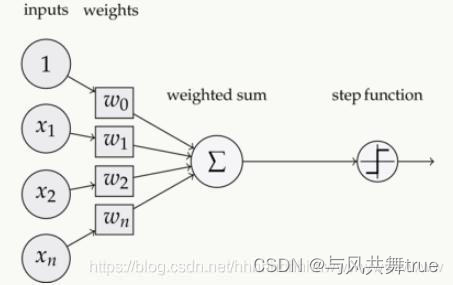

48、感知机

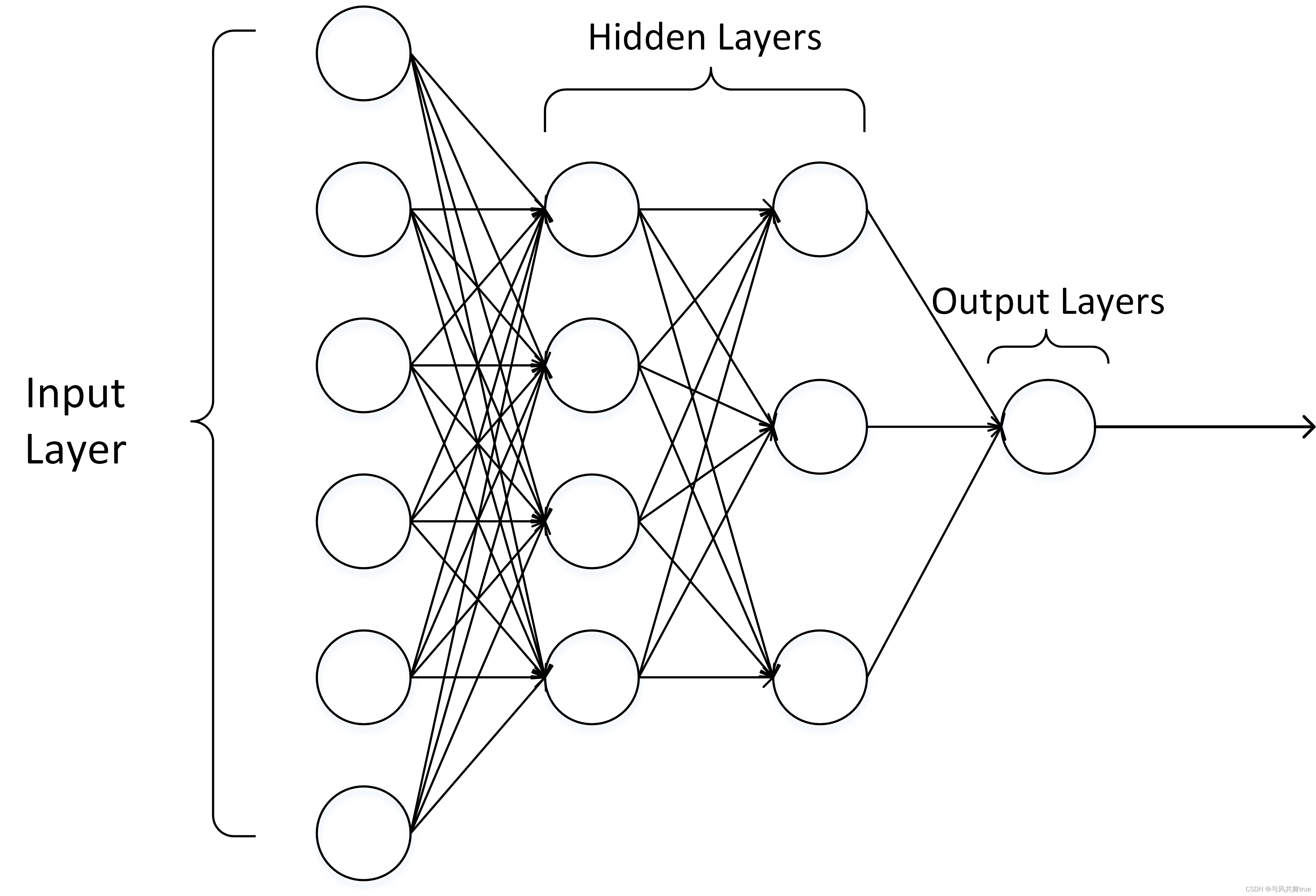

49、多层感知机

多层感知机由感知机推广而来,最主要的特点是有多个神经元层,因此也叫深度神经网络。相比于单独的感知机,多层感知机的第i ii层的每个神经元和第i − 1 i-1i−1层的每个神经元都有连接。

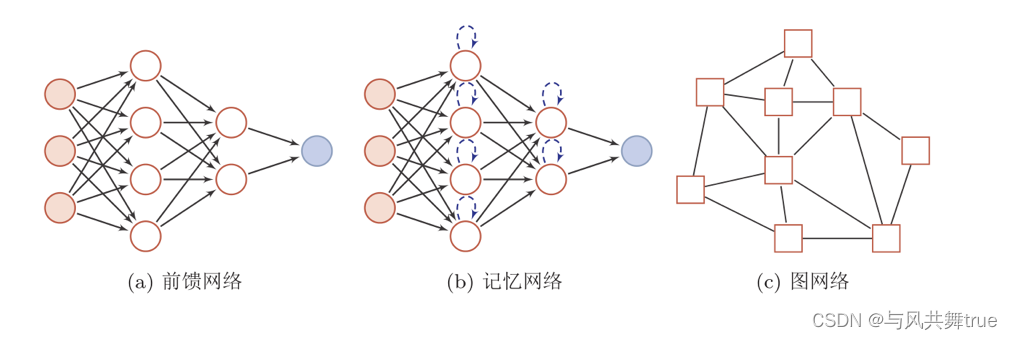

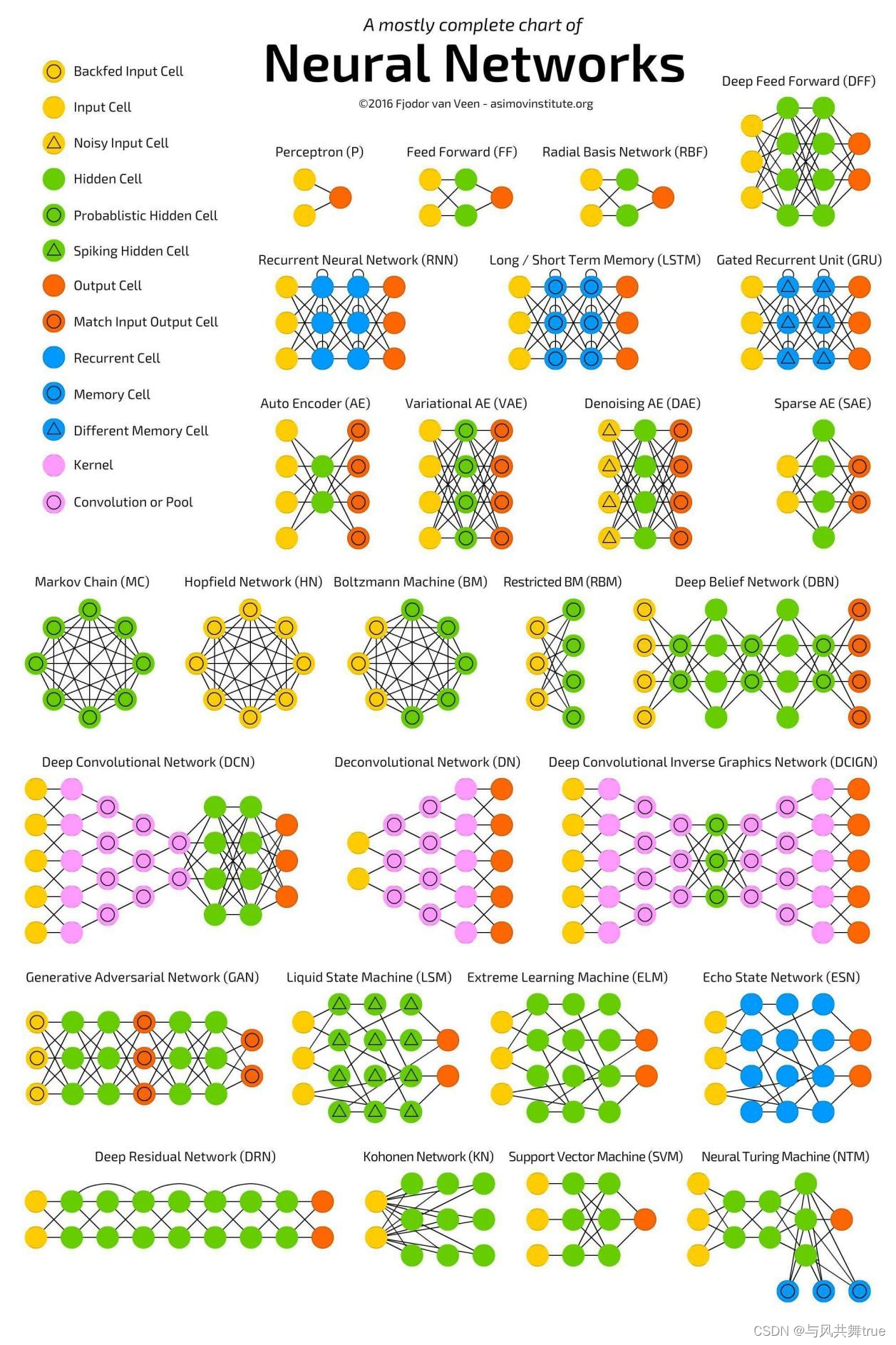

50、神经网络常用模型结构

其中圆形节点表示一个神经元,方形节点表示一组神经元。

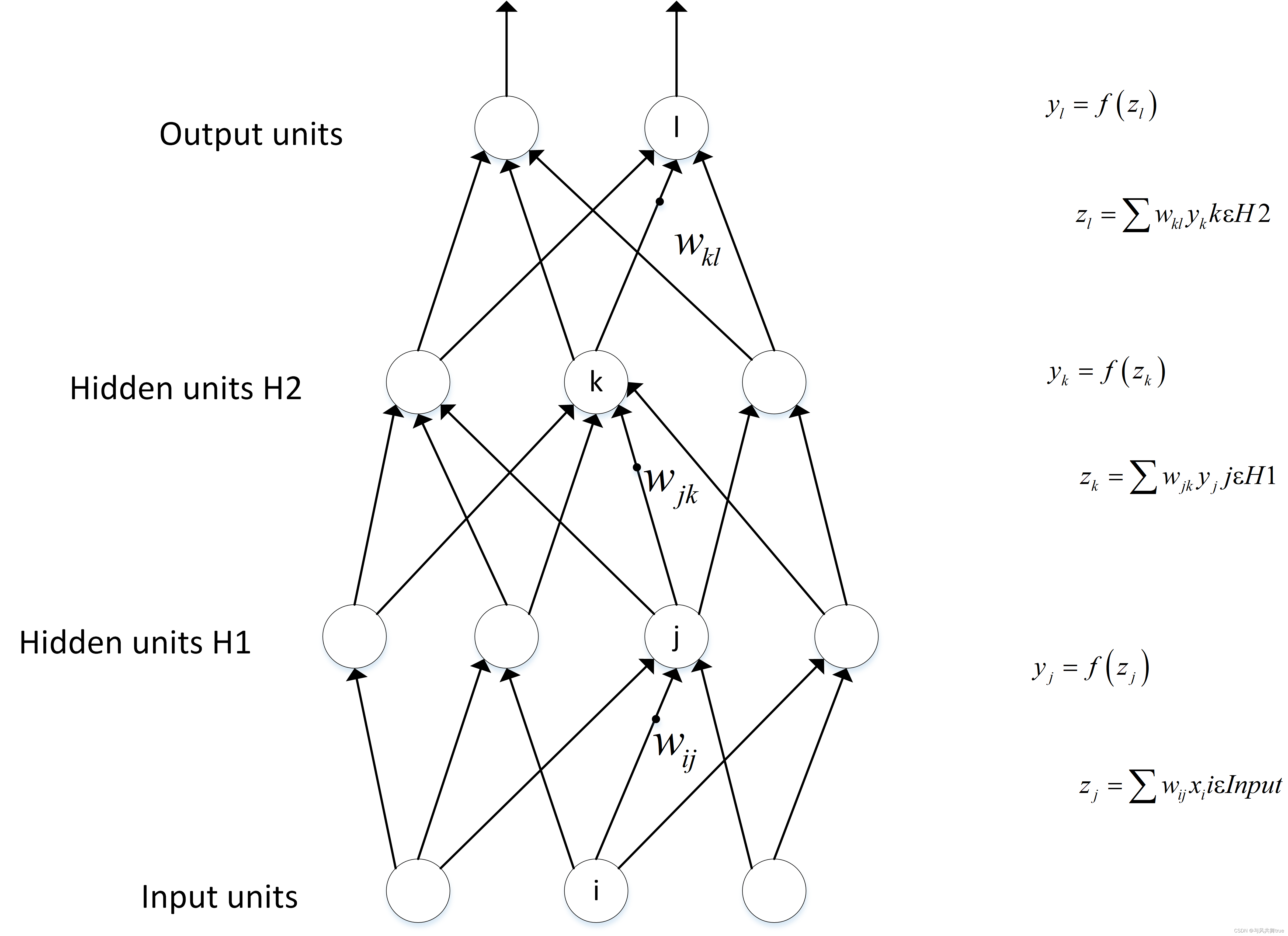

51、前向传播和反向传播

前向传播

假设上一层结点i , j , k , . . . i,j,k,…i,j,k,…等一些结点与本层的结点w ww有连接,那么结点w ww的值怎么算呢?就是通过上一层的i , j , k , . . . i,j,k,…i,j,k,…等结点以及对应的连接权值进行加权和运算,最终结果再加上一个偏置项(图中为了简单省略了),最后在通过一个非线性函数(即激活函数),如R e L u ReLu,s i g m o i d 等函数,最后得到的结果就是本层结点w的输出。

最终不断的通过这种方法一层层的运算,得到输出层结果。

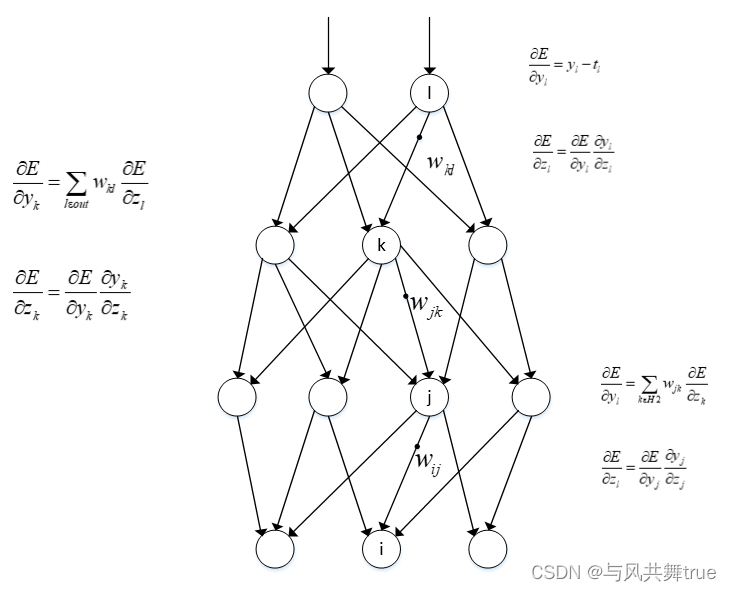

反向传播

由于我们前向传播最终得到的结果,以分类为例,最终总是有误差的,那么怎么减少误差呢,当前应用广泛的一个算法就是梯度下降算法,但是求梯度就要求偏导数

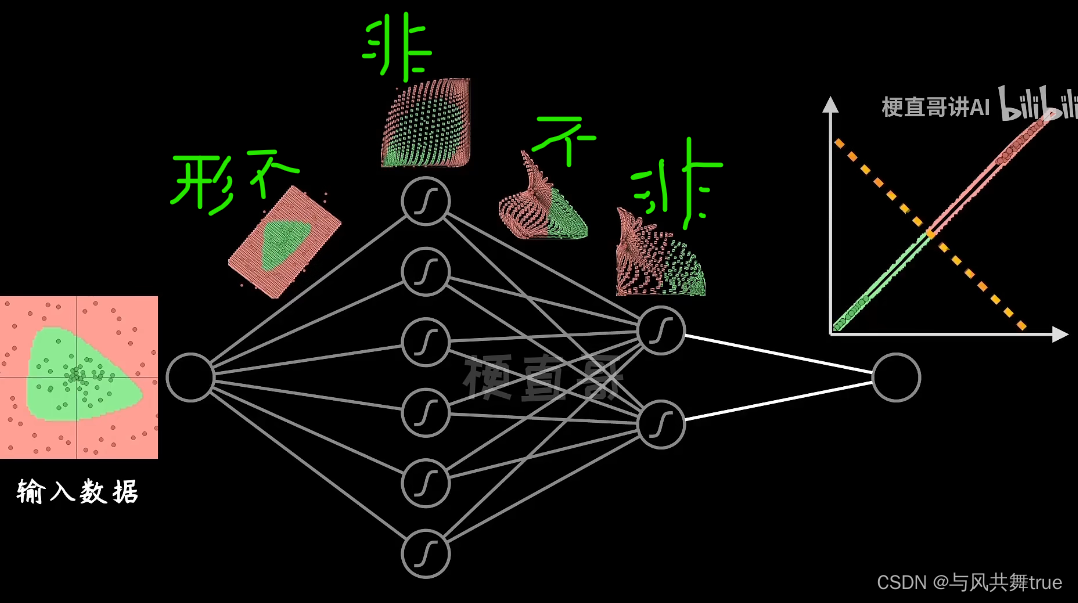

52、激活函数

是什么:

在神经元中,输入的 inputs 通过加权,求和后,还被作用了一个函数,这个函数就是激活函数。**引入激活函数是为了增加神经网络模型的非线性。**没有激活函数的每层都相当于矩阵相乘。就算你叠加了若干层之后,无非还是个矩阵相乘罢了。

为什么:

- 激活函数对模型学习、理解非常复杂和非线性的函数具有重要作用。

- 激活函数可以引入非线性因素。如果不使用激活函数,则输出信号仅是一个简单的线性函数。线性函数一个一级多项式,线性方程的复杂度有限,从数据中学习复杂函数映射的能力很小。没有激活函数,神经网络将无法学习和模拟其他复杂类型的数据,例如图像、视频、音频、语音等。

- 激活函数可以把当前特征空间通过一定的线性映射转换到另一个空间,让数据能够更好的被分类。

为什么激活函数需要非线性函数

假若网络中全部是线性部件,那么线性的组合还是线性,与单独一个线性分类器无异。这样就做不到用非线性来逼近任意函数。

使用非线性激活函数 ,以便使网络更加强大,增加它的能力,使它可以学习复杂的事物,复杂的表单数据,以及表示输入输出之间非线性的复杂的任意函数映射。使用非线性激活函数,能够从输入输出之间生成非线性映射。

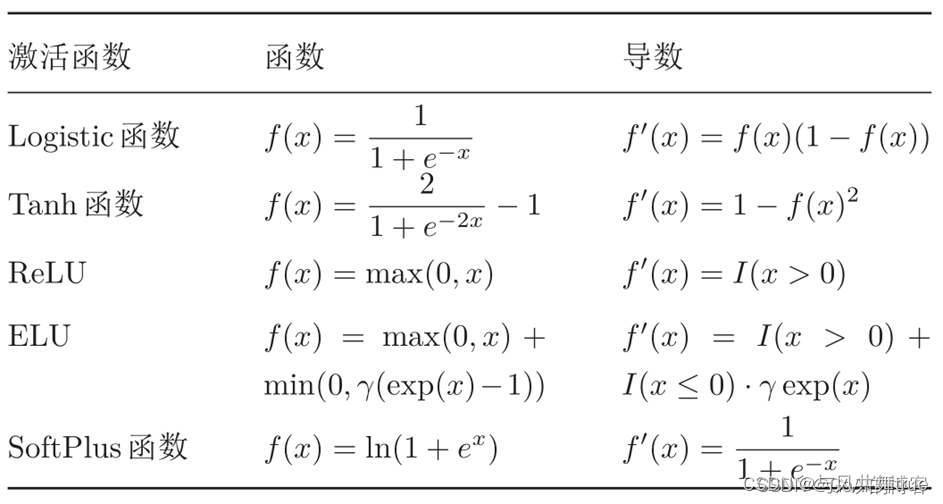

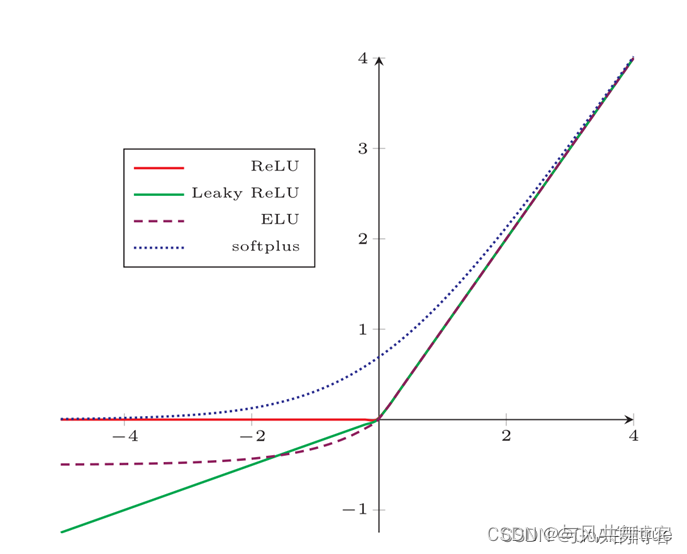

常见激活函数

激活函数详细学习参考以下资料:

https://ai-wx.blog.csdn.net/article/details/104729911

https://ai-wx.blog.csdn.net/article/details/118914829

https://blog.csdn.net/shyjhyp11/article/details/109279411

一些选择激活函数的经验法则: 如果输出是0、1值(二分类问题),则输出层选择 sigmoid 函数,然后其它的所有单元都选择 Relu 函数。这是很多激活函数的默认选择,如果在隐藏层上不确定使用哪个激活函数,那么通常会使用 Relu 激活函数。有时,也会使用 tanh激活函数。

激活函数在改变队伍形状

人们多年发现,relu函数最有效

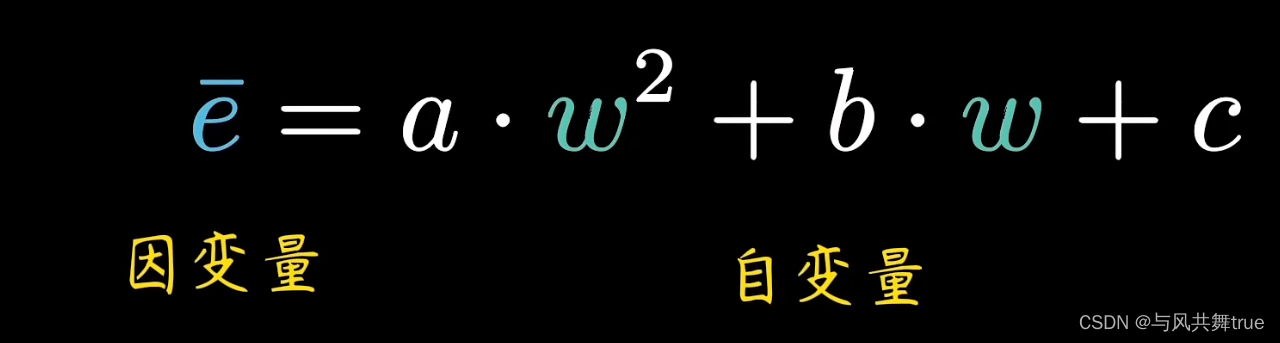

53、损失函数

损失函数:用来评价网络模型的输出的预测值与真实值之间的差异,损失函数越小,模型性能越好,我们就是要让损失函数尽可能小,

有多种损失函数:例如最小二乘法(均方误差)、交叉熵函数

1、最小二乘法:(其实就是变形了的实际值与预测值之间的差值的平方或者是区别)

e就是误差,

代价函数或损失函数怎么用:

机器学习的目的就是找到代价函数最小值

https://www.bilibili.com/video/BV1RL411T7mT/?spm_id_from=333.999.0.0&vd_source=a402747bd6c153bdb2defee02a9cb617

代价函数不一定是一个参数,可能是一元二次的,肯能是曲面

2、还有一个是最大似然估计(高斯)

54、回归损失函数

对于分类和回归模型使用的损失函数不同,

(1) 均方误差损失函数

均方误差(Mean Squared Error Loss, MSE)损失函数定义如下:

def mean_squared_error(y_true, y_pred):

return np.mean(np.square(y_pred - y_true), axis=-1)

(2) 平均绝对误差损失函数

平均绝对误差(Mean Absolute Error Loss, MAE)损失函数定义如下:

def mean_absolute_error(y_true, y_pred):

return np.mean(np.abs(y_pred - y_true), axis=-1)

(3) 均方误差对数损失函数

(4) 平均绝对百分比误差损失函数

均方误差损失函数是使用最广泛的,并且在大部分情况下,均方误差有着不错的性能,因此被用作损失函数的基本衡量指标。MAE 则会比较有效地惩罚异常值,如果数据异常值较多,需要考虑使用平均绝对误差损失作为损失函数。一般情况下,为了不让数据出现太多异常值,可以对数据进行预处理操作。

均方误差对数损失与均方误差的计算过程类似,多了对每个输出数据进行对数计算,目的是缩小函数输出的范围值。平均绝对百分比误差损失则计算预测值与真实值的相对误差。均方误差对数损失与平均绝对百分 比误差损失实际上是用来处理大范围数据( [ − 10 5 , 10 5 ]的,但是在神经网络中,我们常把输入数据归一化到一个合理范围 ( [ − 1 , 1 ]),然后再使用均方误差或者平均绝对误差损失来计算损失。

55、分类损失函数

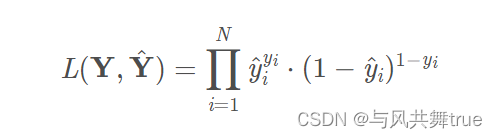

(1) Logistic损失函数

(2) 负对数似然损失函数

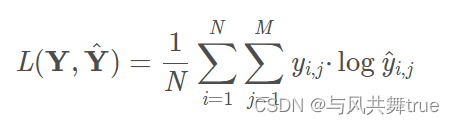

(3) 交叉熵损失函数

Logistic损失函数和负对数似然损失函数只能处理二分类问题,对于两个分类扩展到M个分类,使用交叉熵损失函数(Cross Entropy Loss),其定义如下:

(4) Hinge损失函数

(5) 指数损失函数

56、神经网络中常用的损失函数

在实际工程项目上,结合激活函数来选择损失函数是常见的做法,常用组合有以下 3 种

(1) ReLU + MSE

均方误差损失函数无法处理梯度消失问题,而使用 Leak ReLU 激活函数能够减少计算时梯度消失的问题,因此在神经网络中如果需要使用均方误差损失函数,一般采用 Leak ReLU 等可以减少梯度消失的激活函数。另外,由于均方误差具有普遍性,一般作为衡量损失值的标准,因此使用均方误差作为损失函数表现既不会太好也不至于太差。

(2) Sigmoid + Logistic

Sigmoid 函数会引起梯度消失问题:根据链式求导法,Sigmoid 函数求导后由多个[0, 1]范围的数进行连乘,如其导数形式为 ,当其中一个数很小时,连成后会无限趋近于零直至最后消失。而类 Logistic 损失函数求导时,加上对数后连乘操作转化为求和操作,在一定程度上避免了梯度消失,所以我们经常可以看到 Sigmoid 激活函数+交叉摘损失函数 的组合。

(3) Softmax + Logisitc

在数学上,Softmax 激活函数会返回输出类的互斥概率分布,也就是能把离散的输出转换为一个同分布互斥的概率,如(0.2, 0.8)。另外,Logisitc 损失函数是基于概率的最大似然估计函数而来的,因此输出概率化能够更加方便优化算法进行求导和计算,所以我们经常可以看到输出层使xu用 Softmax 激活函数+交叉熵损失函数 的组合。

57、激活函数、损失函数、优化函数的区别

**1.激活函数:**将神经网络上一层的输入,经过神经网络层的非线性变换转换后,通过激活函数,得到输出。常见的激活函数包括:sigmoid, tanh, relu等。

**2.损失函数:**度量神经网络的输出的预测值,与实际值之间的差距的一种方式。常见的损失函数包括:最小二乘损失函数、交叉熵损失函数、回归中使用的smooth L1损失函数等。

3.优化函数:也就是如何把损失值从神经网络的最外层传递到最前面。如最基础的梯度下降算法,随机梯度下降算法,批量梯度下降算法,带动量的梯度下降算法,Adagrad,Adadelta,Adam等。

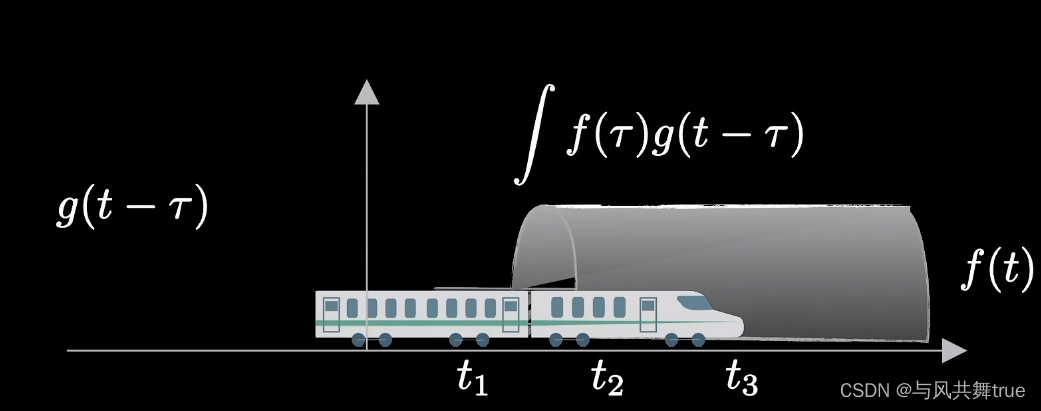

58、CNN卷积神经网络

https://blog.csdn.net/jiaoyangwm/article/details/80011656

卷积神经网络(Convolutional Neural Networks,CNN)是一类包含卷积计算且具有深度结构的前馈神经网络(Feedforward Neural Networks),是深度学习(deeplearning)的代表算法之一 。目前 CNN 已经得到了广泛的应用,比如:人脸识别、自动驾驶、美图秀秀、安防等很多领域。

卷积神经网络 – CNN 最擅长的就是图片的处理。它受到人类视觉神经系统的启发。

卷积

火车进山洞,山洞套火车

卷积作用就是滤波

59、优化算法

基本的梯度下降方法

(1)随机梯度下降法SGD

(2)批量梯度下降法BGD

小批量梯度下降法MBGD

Adagrad

Adadelta

RMSprop

60、深度学习

图像处理领域主要应用

图像分类(物体识别):整幅图像的分类或识别

物体检测:检测图像中物体的位置进而识别物体

图像分割:对图像中的特定物体按边缘进行分割

图像回归:预测图像中物体组成部分的坐标

语音识别领域主要应用

语音识别:将语音识别为文字

声纹识别:识别是哪个人的声音

语音合成:根据文字合成特定人的语音

自然语言处理领域主要应用

语言模型:根据之前词预测下一个单词。

情感分析:分析文本体现的情感(正负向、正负中或多态度类型)。

神经机器翻译:基于统计语言模型的多语种互译。

神经自动摘要:根据文本自动生成摘要。

机器阅读理解:通过阅读文本回答问题、完成选择题或完型填空。

自然语言推理:根据一句话(前提)推理出另一句话(结论)。

综合应用

图像描述:根据图像给出图像的描述句子

可视问答:根据图像或视频回答问题

图像生成:根据文本描述生成图像

视频生成:根据故事自动生成视频

379

379

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?