论文:DF-GAN: A Simple and Effective Baseline for Text-to-Image Synthesis

摘要:

从文字描述中合成高质量的逼真图像是一项具有挑战性的任务。现有的文本到图像生成对抗网络通常采用堆叠架构作为主干,但仍然存在三个缺陷。首先,堆叠架构引入了不同图像尺度的生成器之间的纠缠。其次,现有的研究倾向于在文本图像语义一致性的对抗学习中应用和固定额外的网络,这限制了这些网络的监督能力。第三,以往广泛采用的基于跨模态注意力的文本-图像融合算法,由于计算成本的限制,只适用于几种特殊的图像尺度。为此,我们提出了一种更简单但更有效的深度融合生成对抗网络(DF-GAN)。具体而言,我们提出:(1)一种新型的单阶段文本-图像主干,直接合成高分辨率图像,不存在不同生成器之间的纠缠;(2)一种新型的目标感知判别器,由匹配感知梯度惩罚和单向输出组成,在不引入额外网络的情况下增强了文本-图像语义一致性;(3)一种新型的深度文本-图像融合块,深化融合过程,使文本和视觉特征完全融合。与目前最先进的方法相比,我们提出的DFGAN更简单,更有效地合成真实和文本匹配的图像,并在广泛使用的数据集上取得更好的性能。

引言:

文本到图像合成的两个主要挑战是生成图像的真实性,以及给定文本和生成图像之间的语义一致性。由于GAN模型的不稳定性,最新的模型大多采用堆叠架构[56,57]作为主干来生成高分辨率图像。他们采用跨模态注意融合文本和图像特征[37,50,56,57,60],然后引入DAMSM网络[50]、循环一致性[33]或Siamese网络[51],通过额外的网络来保证文本语义的一致性。

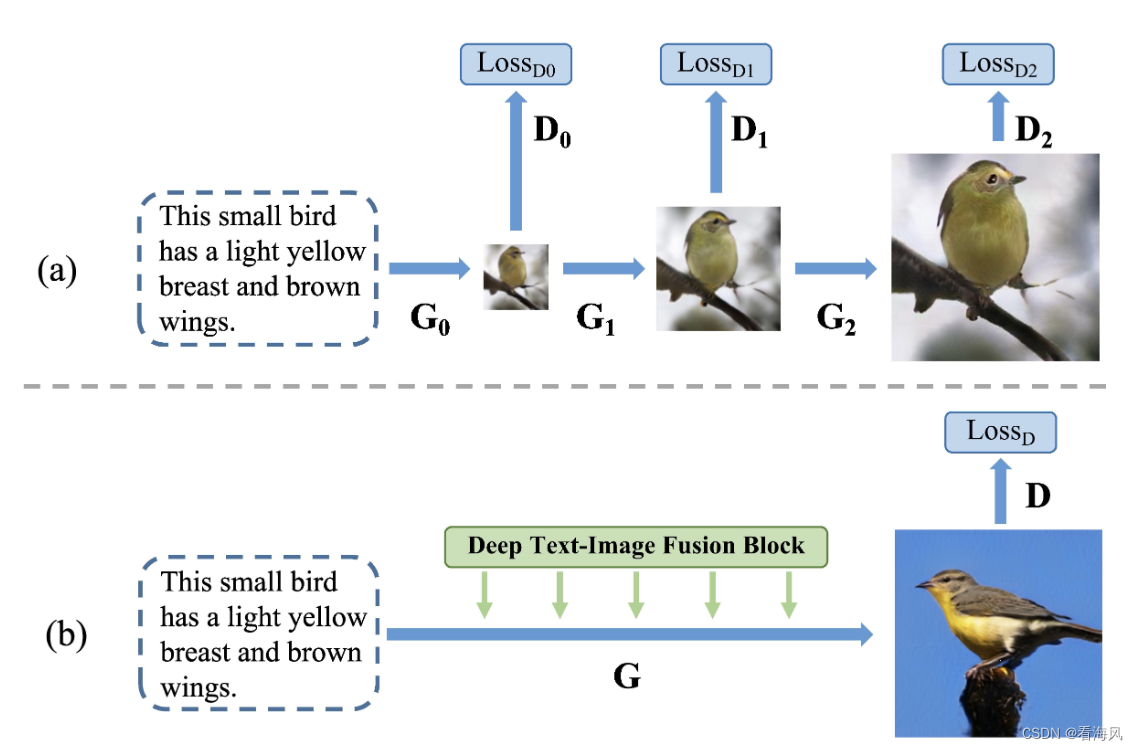

虽然前人的研究已经取得了令人印象深刻的成果[9,19,21,32,33,51,60],但仍存在三个问题。首先,堆叠架构[56]引入了不同生成器之间的纠缠,这使得最终的精炼图像看起来像是模糊形状和一些细节的简单组合。如图1(a)所示,最终的精炼图像具有由G0合成的模糊形状,由G1合成的粗略属性(如眼睛和喙),以及由G2添加的细粒度细节(如眼睛反射)。最终合成的图像看起来像是来自不同图像尺度的视觉特征的简单组合。第二,现有的研究通常在对抗性训练过程中固定额外的网络[33, 50],使得这些网络很容易被生成器愚弄来合成对抗性特征[30, 52],从而削弱了它们对语义一致性的监督力量。第三,跨模态注意力[50]不能充分利用文本信息。由于其高计算成本,它们只能在64×64和128×128的图像特征上应用两次。它限制了文本-图像融合过程的有效性,并使该模型难以扩展到更高分辨率的图像合成中。

为了解决上述问题,提出了深度融合生成对抗网络(DF-GAN)。对于第一个问题,我们将堆叠主干替换为一级主干,即只有一个生成器。它由铰链损失[54]和残差网络[11]组成,稳定了GAN训练过程,直接合成高分辨率图像。针对第二个问题,在不额外引入网络的情况下,我们设计了一个由匹配感知梯度惩罚(MA-GP)和单向输出组成的目标感知鉴别器,以增强文本图像的语义一致性。MA-GP是一种基于鉴别器的正则化策略。它追求鉴别器对目标数据(真实图像和文本匹配图像)的梯度为零。因此,MA-GP在真实和匹配的数据点处构建了光滑的损失面,进一步促进了生成器合成文本匹配图像。此外,考虑到之前的双向输出减缓了MA-GP下生成器的收敛过程,我们用更有效的单向输出取代它。对于第三个问题,我们提出了一种深度文本图像融合块(DFBlock),以更有效地将文本信息融合到图像特征中。DFBlock由几个仿射变换组成[31]。仿射变换是一个轻量级模块,它通过通道缩放和移位操作来操纵视觉特征映射。在所有图像尺度叠加多个dfblock,加深了文本-图像融合过程,使文本与视觉特征充分融合。

模型概述:

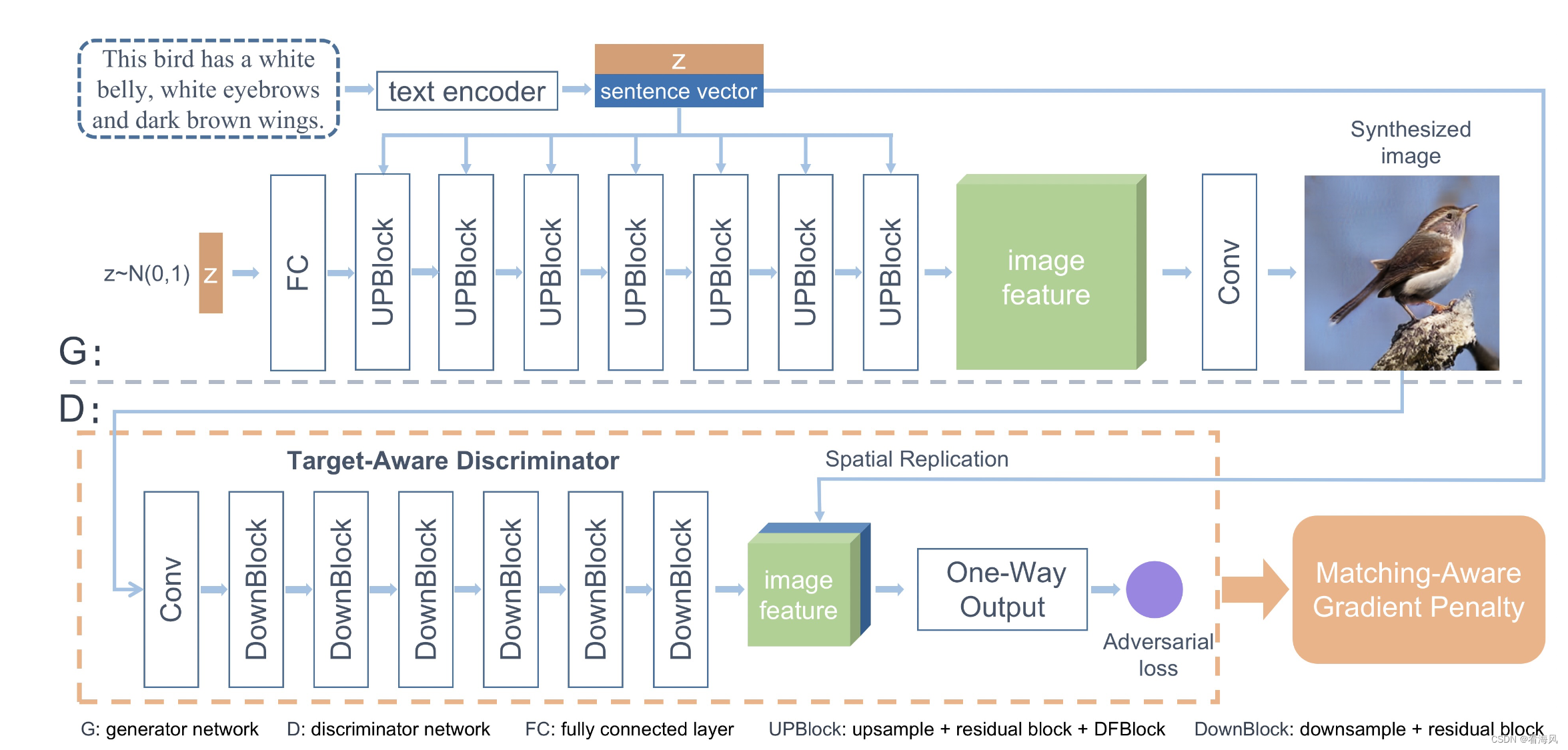

DF-GAN由一个生成器、一个鉴别器和一个预训练的文本编码器组成,如图2所示。

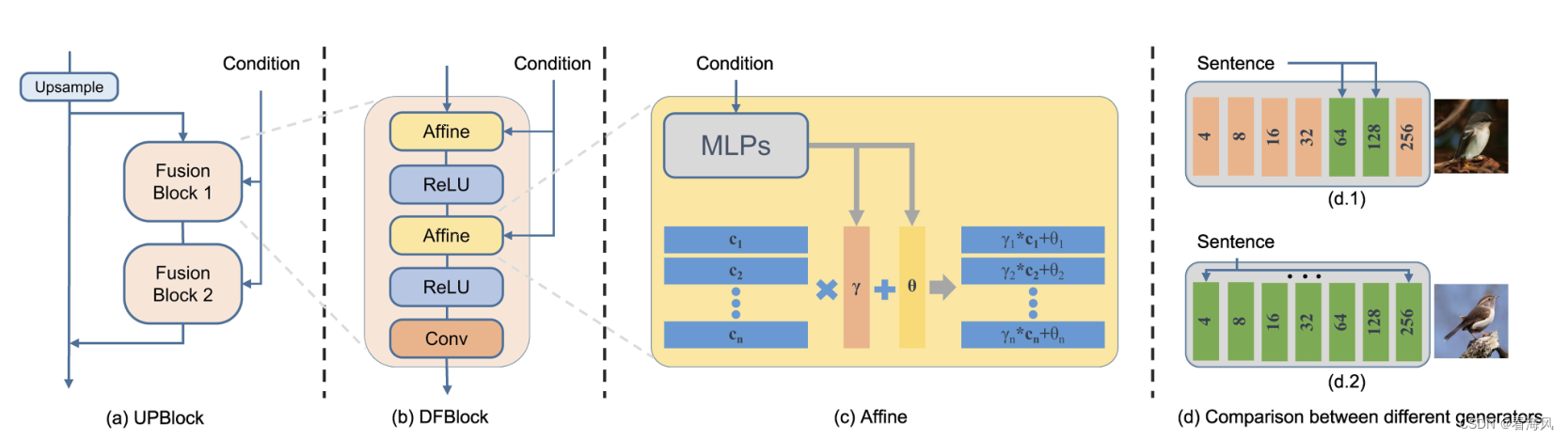

该生成器有两个输入,一个是由文本编码器编码的句子向量,另一个是从高斯分布中采样的噪声向量,以确保生成图像的多样性。首先将噪声矢量馈送到一个完全连接的层中并重塑。然后应用一系列upblock对图像特征进行上采样。UPBlock由上行采样层(upsample layer)、残差块(residual block)和DFBlocks组成,用于融合图像生成过程中的文本和图像特征。最后,卷积层将图像特征转换为图像。

鉴别器通过一系列downblock将图像转换为图像特征。然后,句子向量将被复制并与图像特征连接。预测对抗损失以评估输入的视觉真实感和语义一致性。鉴别器通过将生成的图像与真实样本区分开来,促进生成器合成具有更高质量和文本-图像语义一致性的图像。

文本编码器是一种双向长短期记忆(LSTM)[41],它从文本描述中提取语义向量。我们直接使用AttnGAN[50]提供的预训练模型。

生成器:

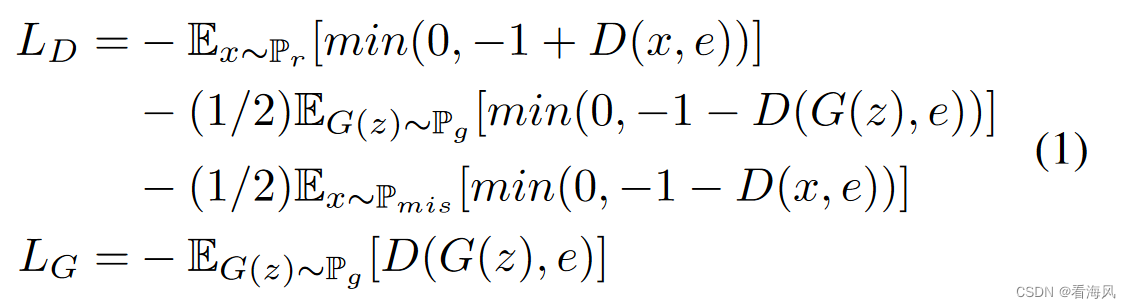

由于我们的一级框架中的单个生成器需要直接从噪声向量合成高分辨率图像,因此它必须比以前的堆叠结构中的生成器包含更多的层。为了有效地训练这些层,我们引入残差网络[11]来稳定更深层网络的训练。铰链损失[23]的公式如下:

其中,z是高斯分布采样的噪声向量;e是句子向量;Pg、Pr、Pmis分别表示合成数据分布、真实数据分布和不匹配数据分布。

鉴别器:

目标感知鉴别器,它由匹配感知梯度惩罚(MA-GP)和单向输出组成。TargetAware Discriminator使生成器能够合成更逼真、文本-图像语义一致的图像。

匹配感知梯度惩罚(MA-GP):

基于匹配感知的零中心梯度惩罚(MAGP)是增强文本图像语义一致性的策略。好处是:1)将MA-GP损失作为判别器的正则化,模型可以更好地收敛于文本匹配的真实数据,从而合成更多的文本匹配图像。2)由于鉴别器在网络中是联合训练的,它可以防止生成器合成固定额外网络的对抗特征。3)由于MA-GP不包含任何用于文本图像一致性的额外网络,并且梯度已经通过反向传播过程计算,因此MA-GP引入的唯一计算是梯度求和,这比额外的网络更易于计算。

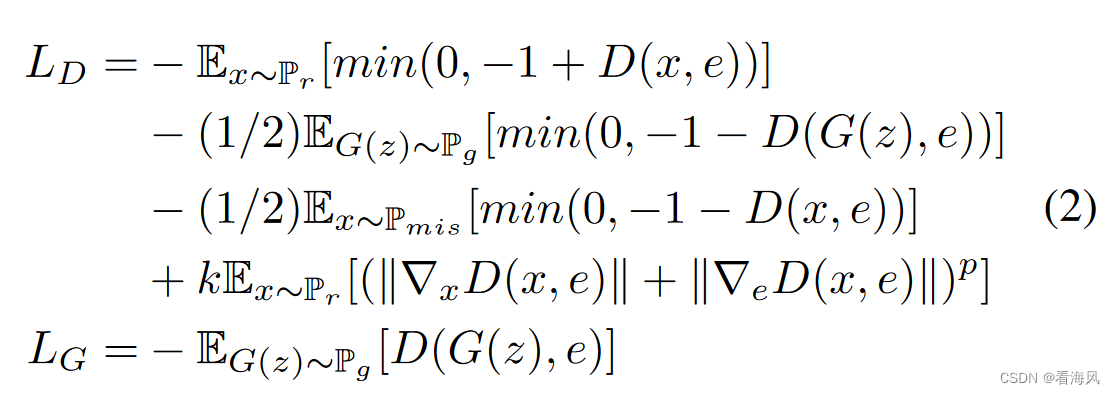

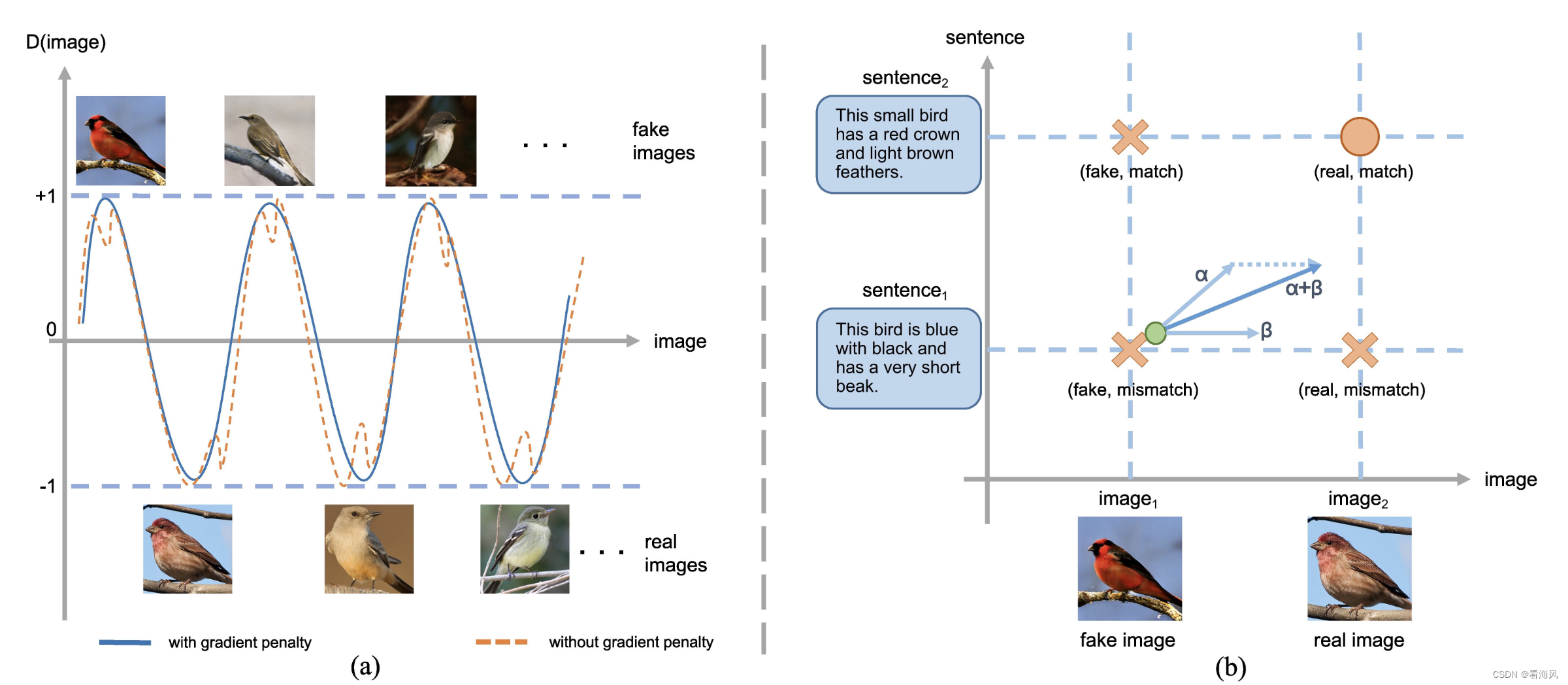

如图3(a)所示,在无条件图像生成中,目标数据(真实图像)对应的鉴别器损失较低,合成图像对应于较高的鉴别器损失。铰链损耗限制了鉴别器损耗在-1和1之间的范围。对真实数据的梯度惩罚将降低真实数据点及其附近的梯度。然后对真实数据点周围的损失函数表面进行平滑处理,有利于合成数据点向真实数据点收敛。基于以上分析,我们发现目标数据上的梯度惩罚构建了一个更好的损失格局,以帮助生成器收敛。通过利用视图生成文本到图像。如图3(b)所示,在文本-图像生成中,判别器观察到四种输入:具有匹配文本的合成图像(假的,匹配的),具有不匹配文本的合成图像(假的,不匹配的),具有匹配文本的真实图像(真实的,匹配的),具有不匹配文本的真实图像(真实的,不匹配的)。对于文本-视觉语义的一致性,我们倾向于在文本匹配的真实数据上应用梯度惩罚,这是文本-图像合成的目标。因此,在MA-GP中,梯度惩罚应该应用于具有匹配文本的真实图像。我们的模型与MA-GP的整个表述如下:

其中k和p是平衡梯度惩罚有效性的两个超参数。

单项输出:

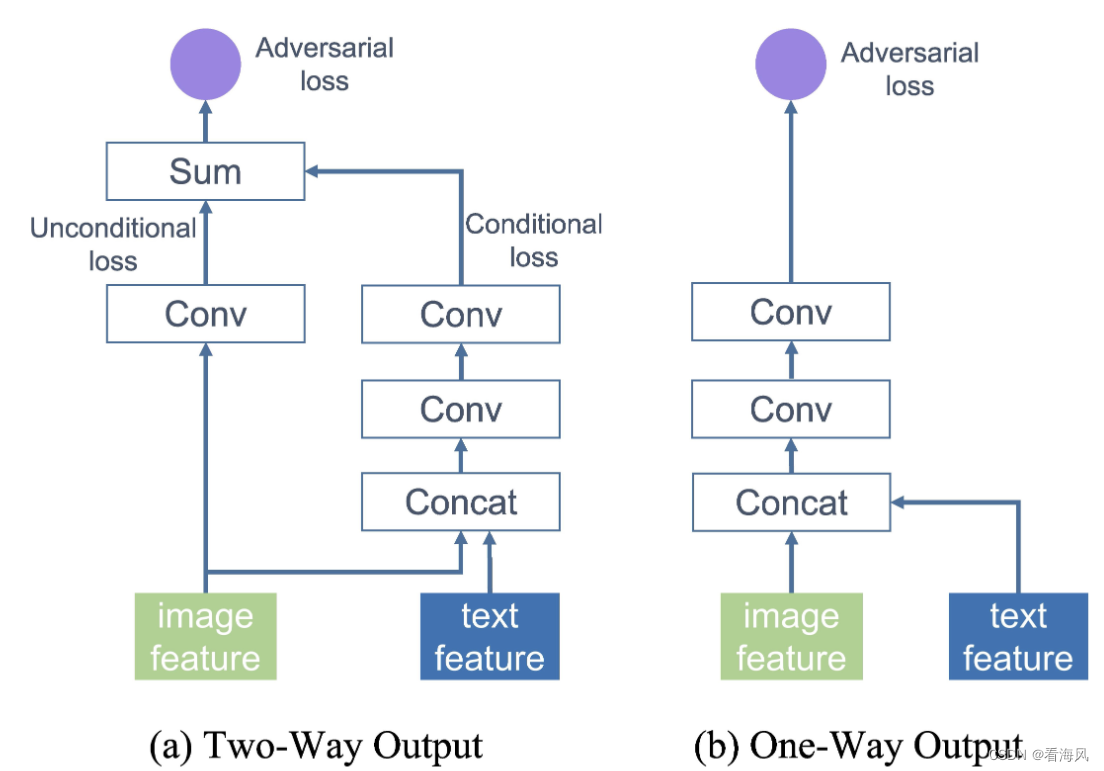

在以往的文本-图像gan[50,56,57]中,鉴别器提取的图像特征通常有两种使用方式(图4(a)):一种是判断图像的真假,另一种是将图像特征与句子向量连接起来,评估文本-图像语义一致性。相应的,在这些模型中计算了无条件损失和条件损失。然而,双向输出削弱了MA-GP的有效性,减慢了生成器的收敛速度。具体来说,如图3(b)所示,反向传播后,条件损失给出一个指向真实和匹配输入的梯度α,而无条件损失给出一个只指向真实图像的梯度β。然而,最终梯度的方向只是简单地将α和β相加,并没有像我们期望的那样指向真实的和匹配的数据点。由于生成器的目标是合成真实的和文本匹配的图像,最终的有偏差的梯度不能很好地实现文本图像的语义一致性,减慢了生成器的收敛过程。

因此,我们提出了用于文本到图像合成的单向输出。如图4(b)所示,我们的鉴别器将图像特征和句子向量连接起来,然后通过两个卷积层只输出一个对抗性损失。通过单向输出,我们可以使单个梯度α直接指向目标数据点(真实的和匹配的),从而优化和加速生成器的收敛。

通过结合MA-GP和单向输出,我们的目标感知鉴别器可以引导生成器合成更多真实的和文本匹配的图像。

深度文本图像融合块(DFBlock):

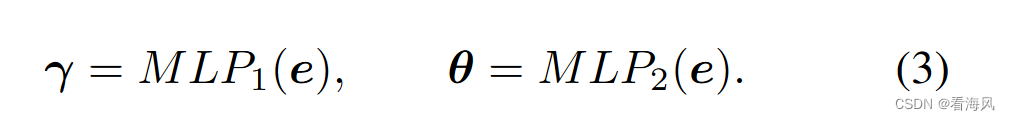

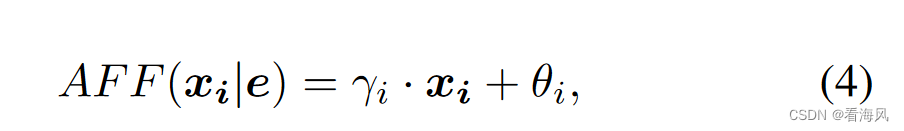

如图2所示,我们的DF-GAN发生器由7个upblock组成。UPBlock包含两个文本-图像融合块。为了充分利用融合中的文本信息,我们提出了深度文本图像融合块(DFBlock),该融合块将多个仿射变换和ReLU层叠加在融合块中。对于仿射变换,如图5©所示,我们采用两个mlp(多层感知器)分别从句子向量e预测语言条件通道方向的缩放参数γ和移位参数θ:

对于给定的输入特征映射X∈R^B×C×H×W,我们首先使用缩放参数γ对X进行通道级缩放操作,然后使用移位参数θ应用通道级移位操作。这个过程可以表示为:

式中AFF为仿射变换;E是句子向量;γi和θi是视觉特征映射第i通道的缩放参数和移位参数。

仿射层扩展了生成器的条件表示空间。然而,仿射变换是每个通道的线性变换。它限制了文本图像融合处理的有效性。因此,我们在两个仿射层之间添加了一个ReLU层,使融合过程具有非线性。与只有一个仿射层相比,它扩大了条件表示空间。更大的表示空间有助于生成器根据文本描述将不同的图像映射到不同的表示。

DFBlock部分受到条件批归一化(CBN)[5]和自适应实例归一化(AdaIN)[14,16]的启发,它们包含仿射变换。然而,CBN和AdaIN都采用了归一化层[15,44],将特征映射转换为正态分布。它产生了与仿射变换相反的效果,期望增加不同样品之间的距离。这对条件生成过程是没有帮助的。为此,我们取消了规范化过程。此外,我们的DFBlock加深了文本图像融合过程。我们堆叠多个仿射层,并在两者之间添加一个ReLU层。

DFBlock促进了视觉特征的多样性,扩大了表示空间,以根据不同的文本描述表示不同的视觉特征。DFBlock为文本到图像的生成带来了两个主要的好处:1)使生成器在融合文本和图像特征时更充分地利用了文本信息。2)深化融合过程,扩大融合模块的表示空间,有利于从不同的文本描述中生成语义一致的图像。

DFBlock使得我们的模型在融合文本和图像特征时不再考虑图像尺度的限制。这是因为现有的文本到图像gan一般采用跨模态注意机制,随着图像尺寸的增大,计算成本快速增长。

1589

1589

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?