小罗碎碎念

本期推文主题

今天详细分析的这篇文章,通过系统性地收集和实验验证医学图像分割中的多种技巧,提供了一个全面深入的技术分析和实用指南,旨在解决小数据集学习、类别不平衡、多模态学习和领域适应等挑战。

作者所有的实验都在四个数据集上展开——2D与3D的数据集各两个,既涉及病理的数据,也涉及影像的数据,所以这篇文章的受众是非常广的。

考虑到这篇文章涉及到大量的工科专业术语,小罗特地做了大量的知识点补充,希望能对你们有所帮助!!下期推文见!!

文献概述

这篇文章名为《Understanding the Tricks of Deep Learning in Medical Image Segmentation: Challenges and Future Directions》,由Dong Zhang、Yi Lin、Hao Chen等作者撰写。

主要探讨了深度学习在医学图像分割(MedISeg)中的多种实现策略,这些策略虽然提高了性能,但也使得系统变得复杂,并可能导致结果比较的不公平。

| 角色 | 姓名 | 单位(中文) |

|---|---|---|

| 第一作者 | Dong Zhang | 香港科技大学计算机科学与工程系 |

| 通讯作者 | Hao Chen | 香港科技大学计算机科学与工程系 |

文章收集并实验探索了不同模型实现阶段(包括预训练模型、数据预处理、数据增强、模型实现、模型推理和结果后处理)的一系列技巧,并在一致的基线模型上检验了这些技巧的有效性。

通过在2D和3D医学图像数据集上的广泛实验,文章明确了这些技巧的效果,并开源了一个强大的MedISeg代码库,其中每个组件都具有即插即用的优势。

文章的主要贡献包括:

- 收集并实验探索了不同实现阶段的基础MedISeg技巧。

- 开源了一个强大的MedISeg代码库,包含丰富的分割技巧,每个技巧都具有即插即用的优势。

- 为未来医学图像处理挑战,包括小数据集学习、类别不平衡学习、多模态学习和领域适应等,提供了实际的指导。

文章还讨论了这些技巧的潜在挑战和问题,指出了这些技巧的局限性,并提出了未来的研究方向,包括对MedISeg技巧的进一步研究和发展、探索技巧在更多方法和数据集上的有效性、探索受技巧启发的模型设计,以及探索基于注意力的技巧和大型视觉模型在医学图像分析中的应用。

一、引言

医学图像分割(MedISeg)是计算机视觉和医学图像分析领域最具代表性和全面性的研究课题之一。

MedISeg不仅可以识别物体类别,还能精确定位像素级别的位置。在临床实践中,MedISeg已在多种潜在应用中得到成功应用,包括癌症诊断、肿瘤变化检测、治疗计划以及计算机辅助手术等,并进行了定性和定量分析。

近年来,得益于深度图像处理技术的显著进步,MedISeg的性能得到了大幅提升。

先进的主干网络(例如AlexNet、VGG、ResNet、DenseNet、MobileNet、ShuffleNet、ResNeXt、HRNet、RegNet、ViT、SwinTransformer、CMT、ConFormer、CvT等)内在地编码了丰富的语义特征表示,直接促进了MedISeg的能力。

知识点补充:主干网络介绍

-

AlexNet:由Alex Krizhevsky等人于2012年提出,是深度学习在图像识别领域的重要里程碑,它是一个具有5层卷积神经网络的结构。

-

VGG:由牛津大学的视觉几何组(Visual Geometry Group)提出,其特点是使用3x3的卷积核和更多的卷积层,通常以VGG16或VGG19的形式出现。

-

ResNet:由微软研究院提出,引入了残差学习框架来解决深层网络训练中的梯度消失问题,其关键创新是残差块(Residual Block)。

-

DenseNet:特点是每个卷积层都与前面所有层相连,这种密集连接可以有效地提高特征传播和网络性能。

-

MobileNet:专为移动和嵌入式视觉应用设计,通过使用深度可分离卷积来减少计算量和模型大小。

-

ShuffleNet:针对移动设备优化,使用组卷积和通道重排序来降低模型复杂度。

-

ResNeXt:通过使用卡特(cardinality)的概念,即模型的宽度可以扩展,来提高网络的性能。

-

HRNet:高分辨率网络,它通过多尺度特征融合来保持高分辨率表示,适用于需要精细定位的任务。

-

RegNet:由Facebook AI Research提出,通过系统地研究网络宽度和深度的比例,来设计出高效的网络结构。

-

ViT(Vision Transformer):将自然语言处理中的Transformer模型引入到计算机视觉领域,使用自注意力机制来处理图像。

-

SwinTransformer:一种基于Transformer的层次结构模型,使用移位窗口来增强模型的表示能力。

-

CMT(Convolutional Neural Networks Meet Vision Transformers):结合了卷积神经网络和Transformer的特点,以利用两者的优势。

-

ConFormer:是一种结合了卷积网络和Transformer的模型,专注于局部特征和全局上下文的结合。

-

CvT(Convolutional Vision Transformer):将卷积操作引入到Transformer架构中,以增强模型对空间关系的学习能力。

这些架构在计算机视觉的不同任务中都有广泛的应用,包括图像分类、目标检测、图像分割等。

同时,一些特定的精细特征调控方法(例如侧连接、残差映射、编解码器方案、密集连接、特征金字塔和全局上下文聚合等)也能提升识别性能。这些复杂元素的整合是MedISeg系统表现优异的主要原因。

知识点补充:特征调控方法

这些特征调控方法是深度学习网络中用于改善特征表示和增强模型性能的技术。

-

侧连接(Lateral Connection):

侧连接是一种网络结构,它允许在编码器和解码器的相同层级之间进行信息的直接传递。这种连接方式有助于在解码器中恢复编码器捕获的高分辨率特征,从而提高图像分割的精度。 -

残差映射(Residual Mapping):

残差映射通过添加输入和输出之间的残差连接来解决深层网络训练中的梯度消失问题。在ResNet等网络中,残差块允许梯度直接流向前面的层,从而使得网络能够学习到更深的层次。 -

编解码器方案(Encoder-Decoder Scheme):

这是一种常见的网络架构,由编码器和解码器两部分组成。编码器逐步降低图像的空间维度,同时增加特征通道数,以捕获抽象特征;解码器则逐步恢复图像的空间维度,减少特征通道数,以重建图像的细节信息。 -

密集连接(Dense Connection):

密集连接是DenseNet网络的一个特征,每个卷积层都与前面所有层相连,这样每个层都可以接收到前面所有层的特征图,增强了特征的重用和信息的流动。 -

特征金字塔(Feature Pyramid):

特征金字塔是一种结构,用于构建多尺度的特征表示,常用于处理不同尺寸的物体。通过在网络中添加多尺度的特征图,可以更好地捕获图像中的小物体和大物体。 -

全局上下文聚合(Global Context Aggregation):

全局上下文聚合是一种技术,它允许网络在进行特征学习时考虑整个图像的全局信息。这可以通过全局池化、注意力机制或其他方法来实现,目的是让模型能够更好地理解图像的整体结构和内容。

这些特征调控方法在医学图像分割和其他计算机视觉任务中非常重要,因为它们可以帮助模型更有效地学习和利用图像数据中的信息。

此外,一些训练策略(例如协同训练、协同教学、协同学习、测试时训练等)和损失函数(例如dice损失和Lovasz-softmax损失等)也是影响MedISeg性能的重要组件。

知识点补充:常用的损失函数

在深度学习中,尤其是在医学图像分割领域,损失函数对于模型的训练至关重要。以下是一些常见的损失函数:

-

交叉熵损失(Cross-Entropy Loss):

用于分类问题,衡量模型预测的概率分布与真实标签的概率分布之间的差异。 -

均方误差损失(Mean Squared Error Loss):

计算模型预测值与真实值之间平方差的平均,常用于回归问题。 -

平均绝对误差损失(Mean Absolute Error Loss):

计算模型预测值与真实值之间绝对差的平均,也是一种回归损失。 -

Dice损失(Dice Loss):

特别适用于医学图像分割,衡量两个样本集合的重叠程度,常用于计算二分类问题中的损失。 -

Tversky损失(Tversky Loss):

一种用于不平衡数据集的损失函数,可以调整真正例和假正例的权重。 -

Focal Loss:

解决类别不平衡问题,减少易分类样本对损失函数的贡献,增加难分类样本的权重。 -

IoU损失(Intersection over Union Loss):

衡量预测分割区域与真实分割区域之间的重叠程度,常用于分割任务。 -

Lovasz-Softmax损失(Lovasz-Softmax Loss):

一种基于排序的损失函数,用于处理不平衡的分类问题,特别是在医学图像分割中。 -

GDice损失(Generalized Dice Loss):

对Dice损失的泛化,可以处理多类别分割问题。 -

Wasserstein损失(Wasserstein Loss):

用于衡量两个概率分布之间的差异,常用于生成对抗网络(GANs)。 -

Jaccard损失(Jaccard Loss):

类似于Dice损失,但使用的是Jaccard相似度来衡量集合的重叠。 -

Cosine损失(Cosine Loss):

用于衡量两个向量的相似度,常用于相似性度量任务。 -

Hinge损失(Hinge Loss):

用于 SVM(支持向量机)分类器,衡量样本与决策边界的距离。 -

Gaussian损失(Gaussian Loss):

用于回归问题,对预测值和真实值之间的差异使用高斯分布建模。 -

Categorical损失(Categorical Loss):

当输出是独热编码的类别时使用,是交叉熵损失的一种形式。

这些损失函数可以根据具体问题和数据集的特点进行选择或组合,以达到最佳的训练效果。在医学图像分割中,通常会选择那些能够更好地捕捉分割精度和处理类别不平衡问题的损失函数。

然而,现有方法的进展并非孤立提出,它们通常与现有方法混合,导致MedISeg系统极为复杂。

目前,一个完整的MedISeg系统通常包含大量实现细节(包括一些与学习模型无关的预处理程序),以达到理想的最先进性能。不幸的是,在当前的复杂MedISeg系统中,一些边缘实现策略(也称为“技巧”)常被忽视,尽管它们对系统性能有显著影响。

本工作旨在揭示这些技巧对MedISeg模型的影响。作者根据完整的实现阶段,收集了一系列容易被忽视的代表性技巧,包括:

- 预训练模型

- 数据预处理

- 数据增强

- 模型实现

- 模型推理

- 结果后处理

通过在典型的2D-UNet和3D-UNet分割基线上进行实验探索这些技巧的有效性,从而避免了模型变种对性能变化的影响。与仅关注图像分割模型优缺点分析的技术调查不同,作者的工作提供了大量扎实的实验结果,对未来工作更具技术操作性。基于四个医学图像数据集的广泛实验结果,作者明确澄清了这些技巧的效果。

本工作的主要贡献总结如下:

- 作者收集了一系列不同实现阶段的MedISeg基本技巧,并在一致的基线模型上实验探索了这些技巧的有效性。

- 作者明确澄清了这些技巧的有效性,并在2D和3D医学图像数据集上进行了大量扎实的实验,弥补了MedISeg实现忽视的问题。

- 作者开源了一个强大的MedISeg仓库,其中包括丰富的分割技巧,每个技巧都具有即插即用的优势。

- 这一里程碑工作将促进后续努力在公平环境下比较MedISeg模型的实验结果。

- 此工作将为广泛的医学图像处理,特别是未来语义分割挑战提供实际指导。

二、预备知识

2.1 基线模型

为确保实验的全面性,作者选择了常用的代表性2D-UNet [44] 和3D-UNet [77] 作为基线模型。

以下为这两个基线的详细描述:

2.1.1 2D-UNet

2D-UNet是一种广泛应用于医学图像分割的架构[82]–[86]。

它由编码器网络和解码器网络组成。

编码器网络遵循全卷积架构,包含四个空间缩减阶段,每个阶段由两个3×3卷积层组成,之后是整流线性单元(ReLU)激活函数[87],[88]和一个全局最大池化层(步长大小S=2)。

解码器网络以编码器网络的输出为输入,也有四个对应于相同空间编码器阶段的阶段。每个解码器阶段使用2D转置卷积算子通过双线性插值操作[89]将特征图上采样2倍。

然后,依次部署两个3×3卷积层和一个ReLU激活函数[87],[88]。在最终的解码器网络层中,输出特征图的通道大小通过一个2×2卷积层分配给所用数据集的类别大小。

2.1.2 3D-UNet

3D-UNet与2D-UNet具有类似的网络架构[44],包括一个3D编码器网络和一个3D解码器网络[90]–[95]。它常用于3D图像分割[96]–[98]。

3D-UNet与2D-UNet的主要区别在于:

- i) 2D卷积层被3D卷积层[99]取代;

- ii) 在编码器和解码器相同阶段的水平连接之间增加了侧连接,具有相同的空间和通道大小;

- iii) 使用归一化层[100][87],[88]对输入图像强度进行归一化处理。

2.2 实验数据集

为确保实验评估的全面性并避免对特定数据集特征的偏见,本文选择了四个代表性的医学图像数据集。

这些数据集包括:

- 一个具有常见对象大小的2D数据集,即ISIC 2018病变边界分割数据集[78];

- 一个具有小对象大小的2D数据集,结肠细胞核识别与计数挑战(CoNIC)数据集[79],[81],[101];

- 3D肾脏肿瘤分割2019(KiTS19)数据集[80];

- 3D肝脏肿瘤分割挑战(LiTS)数据集[67]。

以下为每个数据集的详细介绍:

2.2.1 2D ISIC 2018

ISIC 2018数据集[78]是一个具有挑战性且代表性的2D皮肤病变边界分割数据集,属于计算机辅助诊断领域。

该数据集包含2,594张JPEG皮肤镜图像和2,594张PNG地面真实(GT)图像,每张图像中有一个或多个不同大小的病变区域。

每个皮肤病变图像具有统一的空间大小600×450。在此数据集中,作者只需分割两个类别的区域,即前景“病变”区域和“背景”。

根据先前研究[102],[103],作者将数据集随机划分为80%的训练集和20%的测试集。在每次交叉验证中,作者进一步从训练集中随机划分10%作为验证集。

2.2.2 2D CoNIC

2D CoNIC挑战数据集包含来自Lizard数据集[81]的图像,该数据集包括六个核类别(即“上皮细胞”、“结缔组织细胞”、“淋巴细胞”、“浆细胞”、“中性粒细胞”和“嗜酸性粒细胞”)和一个“背景”。

Lizard数据集[79],[81],[101]中的每个原始图像都有一个地面真实标签,包含实例图、核类别、边界框分割掩模和核计数的信息。在作者的实验中,作者使用分割掩模进行图像分割,并仅区分前景对象“核”和“背景”,从而形成一个如[78]所示的二值分割任务。

数据集提供4,981个RGB格式的图像补丁,大小为256×256。遵循先前研究[104]–[106],作者将所有图像随机划分为80%的训练集和20%的测试集。在每次交叉验证中,作者进一步从训练集中随机划分10%作为验证集。

2.2.3 3D KiTS19

KiTS19数据集提供了210个高质量的注释3D腹部计算机断层扫描图像,包括三个类别:“肾脏”、“肿瘤”和“背景”。

给定图像中的肾脏和肿瘤位置相对固定。在作者的实验中,作者遵循常用的二值分割设置[80],[107],[108]:

- 设置-i) 前景“肾脏”和“背景”;

- 设置-ii) 前景“肿瘤”和“背景”。

尽管KiTS19提供了其他人体结构(例如输尿管、动脉和静脉),但它们不在需要分割的范围内,统一被视为背景。KiTS19中的每个图像及其对应的地面真实掩模以NIFTI格式提供,包括切片数量(平均216个切片)、高度(512)和宽度(512)。

为确保地面真实质量,作者遵循先前研究[80],[109]并从原始数据集中移除了案例15、23、37、68、125和133,留下204个案例用于训练和测试。

在每次交叉验证中,作者按照[80],[107]的做法,从训练集中随机划分10%作为验证集。尽管数据集的官方网站提供了额外的90个测试案例,但地面真实掩模未公开访问,因此作者从实验中排除了这些案例。

2.2.4 3D LiTS

肝癌是一种常见肿瘤,主要影响男性[67],[110],[111]。

为推进病变的自动分割,LiTS提出了一个基于对比增强腹部计算机断层扫描的基准。LiTS包含130个训练扫描和70个测试扫描,图像最初以PNG格式提供,空间大小为256×256。

每个图像包含两个类别:“背景”和“肝脏”。作者按照[112],[113]将肿瘤区域和肝脏区域视为等同。

在训练期间,所有图像被裁剪到200×200的空间大小。在每次交叉验证中,作者按照[111]的做法,从训练集中随机划分10%作为验证集。

2.3 实验设置平台

本文的所有实验均使用PyTorch深度学习平台[114]进行,配备NVIDIA GeForce RTX 2080 GPUs。为最小化潜在的编码错误,作者利用PyTorch的官方函数执行必要操作,包括基本操作、损失计算和指标计算。

主干网络

鉴于数据集大小和网络成熟度,作者采用广泛认可的ResNet-50[18]作为默认主干网络,该网络遵循全卷积网络架构的经典实现[17],[115],[116]。

主干网络的输入端采用了如图1 (a)所示的原始累积卷积方法。

(a) 原始实现方案:

- 原始的ResNet实现在输入干部分使用了一层(7 \times 7)的卷积层,后面跟着一个步长(stride size)为2的最大池化层(MaxPooling)。这种配置在ResNet的论文中被提出,并在随后的研究中广泛使用。

(b) 修改后的实现方案:

- 修改后的实现方案用三个(3 \times 3)的卷积层代替了原始的(7 \times 7)卷积层。这种修改可以减少计算量,因为(3 \times 3)卷积层的参数更少,计算复杂度更低。

- 这三个(3 \times 3)卷积层后面同样跟着一个步长为2的最大池化层。

- 这种修改后的实现方案虽然与原始方案不同,但据文中所述,它可以显著提高准确性。

“S” 表示步长:

- 在卷积神经网络中,步长(stride)是指卷积核移动的像素数。步长为2意味着卷积核每次移动两个像素,这会减少输出特征图的空间尺寸。

“×2” 表示块重复次数:

- 这表示修改后的实现方案中,三个(3 \times 3)卷积层的组合被重复两次。这种重复可以进一步提取特征,同时保持计算成本在可接受的范围内。

总的来说,Fig. 1展示了通过调整输入干的卷积层配置来平衡计算成本和模型性能的一种有效方法。这种修改在实际应用中可能更为常见,因为它提供了一种在保持性能的同时减少计算资源消耗的策略。

评估指标

作者采用常用的召回率、精确度、Dice系数[117]和交并比(IoU)作为主要评估指标[80],[108],[109],[118]。特别是,作者进行五折交叉验证以评估模型性能,并报告平均值结果。

2.3.1 2D-UNet的实施细节

遵循先前研究[102],[103],ISIC 2018[78]和CoNIC[79],[81],[101]的2D训练图像统一调整到200×200的固定输入大小,并使用ImageNet数据集[119]的均值和标准差进行归一化,如[60],[85],[120]所示。

初始学习率设置为0.0003。使用自适应矩估计[121]作为优化器,其中权重衰减设置为0.0005。

整个模型训练200个周期,批量大小为32,并使用验证集上最佳模型的 结果进行测试,如[59],[108]所示。

遵循[8],[67],作者采用常用的像素级交叉熵[122]损失作为默认损失函数。

2.3.2 3D-UNet的实施细节

遵循KiTS19[80]和LiTS[67]的常用实验设置[67],[80],[109]–[111],[118],[123],Hounsfield单位被剪辑到[−79, …, 304],并通过3.22 × 1.62 × 1.62 mm³的系数重新采样体素间距,如[59],[107],[108]所示。

作者对计算机断层扫描的横截面进行下采样,并重新采样以调整LiTS[67]的z轴间距为1mm。训练体素大小(补丁大小)设置为96 × 96 × 96,恰好适合NVIDIA GeForce RTX 2080 GPU。

使用随机梯度下降[124]作为优化器,其中动量设置为0.9,权重衰减设置为0.0001。初始学习率设置为0.01,批量大小设置为2。

模型以端到端的方式进行训练,共100个周期,并使用验证集上最佳模型的 结果进行测试,如[59],[108]所示。唯一使用的损失函数为交叉熵损失,如[123],[125]所示。

在推理阶段,作者执行以50%区域重叠的方式进行补丁式重叠(即48 × 48 × 48)。

三、方法和实验

在本研究中,作者将完整的MedISeg系统划分为六个阶段,每个阶段探索一组代表性的技巧。所有的实验都是使用第2.3节中描述的初步设置进行的,没有进行任何特定的修改。

3.1 预训练模型

预训练模型可以提供有利的参数[39],[126],但不同预训练模型的影响通常被忽视。

例如,当使用流行的ImageNet[119]预训练模型时,作者经常声称他们的网络是在ImageNet上预训练的,但没有指定具体的预训练实现。然而,在ImageNet上预训练可以有至少两种基本形式(即1k和21k版本),公平的结果比较需要详细的预训练实现解释。

为此,在本节中,作者探索了在MedISeg上常用的六种公共预训练权重。这些预训练权重可以分为以下两大类:

- 全监督(即PyTorch官方权重[114]和面向模型的ImageNet-1k/21k权重[119])

- 自监督(即SimCLR权重[127],MoCo权重[128]和Model Genesis (ModelGe)权重[129])

3.1.1 PyTorch官方权重

在PyTorch仓库中,有一些由torchvision.models提供的骨干网络预训练权重[114]。

这些权重是通过在ImageNet-1k数据集[119]上对相应的骨干网络进行单标签图像分类任务训练获得的。

3.1.2 面向模型的ImageNet-1k权重

除了PyTorch官方权重外,模型创建者通常也会发布ImageNet[119]上的预训练权重。

例如,面向模型的ImageNet-1k权重可以通过在ImageNet-1k数据集上对ResNet-50[18]进行图像分类训练获得。

3.1.3 面向模型的ImageNet-21k权重

与ImageNet-1k[119]相比,ImageNet-21k是一个更通用和全面的版本,总共有约21,000个对象类用于图像分类。

因此,在ImageNet-21k上训练的权重也有利于下游任务[38],[39],[132]。

3.1.4 SimCLR权重

SimCLR[127]表明,通过特征表示之间的可学习非线性变换和对比学习损失可以改进特征表示[133],[134]。

为此,SimCLR主要包含三个步骤:

- 1)将输入图像分组为一些图像补丁;

- 2)对不同批次的图像补丁实施不同的数据增强策略;

- 3)训练模型以获得相同图像补丁的不同增强结果的相似结果,并排除其他结果。

在作者的工作中,使用在ImageNet-1k[119]上进行分类训练的SimCLR权重[18]。

3.1.5 MoCo权重

MoCo[128]是经典的自监督对比学习方法之一,它旨在解决内存银行中采样特征不一致的问题[135],[136]。为此,MoCo使用队列来存储和采样负样本;

也就是说,它存储用于训练的多批次特征向量。在其实现中,固定网络保持不变,并在骨干网络的末尾添加一个线性层和softmax层进行无监督训练方式的分类。

在作者的工作中,作者使用在ImageNet-1k[119]上进行ResNet-50[18]分类训练的MoCo权重。

3.1.6 ModelGe权重

ModelGe[129]是一种先进的自监督模型预训练技术,通常包含四个变换操作(即非线性、局部像素打乱、外部填充和内部填充)用于CT和MRI图像的单图像恢复[137],[138]。

在其实现中,网络通过恢复原始图像补丁来学习通用的视觉表示,其中变换操作的权重设置为非线性0.9,局部像素打乱0.5,外部填充0.8,内部填充0.2,遵循[139]–[141]。

基于训练的模型,获得的训练权重可以作为下游模型的预训练权重。

3.1.7 实验结果

在表1中,作者展示了不同预训练权重对医学图像分割(MedISeg)模型性能的影响。

表格列出了使用2D-UNet作为基线模型在ISIC 2018和CoNIC数据集上的实验结果,以及使用3D-UNet在KiTS19数据集上的实验结果。

-

预训练权重来源:

- PyTorch: 指的是PyTorch官方提供的预训练权重。

- Imag-1k: 指在ImageNet-1k数据集上训练得到的模型权重。

- Imag-21k: 指在ImageNet-21k数据集上训练得到的模型权重,这个数据集比1k版本更大,包含更多的类别。

- SimCLR: 代表使用SimCLR方法得到的自监督学习预训练权重。

- MOCO: 代表使用MOCO方法得到的自监督学习预训练权重。

- ModelGe: 是一种先进的自监督模型预训练技术得到的权重。

-

性能指标:

表格中列出了以下性能指标:- Recall(召回率):正确预测为正的样本占实际为正的样本的比例。

- Precision(精确度):正确预测为正的样本占预测为正的样本的比例。

- Dice(Dice系数):衡量两个样本集合相似度的一种指标,常用于医学图像分割。

- IoU(交并比):预测的分割区域与真实分割区域之间的交集与并集的比例。

-

实验结果分析:

- 对于2D-UNet在ISIC 2018数据集上,使用ImageNet-21k预训练权重(Imag-21k)在所有指标上都带来了最大的性能提升。

- 在CoNIC数据集上,ImageNet-21k预训练权重同样带来了显著的性能提升,特别是在Dice和IoU指标上。

- 对于3D-UNet在KiTS19数据集上,ModelGe预训练权重在设置-ii上带来了性能提升,但在设置-i上性能有所下降。

-

微调(Fine-tuning):

- 表格中的“+”表示在相应的预训练权重基础上进行了微调。微调是指在预训练模型上进一步训练,以适应特定的下游任务。

-

结论:

- 不同的预训练权重对模型性能有不同的影响。一般来说,更大规模的数据集(如ImageNet-21k)训练得到的权重能带来更好的迁移学习能力。

- 自监督学习方法(如SimCLR和MOCO)也显示出了其在医学图像分割任务中的潜力。

- 特定的预训练权重(如ModelGe)可能在某些特定任务或数据集上表现更好,这可能与权重是如何预训练的以及它们与下游任务的相关性有关。

表1强调了预训练权重选择的重要性,并表明适当的预训练可以显著提高医学图像分割任务的性能。

表2展示了在3D LiTS数据集上,使用3D-UNet基线模型并结合ModelGe预训练权重进行微调的实验结果。

-

数据集: 3D LiTS数据集是一个用于医学图像分割的公共数据集,专注于肝脏肿瘤的分割。

-

预训练权重: "ModelGe"指的是模型创世纪(Model Genesis)[129]预训练权重,这是一种自监督学习方法得到的权重,旨在改善模型对医学图像的泛化能力。

-

微调(Fine-tuning): 表中的“+”表示在ModelGe预训练权重的基础上对3D-UNet基线模型进行了微调。微调是一种迁移学习技术,通过在特定任务的数据集上继续训练预训练模型,以提高模型在该任务上的性能。

-

性能指标:

- Recall(召回率): 表示模型正确识别的正样本占所有实际正样本的比例。

- Precision(精确度): 表示模型正确识别为正的样本占所有模型预测为正的样本的比例。

- Dice(Dice系数): 是一种衡量两个样本集合相似度的指标,常用于评估图像分割任务的性能。

- IoU(交并比): 表示预测的分割区域与真实分割区域的交集与并集的比例,是评价分割精度的常用指标。

-

实验结果:

- 在使用ModelGe预训练权重微调后,3D-UNet模型在LiTS数据集上的性能有所提升。具体来说,Recall提升了1.21%,Precision提升了0.63%,Dice提升了0.88%,IoU提升了1.23%。

- 这些提升表明ModelGe预训练权重对于3D-UNet模型在肝脏肿瘤分割任务上是有效的,能够提高模型的分割精度和鲁棒性。

-

结论:

- 表2的实验结果强调了预训练权重在医学图像分割中的重要性。选择合适的预训练权重并进行微调可以显著提高模型的性能。

- 对于3D医学图像分割任务,ModelGe预训练权重是一个有益的选择,可以作为提高模型性能的策略之一。

通过表2的数据,我们可以了解到在特定的3D医学图像分割任务中,使用特定的预训练权重进行微调可以带来性能上的提升,这对于模型的优化和实际应用具有重要意义。

3.2 数据预处理

由于3D医学图像具有特定的数据特性(例如模态和分辨率),因此需要进行预处理以实现满意的分割性能[145],[146]。

在本研究中,作者探讨了3D-UNet[77]中四种常用图像预处理技术的有效性:

- 补丁化[147]

- 过采样(OverSam)[148]

- 重新采样(ReSam)[149]

- 强度归一化(IntesNorm)[108]

3.2.1 补丁化

一些医学图像,如MRI[150]和病理图像[147],在空间尺寸上可能非常大,且缺乏足够的训练样本,这使得直接在这些图像上训练MedISeg模型变得不切实际[151],[152]。

因此,常见的方法是将整个图像重新采样为不同空间尺度的小图像补丁,有无重叠均可。这种方法可以减少GPU内存需求,并使模型训练更加有效。

补丁大小是影响模型性能的最关键因素之一。在作者的工作中,遵循3D-UNet[59],[108]的实验设置,作者将训练补丁大小设置为96×96×96,无重叠,并在推理阶段将补丁大小设置为96×96×96,有50%的区域重叠。

3.2.2 过采样

过采样[148]旨在解决少数类中正负样本之间不平衡的问题[153]。

目前,已提出了一系列过采样方案,包括随机过采样[148],合成少数过采样(SMOTE)[154],边界线SMOTE[155],以及自适应合成采样[156]。

之前的实验结果表明,过采样不会影响模型的斜率,但可以放大模型的截距[157],[158]。在作者的工作中,作者采用了[108]中提出的流行的过采样方案,其中70%的选定训练样本来自随机图像位置,30%的图像补丁保证至少包含一个前景类。

这样,每个训练样本可以同时包含一个前景图像补丁和一个随机图像补丁。

3.2.3 重新采样

重新采样[149]旨在提高所使用数据集的代表性。

由于可用样本的能力有时有限且异构,通过随机/非随机的重新采样策略可以获得更好的子样本数据集[159],[160]。

在其实施中,重新采样主要包括四个步骤:

1、间距插值;

2、窗口变换;

3、获取遮罩有效范围;

4、生成子图像。

基于重新组织的子样本数据集,可以训练出表现更好的识别模型[149],[161]。在作者的基线实现中,已使用了常用的随机重新采样策略。

为了展示其对MedISeg的重要性,在本节中,作者通过移除重新采样策略(即/o)来探索其效果,即图像像素直接插值和缩放,使得像素实际表示的距离相同。

3.2.4 强度归一化

强度归一化[162]是针对医学图像的特定归一化策略[163],[164]。

通常有两种常用的强度归一化方法:

- 对所有模态使用z-scoring

- 对计算机断层扫描图像使用另一种方法[108]

在作者的工作中,作者主要通过移除强度归一化(即/o)来探讨其在KiTS19[80]上的有效性。遵循常见的实现[108],[162],本文采用了全局归一化方案,其中0.5%的前景体素用于裁剪和计算前景均值,99.5%的前景体素用于计算标准差。

3.2.5 实验结果

表3展示了在3D医学图像分割中,数据预处理技巧对于模型性能的影响。

这里列出了两种不同的实验设置(setting-i和setting-ii),并且对每种设置下不同预处理技巧的效果进行了比较。

-

预处理技巧:

- OverSam (Oversampling): 过采样,用于解决类别不平衡问题,通过增加少数类的样本数量来改善模型性能。

- ReSam (Resampling): 重采样,用于改善数据集的表示能力,通过随机或非随机策略获取更好的子样本集。

- IntesNorm (Intensity normalization): 强度归一化,一种针对医学图像的特定归一化策略,用于调整图像的强度分布。

-

实验设置:

- Setting-i和Setting-ii: 这两种设置代表了不同的分割任务或不同的数据集特点。具体的设置细节在文中section 2.2中介绍。

-

性能指标:

- 表格列出了Recall(召回率)、Precision(精确度)、Dice(Dice系数)和IoU(交并比)这四个性能指标,用于评估分割模型的效果。

-

实验结果:

- 3D-UNet: 基线模型在没有应用任何预处理技巧时的性能。

- Patching: 不同的patching大小对于模型性能有不同的影响。较大的patching大小通常能带来更好的性能,但当patching大小过小时(如32),模型性能会显著下降,甚至出现模型损坏(NaN)。

- OverSam: 在某些情况下,OverSam能够提升模型性能,尤其是在setting-ii上,Recall和IoU有显著提升。

- ReSam: 重采样对于模型性能至关重要,尤其是在setting-ii上,不使用ReSam会导致模型性能大幅下降。

- IntesNorm: 强度归一化对于setting-i的影响较小,但在setting-ii上,不使用IntesNorm会导致性能下降。

-

结论:

- 数据预处理技巧对于3D医学图像分割模型的性能有显著影响。选择合适的预处理方法可以提升模型的准确性和鲁棒性。

- 表中的结果表明,没有一种预处理技巧在所有情况下都是最优的,其效果依赖于具体的实验设置和数据集特性。

- 某些预处理技巧在特定条件下可能不会带来性能提升,甚至可能导致模型损坏,因此在实际应用中需要仔细选择和调整预处理步骤。

表3强调了在医学图像分割任务中,细致的数据预处理是实现高性能模型的关键步骤之一。通过这些实验结果,研究者可以更好地理解不同预处理技巧的作用,并为未来的模型设计和实验设置提供指导。

表4提供了在3D LiTS数据集上,针对数据预处理技巧的实验结果。

- 实验设置:

- 表中展示了不同预处理技巧对模型性能的影响,包括在3D LiTS数据集上的应用效果。

- 性能指标:

- 表格列出了Recall(召回率)、Precision(精确度)、Dice(Dice系数)和IoU(交并比)这四个性能指标。

- 实验结果分析:

- Patching: 展示了不同尺寸的patching对模型性能的影响。结果表明,增加patching大小通常可以提高模型性能,例如,Patching192相比于Patching96在Dice和IoU上有所提升。

- OverSam: 过采样在LiTS数据集上对模型性能有正面影响,尤其是在Precision上,提高了3.52%。

- ReSam: 重采样对模型性能至关重要,不使用ReSam时,模型性能显著下降,如ReSam列的Precision和IoU出现了大幅度下降。

- IntesNorm: 强度归一化对模型性能的影响相对较小,但在某些情况下,如不使用IntesNorm,模型的Recall和IoU有所下降。

- 结论:

- 数据预处理是提高医学图像分割模型性能的关键步骤。不同的预处理技巧对模型性能有不同的影响,选择合适的预处理方法可以显著提升模型的准确性和鲁棒性。

- 表4的结果强调了在医学图像分割任务中,细致的预处理和模型调整的重要性。研究者可以根据这些结果来优化自己的模型和实验设置。

通过表4的数据,我们可以了解到在3D LiTS数据集上,适当的数据预处理技巧如过采样和重采样可以显著提高模型的性能,而强度归一化虽然影响较小,但在某些情况下也是必要的。此外,不恰当的预处理或缺少关键步骤可能会导致模型性能下降或损坏。

作者观察到,与基线模型相比,预处理操作在设置-ii上的影响比对设置-i上的影响更敏感。具体来说:

1、更大的补丁化大小导致整体模型性能更好。

当补丁化大小相对较小(例如,32)时,分割模型在KiTS19[142]和LiTS[67]上都出现了损坏。当补丁化大小设置为192时,KiTS19[142]上的模型在设置-ii上实现了最佳性能。

LiTS[67]上的实验结果表明,随着补丁化大小的增加,模型性能逐渐提高。尽管在Patching192下,与基线性能相比,设置-i上的模型性能略有下降,但这源于图像尺度的实验设置,而不是补丁化方案[108]。

这一实验现象与[59],[108]中的先前论文的结论一致,即建议使用尽可能大的图像补丁大小,以适应GPU内存。

2、OverSam[153],[156]提高了整体模型性能。

特别是,在KiTS19[142]上,OverSam带来了显著的性能提升,在设置-i上提高了0.84%的召回率、0.43%的Dice系数和0.73%的交并比,在设置-ii上提高了9.11%的召回率、6.98%的精确度、6.06%的Dice系数和5.05%的交并比。

3、在KiTS19[142]和LiTS[67]上,不使用ReSam会导致模型性能显著下降。

例如,在KiTS19上,模型可能会导致设置-i上的性能下降90.83%的召回率、69.71%的精确度、92.15%的Dice系数和87.17%的交并比。令人惊讶的是,在设置-ii上,如果没有使用ReSam,模型将完全损坏。

4、在KiTS19上,强度归一化对结果的影响相对较弱。

例如,在没有使用强度归一化的情况下,基线3D-UNet[77]仅在设置-i上减少了最大模型性能0.78%的召回率、0.30%的Dice系数和0.70%的交并比,在设置-ii上减少了0.20%的召回率和0.00%的Dice系数。

然而,强度归一化对LiTS[67]上的实验结果有显著影响。这一现象表明,对于数据预处理策略,相同的方法在不同数据集上具有不同的影响。

3.3 数据增强

数据增强用于解决训练样本不足和过拟合的问题[166]–[170]。特别是在医学图像中,数据增强经常被使用[171],[172]。

MedISeg中使用的数据增强方案可以广泛地分为两大类:

- 基于几何变换的数据增强(GTAug)[167]

- 基于生成对抗网络(GAN)的数据增强(GANAug)[169]。

3.3.1 GTAug

为了消除训练图像中几何对象变化的影响,如位置、尺度和视角度,作者采用了GTAug[167]。

GTAug是一种广泛使用的数据增强方法,包括翻转、裁剪、旋转、平移、颜色抖动、对比度、低分辨率模拟、高斯噪声注入、图像混合、随机擦除、高斯模糊、混洗和裁剪混合[59],[166],[168],[170]。

在作者的工作中,作者选择了几种常用的数据增强方法,包括:

- 随机亮度对比(亮度限制=0.2,对比度限制=0.2,概率p=0.5)

- 随机伽马(伽马限制=(80, 120),概率p=0.5)

- CLAHE

- 随机噪声(概率p=0.5)

- 伽马调整(概率p=0.5)

- 位移缩放旋转(位移限制=0.1,缩放限制=0.1,旋转限制=45,概率p=0.5)

- 水平翻转(概率p=0.5)

- 垂直翻转(概率p=0.5)

- 随机缩放([0.85, 1.25])

- 随机旋转([90, 180, 279])

- 在MedISeg模型中对X、Y、Z轴方向的随机镜像

作者将上述数据增强方案分为两组,并实现两种类型的数据增强,命名为GTAug-A(即像素级变换)和GTAug-B(即空间级变换)。

具体来说,对于2D-UNet[44]的实验,作者在GTAug-A中使用随机亮度对比、随机伽马和CLAHE,在GTAug-B中使用位移缩放旋转、水平翻转和垂直翻转。

所有方案均使用其默认参数。对于3D-UNet[77]的实验,作者在GTAug-A中使用随机噪声和伽马调整,在GTAug-B中使用随机缩放、随机旋转和随机镜像,所有方案均使用其默认参数。

3.3.2 GANAug

数据增强的本质是引入领域知识或其他增量信息到训练数据集中[174]–[176]。

从这个角度来看,GANAug可以被视为一种损失函数,专注于指导网络生成一些接近源数据集域的真实数据[120],[166]。

特别是,考虑到小数据集,生成模型GAN的分布拟合比判别模型更好。因此,GANAug适用于MedISeg任务[177],[178]。

在作者的工作中,使用经典的像素级图像到图像转换的带条件对抗网络[173]及其默认设置。

3.3.3 实验结果

表5展示了在2D-UNet模型上应用不同的数据增强方案对ISIC 2018和CoNIC数据集以及3D-UNet模型上应用在KiTS19数据集的性能影响。

-

数据增强类型:

- GTAug (Geometric Transformation-based Augmentation): 基于几何变换的数据增强,包括翻转、裁剪、旋转等操作,用于增加数据多样性,减少过拟合。

- GANAug (GAN-based Augmentation): 基于生成对抗网络(GAN)的数据增强,通过生成器网络产生新的训练样本。

- All: 表示在模型训练阶段同时使用了GTAug和GANAug。

-

性能指标:

- 表格列出了Recall(召回率)、Precision(精确度)、Dice(Dice系数)和IoU(交并比)这四个性能指标。

-

实验结果分析:

- 对于2D-UNet在ISIC 2018数据集上,使用GTAug-B(空间级变换)相比于基线模型在所有性能指标上都有显著提升。而GTAug-A(像素级变换)在Recall、Dice和IoU上略有下降,但Precision有所提升。这表明空间级变换对于2D图像的分割性能更为有益。

- 在CoNIC数据集上,GTAug-B同样在所有性能指标上都带来了提升,而GTAug-A则在大多数指标上没有带来提升或有所下降。

- 对于3D-UNet在KiTS19数据集上,情况有所不同。GTAug-B在某些设置下显著降低了性能,而GTAug-A和GANAug在某些情况下能够提升性能。这表明在3D数据上,数据增强的效果依赖于具体的数据集特性和分割任务。

-

结论:

- 数据增强是提高医学图像分割模型泛化能力的重要手段。不同的数据增强策略对2D和3D数据集的影响存在差异。

- 在2D数据集上,基于几何变换的数据增强(尤其是空间级变换)能显著提升模型性能。

- 在3D数据集上,选择合适的数据增强策略至关重要,不适当的数据增强可能会损害模型性能。

- 同时使用GTAug和GANAug并不一定带来性能提升,有时甚至可能降低性能,这表明在实际应用中需要仔细考虑数据增强方法的选择。

表5强调了在医学图像分割任务中,数据增强策略需要根据具体的数据集和任务特性来定制,以确保能够有效提升模型性能。同时,它也表明了对于不同的数据维度(2D与3D),数据增强的效果可能存在显著差异。

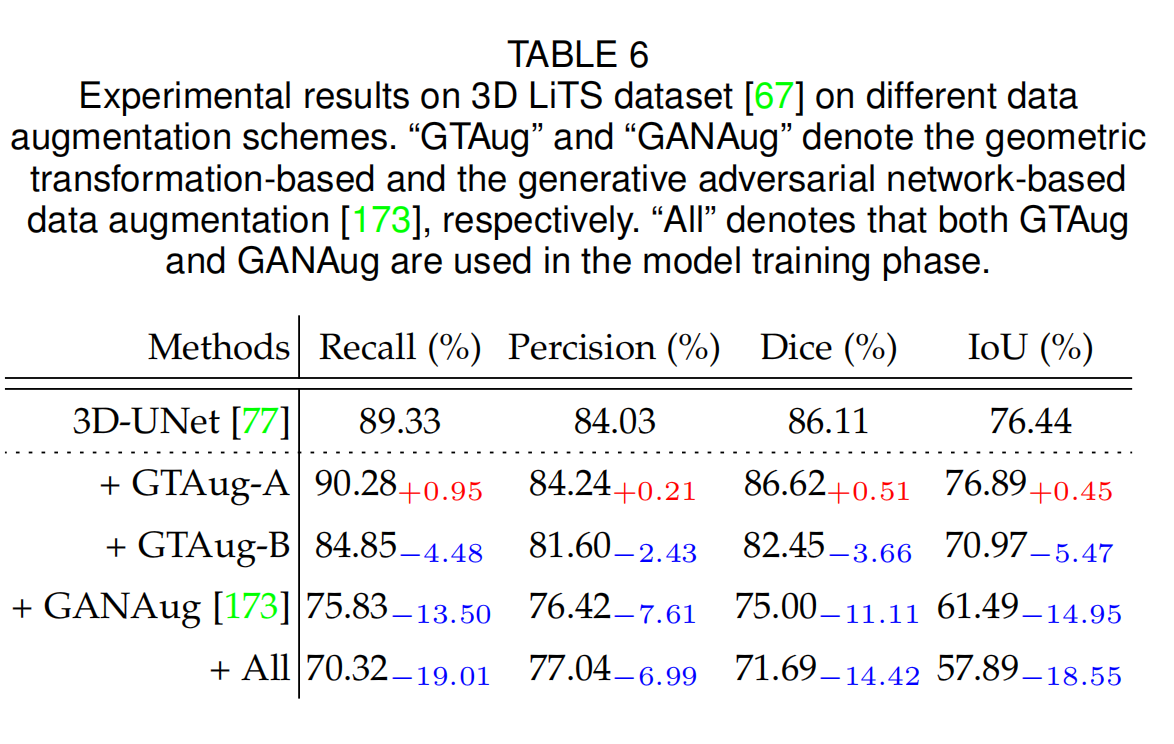

表6提供了在3D LiTS数据集上应用不同数据增强方案的实验结果。

-

数据增强类型:

- GTAug: 基于几何变换的数据增强,可能包括旋转、缩放、翻转等操作,用于增加数据的多样性。

- GANAug: 基于生成对抗网络的数据增强,通过生成器产生新的训练样本,以扩充数据集。

- All: 在模型训练阶段同时使用GTAug和GANAug。

-

性能指标:

- 表格列出了Recall(召回率)、Precision(精确度)、Dice(Dice系数)和IoU(交并比)这四个性能指标。

-

实验结果分析:

- 对于3D-UNet基线模型,在没有任何数据增强的情况下,其性能指标被列出作为比较的基准。

- GTAug-A: 应用GTAug后,在Recall上提升了0.95%,在Precision上提升了0.21%,在Dice上提升了0.51%,在IoU上提升了0.45%。

- GTAug-B: 应用GTAug后,所有性能指标都出现了下降,这表明这种几何变换的数据增强对模型性能有负面影响。

- GANAug: 应用GANAug后,性能指标显著下降,Recall下降了13.50%,Precision下降了7.61%,Dice下降了11.11%,IoU下降了14.95%。

- All: 当同时使用GTAug和GANAug时,性能指标进一步下降,这表明在3D LiTS数据集上,结合使用这两种数据增强方法并不是一个好的策略。

-

结论:

- 在3D LiTS数据集上,不是所有的数据增强方案都能提升模型性能。特别是GANAug,在这个数据集上导致了显著的性能下降。

- GTAug的效果则取决于具体的变换类型。在这种情况下,GTAug-A(可能代表一种特定的几何变换组合)对性能有正面影响,而GTAug-B则有负面影响。

- 结合使用GTAug和GANAug(All)并没有带来性能提升,反而导致了性能的进一步下降,这可能表明这两种方法的结合在这个特定的数据集上并不适用。

表6强调了在选择数据增强策略时需要考虑数据集的特定属性和任务需求。不同的数据增强方法可能对不同的数据集和任务有着不同的影响,因此在实际应用中需要谨慎选择和调整数据增强方案。

3.4 模型实现

医学图像分割(MedISeg)模型通常包含许多实现细节,这在当前的研究中尤为明显。

在本研究中,作者探讨了常用的实现技术的效果:

- 深度监督(DeepS)[179];

- 类平衡损失(CBL)[180],包括四种损失函数(即CBLDice [181]、CBLFocal [182]、CBLTvers [60]和CBLWCE [183]);

- 在线硬样本挖掘(OHEM)[184];

- 实例归一化(IntNorm)[100]

此外,由于近年来基于Transformer的方法在MedISeg中越来越受到关注,作者还在本节中展示了ViT [38]、MAE [185]和MoCo [186]的实验结果进行比较。

3.4.1 DeepS

DeepS [179]是一种辅助学习技术,最初在DSN [179]中提出,随后用于图像分类[187]。

这种技术旨在通过在直接或间接方式下在骨干网络的某些中间隐藏层上添加辅助分类器或分割器来监督骨干网络[47],[188]–[190]。它可以用于解决与训练梯度消失或收敛速度缓慢相关的问题。

对于图像分割,这种技术通常通过添加图像级分类损失来实现。在作者的工作中,作者遵循[188],[189],[191]并从最后三个解码器层提取特征图。

然后,作者使用一个1×1卷积层将病变掩码投影到相同的通道大小。通过双线性插值,不同层的输出特征图被上采样到与输入图像相同的空间大小,以供分割头网络使用[115],[190],[192]。

3.4.2 CBL

CBL [180]通常用于学习一个通用的类权重,即每个类的权重只与对象类别相关。

与一些传统的分割损失函数(如交叉熵损失)在类不平衡数据集上相比[179],[180],CBL可以提高模型的表征能力。在使用的数据集中,CBL通过引入有效样本数量来表示所选数据集的预期体积表示,并通过有效样本数量而不是原始样本数量来为不同类别加权。

在本论文中,作者主要探索了四种常用的CBL损失函数在医学图像领域类不平衡问题上的效果,包括:

- Dice损失(CBLDice)[181]

- Focal损失(CBLFocal)[182]

- Tversky损失(CBLTvers [60])

- 加权交叉熵损失(CBLWCE [183])

3.4.3 OHEM

OHEM [184]的核心思想是首先通过损失函数过滤掉一些硬学习样本(即图像、对象和像素),这些选定的硬例子对识别任务有重要影响[184]。

然后,这些样本应用于模型训练过程中的梯度下降。在不同的视觉任务上的广泛实验结果表明,OHEM不仅高效,而且在各种数据集上都表现良好[71],[72],[193],[194]。

在作者的工作中,作者验证了OHEM在2D和3D医学数据集上的有效性,并使用了其默认设置。

3.4.4 IntNorm

IntNorm [100]是一种流行的归一化算法,适用于对单个像素有更高要求的识别任务。

在其实现中,每个样本及其所有元素都考虑在内,以计算统计归一化[100],[195],[196]。在医学图像领域,IntNorm使用的一个重要原因是,在训练过程中通常将批量大小设置为一个小值(特别是对于3D图像),这使得批量归一化无效。

在本论文中,作者通过在3D实验中将IntNorm替换为强度归一化[108]来展示其效果。

3.4.5 Transformer-Based Methods

作者在实验中采用了ViT [38],MAE [185]和MoCo [186]。

ViT将输入图像分割成多个图像补丁,然后将每个补丁投影到一个固定长度的向量,并发送到Transformer层。解码器逐渐上采样获得的特征向量到与输入图像相同的大小进行预测。

基于ViT,MAE [185]首先随机遮挡补丁并在训练过程中尝试重建它们,这是一种典型的自监督学习方法。MoCo [186]也是一种基于ViT的无监督视觉表示学习方法。MoCo将对比学习与查找字典的过程相比较,并将字典视为一个队列并引入了动量更新的概念。

3.4.6 实验结果

表7展示了在2D-UNet和3D-UNet模型上应用不同模型实现技巧(tricks)的实验结果。

这些技巧包括深度监督(DeepS)、类别平衡损失(CBL)、在线硬例挖掘(OHEM)和实例归一化(IntNorm)。

-

模型实现技巧:

- DeepS (Deep Supervision): 深度监督,通过在网络的不同阶段添加辅助输出来增强模型的训练信号。

- CBL (Class Balance Loss): 类别平衡损失,用于处理类别不平衡问题,通过加权不同类别的损失来优化模型性能。

- OHEM (Online Hard Example Mining): 在线硬例挖掘,选择难以分类的样本进行重点学习,以提高模型的泛化能力。

- IntNorm (Instance Normalization): 实例归一化,一种归一化技术,用于调整和标准化输入数据的分布。

-

性能指标:

- 表格列出了Recall(召回率)、Precision(精确度)、Dice(Dice系数)和IoU(交并比)这四个性能指标。

-

实验结果分析:

- 对于2D-UNet在ISIC 2018数据集上,CBLDice和CBLTvers技巧带来了显著的性能提升,特别是在Dice和IoU指标上。而CBLFocal和CBLWCE技巧则导致性能下降。

- 在CoNIC数据集上,CBLDice同样带来了性能提升,而DeepS和OHEM技巧对性能的影响不大,CBLFocal和CBLWCE技巧再次导致性能下降。

- 对于3D-UNet在KiTS19数据集上,CBLDice和CBLTvers技巧在某些设置下能显著提升性能,而CBLFocal技巧导致性能大幅下降。OHEM技巧在所有设置下都能小幅提升性能。

-

技巧适用性:

- 某些技巧在2D数据集上表现良好,但在3D数据集上可能效果不佳。这表明不同维度的数据集可能需要不同的处理方法。

- 深度监督(DeepS)在2D数据集上的性能提升较小,而在3D数据集上的某些设置中性能下降,表明该技巧可能不适用于所有情况。

-

结论:

- 模型实现技巧对于提升医学图像分割模型的性能具有重要作用。然而,并非所有技巧在所有情况下都有效,需要根据具体的数据集和任务特性来选择适当的技巧。

- 类别平衡损失(CBL)在处理类别不平衡问题时特别有效,但不同类型的CBL损失函数对性能的影响也有所不同。

- 实例归一化(IntNorm)在3D-UNet模型上的应用导致了性能的显著下降,这可能表明归一化方法需要根据数据集的特性进行调整。

表7强调了在医学图像分割任务中,细致地选择和调整模型实现技巧的重要性,以及在不同数据集上进行实验验证的必要性。通过这些实验结果,研究者可以更好地理解不同技巧的作用,并为未来的模型设计和实验设置提供指导。

结果显示,在2D数据集上实现这些技巧比在3D数据集上带来更大的精度提升。例如,在2D-UNet [44]上实现DeepS [179],CBLDice [181],和CBLTvers [60]可以显著提高ISIC 2018 [78]模型的性能。

然而,其他技巧如+CBLFocal,+CBLWCE,和+OHEM [184]在大多数评估指标上导致2D数据集上的模型性能下降。这些观察和结论对于2D-UNet [44]在ISIC 2018 [78]和CoNIC [79]上都适用。

值得注意的是,这些技巧最初是为2D数据集设计的,并在2D数据集上进行了验证,这解释了为什么它们在3D数据集上表现不佳。

表8提供了在3D LiTS数据集上,针对几种模型实现技巧的实验结果。

- 模型实现技巧:

- DeepS: 深度监督,通过在网络的多个层次上添加辅助输出来增强训练信号。

- CBL: 类别平衡损失,用于处理类别不平衡问题,通过调整不同类别的损失权重来优化模型。

- OHEM: 在线硬例挖掘,选择难以正确分类的样本进行重点学习,以提高模型性能。

- IntNorm: 实例归一化,一种数据预处理方法,用于调整样本的分布。

- 性能指标:

- 表格列出了Recall(召回率)、Precision(精确度)、Dice(Dice系数)和IoU(交并比)这四个性能指标。

- 实验结果分析:

- 在3D LiTS数据集上,使用3D-UNet基线模型的性能被列出作为参考。

- DeepS技巧在Dice指标上带来了小幅度的提升,在Recall上也有提升,但在Precision上没有变化。

- OHEM技巧在大多数性能指标上都带来了提升,特别是在IoU上。

- IntNorm技巧在这个数据集上的表现不佳,导致大部分性能指标的显著下降。

- 结论:

- 深度监督(DeepS)和在线硬例挖掘(OHEM)技巧在3D LiTS数据集上通常是有益的,能够提升模型的分割性能。

- 类别平衡损失(CBL)的效果取决于所使用的具体损失函数,不同的CBL变体对性能的影响各不相同。

- 实例归一化(IntNorm)在这个实验中似乎并不适合3D LiTS数据集,导致了性能的下降。这可能表明归一化方法需要根据数据集的特性进行选择和调整。

表8强调了在医学图像分割任务中,不同的模型实现技巧对性能有显著影响,但它们的效果依赖于具体的数据集和任务。选择合适的技巧可以显著提升模型性能,而不恰当的选择则可能导致性能下降。因此,在实际应用中,需要根据具体情况进行实验验证和技巧选择。

表9展示了基于Transformer的方法在2D ISIC 2018和CoNIC数据集上的实验结果,以及不同多头注意力机制(multi-head attention mechanism)中头(heads)的数量对性能的影响。

-

Transformer-based 方法:

- 表格中列出了几种基于Transformer的方法,包括Vision Transformer (ViT)、Masked Autoencoders (MAE) 和 MoCo v3。这些方法利用了多头注意力机制来处理图像数据。

-

多头注意力机制的头数:

- 表中的"/16"和"/32"表示多头注意力机制中使用的头的数量。头数是Transformer模型中并行处理信息流的数量,可能会影响模型的性能。

-

性能指标:

- 表格列出了Recall、Precision、Dice和IoU这四个性能指标,用于评估不同Transformer-based方法在图像分割任务上的效果。

-

实验结果分析:

- ViT-B/16和ViT-L/16分别表示使用基础(B)和大型(L)模型尺寸的Vision Transformer,且具有16个头。结果表明,这些模型在ISIC 2018和CoNIC数据集上的性能低于2D-UNet基线模型。

- ViT-B/32和ViT-L/32表示相应的模型使用了32个头。增加头数似乎并没有显著提高性能,反而在某些情况下导致了性能下降。

- ViT-B/16-MAE和ViT-B/32-MAE表示在ViT的基础上应用了MAE技术,结果表明,MAE技术并没有显著提升性能。

- ViT-B/16-MoCo v3和ViT-B/32-MoCo v3表示在ViT的基础上应用了MoCo v3技术,这些模型的性能同样低于2D-UNet基线模型。

-

结论:

- 在这些实验中,基于Transformer的方法在医学图像分割任务上的表现没有超过传统的2D-UNet模型。这可能是由于Transformer模型在小数据集上的性能受限,或者是因为它们缺乏对医学图像分割任务的特定领域知识。

- 多头注意力机制中头的数量增加并没有带来预期的性能提升,这表明可能需要进一步调整Transformer模型的架构或训练策略,以适应医学图像分割的特定需求。

- 实验结果强调了在采用新型模型架构进行医学图像分割任务时,需要仔细考虑模型的适应性和数据集的特点。

表9中展示的实验结果表明,基于Transformer的方法在ISIC 2018 [78]和CoNIC [81]上的性能显著低于基于CNN的方法。这可能是因为Transformer模型缺乏足够的先验知识,并且训练数据集的数据量不足。

在医学图像中,目标位置相对一致,使得先验知识在MedISeg中至关重要。此外,Transformer模型通常具有比其CNN对应物更多的参数,需要更多的数据来优化它们。

这些发现强调了在MedISeg中考虑可用数据量或修改现有Transformer模型以实现满意结果的重要性。

3.5 模型推理

在本研究中,作者主要探索了两种常用的推理技巧,即:

- 测试时间增强(TTA)

- 模型集成(Ensemble)

3.5.1 TTA

TTA可以在不训练的情况下提高性能,因此它具有即插即用的潜力。同时,它可以提高模型的校准能力,这对于视觉任务是有益的[198],[199]。

在本工作中,作者遵循第3.3节中相同的数据增强策略,从三个方面实施TTA策略:

- 在基线模型上实施TTA策略(即TTAbaseline)。

- 在基线模型上实施与GTAug-A相同的测试时间增强GTAug-A(即TTAGTAug-A)。

- 在基线模型上实施与GTAug-B相同的测试时间增强GTAug-B(即TTAGTAug-B)。

3.5.2 Ensemble

常用的模型集成方法包括投票、平均、堆叠和非交叉堆叠(混合)[116],[197]。

在本工作中,作者首先独立地进行5次带有不同随机种子(即2022-2026)的训练集,获得5个不同的模型。

然后,作者选择常用的投票和平均作为模型集成策略,分别称为EnsVot和EnsAvg。

3.5.3 实验结果

表10展示了在2D-UNet和3D-UNet模型上应用不同的模型推理技巧(model inference tricks)的实验结果。

这些技巧包括测试时增强(Test Time Augmentation, TTA)和模型集成(model ensemble)。

-

模型推理技巧:

- TTA (Test Time Augmentation): 在测试阶段对输入图像进行数据增强,以提高模型的泛化能力和性能。

- Ensemble: 模型集成,通过结合多个模型的预测来提高整体性能。表格中提到了两种集成策略:平均(EnsAvg)和投票(EnsVot)。

-

TTA的变体:

- TTAbaseline: 在基线模型上应用TTA,不使用特定的数据增强策略。

- TTAGTAug-A: 在TTA中应用了特定的数据增强策略GTAug-A。

- TTAGTAug-B: 在TTA中应用了特定的数据增强策略GTAug-B。

-

性能指标:

- 表格列出了Recall、Precision、Dice和IoU这四个性能指标。

-

实验结果分析:

- 对于2D-UNet在ISIC 2018数据集上,所有TTA技巧都提高了模型性能,其中TTAGTAug-B表现最佳,而TTAbaseline表现最差。集成策略EnsAvg和EnsVot也带来了性能提升。

- 在CoNIC数据集上,观察到类似的结果,TTA技巧和集成策略均提高了性能,其中TTAGTAug-B和EnsAvg表现更好。

- 对于3D-UNet在KiTS19数据集上,TTA技巧并没有显著提高性能,甚至在某些情况下导致了性能下降。然而,集成策略EnsAvg和EnsVot仍然提高了性能。

-

结论:

- 在2D数据集上,测试时增强和模型集成策略通常能够提高医学图像分割模型的性能,特别是TTAGTAug-B和EnsAvg。

- 在3D数据集上,TTA技巧的效果并不一致,可能与数据集的特性或所选的数据增强策略有关。然而,模型集成仍然是提高性能的有效手段。

- “All”表示同时使用了TTAGTAug和相应的模型集成策略,在某些情况下这可以进一步提高性能,但并不总是最佳选择。

表10强调了在实际应用中,根据具体的数据集和任务需求选择合适的推理技巧的重要性。同时,它也表明了模型集成是一种强大的技术,可以稳定地提高模型的预测性能。

表11展示了在3D LiTS数据集上,使用不同的模型推理技巧(model inference tricks)对3D-UNet模型性能的影响。

-

实验结果分析:

- 对于3D-UNet模型,TTA技巧在大多数情况下降低了模型的性能,尤其是在TTAGTAug-B的情况下,性能下降最为明显。

- 模型集成策略EnsAvg和EnsVot在所有情况下都提高了模型的性能,尽管提升幅度不大。

- 当同时使用TTA和模型集成策略(“All”)时,性能提升不如仅使用模型集成策略明显。

-

结论:

- 在3D LiTS数据集上,测试时增强(TTA)技巧并没有带来预期的性能提升,反而在某些情况下导致了性能下降。

- 模型集成策略,特别是平均(EnsAvg)和投票(EnsVot)策略,能够稳定地提高模型的分割性能。

- 结合使用TTA和模型集成策略(“All”)并没有带来额外的性能提升,这可能表明在特定情况下,TTA技巧并不适合与模型集成联合使用。

表11的数据表明,在3D医学图像分割任务中,模型集成是一种有效的性能提升手段,而测试时增强的使用需要谨慎考虑,以避免潜在的性能下降。此外,实验结果还强调了在不同数据集上验证不同技巧的重要性,因为一种技巧在一个数据集上有效,可能在另一个数据集上效果不佳。

3.6 结果后处理

后处理操作旨在通过非可学习方法来增强模型性能。例如,分割结果可以通过整合全局图像信息进行优化。

在本论文中,作者探讨了医学图像分析中两种常用的后处理方案:

- 去除最大面积以外的所有组件(ABL-CS)[202]

- 去除小区域(RSA)[203]。

3.6.1 ABL-CS

ABL-CS [202]旨在根据生物体的物理属性去除分割结果中的某些错误区域。例如,对于心脏分割任务,作者都知道每个人只有一个心脏,因此如果分割得到的掩模中有小面积区域,作者需要移除这些小面积区域[205]。

3.6.2 RSA

对于MedISeg,成像协议通常保持不变,因此每个实例分割掩模的区域也保持不变。

基于这一物理属性,作者可以设置一个像素级阈值来移除某些过小的实例掩模(即低于给定阈值的掩模)[203]。在作者的工作中,遵循[206],[207],设置阈值为5000对于设置-i,80对于设置-ii,120对于ISIC 2018 [78],10对于CoNIC [79]和LiTS [67]。

这意味着所有小于此阈值的掩模在最终结果中被排除。

3.6.3 实验结果

表12提供了在2D-UNet和3D-UNet模型上应用后处理技巧的实验结果。

这些后处理技巧包括最大连通组件抑制(ABL-CS)和移除小面积(RSA)。

-

后处理技巧:

- ABL-CS (All-But-Largest-Component-Suppression): 这种策略旨在抑制所有非最大的连通组件,通常用于改善分割结果中的小错误区域。

- RSA (Remove Small Area): 这种策略通过移除低于某个阈值的小面积来后处理分割结果,以消除可能的错误预测。

-

性能指标:

- 表格列出了Recall(召回率)、Precision(精确度)、Dice(Dice系数)和IoU(交并比)这四个性能指标。

-

实验数据集:

- 2D-UNet: 应用于ISIC 2018和CoNIC数据集。

- 3D-UNet: 应用于KiTS19数据集的两种设置(settings-i和settings-ii)。

-

实验结果分析:

- 对于2D-UNet在ISIC 2018数据集上,ABL-CS提升了Precision、Dice和IoU,但略微降低了Recall。RSA对Dice和IoU有小幅提升,但对Recall和Precision影响不大。

- 在CoNIC数据集上,ABL-CS由于数据集特性没有应用,RSA的结果是性能指标几乎没有变化。

- 对于3D-UNet在KiTS19数据集上,ABL-CS在两种设置下都提升了Precision,但在settings-i上略微降低了Recall和IoU,在settings-ii上则没有显著变化。RSA在settings-i上提升了Precision,但在settings-ii上对性能指标几乎没有影响。

-

结论:

- 后处理技巧可以对模型的最终性能产生影响,尤其是在需要改进分割结果的精度时。

- ABL-CS和RSA在不同的数据集和设置下表现不同,表明这些技巧的效果依赖于具体的应用场景和数据特性。

- 在某些情况下,后处理可能会带来性能的提升,但在其他情况下可能效果有限或不适用。

表12强调了后处理技巧在医学图像分割中的潜在作用,以及在选择这些技巧时需要考虑数据集的特定需求和特性。通过这些实验结果,研究者可以更好地理解不同后处理技巧的效果,并为实际应用中的模型优化提供指导。

表13提供了在3D LiTS数据集上应用后处理技巧的实验结果,这些技巧包括最大连通组件抑制(ABL-CS)和移除小面积(RSA)。

-

实验结果分析:

- 对于基线模型3D-UNet,在没有任何后处理的情况下,列出了其在LiTS数据集上的性能指标。

- ABL-CS: 在LiTS数据集上应用ABL-CS后,Recall略有下降(-0.02%),但Precision显著提升(+3.35%),Dice和IoU也分别提升了1.68%和2.69%。

- RSA: 应用RSA后,Recall没有变化(-0.01%),Precision小幅提升(+0.16%),Dice微增(+0.08%),而IoU提升了0.14%。

-

结论:

- 后处理技巧在3D LiTS数据集上对模型性能有积极影响,尤其是在提升精确度方面。

- ABL-CS技巧在提升Dice和IoU方面更为有效,这表明它在改善分割质量方面可能更优。

- RSA技巧虽然对性能的提升不如ABL-CS显著,但也在一定程度上提高了模型的精确度和Dice系数。

表13的数据表明,在3D医学图像分割任务中,适当的后处理技巧可以进一步提升模型的分割性能。研究者可以根据这些结果来选择适合特定数据集和任务的后处理方法,以优化模型的最终输出。

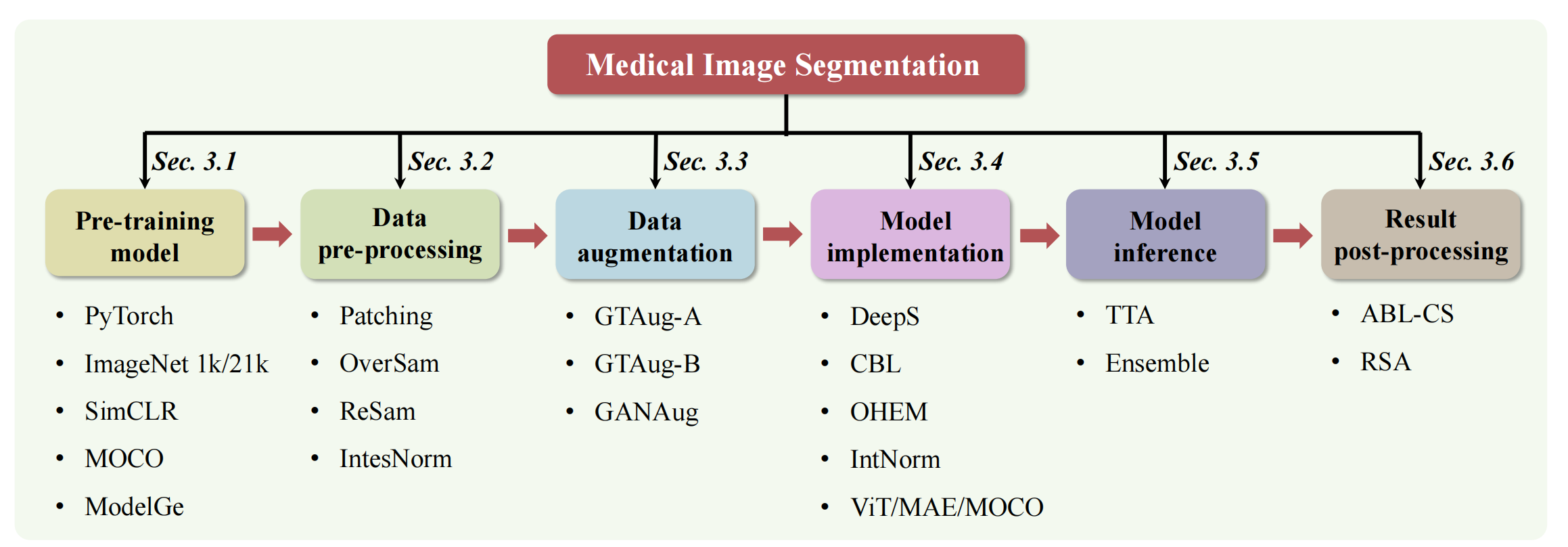

四、讨论

在本节中,作者讨论了与上述实验技巧相关的潜在挑战和问题。此外,作者还指出了这些技巧的局限性。如图2所示,一个完整的MedISeg系统可以分为六个主要实现阶段,作者在每个阶段收集并探索了一系列的技巧。

Fig. 2 所描述的图表是对于医学图像分割(MedISeg)系统中各种技巧及其潜在关系的说明性插图。

该图将MedISeg系统分为六个实施阶段,并针对每个阶段的技巧,使用两种典型的语义分割基线模型(2D-UNet和3D-UNet)以及四个医学图像分割数据集(2D ISIC 2018, 2D CoNIC, 3D KiTS19, 和 3D LiTS)进行了实验性的探索。

-

六个实施阶段:

- 预训练模型(Pre-training Model): 探索不同的预训练模型权重对分割性能的影响。

- 数据预处理(Data Pre-processing): 研究图像预处理步骤,如归一化、增强等对模型性能的影响。

- 数据增强(Data Augmentation): 应用不同的数据增强技术来增加数据多样性,减少过拟合。

- 模型实现(Model Implementation): 研究网络架构选择、损失函数、优化器等对模型性能的影响。

- 模型推理(Model Inference): 探索测试时的技巧,如测试时增强(TTA)和模型集成,以提高模型的推理性能。

- 结果后处理(Result Post-processing): 应用后处理技术,如ABL-CS和RSA,来改善最终的分割结果。

-

基线模型:

- 2D-UNet: 一个广泛使用的2D医学图像分割架构。

- 3D-UNet: 2D-UNet的3D版本,适用于3D图像数据。

-

数据集:

- 2D ISIC 2018: 一个具有挑战性的2D皮肤病变边界分割数据集。

- 2D CoNIC: 一个2D结肠核识别和计数挑战数据集。

- 3D KiTS19: 一个3D肾脏肿瘤分割数据集。

- 3D LiTS: 一个3D肝脏肿瘤分割挑战数据集。

-

实验探索:

- 图表中可能展示了不同技巧在各个阶段的应用,并通过实验来验证它们对基线模型性能的影响。

-

潜在关系:

- 图表可能揭示了不同技巧之间的相互作用和潜在的组合效应,以及它们如何共同影响最终的分割性能。

-

结论:

- 通过系统地分析每个阶段的技巧,研究者可以更好地理解哪些技巧对特定数据集和任务最有效,以及如何组合这些技巧来优化MedISeg系统。

Fig. 2 强调了在医学图像分割任务中,细致地选择和实施各个阶段的技巧对于提高模型性能至关重要。通过实验验证,可以为未来的医学图像处理挑战提供实用的指导和参考。

此外,MedISeg面临的潜在挑战包括但不限于小数据集、类不平衡学习、多模态学习和域适应。

4.1 挑战

通过将收集的技巧应用于各种基线模型,作者观察到性能的显著提升。

值得注意的是,尽管这些提升可以归因于技巧在基线上的实施,但性能的提升也归因于医学图像处理问题本身所固有的基础挑战。例如,作者观察到微调预训练权重可以显著提高模型性能(参考表1和表2)。

首先,这一观察表明,自然场景上的预训练权重可以通过简单的微调策略转移到医学场景中,从而本质上解决了多模态学习和域适应(即自然场景和医学场景之间的跨域表示)问题。尽管这些问题也可以通过一些先进的迁移学习[208]–[210]或元学习方法[200],[211]解决,但微调是一个廉价的解决方案。

其次,它表明训练更多的数据样本有助于提高模型性能(对应于小数据集和过拟合的问题)。这些问题在具有非常强学习能力(例如基于Transformer的模型)的模型中尤为突出,因为这类模型通常需要非常大的数据集来训练。

除了预训练模型,数据预处理、数据增强和测试时间增强的观察和结论也可以在表3到表13中得出。

数据预处理和数据增强方法可以增强实验数据集的表示能力,从而隐式解决由训练样本不足、小数据集和类不平衡学习带来的挑战。补丁化、过采样和重新采样方法在缓解这些挑战方面是有效的。

特别是,补丁化和过采样可以用于解决小数据集问题,而补丁化、过采样、重新采样和强度归一化可以用于解决类不平衡学习问题。

幸运的是,这些方法不会带来显著的计算成本,并且可以无缝实施。尽管数据增强和测试时间增强并不总是能提高性能,这可能是因为数据集特定的因素,而不是技术本身的局限性。

基于几何变换的数据增强方案之间存在显著差异。

KiTS19 [142]和LiTS [67]上每个数据增强方案的分割插图在图3中进行了可视化。多尺度和旋转在KiTS19 [142]上的一些评估指标上提高了模型性能,而翻转明显降低了模型性能。

LiTS [67]上的结果显示,多尺度只提高了部分评估指标(例如Dice),而其余的数据增强方案不起作用。这些结果验证了作者的假设,即具有非破坏性归纳偏置的数据增强方法(例如多尺度)对具有相对固定目标位置的图像更有益。

GAN数据增强方法可以在不破坏此类归纳偏置的情况下改善数据集表示,在KiTS19 [142]上取得更好的性能(参见表5)。这些实验表明,未来的数据增强设计应考虑所使用数据集的具体状态(例如模态、分布和病变大小)。此外,类不平衡学习也可以通过收集的技巧来解决(参见表7和表8)。

总之,作者的工作不仅提供了完整的MedISeg调查,也为解决医学图像处理中的分割相关挑战提供了实用的指导,包括但不限于小数据集、类不平衡学习、多模态学习和域适应。

4.2 局限性

本工作的存在一些局限性。例如,收集的技巧是有限的,这意味着作者在这篇论文中收集和实验的技巧只是所有医学图像分割技巧的一个有限子集。

这一点可以从以下几个方面进行详细说明:

(1) 调查的技巧子集

作者只收集了同一类别阶段的代表性数量的技巧。例如,存在许多数据增强方案,如翻译、颜色抖动、对比度、低分辨率模拟、高斯噪声注入、图像混合、随机擦除、高斯模糊、混洗和裁剪混合[59],[166],[168],[170],[190]。

然而,由于医学图像处理的实际需求和实验数据集的特点,只有少数这些技术被使用。

(2) 调查技巧的应用限制

在作者的工作中,作者选择了常用的2D-UNet [44]和3D-UNet [77]作为基线模型,并在四个代表性的2D和3D医学图像数据集上验证了这些技巧的有效性。

然而,许多具有不同主干网络的先进MedISeg模型在不同的层次上并未涉及。

(3) 调查技巧的影响限制

医学图像处理与临床实践密切相关,涉及许多复杂具有挑战性的问题,例如隐蔽对象[212],模糊图像[213],长尾问题[214],医学图像的增量学习问题[215],以及目标边界检测和细化[2]。

在作者的工作中,作者只解决了其中一些基本挑战。

总体而言,作者的工作为探索医学图像分割技巧的一个子集提供了有用的起点,但需要进一步的研究来充分探索这些技术在医学图像处理中的潜力。

五、结论与未来方向

在本工作中,作者收集了一组全面的MedISeg技巧,涵盖了医学图像分割中常用的基本方案。

为了避免实施差异带来的性能不确定性,作者在一致的2D-UNet [44]和3D-UNet [77]基线模型上实验探索了这些技巧的有效性。

作者在2D ISIC 2018 [78]、2D CoNIC [79],[81],[101]、3D KiTS19 [80]和3D LiTS [67]数据集上的实验显示了这些技巧的有效性,并帮助作者为即将到来的分割流水线提供了实证指导,包括网络架构、训练策略和损失函数。

作者工作的一个重要贡献是对这些收集技巧效果的明确探索。

作者的工作不仅促进了后续方法对技巧的关注,而且实现了公平的结果比较。这在面对像图像分割[188],[192]、目标检测[47],[182]和图像生成[83],[120]等复杂任务时,网络架构变得更加复杂的情况下尤为必要。与现有的基于论文的分割调查[10],[83],[151],[152],[166],[170],[177],[201]相比,作者的工作提供了广泛的实验,更具技术操作性。

在未来,作者计划从以下几个方向进行工作:

5.1 技巧追踪

(1) 对MedISeg进行更多技巧的调查和发展。

由于MedISeg与临床实践紧密集成,继续探索和发展更先进的MedISeg技巧以满足不同问题的需求具有很大的实际价值。

(2) 在更多方法和数据集上探索技巧的有效性。

为了实现更全面和公平的实验结果比较,有必要进行彻底的技巧调查。当面对不同图像类型、分布和内部类别差异可能会影响特定技巧有效性的MedISeg问题时,这一点尤为重要。

(3) 探索受技巧启发的模型设计。

尽管技巧在现有出版物中常常被忽视,但它们包含的原则和思想可以启发后续工作以实现更便宜、计算上更友好的模型设计。

(4) 探索基于注意力的技巧。

多头注意力机制提供了强大的特征表示能力,视觉Transformer框架在计算机视觉和医学图像分析社区中受到了更多关注。

然而,由于其复杂的内部架构和不成熟的实践应用(尤其是在面对小数据集时),需要探索基于视觉Transformer框架的技巧研究。

5.2 大型视觉模型之后

最近,大型视觉模型,如SAM [216]和MedSAM [217],引起了广泛关注,它们引领了图像语义识别的新时代,尤其是在密集图像预测任务上,如语义分割和实例分割[218],[219]。

这些模型在自然场景图像的挑战性任务上取得了突破性的进展和令人印象深刻的性能,如图像修复和伪装对象检测[218]–[223]。然而,大型视觉模型在特定医学数据集上的性能与最先进模型之间仍存在差距[224]–[227]。因此,探索将现成的大型视觉模型与下游医学图像处理任务集成,并在特定医学图像数据集上取得满意结果是至关重要的。

此外,在医学图像分析领域,将大型视觉模型与大型视觉语言模型(如ChatCAD [228]和CLIP [229])相结合具有巨大潜力。这可能涉及设计有效的视觉提示[230]或视觉适配器[231],使最终模型能够部署在边缘计算设备上。

这一有前景的研究方向可能会在MedISeg和其他医学图像分析任务上取得重大进展。

1166

1166

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?