控制器

一般来说用户不会直接创建pod,而是创建控制器。控制器通过标签选择器来管理pod。控制器会创建出满足条件的Pod,并确保每一个Pod资源处于用户期望的目标状态。如果Pod资源在运行中出现故障,它会基于指定策略重新编排Pod。按照pod的创建方式可以将其分为两类:

自主式pod:kubernetes直接创建出来的pod,不被控制器管理,创建后一旦死亡或被删除不会被重新创建。

控制器管理的pod:kubernetes通过控制器创建的pod,被控制器管理,用来控制pod的具体状态和行为,在控制器的生命周期里,始终维持pod的副本数。

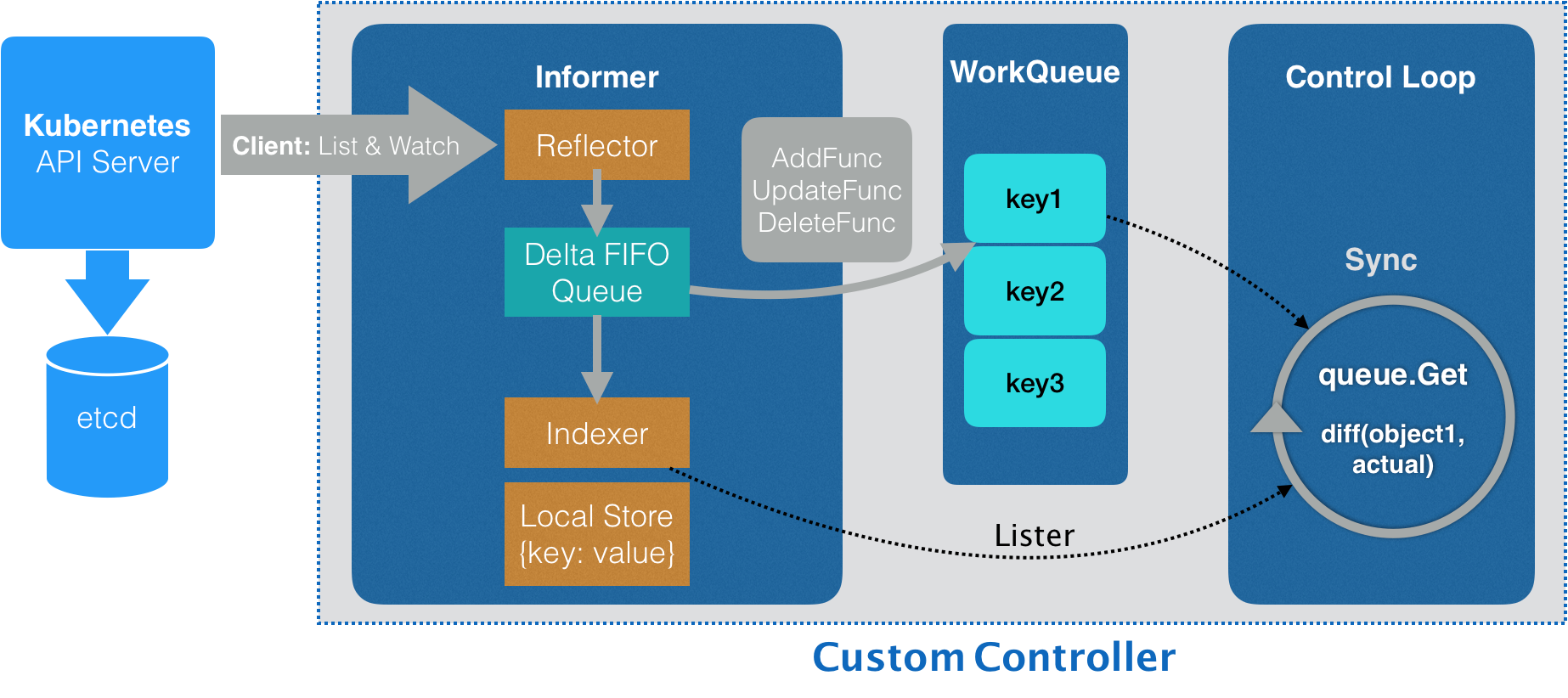

Pod控制器循环监控集群中运行着的Pod资源对象,来确保受其管控的资源对象严格符合用户期望的状态,使当前状态不断地向期望状态和解(reconciliation)来完成容器应用管理。每个控制器均通过API Server提供的接口持续监控相关资源对象的当前状态,并在因故障、更新或其他原因导致系统状态发生变化时,尝试让资源的当前状态向期望状态迁移和逼近。

for {

desired := getDesiredState() // 期望的状态

current := getCurrentState() // 当前实际状态

if current == desired { // 如果状态一致则什么都不做

// nothing to do

} else { // 如果状态不一致则调整编排,到一致为止

// change current to desired status

}

}

期望状态一般来自于用户提交的 YAML 文件。比如Deployment 控制器从 Etcd 中获取到所有携带了app: nginx标签的 Pod,然后统计它们的数量,这就是实际状态。Deployment 对象的 Replicas 字段的值就是期望状态,Deployment 控制器将两个状态做比较,然后根据比较结果,确定是创建 Pod,还是删除已有的 Pod

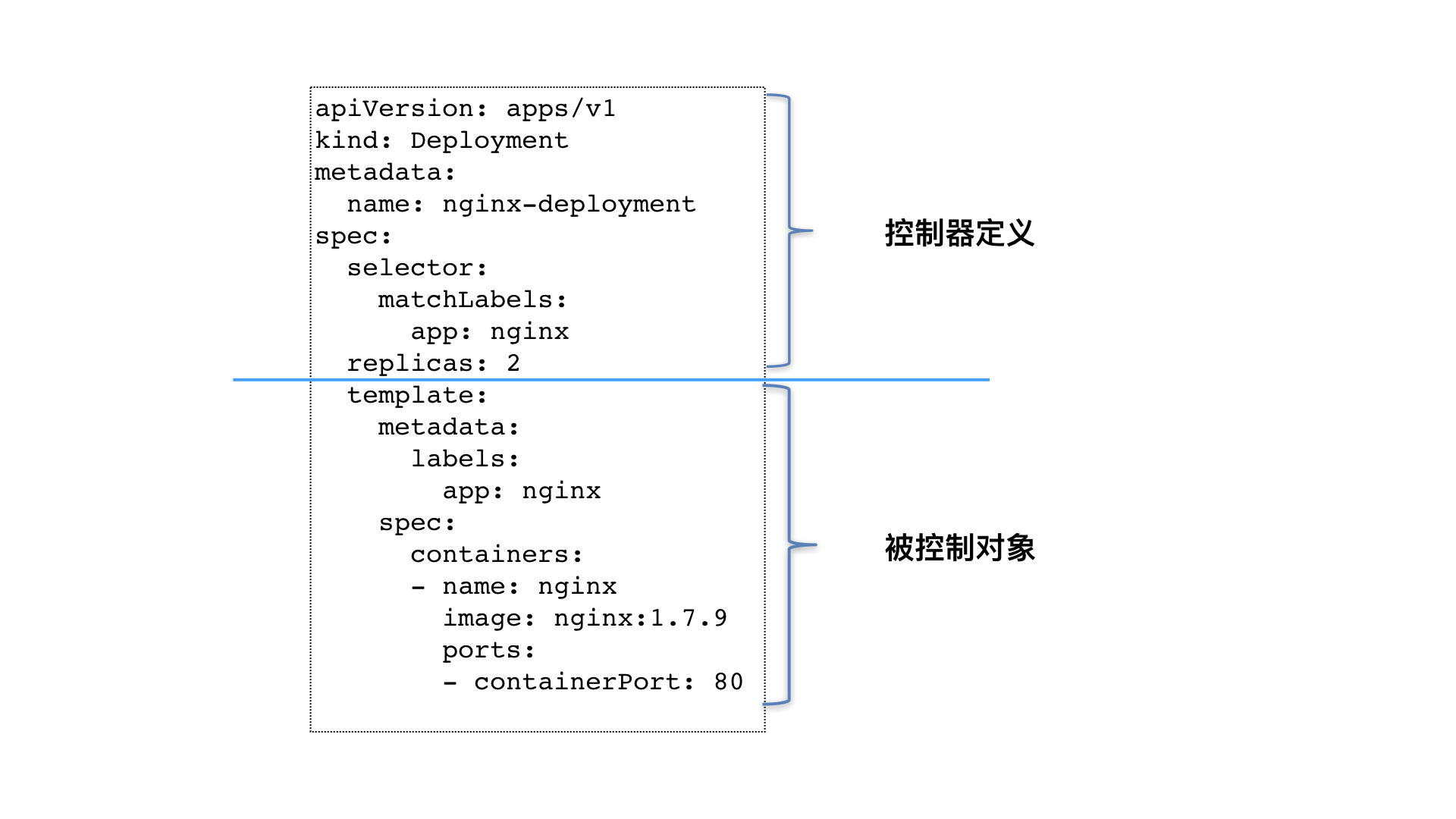

像 Deployment 这种控制器的设计原理,就是用一种对象管理另一种对象的艺术。由上半部分的控制器定义(包括期望状态),加上下半部分的被控制对象的模板组成的。其中,这个控制器对象本身,负责定义被管理对象的期望状态。比如,Deployment 里的 replicas=2 这个字段。而被控制对象的定义,则来自于一个模板PodTemplate。Deployment 这个 template 字段里的内容,跟一个标准的 Pod 对象的 API 定义丝毫不差。而所有被这个 Deployment 管理的 Pod 实例,其实都是根据这个 template 字段的内容创建出来的。

控制器的工作原理

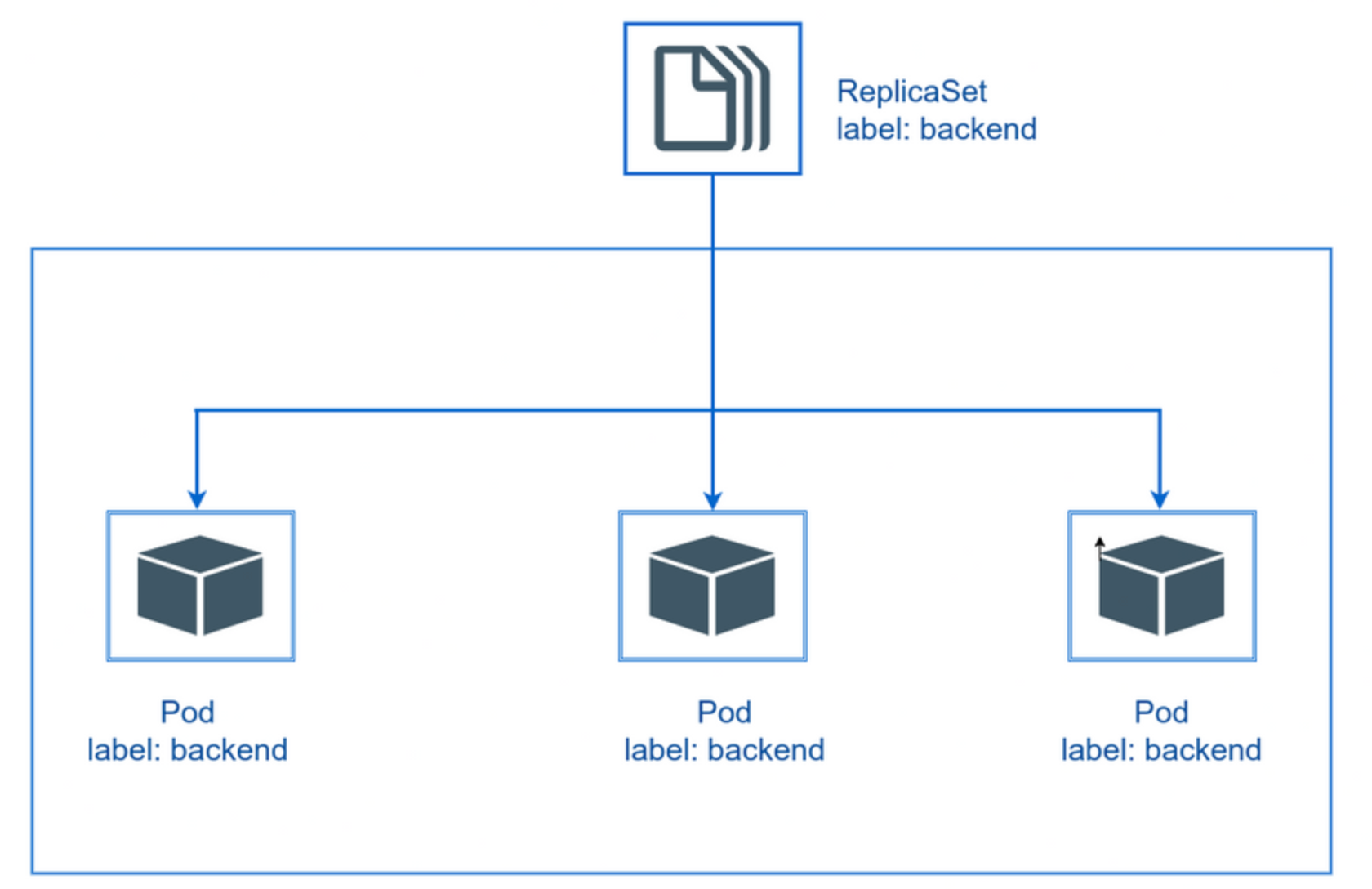

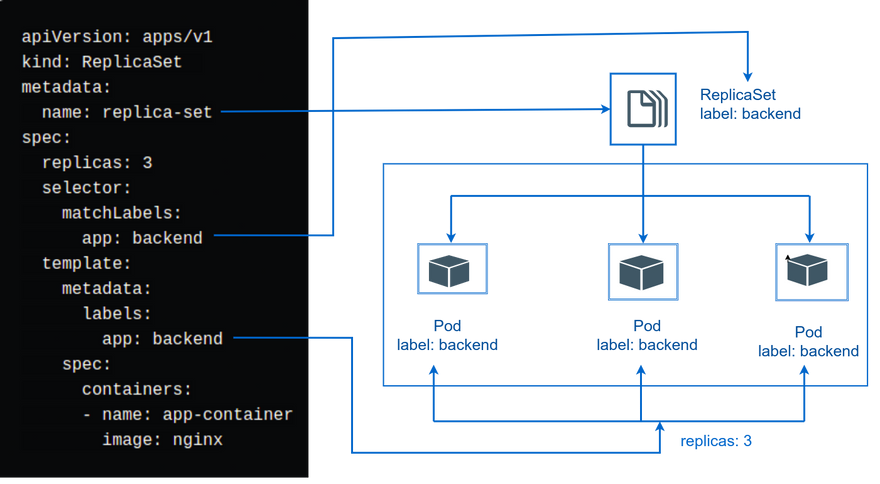

ReplicaSet

ReplicaSet的核心任务是保持Pod应用的副本数与用户定义的数量一致。如果副本数不足,ReplicaSet会自动创建新的Pod,而如果超出了定义的数量,它会负责自动回收多余的Pod。在Pod发生故障时,ReplicaSet会主动监测运行状态,并自动进行重启或重建,确保应用的稳定性。此外,ReplicaSet还支持对Pod自动扩缩容和镜像版本的升降级。ReplicaSet是ReplicationController的升级版

ReplicaSet创建

创建一个ReplicaSet示例

cat <<EOF | kubectl apply -f -

apiVersion: apps/v1 #版本号

kind: ReplicaSet #类型

metadata: #元数据信息

name: replica-set #RS的名称

namespace: default #名称空间,默认default

#labels: #控制器标签

# key: value

spec: #详细信息

replicas: 3 #期望的pod副本数,这里是3个副本

selector: #标签选择器,通过它指定该控制器管理哪些pod

matchLabels: #Labels匹配规则

app: bakend #k:v,通过这个标签来确定这些pod被控制器所管理,pod创建将以此标签命名,管理的是具有 app=bakend 的pod

template: #模板,当副本数量不足时,会根据下面的模板创建pod副本

#template模板下面的内容其实就是自主式pod的模板,嵌套在控制器内,所以apiVersion、kind;name、namespace都可以省略不写

#apiVersion: v1

#kind: Pod

metadata:

#name: #pod名称会根据rs名称自动生成,pod的名称是在控制器名称后面拼接了-xxxxx随机码

#namespace:

labels:

app: bakend #此处的标签一定要跟上面的 metchLables 保持一致,通过标签进行管理

spec:

containers: #容器

- name: nginx #容器名

image: nginx #镜像

ports:

- containerPort: 80 #容器端口

EOF

从我们上面的清单文件中可以看到,我们有带标签的 Pod app:backend,并且在 ReplicaSet 中有一个带 matchLabels 的选项app:backend。这意味着借助 Kubernetes 功能之一 与之pods关联。带标签的 Pod仅与我们使用清单文件创建的副本集相关联。

查看创建好的ReplicaSet,可以看到当前资源对象的描述信息

[root@master ~]# kubectl get rs replica-set -owide

NAME DESIRED CURRENT READY AGE CONTAINERS IMAGES SELECTOR

replica-set 3 3 3 22s nginx nginx app=bakend

# DESIRED:用户期望的副本数量

# CURRENT:当前处于running状态的pod个数

# READY:已经准备好提供服务的副本数量

查看当前控制器创建出来的pod,控制器创建出来的pod的名称是在控制器名称后面拼接了 -xxxxx 随机码

[root@master ~]# kubectl get pod -owide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

replica-set-f9dxx 1/1 Running 0 58s 10.244.104.57 node2 <none> <none>

replica-set-f9gfj 1/1 Running 0 58s 10.244.166.179 node1 <none> <none>

replica-set-fmr9l 1/1 Running 0 58s 10.244.104.56 node2 <none> <none>

查看标签信息,控制器通过使用标签选择器来关联和管理一组 Pod

[root@master ~]# kubectl get pod --show-labels

NAME READY STATUS RESTARTS AGE LABELS

replica-set-f9dxx 1/1 Running 0 90s app=bakend

replica-set-f9gfj 1/1 Running 0 90s app=bakend

replica-set-fmr9l 1/1 Running 0 90s app=bakend

修改其中一个pod的标签,该 Pod 将不再匹配 ReplicaSet 的选择器,ReplicaSet 就会认为它不再是它所管理的 Pod 之一,然后ReplicaSet会尝试通过创建新的Pod来满足用户定义的副本数,以确保符合期望的状态

[root@master ~]# kubectl label pod replica-set-f9dxx app=nginx --overwrite=True

[root@master ~]# kubectl get pod --show-labels

NAME READY STATUS RESTARTS AGE LABELS

replica-set-f9dxx 1/1 Running 0 4m55s app=nginx

replica-set-f9gfj 1/1 Running 0 4m55s app=bakend

replica-set-fmr9l 1/1 Running 0 4m55s app=bakend

replica-set-gwhmc 1/1 Running 0 19s app=bakend

扩缩容

在Kubernetes中,通过kubectl edit修改副本数之后,Kubernetes会尝试根据你的更改逐渐更新Pod的实例数,以确保平滑的滚动更新而不会导致服务中断

[root@localhost ~]# kubectl edit rs replica-set #修改副本数,比如改成5个副本。修改 spec:replicas: 5 即可

[root@localhost ~]# kubectl get pods #pod变成5个,达到扩容

NAME READY STATUS RESTARTS AGE

replica-set-f9gfj 1/1 Running 0 7m22s

replica-set-fmr9l 1/1 Running 0 7m22s

replica-set-gn6b9 1/1 Running 0 34s

replica-set-gwhmc 1/1 Running 0 2m46s

replica-set-lnbdh 1/1 Running 0 34s

也可以直接使用scale命令实现扩缩容,后面 --replicas=n 直接指定目标数量即可

[root@localhost ~]# kubectl scale rs replica-set --replicas=2

[root@localhost ~]# kubectl get pod #命令执行完毕立即查看,发现已经有3个开始准备退出了

NAME READY STATUS RESTARTS AGE

replica-set-f9gfj 1/1 Running 0 10m

replica-set-fmr9l 1/1 Running 0 10m

replica-set-f9dxx 0/1 Terminating 0 28m

replica-set-gn6b9 0/1 Terminating 0 28m

replica-set-lnbdh 0/1 Terminating 0 34s

[root@master ~]# kubectl get pod

NAME READY STATUS RESTARTS AGE

replica-set-f9gfj 1/1 Running 0 10m

replica-set-fmr9l 1/1 Running 0 10m

镜像升级

使用edit命令编辑Pod的镜像时,则不会立即生效,Kubernetes不会自动更改正在运行的容器的镜像,因为这可能会影响正在运行的应用程序。您需要手动更新Pod的镜像版本,并重启Pod中的容器以应用更改,可以使用delete命令,使其自动创建

kubectl edit rs replica-set #修改镜像使其更新,编辑rs的容器镜像 - image: nginx:1.17.2

查看镜像版本是否修改成功

[root@master ~]# kubectl get rs replica-set -o wide

NAME DESIRED CURRENT READY AGE CONTAINERS IMAGES SELECTOR

replica-set 2 2 2 18m nginx nginx:1.17.2 app=bakend

查看当前pod镜像版本

[root@master ~]# kubectl describe pod replica-set-f9gfj | grep 'Image:'

Image: nginx

edit编辑更新镜像需要手动删除pod才会生效

kubectl scale rs replica-set --replicas=0

kubectl scale rs replica-set --replicas=2

再次查看pod的镜像版本发现已经完成更新

[root@master ~]# kubectl get pod

NAME READY STATUS RESTARTS AGE

replica-set-jkdnq 1/1 Running 0 66s

replica-set-zqtjx 1/1 Running 0 66s

[root@master ~]# kubectl describe pod replica-set-jkdnq | grep 'Image:'

Image: nginx:1.17.2

通过使用kubectl set image命令来更新Pod的镜像版本

#kubectl set image rs rs名称 容器=镜像版本 -n namespace

kubectl set image rs replica-set nginx=nginx:1.17.1

发现pod版本没有发生变化,只有重建版本才能更新

[root@master ~]# kubectl get rs -o wide

NAME DESIRED CURRENT READY AGE CONTAINERS IMAGES SELECTOR

replica-set 2 2 2 25m nginx nginx:1.17.1 app=bakend

[root@master ~]# kubectl describe pod replica-set-jkdnq | grep 'Image:'

Image: nginx:1.17.2

[root@master ~]# kubectl delete pod replica-set-jkdnq replica-set-zqtjx

[root@master ~]# kubectl get pod

NAME READY STATUS RESTARTS AGE

replica-set-cwjr5 1/1 Running 0 36s

replica-set-j25z9 1/1 Running 0 36s

[root@master ~]# kubectl describe pod replica-set-cwjr5 | grep 'Image:'

Image: nginx:1.17.1

在Kubernetes中,使用edit命令编辑Pod的副本数时,更改将立即生效并且自动更新Pod的副本数。这是因为Pod的副本数是由ReplicaSet控制器管理的,当副本数被更改时,ReplicaSet会自动根据最新的配置调整Pod的副本数。而编辑Pod的镜像时,则不会立即生效,需要手动更新Pod的镜像版本。在编辑Pod的配置时,Kubernetes不会自动更改正在运行的容器的镜像,因为这可能会影响正在运行的应用程序。相反,您需要手动更新Pod的镜像版本,并重启Pod中的容器以应用更改。您可以通过使用kubectl set image命令来更新Pod的镜像版本

删除

被控制器管理的pod删除后,控制器会自动创建新的Pod以确保所需的副本数仍然满足。这个就是上面我们所说的 ReplicaSet 控制器为我们做的工作,现在pod是2个副本,将pod删除,这个时候 ReplicaSet 控制器监控到控制的 Pod 数量和期望的 2 不一致,所以就需要启动新的 Pod 来保持 2 个副本,这个过程上面我们说了就是调谐的过程。

[root@master ~]# kubectl delete pod --all #--all删除所有default名称空间下的pod

pod "replica-set-jkdnq" deleted

pod "replica-set-j25z9" deleted

[root@master ~]# kubectl get pod

[root@master ~]# kubectl get pod

NAME READY STATUS RESTARTS AGE

replica-set-5wrzb 1/1 Running 0 7s

replica-set-tvpk5 1/1 Running 0 7s

我们可以随便查看一个 Pod 所属的控制器

[root@master ~]# kubectl describe pod replica-set-5wrzb | grep Controlled

Controlled By: ReplicaSet/replica-set

#查看metadata.ownerReferences下面的内容

[root@master ~]# kubectl get pod replica-set-5wrzb -o yaml | grep -A6 ownerReferences

ownerReferences:

- apiVersion: apps/v1

blockOwnerDeletion: true

controller: true

kind: ReplicaSet

name: replica-set

uid: 414fbe0e-433f-413c-9f95-ed36d14bc6cc

owner主要是被集群中的垃圾收集器使用,在删除所有者对象时,它所拥有的子对象也会被自动删除。删除ReplicaSet,会以ReplicaSet为资源者的对象给删除掉,也就是删除rs会附带删除这个pod。

ownerReferences用于建立对象之间的所有权关系,即用来表示一个Kubernetes对象是否拥有另一个对象。当一个对象被标记为另一个对象的所有者(owner)时,它将被认为是该对象的子对象(child),并且在删除该父对象时,它的子对象也会被自动删除。这种所有权关系通常用于管理一组相关对象的生命周期,例如当您使用Deployment或StatefulSet控制器创建Pod时,这些控制器将作为父对象,并且所创建的Pod将被标记为其子对象。这样,当您要更新或删除父对象时,控制器将自动更新或删除与之相关的Pod。例如,一个Deployment可能会创建多个Pod,并且这些Pod需要与一个Service关联起来。但是,当您删除一个Deployment时,如果没有处理这些关联关系,那么它所创建的Pod和Service就会继续存在,可能会导致一些问题。

要想删除pod需要删除对应的控制器,在kubernetes删除ReplicaSet前,会将ReplicaSet的replicasclear调整为0,等待所有的Pod被删除后,在执行ReplicaSet对象的删除

# 也可以使用yaml直接删除 kubectl delete -f xxx.yaml

kubectl delete rs replica-set

如果希望仅仅删除RS对象(保留Pod),可以使用kubectl delete命令时添加--cascade=false选项(不推荐)

Deployment

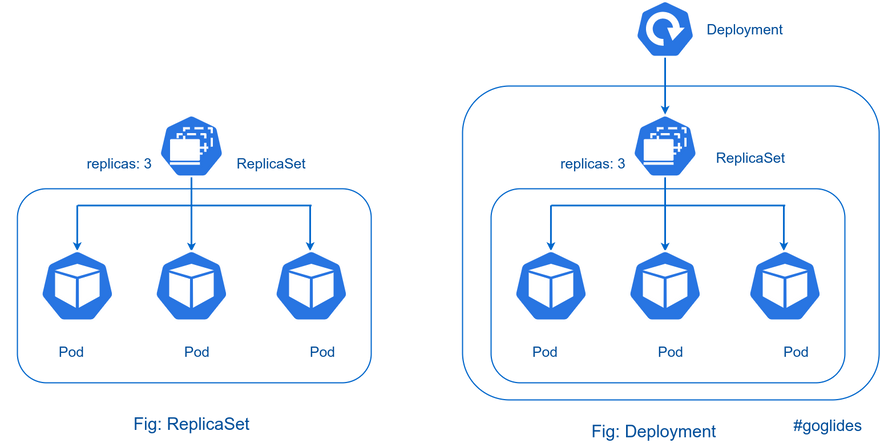

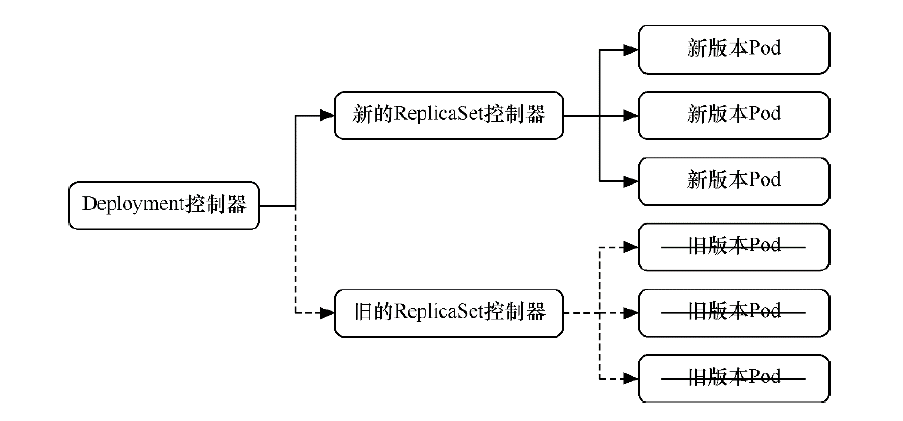

为了更好的管理服务编排,Kubernetes引入了Deployment控制器。值得一提的是,Deployment控制器并不是直接管理pod,而是通过管理ReplicaSet来间接管理Pod,Deployment可以控制ReplicaSet的创建、升级、回滚等操作,从而管理Pod的数量和版本。即Deployment管理ReplicaSet,ReplicaSet管理Pod。相比之下,Deployment比ReplicaSet功能更加强大,能够支持服务发布的停止、继续、滚动更新、回滚和水平扩缩容等功能,使得服务编排更加方便和灵活。

Deployment 控制器的实现流程主要包括以下几个步骤:

获取实际状态: Deployment 控制器从 Etcd 中获取所有携带了指定标签的 Pod,并统计它们的数量

获取期望状态: 通过 Deployment 对象的 Replicas 字段,获取期望的 Pod 数量

对比状态: 对比实际状态和期望状态的数量。如果它们不一致,就需要进行调谐,确定是创建新的 Pod 还是删除现有的 Pod

可以看到,一个 Kubernetes 对象的主要编排逻辑,实际上是在第三步的“对比”阶段完成的。这个操作,通常被叫作调谐(Reconcile)。这个调谐的过程,则被称作“Reconcile Loop”(调谐循环)或者“Sync Loop”(同步循环)。我们社区交流也称为“控制循环”

Deployment资源清单

apiVersion: apps/v1 # 版本号

kind: Deployment # 类型

metadata: # 元数据

name: string # deployment控制器名称

namespace: string # 所属命名空间

labels: # 标签列表

key: value # 定义标签的键值对

annotations: # 自定义注解列表

key: value # 定义注解的键值对

spec: # 详情描述

replicas: int # 期望的副本数量,默认为1

revisionHistoryLimit: 3 # 保留历史版本

paused: false # 暂停部署,默认是false

progressDeadlineSeconds: 600 # 部署超时时间(s),默认是600,超过这个时间就会变为失败

strategy: # 更新时替换旧pod的策略

type: RollingUpdate # 滚动更新策略

# RollingUpdate 以滚动更新的方式更新pod,并可以通过设置maxSurge、maxUnavailable来控制滚动更新的过程

# Recreate 所有现有的pod都会在创建新的pod之前被终止

rollingUpdate: # 滚动更新

maxSurge: 30% # 最大额外可以存在的副本数,可以为百分比,也可以为整数

maxUnavailable: 30% # 最大不可用状态的 Pod 的最大值,可以为百分比,也可以为整数

selector: # 选择器,通过它指定该控制器管理哪些pod

matchLabels: # Labels匹配规则

app: nginx-pod

matchExpressions: # Expressions匹配规则

- {key: app, operator: In, values: [nginx-pod]}

template: # 模板,当副本数量不足时,会根据下面的模板创建pod副本

metadata:

labels:

app: nginx-pod #Pod 标签

spec:

containers:

- name: nginx

image: nginx:1.17.1

ports:

- containerPort: 80

Deployment创建

创建一个deploy控制器示例

cat <<EOF | kubectl apply -f -

apiVersion: apps/v1 # 资源群组

kind: Deployment # 资源类型

metadata: # 元数据

name: deployment-nginx # deploy名称

namespace: dev # Pod所在的名称空间

spec:

replicas: 2 # Pod的副本数

selector: # 标签选择器

matchLabels:

app: nginx-deployment #

template: # 定义Pod的模板

metadata: #

labels: #

app: nginx-deployment

spec:

containers:

- name: nginx # 容器名称

image: nginx:1.16.1 # 容器镜像

imagePullPolicy: IfNotPresent # 容器拉取策略

ports: # 定义容器的端口

- name: http

containerPort: 80 # 容器端口为80

EOF

查看创建的deploy

[root@master ~]# kubectl get deployment -n dev

NAME READY UP-TO-DATE AVAILABLE AGE

deployment-nginx 2/2 2 2 6s

# NAME 列出了集群中 Deployment 的名称

# READY 显示应用程序的可用的副本数。显示的模式是 就绪个数/期望个数

# UP-TO-DATE 当前处于最新版本的 Pod 的个数,所谓最新版本指的是 Pod 的 Spec 部分与 Deployment 里 Pod 模板里定义的完全一致

# AVAILABLE 当前可用的pod的数量,既是running状态又是最新版本,并且处于ready状态。AVAILABLE 字段,描述的才是用户所期望的最终状态

# AGE 显示应用程序运行的时间

创建deployment同时也会自动创建出对应的ReplicaSet,ReplicaSet 的名称被格式化为[Deployment名称]-[随机字符串]。 其中的随机字符串是使用 pod-template-hash 随机生成的。Deployment 控制器将 pod-template-hash 标签添加到 Deployment 所创建或收留的每个 ReplicaSet。此标签可确保 Deployment 的子 ReplicaSets 不重叠,从而避免这些pod与其它pod混淆。

[root@master ~]# kubectl get rs -n dev

NAME DESIRED CURRENT READY AGE

deployment-nginx-dcbd8844d 2 2 2 25s

# NAME 列出名字空间中 ReplicaSet 的名称;

# DESIRED 显示应用的期望副本个数,即在创建 Deployment 时所定义的值。 此为期望状态;

# CURRENT 显示当前运行状态中的副本个数;

# READY 显示应用中有多少副本可以为用户提供服务;

# AGE 显示应用已经运行的时间长度。

注意下面示例输出中的 pod label 里的 pod-template-hash label。当 Deployment 创建或者接管 ReplicaSet 时,Deployment controller 会自动为 Pod 添加 pod-template-hash label。这样做的目的是防止 Deployment 的子 ReplicaSet 的 pod 名字重复。通过将 ReplicaSet 的 PodTemplate 进行哈希散列,使用生成的哈希值作为 label 的值,并添加到 ReplicaSet selector 里、 pod template label 和 ReplicaSet 管理中的 Pod 上。

[root@master ~]# kubectl get pods -n dev --show-labels -owide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES LABELS

deployment-nginx-dcbd8844d-67vkh 1/1 Running 0 38s 10.244.1.79 node1 <none> <none> app=nginx-deployment,pod-template-hash=dcbd8844d

deployment-nginx-dcbd8844d-cp8mn 1/1 Running 0 38s 10.244.2.95 node2 <none> <none> app=nginx-deployment,pod-template-hash=dcbd8844d

发现该pod被rs控制,deployment会去创建一个rs,rs去创建对应的pod

[root@master ~]# kubectl describe pod deployment-nginx-dcbd8844d-67vkh -n dev | grep "Controlled By"

Controlled By: ReplicaSet/deployment-nginx-dcbd8844d

[root@master ~]# kubectl get pod deployment-nginx-dcbd8844d-67vkh -n dev -oyaml

………

name: deployment-nginx-dcbd8844d-67vkh #pod名

namespace: dev

ownerReferences:

- apiVersion: apps/v1

blockOwnerDeletion: true

controller: true

kind: ReplicaSet

name: deployment-nginx-dcbd8844d #rs名

uid: d4909347-afd6-463d-b5ce-978052c58ed5

………

[root@master ~]# kubectl get rs deployment-nginx-dcbd8844d -n dev -o yaml #查看rs

………

name: deployment-nginx-dcbd8844d #rs名

namespace: dev

ownerReferences: - apiVersion: apps/v1

blockOwnerDeletion: true

controller: true

kind: Deployment

name: deployment-nginx #dm名

uid: 30903400-3dc6-4605-9171-46b46cdae26a

………

水平扩缩容

水平扩缩容非常容易实现,deployment只需要修改它所控制的ReplicaSet的pod副本个数就可以了

通过scale命令进行扩缩容,给名叫deployment-nginx的deployment pod副本数量为5个

kubectl scale deployment deployment-nginx --replicas=5 -n dev

查看deployment

[root@master ~]# kubectl get deploy deployment-nginx -n dev

NAME READY UP-TO-DATE AVAILABLE AGE

deployment-nginx 5/5 5 5 4m47s

查看pod

[root@master ~]# kubectl get pods -n dev

NAME READY STATUS RESTARTS AGE

deployment-nginx-dcbd8844d-67vkh 1/1 Running 0 5m2s

deployment-nginx-dcbd8844d-cp8mn 1/1 Running 0 5m2s

deployment-nginx-dcbd8844d-h7xvv 1/1 Running 0 83s

deployment-nginx-dcbd8844d-p86mk 1/1 Running 0 83s

deployment-nginx-dcbd8844d-thkdp 1/1 Running 0 83s

通过edit命令进行扩缩容,编辑deployment的副本数量,修改spec:replicas: 3即可

kubectl edit deploy deployment-nginx -n dev

查看pod

[root@master ~]# kubectl get pods -n dev

NAME READY STATUS RESTARTS AGE

deployment-nginx-dcbd8844d-67vkh 1/1 Running 0 7m7s

deployment-nginx-dcbd8844d-cp8mn 1/1 Running 0 7m7s

deployment-nginx-dcbd8844d-h7xvv 1/1 Running 0 3m28s

kubectl edit 命令只是把 API 对象的内容下载到了本地文件,修改完成后再提交上去。Kubernetes 就会立刻触发滚动更新的过程。你还可以通过 kubectl rollout status 指令查看 deployment-nginx 的状态变化,也可以通过查看 Deployment 的 Events,看到这个滚动更新的流程

[root@master ~]# kubectl rollout status deploy deployment-nginx -n dev

deployment "deployment-nginx" successfully rolled out

[root@master ~]# kubectl describe deploy deployment-nginx -n dev

Events:

Type Reason Age From Message

---- ------ ---- ---- -------

Normal ScalingReplicaSet 8m20s deployment-controller Scaled up replica set deployment-nginx-dcbd8844d to 2

Normal ScalingReplicaSet 4m41s deployment-controller Scaled up replica set deployment-nginx-dcbd8844d to 5

Normal ScalingReplicaSet 88s deployment-controller Scaled down replica set deployment-nginx-dcbd8844d to 3

滚动更新

仅当 Deployment Pod 模板(即 .spec.template)发生改变时,例如模板的标签或容器镜像被更新,才会触发Deployment 上线。 其他更新(如对 Deployment 执行扩缩容的操作)不会触发上线动作,当你修改 Deployment 的副本数量(spec.replicas)时,只是调整 Pod 的数量,而不涉及 Pod 模板的变更。这不会触发新的 Pod 模板创建,也不会引发滚动更新。例如,你把 replicas 从 3 调整到 5,Kubernetes 只会再创建两个 Pod 来满足新的副本数量要求,而不会重新创建已有的 Pod。

先来更新 nginx Pod 以使用 nginx:1.17.1 镜像

kubectl set image deployment deployment-nginx nginx=nginx:1.17.1 -n dev --record

或者 edit Deployment 并将 .spec.template.spec.containers[0].image 更改至 nginx:1.17.1。edit 指令会直接打开deployment-nginx的 API 对象。然后,你就可以修改这里的 Pod 模板部分了。

kubectl edit deployment deployment-nginx -n dev

kubectl set 指令编辑完成后,Kubernetes 就会立刻触发 滚动更新 的过程。通过 kubectl rollout status 指令查看 deployment-nginx 的状态变化:

kubectl rollout status deployment deployment-nginx -n dev

可以通过查看 Deployment 的 Events,看到这个 滚动更新 的流程

[root@master ~]# kubectl describe deployment deployment-nginx -n dev

Events:

Type Reason Age From Message

---- ------ ---- ---- -------

Normal ScalingReplicaSet 10m deployment-controller Scaled up replica set deployment-nginx-dcbd8844d to 2

Normal ScalingReplicaSet 7m9s deployment-controller Scaled up replica set deployment-nginx-dcbd8844d to 5

Normal ScalingReplicaSet 3m56s deployment-controller Scaled down replica set deployment-nginx-dcbd8844d to 3

Normal ScalingReplicaSet 19s deployment-controller Scaled up replica set deployment-nginx-9588fc68c to 1

Normal ScalingReplicaSet 18s deployment-controller Scaled down replica set deployment-nginx-dcbd8844d to 2

Normal ScalingReplicaSet 18s deployment-controller Scaled up replica set deployment-nginx-9588fc68c to 2

Normal ScalingReplicaSet 17s deployment-controller Scaled down replica set deployment-nginx-dcbd8844d to 1

Normal ScalingReplicaSet 17s deployment-controller Scaled up replica set deployment-nginx-9588fc68c to 3

Normal ScalingReplicaSet 16s deployment-controller Scaled down replica set deployment-nginx-dcbd8844d to 0

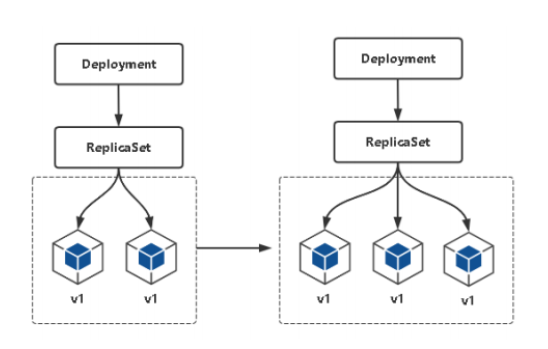

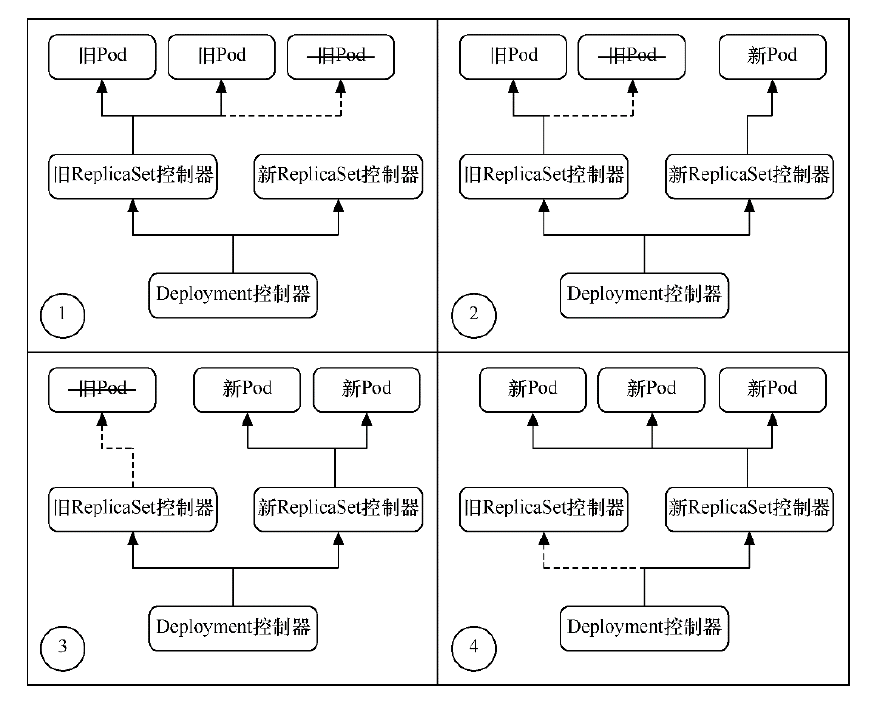

可以看到,首先,当你修改了 Deployment 里的 Pod 定义之后,Deployment Controller 会使用这个修改后的 Pod 模板,创建一个新的 ReplicaSet(hash=9588fc68c),这个新的 ReplicaSet 的初始 Pod 副本数是:0。然后在 Age=19 s 的位置,Deployment Controller 开始将这个新的 ReplicaSet 所控制的 Pod 副本数从 0 个变成 1 个,即水平扩展出一个副本。紧接着,在 Age=18 s 的位置,Deployment Controller 又将旧的 ReplicaSet(hash=dcbd8844d)所控制的旧 Pod 副本数减少一个,即水平收缩成一个副本。

如此交替进行,新 ReplicaSet 管理的 Pod 副本数,从 0 个变成 1 个,再变成 2 个,最后变成 3 个。而旧的 ReplicaSet 管理的 Pod 副本数则从 3 个变成 2 个,再变成 1 个,最后变成 0 个。这样,就完成了这一组 Pod 的版本升级过程。像这样,将一个集群中正在运行的多个 Pod 版本,交替地逐一升级的过程,就是 滚动更新 。

在这个 滚动更新 过程完成之后,你可以查看一下新、旧两个 ReplicaSet 的最终状态。当第一次创建 Deployment 时,它创建了一个 ReplicaSet(deployment-nginx-dcbd8844d) 并将其直接扩容至 3 个副本。更新 Deployment 时,它创建了一个新的 ReplicaSet (deployment-nginx-9588fc68c),并将其扩容为 1,然后将旧 ReplicaSet(deployment-nginx-dcbd8844d) 缩容到 2, 以便至少有 2 个 Pod 可用且最多创建 4 个 Pod。 然后,它使用相同的滚动更新策略继续对新的 ReplicaSet 扩容并对旧的 ReplicaSet 缩容。 最后,你将有 3 个可用的副本在新的 ReplicaSet 中,旧 ReplicaSet(hash=dcbd8844d)已经被 水平收缩 成了 0 个副本。

[root@master ~]# kubectl get rs -n dev

NAME DESIRED CURRENT READY AGE

deployment-nginx-9588fc68c 3 3 3 4m30s

deployment-nginx-dcbd8844d 0 0 0 14m

滚动更新不会中断整个pod集群提供的服务,是一种比较平滑的升级方式。比如,在升级刚开始的时候,集群里只有 1 个新版本的 Pod。如果这时,新版本 Pod 有问题启动不起来,那么 滚动更新 就会停止,从而允许开发和运维人员介入。而在这个过程中,由于应用本身还有两个旧版本的 Pod 在线,所以服务并不会受到太大的影响。当然,这也就要求你一定要使用 Pod 的 Health Check 机制检查应用的运行状态,而不是简单地依赖于容器的 Running 状态。要不然的话,虽然容器已经变成 Running 了,但服务很有可能尚未启动,滚动更新的效果也就达不到了。

Deployment 可确保在更新时仅关闭一定数量的 Pod。默认情况下,它确保至少所需 Pods 75% 处于运行状态(最大不可用比例为 25%); Pod 个数比期望个数最多多出 25%(最大峰值 25%)。所以,在上面这个 Deployment 的例子中,它有 3 个 Pod 副本,那么控制器在 滚动更新 的过程中永远都会确保至少有 2 个 Pod 处于可用状态,至多只有 4 个 Pod 同时存在于集群中。这个策略是 Deployment 对象的一个字段,名叫 RollingUpdateStrategy,如下所示:

[root@master ~]# kubectl describe deployment deployment-nginx -n dev |grep RollingUpdateStrategy

RollingUpdateStrategy: 25% max unavailable, 25% max surge

[root@master ~]# kubectl get deployment deployment-nginx -n dev -o yaml

………

strategy: # 更新策略

rollingUpdate:

maxSurge: 25% #能够额外创建的pod数或相对于总副本数的百分比

maxUnavailable: 25% #更新过程中能够进入不可用状态pod的最大值或相对于总副本数的最大百分比

type: RollingUpdate # 滚动更新策略,不写默认为该策略

maxSurge 指定的是除了 DESIRED 数量之外,在一次滚动中,Deployment 控制器还可以创建多少个新 Pod;而 maxUnavailable 指的是,在一次滚动中,Deployment 控制器可以删除多少个旧 Pod。

下面我们将更新策略改成如下内容,同时修改镜像版本为nginx:1.8

[root@master ~]# vim nginx-deploy.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: deployment-nginx

namespace: dev

spec:

replicas: 3

selector:

matchLabels:

app: nginx-deployment

strategy:

type: RollingUpdate

rollingUpdate:

maxSurge: 0

maxUnavailable: 1

template:

metadata:

labels:

app: nginx-deployment

spec:

containers:

- name: nginx

image: nginx:1.8

imagePullPolicy: IfNotPresent

ports:

- name: http

containerPort: 80

创建pod,-–record 参数的作用,是记录下你每次操作所执行的命令,以方便后面查看

kubectl apply -f nginx-deploy.yaml --record

在滚动更新中,因为设置了maxUnavailable=1,表示最多只允许一个pod不可用,所以会先终止一个pod,而另外两个pod处于Runing状态。由于设置了maxSurge=0,表示最多创建0个额外的pod副本,更新过程中有一个正在创建的pod以及两个正在运行的pod(正好三个),因此符合3个副本和0个额外副本的设置

观察升级过程,中间过程是滚动进行的,也就是边销毁边创建

[root@master ~]# kubectl get pods -n dev -w

NAME READY STATUS RESTARTS AGE

deployment-nginx-9588fc68c-5jn5v 1/1 Running 0 49m

deployment-nginx-9588fc68c-mmrcd 1/1 Running 0 49m

deployment-nginx-9588fc68c-s6dls 1/1 Running 0 49m

deployment-nginx-9588fc68c-5jn5v 1/1 Terminating 0 49m

deployment-nginx-86b659b6c4-znhh6 0/1 Pending 0 0s

deployment-nginx-86b659b6c4-znhh6 0/1 Pending 0 0s

deployment-nginx-86b659b6c4-znhh6 0/1 ContainerCreating 0 0s

deployment-nginx-9588fc68c-5jn5v 0/1 Terminating 0 49m

deployment-nginx-9588fc68c-5jn5v 0/1 Terminating 0 49m

deployment-nginx-9588fc68c-5jn5v 0/1 Terminating 0 49m

deployment-nginx-86b659b6c4-znhh6 1/1 Running 0 20s

deployment-nginx-9588fc68c-s6dls 1/1 Terminating 0 49m

deployment-nginx-86b659b6c4-cc4x4 0/1 Pending 0 0s

deployment-nginx-86b659b6c4-cc4x4 0/1 Pending 0 0s

deployment-nginx-86b659b6c4-cc4x4 0/1 ContainerCreating 0 0s

deployment-nginx-9588fc68c-s6dls 0/1 Terminating 0 49m

deployment-nginx-9588fc68c-s6dls 0/1 Terminating 0 49m

deployment-nginx-9588fc68c-s6dls 0/1 Terminating 0 49m

deployment-nginx-86b659b6c4-cc4x4 1/1 Running 0 32s

deployment-nginx-9588fc68c-mmrcd 1/1 Terminating 0 50m

deployment-nginx-86b659b6c4-qgrng 0/1 Pending 0 0s

deployment-nginx-86b659b6c4-qgrng 0/1 Pending 0 0s

deployment-nginx-86b659b6c4-qgrng 0/1 ContainerCreating 0 1s

deployment-nginx-9588fc68c-mmrcd 0/1 Terminating 0 50m

deployment-nginx-9588fc68c-mmrcd 0/1 Terminating 0 50m

deployment-nginx-9588fc68c-mmrcd 0/1 Terminating 0 50m

deployment-nginx-86b659b6c4-qgrng 1/1 Running 0 2s

[root@master ~]# kubectl describe deploy -n dev deployment-nginx

Events:

Type Reason Age From Message

Normal ScalingReplicaSet 61m deployment-controller Scaled up replica set deployment-nginx-dcbd8844d to 2

Normal ScalingReplicaSet 57m deployment-controller Scaled up replica set deployment-nginx-dcbd8844d to 5

Normal ScalingReplicaSet 54m deployment-controller Scaled down replica set deployment-nginx-dcbd8844d to 3

Normal ScalingReplicaSet 50m deployment-controller Scaled up replica set deployment-nginx-9588fc68c to 1

Normal ScalingReplicaSet 50m deployment-controller Scaled down replica set deployment-nginx-dcbd8844d to 2

Normal ScalingReplicaSet 50m deployment-controller Scaled up replica set deployment-nginx-9588fc68c to 2

Normal ScalingReplicaSet 50m deployment-controller Scaled down replica set deployment-nginx-dcbd8844d to 1

Normal ScalingReplicaSet 50m deployment-controller Scaled up replica set deployment-nginx-9588fc68c to 3

Normal ScalingReplicaSet 50m deployment-controller Scaled down replica set deployment-nginx-dcbd8844d to 0

Normal ScalingReplicaSet 102s deployment-controller Scaled down replica set deployment-nginx-9588fc68c to 2

Normal ScalingReplicaSet 102s deployment-controller Scaled up replica set deployment-nginx-86b659b6c4 to 1

Normal ScalingReplicaSet 82s deployment-controller Scaled down replica set deployment-nginx-9588fc68c to 1

Normal ScalingReplicaSet 82s deployment-controller Scaled up replica set deployment-nginx-86b659b6c4 to 2

Normal ScalingReplicaSet 50s deployment-controller Scaled down replica set deployment-nginx-9588fc68c to 0

Normal ScalingReplicaSet 50s deployment-controller Scaled up replica set deployment-nginx-86b659b6c4 to 3

发现镜像已更新,之前的rs还在,只不过replicas变为了0

[root@master ~]# kubectl get rs -n dev -o wide

NAME DESIRED CURRENT READY AGE CONTAINERS IMAGES SELECTOR

deployment-nginx-86b659b6c4 3 3 3 4m2s nginx nginx:1.8 app=nginx-deployment,pod-template-hash=86b659b6c4

deployment-nginx-9588fc68c 0 0 0 53m nginx nginx:1.17.1 app=nginx-deployment,pod-template-hash=9588fc68c

deployment-nginx-dcbd8844d 0 0 0 63m nginx nginx:1.16.1 app=nginx-deployment,pod-template-hash=dcbd8844d

[root@master ~]# kubectl get rs deployment-nginx-dcbd8844d -n dev -o yaml

spec:

replicas: 0

回滚

kubectl rollout: 版本升级相关功能,支持下面的选项:

kubectl rollout status 显示当前升级状态

kubectl rollout history 显示升级历史记录

kubectl rollout pause 暂停版本升级过程

kubectl rollout resume 继续已经暂停的版本升级过程

kubectl rollout restart 重启版本升级过程

kubectl rollout undo 回滚到上一级版本,可以使用 --to-revision回滚到指定版本

默认情况下 Deployment 的所有上线记录都保留在系统中,以便可以随时回滚 。假设你在更新 Deployment 时犯了一个拼写错误,将镜像名称命名设置为 nginx:1.161 而不是 nginx:1.61.1

kubectl set image deploy deployment-nginx nginx=nginx:1.161 -n dev --record

此上线进程会出现停滞,你可以通过检查上线状态来验证

[root@master ~]# kubectl rollout status deploy deployment-nginx -n dev

Waiting for deployment "deployment-nginx" rollout to finish: 1 out of 3 new replicas have been updated...

查看所创建的 Pod,你会注意到新 ReplicaSet 所创建的 1 个 Pod 卡顿在镜像拉取循环中

[root@master ~]# kubectl get pod -n dev

NAME READY STATUS RESTARTS AGE

deployment-nginx-8545c8f6d8-gzbcq 0/1 ImagePullBackOff 0 80s

deployment-nginx-86b659b6c4-cc4x4 1/1 Running 0 25m

deployment-nginx-86b659b6c4-znhh6 1/1 Running 0 26m

查看ReplicaSet发现新版本的 ReplicaSet(hash=8545c8f6d8)的水平扩展已经停止。而且此时它已经创建了一个 Pod,但是它们都没有进入 READY 状态。这当然是因为这个 Pod 都拉取不到有效的镜像。(nginx:1.161这个镜像在docker hub中并不存在,因此滚动更新被触发后会立即停止)。与此同时旧版本的 ReplicaSet(hash=86b659b6c4)的水平收缩,也自动停止了。此时已经有一个旧 Pod 被删除,还剩下两个旧 Pod

[root@master ~]# kubectl get rs -n dev

NAME DESIRED CURRENT READY AGE

deployment-nginx-8545c8f6d8 1 1 0 44s

deployment-nginx-86b659b6c4 2 2 2 25m

deployment-nginx-9588fc68c 0 0 0 74m

deployment-nginx-dcbd8844d 0 0 0 85m

Deployment 控制器自动停止有问题的上线过程,并停止对新的 ReplicaSet 扩容。 这行为取决于所指定的 rollingUpdate 参数(具体为 maxUnavailable)。 默认情况下,Kubernetes 将此值设置为 25%

[root@master ~]# kubectl describe deployment deployment-nginx -n dev

RollingUpdateStrategy: 1 max unavailable, 0 max surge

我们只需要执行一条 kubectl rollout undo 命令,就能把整个 Deployment 回滚到上一个版本,让这个旧 ReplicaSet(hash=86b659b6c4)再次扩展成 3 个 Pod,而让新的 ReplicaSet(hash=8545c8f6d8)重新收缩到 0 个 Pod

[root@master ~]# kubectl rollout undo deployment deployment-nginx -n dev

deployment.apps/deployment-nginx rolled back

[root@master ~]# kubectl get pod -n dev

NAME READY STATUS RESTARTS AGE

deployment-nginx-86b659b6c4-4gfn4 1/1 Running 0 24s

deployment-nginx-86b659b6c4-cc4x4 1/1 Running 0 30m

deployment-nginx-86b659b6c4-znhh6 1/1 Running 0 30m

[root@master ~]# kubectl get rs -n dev

NAME DESIRED CURRENT READY AGE

deployment-nginx-8545c8f6d8 0 0 0 6m32s

deployment-nginx-86b659b6c4 3 3 3 31m

deployment-nginx-9588fc68c 0 0 0 80m

deployment-nginx-dcbd8844d 0 0 0 91m

如果我想回滚到更早之前的版本,可以通过 kubectl rollout history 命令,查看每次 Deployment 变更对应的版本。由于我们在创建这个 Deployment 的时候,指定了--record 参数,所以我们创建这些版本时执行的 kubectl 命令,都会被记录下来。如果执行命令时没有指定--record参数,那么 CHANGE-CAUSE 字段记录值为<none>

[root@master ~]# kubectl rollout history deploy deployment-nginx -n dev

deployment.apps/deployment-nginx

REVISION CHANGE-CAUSE

1 <none>

2 kubectl set image deployment deployment-nginx nginx=nginx:1.17.1 --namespace=dev --record=true

4 kubectl set image deploy deployment-nginx nginx=nginx:1.161 --namespace=dev --record=true

5 kubectl apply --filename=nginx-deploy.yaml --record=true

你还可以通过这个 kubectl rollout history 指令,看到每个版本对应的 Deployment 的 API 对象的细节

kubectl rollout history deploy deployment-nginx -n dev --revision=2

然后,我们就可以在 kubectl rollout undo 命令行最后,加上要回滚到的指定版本的版本号,就可以回滚到指定版本了。直接使用--to-revision=2回滚到了2版本, 如果省略这个选项,就是回退到上个版本。

kubectl rollout undo deploy deployment-nginx -n dev --to-revision=2

这样Deployment Controller 还会按照滚动更新的方式,完成对 Deployment 的降级操作

[root@master ~]# kubectl get rs -n dev -o wide

NAME DESIRED CURRENT READY AGE CONTAINERS IMAGES SELECTOR

deployment-nginx-8545c8f6d8 0 0 0 18m nginx nginx:1.161 app=nginx-deployment,pod-template-hash=8545c8f6d8

deployment-nginx-86b659b6c4 0 0 0 43m nginx nginx:1.8 app=nginx-deployment,pod-template-hash=86b659b6c4

deployment-nginx-9588fc68c 3 3 3 92m nginx nginx:1.17.1 app=nginx-deployment,pod-template-hash=9588fc68c

deployment-nginx-dcbd8844d 0 0 0 103m nginx nginx:1.16.1 app=nginx-deployment,pod-template-hash=dcbd8844d

回滚后,历史版本会新+1

kubectl rollout history deploy deployment-nginx -n dev

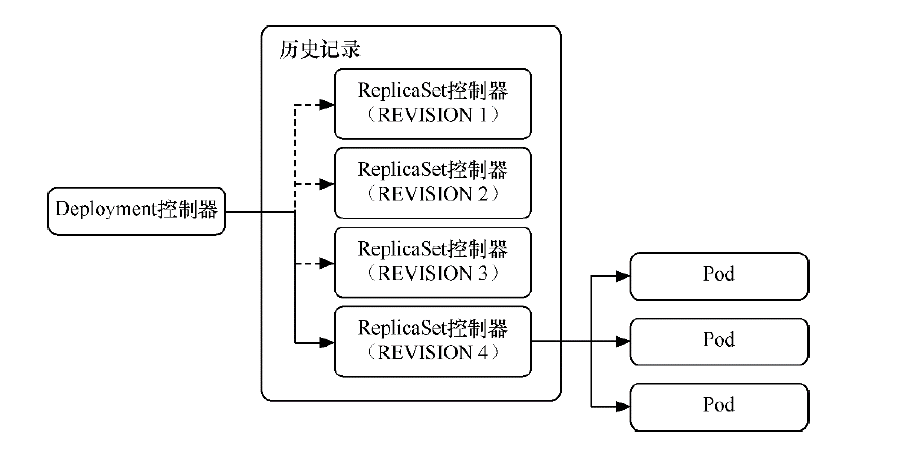

其实deployment之所以可是实现版本的回滚,就是通过记录历史RS来实现的,一旦想回滚到哪个版本,只需要将当前版本pod数量降为0,然后将回滚版本的pod提升为目标数量就可以了。保留历史记录的本质是保留每次修改创建的RS控制器,而回滚的本质是切换到对应版本的RS控制器。deployment对象spec.revisionHistoryLimit字段就是k8s为deployment保留的历史版本个数,如果设置为0,那么就再也不能进行回滚操作了

通过控制RS,比如创建新RS,旧RS就会把里面的pod副本数一个个转移到新RS,达到滚动更新,滚动更新以后旧RS并没有被删除,而是被停用,如果想要用旧RS,达到回滚

更新的暂停与恢复

无论是直接更新还是滚动更新,都会一直更新到结束。但为了避免更新有问题,可以尝试只更新一个pod,待这个pod验证无误后,再更新其它pod。Deployment控制器支持控制更新过程中的控制,如暂停(pause)或继续(resume)更新操作

kubectl rollout pause deployment <deployment name> #暂停

kubectl rollout resume deployment <deployment name> #恢复

比如有一批新的Pod资源创建完成后立即暂停更新过程,此时,仅存在一部分新版本的应用,主体部分还是旧的版本。然后,再筛选一小部分的用户请求路由到新版本的Pod应用,继续观察能否稳定地按期望的方式运行。确定没问题之后再继续完成余下的Pod资源滚动更新,否则立即回滚更新操作。这就是所谓的金丝雀发布

例如,对于一个刚刚创建的 Deployment,获取 Deployment 信息:

[root@master ~]# kubectl get deploy -n dev -owide

NAME READY UP-TO-DATE AVAILABLE AGE CONTAINERS IMAGES SELECTOR

deployment-nginx 3/3 3 3 8s nginx nginx:1.8 app=nginx-deployment

[root@master ~]# kubectl get rs -n dev -owide

NAME DESIRED CURRENT READY AGE CONTAINERS IMAGES SELECTOR

deployment-nginx-86b659b6c4 3 3 3 14s nginx nginx:1.8 app=nginx-deployment,pod-template-hash=86b659b6c4

更新deployment的版本,并配置暂停deployment,升级完第一个pod后会立即暂停后续操作

kubectl set image deploy deployment-nginx nginx=nginx:1.17.4 -n dev && kubectl rollout pause deployment deployment-nginx -n dev

查看pod状态

[root@master ~]# kubectl get deploy -n dev -o wide

NAME READY UP-TO-DATE AVAILABLE AGE CONTAINERS IMAGES SELECTOR

deployment-nginx 3/3 1 3 36s nginx nginx:1.17.4 app=nginx-deployment

[root@master ~]# kubectl get rs -n dev -o wide

NAME DESIRED CURRENT READY AGE CONTAINERS IMAGES SELECTOR

deployment-nginx-749c54bf88 1 1 1 15s nginx nginx:1.17.4 app=nginx-deployment,pod-template-hash=749c54bf88

deployment-nginx-86b659b6c4 2 2 2 44s nginx nginx:1.8 app=nginx-deployment,pod-template-hash=86b659b6c4

验证新版本Pod是否有问题

[root@master ~]# kubectl get pod -n dev -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

deployment-nginx-749c54bf88-dv6wd 1/1 Running 0 39s 10.244.1.132 node1 <none> <none>

deployment-nginx-86b659b6c4-rwwjv 1/1 Running 0 68s 10.244.2.169 node2 <none> <none>

deployment-nginx-86b659b6c4-sqnlt 1/1 Running 0 68s 10.244.1.131 node1 <none> <none>

[root@master ~]# curl -I 10.244.1.132

HTTP/1.1 200 OK

Server: nginx/1.17.4

验证没有问题后,就可以结束暂停了,让剩余的Pod继续更新为最新版

kubectl rollout resume deploy deployment-nginx -n dev

观察更新状态

[root@master ~]# kubectl rollout status deploy deployment-nginx -n dev

Waiting for deployment "deployment-nginx" rollout to finish: 2 out of 3 new replicas have been updated...

Waiting for deployment "deployment-nginx" rollout to finish: 2 out of 3 new replicas have been updated...

Waiting for deployment "deployment-nginx" rollout to finish: 2 out of 3 new replicas have been updated...

Waiting for deployment "deployment-nginx" rollout to finish: 2 of 3 updated replicas are available...

deployment "deployment-nginx" successfully rolled out

监控更新的过程,可以看到已经新增了一个资源,但是并未按照预期的状态去删除一个旧的资源,就是因为使用了pause暂停命令

[root@master ~]# kubectl get deploy -n dev -o wide

NAME READY UP-TO-DATE AVAILABLE AGE CONTAINERS IMAGES SELECTOR

deployment-nginx 3/3 3 3 4m6s nginx nginx:1.17.4 app=nginx-deployment

[root@master ~]# kubectl get rs -n dev -o wide

NAME DESIRED CURRENT READY AGE CONTAINERS IMAGES SELECTOR

deployment-nginx-749c54bf88 3 3 3 4m7s nginx nginx:1.17.4 app=nginx-deployment,pod-template-hash=749c54bf88

deployment-nginx-86b659b6c4 0 0 0 4m36s nginx nginx:1.8 app=nginx-deployment,pod-template-hash=86b659b6c4

[root@master ~]# kubectl get pod -n dev -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

deployment-nginx-749c54bf88-dv6wd 1/1 Running 0 4m23s 10.244.1.132 node1 <none> <none>

deployment-nginx-749c54bf88-n2b82 1/1 Running 0 84s 10.244.2.170 node2 <none> <none>

deployment-nginx-749c54bf88-thd8s 1/1 Running 0 82s 10.244.1.133 node1 <none> <none>

Deployment删除

删除deployment,其下的RS和pod也将被删除

kubectl delete -f nginx-deploy.yaml # 基于模板文件删除资源

kubectl delete deploy deployment-nginx -n dev # 删除deployment

查看是否被删除

[root@master ~]# kubectl get deploy -n dev

No resources found in dev namespace.

[root@master ~]# kubectl get rs -n dev

No resources found in dev namespace.

[root@master ~]# kubectl get pod -n dev

No resources found in dev namespace.

如果某台服务器宕机或关机,那么在该节点上的pod将变成了ternminating状态,表示已经终止。另外还有新的pod在创建,所以控制器保证集群中的pod数量与配置中期望的pod数量保持一致

部署策略

在Kubernetes中有几种不同的方式发布应用,所以为了让应用在升级期间依然平稳提供服务,选择一个正确的发布策略就非常重要了。选择正确的部署策略是要依赖于我们的业务需求的,下面我们列出了一些可能会使用到的策略:

重建(recreate):停止旧版本部署新版本

滚动更新(rolling-update):一个接一个地以滚动更新方式发布新版本

蓝绿(blue/green):新版本与旧版本一起存在,然后切换流量

金丝雀(canary):将新版本面向一部分用户发布,然后继续全量发布

A/B测(a/b testing):以精确的方式(HTTP 头、cookie、权重等)向部分用户发布新版本。A/B测实际上是一种基于数据统计做出业务决策的技术。在 Kubernetes 中并不原生支持,需要额外的一些高级组件来完成改设置(比如Istio、Linkerd、Traefik、或者自定义 Nginx/Haproxy 等)。

你可以在Kubernetes集群上来对上面的这些策略进行测试,下面的仓库中有需要使用到的资源清单:https://github.com/ContainerSolutions/k8s-deployment-strategies

接下来我们来介绍下每种策略,看看在什么场景下面适合哪种策略。

重建(Recreate)

策略定义为Recreate的Deployment,直接删除当前控制器下的所有pod,之后新建更新后的RS控制器及pod

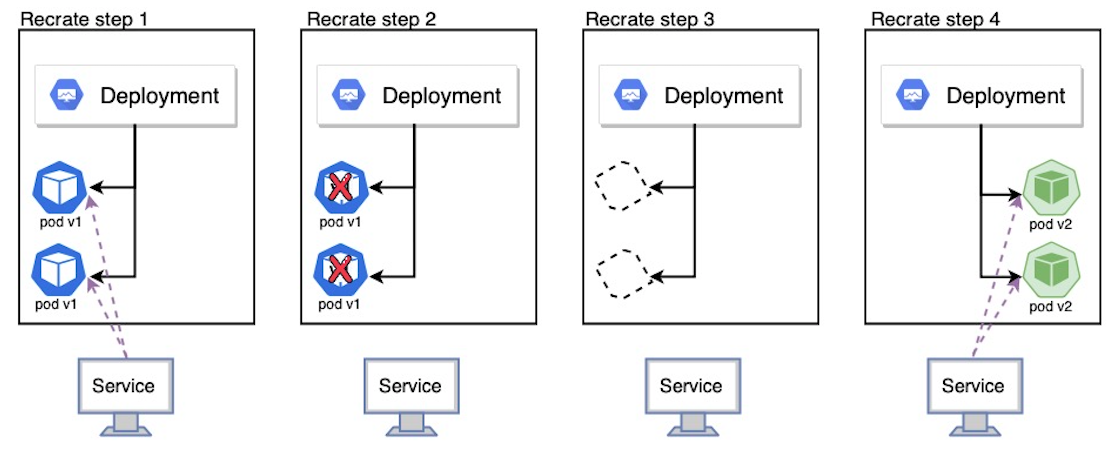

下图是重新创建过程应用接收流量的示意图:

重新创建策略是一个虚拟部署,包括关闭版本A,然后在关闭版本A后部署版本B。此技术意味着服务的停机时间取决于应用程序的关闭和启动持续时间。我们这里创建两个相关的资源清单文件

app-v1.yaml文件内容如下:

apiVersion: v1

kind: Service

metadata:

name: my-app

labels:

app: my-app

spec:

type: NodePort

ports:

- name: http

port: 80

targetPort: http

selector:

app: my-app

---

apiVersion: apps/v1

kind: Deployment

metadata:

name: my-app

labels:

app: my-app

spec:

replicas: 3

selector:

matchLabels:

app: my-app

strategy:

type: Recreate

selector:

matchLabels:

app: my-app

template:

metadata:

labels:

app: my-app

version: v1.0.0

annotations:

prometheus.io/scrape: "true"

prometheus.io/port: "9101"

spec:

containers:

- name: my-app

image: containersol/k8s-deployment-strategies

ports:

- name: http

containerPort: 8080

- name: probe

containerPort: 8086

env:

- name: VERSION

value: v1.0.0

livenessProbe:

httpGet:

path: /live

port: probe

initialDelaySeconds: 5

periodSeconds: 5

readinessProbe:

httpGet:

path: /ready

port: probe

periodSeconds: 5

app-v2.yaml 文件内容如下:

apiVersion: apps/v1

kind: Deployment

metadata:

name: my-app

labels:

app: my-app

spec:

replicas: 3

strategy:

type: Recreate

selector:

matchLabels:

app: my-app

template:

metadata:

labels:

app: my-app

version: v2.0.0

annotations:

prometheus.io/scrape: "true"

prometheus.io/port: "9101"

spec:

containers:

- name: my-app

image: containersol/k8s-deployment-strategies

ports:

- name: http

containerPort: 8080

- name: probe

containerPort: 8086

env:

- name: VERSION

value: v2.0.0

livenessProbe:

httpGet:

path: /live

port: probe

initialDelaySeconds: 5

periodSeconds: 5

readinessProbe:

httpGet:

path: /ready

port: probe

periodSeconds: 5

上面两个资源清单文件中的 Deployment 定义几乎是一直的,唯一不同的是定义的环境变量VERSION值不同,接下来按照下面的步骤来验证Recreate策略:

- 版本1提供服务

- 删除版本1

- 部署版本2

- 等待所有副本准备就绪

首先部署第一个应用

kubectl apply -f app-v1.yaml

测试版本1是否部署成功

[root@master ~]# kubectl get pods -l app=my-app

NAME READY STATUS RESTARTS AGE

my-app-6964668d64-6nv6j 1/1 Running 0 21s

my-app-6964668d64-d5vjs 1/1 Running 0 21s

my-app-6964668d64-xdr45 1/1 Running 0 21s

[root@master ~]# kubectl get svc my-app

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

my-app NodePort 10.96.83.121 <none> 80:31924/TCP 40s

[root@master ~]# curl 10.96.83.121:80

Host: my-app-6964668d64-d5vjs, Version: v1.0.0

可以看到版本1的应用正常运行了,为了查看部署的运行情况,打开一个新终端并运行以下命令

kubectl get pod -l app=my-app -w

然后部署版本2的应用

kubectl apply -f app-v2.yaml

然后测试第二个版本应用的部署进度:

[root@master ~]# while sleep 0.1; do curl http://127.0.0.1:31924; done

curl: (7) Failed connect to 127.0.0.1:31924; Connection refused

curl: (7) Failed connect to 127.0.0.1:31924; Connection refused

......

Host: my-app-5c967c586b-bzqjp, Version: v2.0.0

Host: my-app-5c967c586b-nhscj, Version: v2.0.0

Host: my-app-5c967c586b-f5zb8, Version: v2.0.0

......

这个时候可以观察上面新开的终端中的 Pod 列表的变化,可以看到之前的3个 Pod 都会先处于Terminating状态,并且3个 Pod 都被删除后才开始创建新的 Pod

[root@master ~]# kubectl get pod -l app=my-app -w

NAME READY STATUS RESTARTS AGE

my-app-6964668d64-6nv6j 1/1 Running 0 115s

my-app-6964668d64-d5vjs 1/1 Running 0 115s

my-app-6964668d64-xdr45 1/1 Running 0 115s

my-app-6964668d64-6nv6j 1/1 Terminating 0 2m7s

my-app-6964668d64-d5vjs 1/1 Terminating 0 2m7s

my-app-6964668d64-xdr45 1/1 Terminating 0 2m7s

my-app-6964668d64-6nv6j 0/1 Terminating 0 2m7s

my-app-6964668d64-d5vjs 0/1 Terminating 0 2m7s

my-app-6964668d64-xdr45 0/1 Terminating 0 2m7s

my-app-6964668d64-6nv6j 0/1 Terminating 0 2m7s

my-app-6964668d64-d5vjs 0/1 Terminating 0 2m7s

my-app-6964668d64-6nv6j 0/1 Terminating 0 2m8s

my-app-6964668d64-d5vjs 0/1 Terminating 0 2m8s

my-app-6964668d64-xdr45 0/1 Terminating 0 2m8s

my-app-6964668d64-xdr45 0/1 Terminating 0 2m8s

my-app-5c967c586b-nhscj 0/1 Pending 0 0s

my-app-5c967c586b-nhscj 0/1 Pending 0 0s

my-app-5c967c586b-f5zb8 0/1 Pending 0 0s

my-app-5c967c586b-bzqjp 0/1 Pending 0 0s

my-app-5c967c586b-nhscj 0/1 ContainerCreating 0 0s

my-app-5c967c586b-f5zb8 0/1 Pending 0 0s

my-app-5c967c586b-bzqjp 0/1 Pending 0 0s

my-app-5c967c586b-bzqjp 0/1 ContainerCreating 0 0s

my-app-5c967c586b-f5zb8 0/1 ContainerCreating 0 0s

my-app-5c967c586b-f5zb8 0/1 Running 0 16s

my-app-5c967c586b-f5zb8 1/1 Running 0 17s

my-app-5c967c586b-bzqjp 0/1 Running 0 17s

my-app-5c967c586b-bzqjp 1/1 Running 0 17s

my-app-5c967c586b-nhscj 0/1 Running 0 33s

my-app-5c967c586b-nhscj 1/1 Running 0 33s

发现镜像已更新,之前的rs已经停用

[root@master ~]# kubectl get rs -l app=my-app -owide

NAME DESIRED CURRENT READY AGE CONTAINERS IMAGES SELECTOR

my-app-5c967c586b 3 3 3 10m my-app containersol/k8s-deployment-strategies app=my-app,pod-template-hash=5c967c586b

my-app-6964668d64 0 0 0 12m my-app containersol/k8s-deployment-strategies app=my-app,pod-template-hash=6964668d64

Recreate更新方式直接删除当前控制器下的所有pod,只保留旧的rs控制器的定义,之后新建更新后的rs控制器及pod

最后,可以执行下面的命令来清空上面的资源对象

kubectl delete all -l app=my-app

滚动更新(rolling-update)

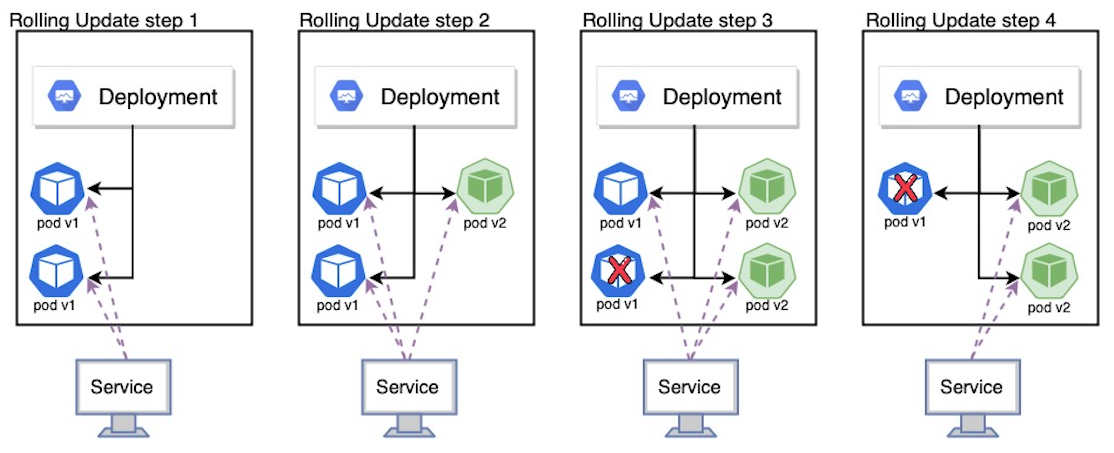

滚动更新通过逐个替换实例来逐步部署新版本的应用,直到所有实例都被替换完成为止。它通常遵循以下过程:在负载均衡器后面使用版本 A 的实例池,然后部署版本 B 的一个实例,当服务准备好接收流量时(Readiness Probe 正常),将该实例添加到实例池中,然后从实例池中删除一个版本 A 的实例并关闭,如下图所示:

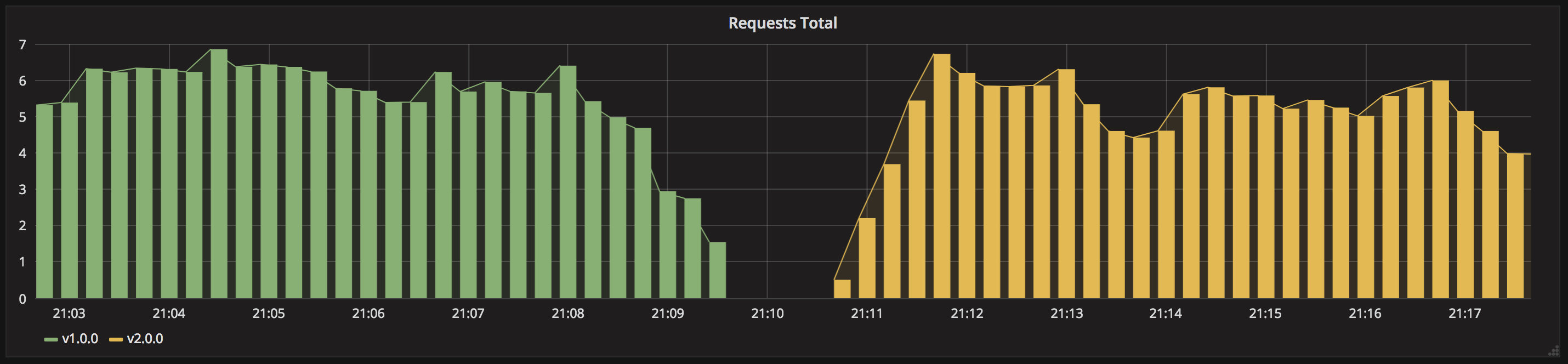

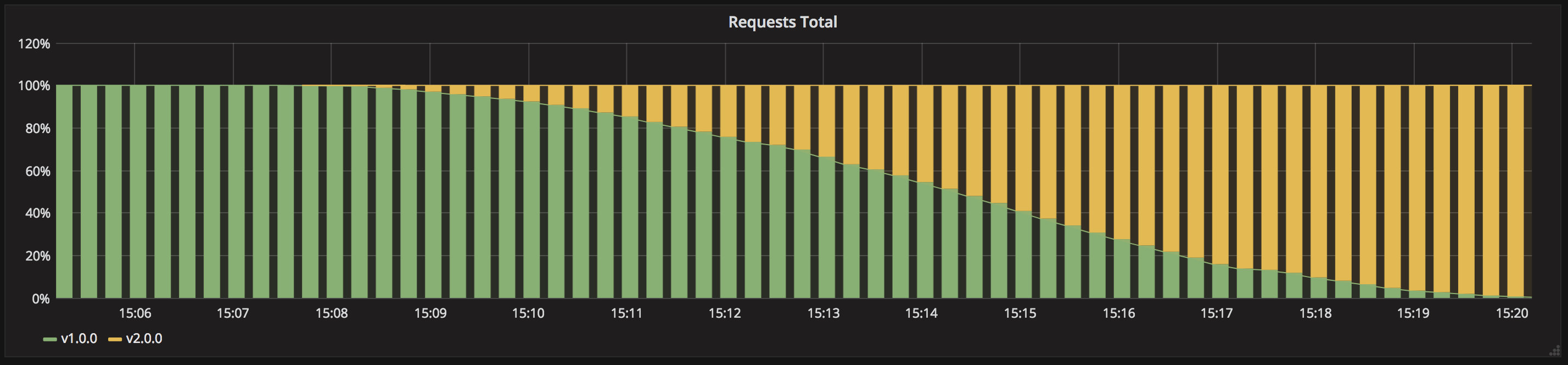

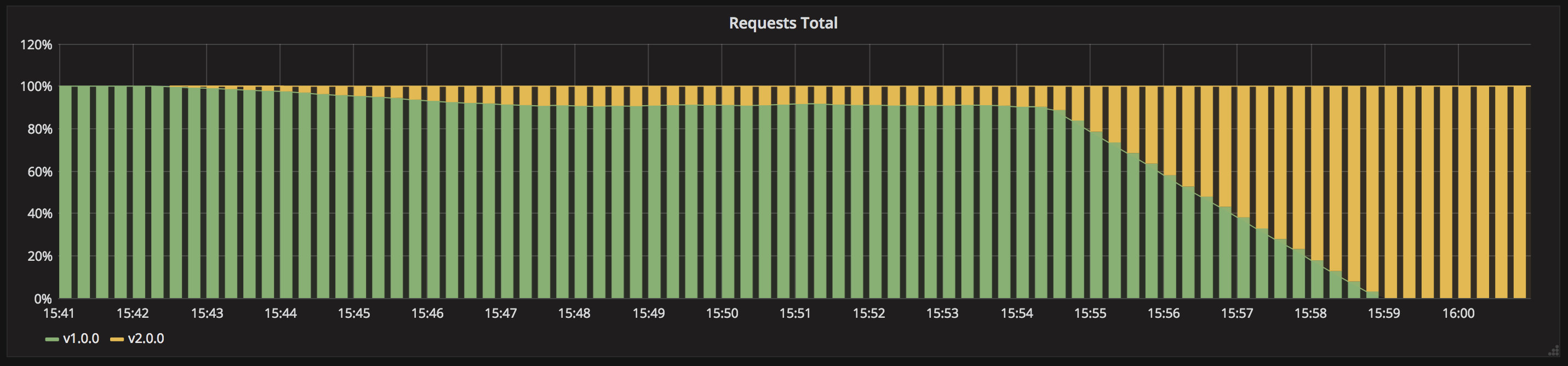

下图是滚动更新过程应用接收流量的示意图:

下面是 Kubernetes 中通过 Deployment 来进行滚动更新的关键参数

spec:

replicas: 3

strategy:

type: RollingUpdate

rollingUpdate:

maxSurge: 2 # 一次可以添加多少个Pod

maxUnavailable: 1 # 滚动更新期间最大多少个Pod不可用

现在仍然使用上面的 app-v1.yaml 这个资源清单文件,新建一个定义滚动更新的资源清单文件 app-v2-rolling-update.yaml,文件内容如下:

apiVersion: apps/v1

kind: Deployment

metadata:

name: my-app

labels:

app: my-app

spec:

replicas: 10

# maxUnavailable设置为0可以完全确保在滚动更新期间服务不受影响,还可以使用百分比的值来进行设置。

strategy:

type: RollingUpdate

rollingUpdate:

maxSurge: 1

maxUnavailable: 0

selector:

matchLabels:

app: my-app

template:

metadata:

labels:

app: my-app

version: v2.0.0

annotations:

prometheus.io/scrape: "true"

prometheus.io/port: "9101"

spec:

containers:

- name: my-app

image: containersol/k8s-deployment-strategies

ports:

- name: http

containerPort: 8080

- name: probe

containerPort: 8086

env:

- name: VERSION

value: v2.0.0

livenessProbe:

httpGet:

path: /live

port: probe

initialDelaySeconds: 5

periodSeconds: 5

readinessProbe:

httpGet:

path: /ready

port: probe

# 初始延迟设置高点可以更好地观察滚动更新过程

initialDelaySeconds: 15

periodSeconds: 5

上面的资源清单中我们在环境变量中定义了版本2,然后通过设置strategy.type=RollingUpdate来定义该 Deployment 使用滚动更新的策略来更新应用,接下来我们按下面的步骤来验证滚动更新策略:

- 版本1提供服务

- 部署版本2

- 等待直到所有副本都被版本2替换完成

首先部署版本1应用

kubectl apply -f app-v1.yaml

测试版本1是否部署成功

[root@master ~]# kubectl get pods -l app=my-app

NAME READY STATUS RESTARTS AGE

my-app-7b4874cd75-h8c4d 1/1 Running 0 47s

my-app-7b4874cd75-p4l8f 1/1 Running 0 47s

my-app-7b4874cd75-qnt7p 1/1 Running 0 47s

[root@master ~]# kubectl get svc my-app

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

my-app NodePort 10.109.99.184 <none> 80:30486/TCP 1m

[root@master ~]# curl http://127.0.0.1:30486

Host: my-app-7b4874cd75-qnt7p, Version: v1.0.0

可以看到版本1的应用正常运行了,为了查看部署的运行情况,打开一个新终端并运行以下命令

kubectl get pod -l app=my-app -w

然后部署滚动更新版本2应用

kubectl apply -f app-v2-rolling-update.yaml

这个时候在上面的 watch 终端中可以看到多了很多 Pod,还在创建当中,并没有一开始就删除之前的 Pod,同样,这个时候执行下面命令,测试应用状态:

[root@master ~]# while sleep 0.1; do curl http://127.0.0.1:30486; done

Host: my-app-7b4874cd75-vrlj7, Version: v1.0.0

......

Host: my-app-7b4874cd75-vrlj7, Version: v1.0.0

Host: my-app-6b5479d97f-2fk24, Version: v2.0.0

Host: my-app-7b4874cd75-p4l8f, Version: v1.0.0

......

Host: my-app-6b5479d97f-s5ctz, Version: v2.0.0

Host: my-app-7b4874cd75-5ldqx, Version: v1.0.0

......

Host: my-app-6b5479d97f-5z6ww, Version: v2.0.0

们可以看到上面的应用并没有出现不可用的情况,最开始访问到的都是版本1的应用,然后偶尔会出现版本2的应用,直到最后全都变成了版本2的应用,而这个时候看上面 watch 终端中 Pod 已经全部变成10个版本2的应用了,我们可以看到这就是一个逐步替换的过程。

如果在滚动更新过程中发现新版本应用有问题,我们可以通过下面的命令来进行一键回滚:

kubectl rollout undo deploy my-app

如果你想保持两个版本的应用都存在,那么我们也可以执行 pause 命令来暂停更新:

kubectl rollout pause deploy my-app

这个时候我们再去循环访问我们的应用,就可以看到偶尔会出现版本1的应用信息了。如果新版本应用程序没问题了,也可以继续恢复更新:

kubectl rollout resume deploy my-app

最后,可以执行下面的命令来清空上面的资源对象:

kubectl delete all -l app=my-app

蓝/绿(blue/green)

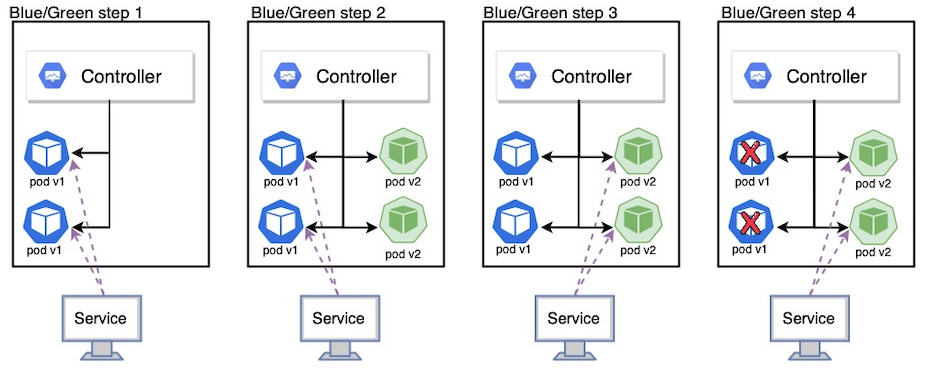

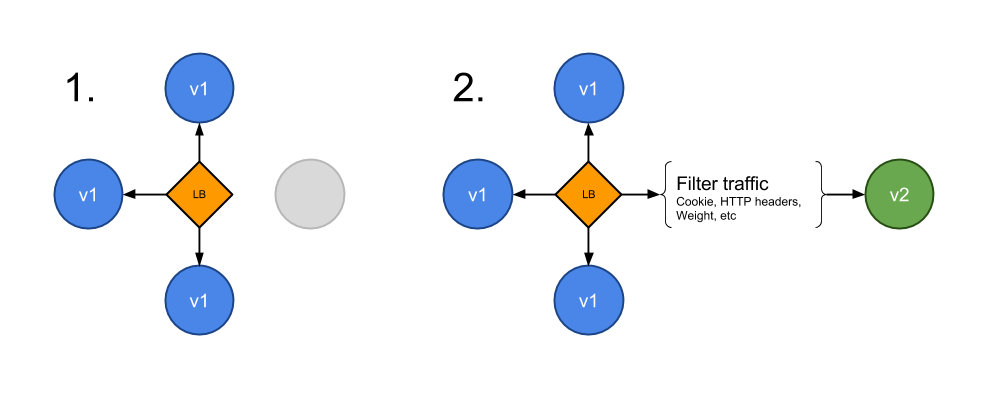

蓝/绿发布是 版本2 与 版本1 一起发布,然后流量切换到版本2,也称为红/黑部署。蓝/绿发布与滚动更新不同,版本2(绿) 与版本1(蓝)一起部署,在测试新版本满足要求后,然后更新更新 Kubernetes 中扮演负载均衡器角色的 Service 对象,通过替换 label selector 中的版本标签来将流量发送到新版本,如下图所示:

下面是蓝绿发布策略下应用方法的示例图:

在 Kubernetes 中,我们可以用两种方法来实现蓝绿发布,通过单个 Service 对象或者 Ingress 控制器来实现蓝绿发布,实现蓝绿发布的关键点就在于 Service 对象中 label selector 标签的匹配方法,比如我们重新定义版本1 的资源清单文件 app-v1-single-svc.yaml,文件内容如下:

apiVersion: v1

kind: Service

metadata:

name: my-app

labels:

app: my-app

spec:

type: NodePort

ports:

- name: http

port: 80

targetPort: http

# 注意这里我们匹配 app 和 version 标签,当要切换流量的时候,我们更新 version 标签的值,比如:v2.0.0

selector:

app: my-app

version: v1.0.0

---

apiVersion: apps/v1

kind: Deployment

metadata:

name: my-app-v1

labels:

app: my-app

spec:

replicas: 3

selector:

matchLabels:

app: my-app

version: v1.0.0

template:

metadata:

labels:

app: my-app

version: v1.0.0

annotations:

prometheus.io/scrape: "true"

prometheus.io/port: "9101"

spec:

containers:

- name: my-app

image: containersol/k8s-deployment-strategies

ports:

- name: http

containerPort: 8080

- name: probe

containerPort: 8086

env:

- name: VERSION

value: v1.0.0

livenessProbe:

httpGet:

path: /live

port: probe

initialDelaySeconds: 5

periodSeconds: 5

readinessProbe:

httpGet:

path: /ready

port: probe

periodSeconds: 5

上面定义的资源对象中,最重要的就是 Service 中 label selector 的定义:

selector:

app: my-app

version: v1.0.0

版本2 的应用定义和以前一样,新建文件 app-v2-single-svc.yaml,文件内容如下:

apiVersion: apps/v1

kind: Deployment

metadata:

name: my-app-v2

labels:

app: my-app

spec:

replicas: 3

selector:

matchLabels:

app: my-app

version: v2.0.0

template:

metadata:

labels:

app: my-app

version: v2.0.0

annotations:

prometheus.io/scrape: "true"

prometheus.io/port: "9101"

spec:

containers:

- name: my-app

image: containersol/k8s-deployment-strategies

ports:

- name: http

containerPort: 8080

- name: probe

containerPort: 8086

env:

- name: VERSION

value: v2.0.0

livenessProbe:

httpGet:

path: /live

port: probe

initialDelaySeconds: 5

periodSeconds: 5

readinessProbe:

httpGet:

path: /ready

port: probe

periodSeconds: 5

然后按照下面的步骤来验证使用单个 Service 对象实现蓝/绿部署的策略:

1、版本1 应用提供服务

2、部署版本2 应用

3、等到版本2 应用全部部署完成,切换入口流量从版本1 到版本2,关闭版本1 应用

首先,部署版本1 应用

kubectl apply -f app-v1-single-svc.yaml

测试版本1 应用是否部署成功

[root@master ~]# kubectl get pods -l app=my-app

NAME READY STATUS RESTARTS AGE

my-app-v1-6964668d64-lwbqm 1/1 Running 0 55s

my-app-v1-6964668d64-n7fpd 1/1 Running 0 55s

my-app-v1-6964668d64-rlf7n 1/1 Running 0 55s

[root@master ~]# kubectl get svc -l app=my-app

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

my-app NodePort 10.96.134.46 <none> 80:32211/TCP 67s

[root@master ~]# curl http://127.0.0.1:32211

Host: my-app-v1-6964668d64-n7fpd, Version: v1.0.0

同样,新开一个终端,执行如下命令观察 Pod 变化

kubectl get pod -l app=my-app -w

然后部署版本2 应用

kubectl apply -f app-v2-single-svc.yaml

然后在上面 watch 终端中可以看到会多3个my-app-v2开头的 Pod,待这些 Pod 部署成功后,我们再去访问当前的应用

[root@master ~]# while sleep 0.1; do curl http://127.0.0.1:32211; done

Host: my-app-v1-6964668d64-lwbqm, Version: v1.0.0

Host: my-app-v1-6964668d64-n7fpd, Version: v1.0.0

Host: my-app-v1-6964668d64-rlf7n, Version: v1.0.0

......

我们会发现访问到的都是版本1 的应用,和我们刚刚部署的版本2 没有任何关系,这是因为我们 Service 对象中通过 label selector 匹配的是version=v1.0.0这个标签,我们可以通过修改 Service 对象的匹配标签,将流量路由到标签version=v2.0.0的 Pod 去

kubectl patch service my-app -p '{"spec":{"selector":{"version":"v2.0.0"}}}'

然后再去访问应用,可以发现现在都是版本2 的信息了

[root@master ~]# while sleep 0.1; do curl http://127.0.0.1:32211; done

Host: my-app-v2-5c967c586b-mshb9, Version: v2.0.0

Host: my-app-v2-5c967c586b-h4pt7, Version: v2.0.0

Host: my-app-v2-5c967c586b-k68l5, Version: v2.0.0

......

如果你需要回滚到版本1,同样只需要更改 Service 的匹配标签即可

$ kubectl patch service my-app -p '{"spec":{"selector":{"version":"v1.0.0"}}}'

如果新版本已经完全符合我们的需求了,就可以删除版本1 的应用了

kubectl delete deploy my-app-v1

最后,同样执行如下命令清理上述资源对象

kubectl delete all -l app=my-app

金丝雀

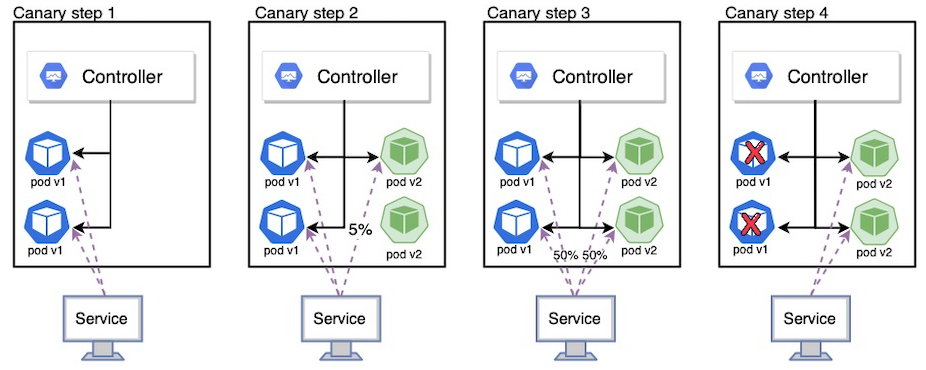

金丝雀部署是让部分用户访问到新版本应用,在 Kubernetes 中,可以使用两个具有相同 Pod 标签的 Deployment 来实现金丝雀部署。新版本的副本和旧版本的一起发布。在一段时间后如果没有检测到错误,则可以扩展新版本的副本数量并删除旧版本的应用。

如果需要按照具体的百分比来进行金丝雀发布,需要尽可能的启动多的 Pod 副本,这样计算流量百分比的时候才方便,比如,如果你想将 1% 的流量发送到版本 B,那么我们就需要有一个运行版本 B 的 Pod 和 99 个运行版本 A 的 Pod,当然如果你对具体的控制策略不在意的话也就无所谓了,如果你需要更精确的控制策略,建议使用服务网格(如 Istio),它们可以更好地控制流量。

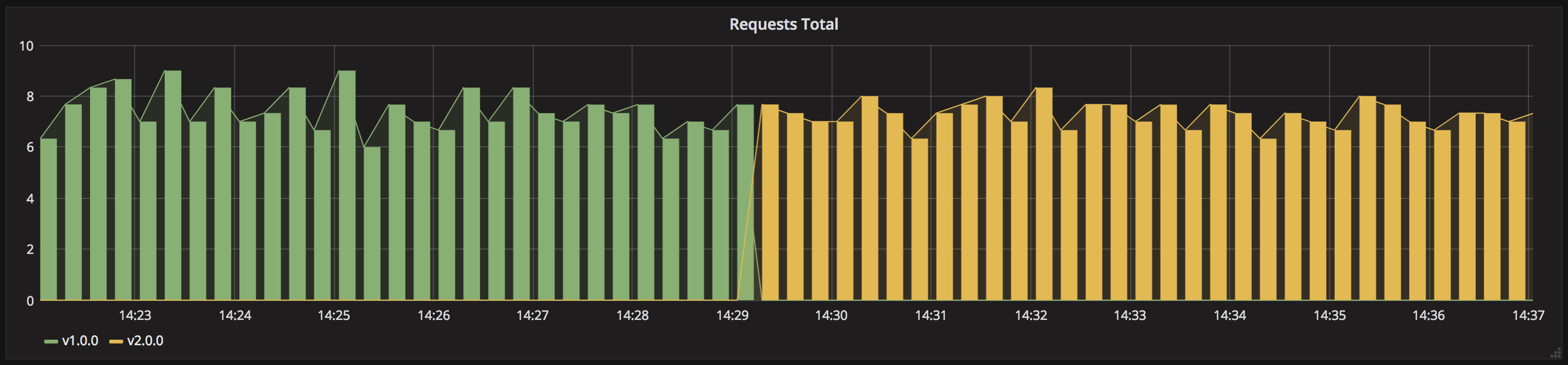

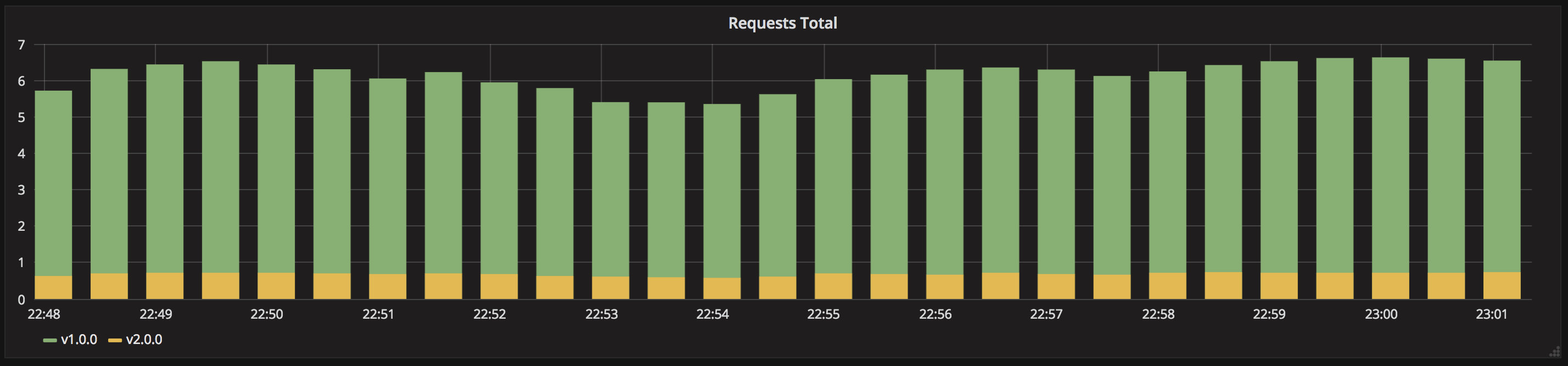

在下面的例子中,我们使用 Kubernetes 原生特性来实现一个穷人版的金丝雀发布,如果你想要对流量进行更加细粒度的控制,请使用豪华版本的 Istio。下面是金丝雀发布的应用请求示意图:

接下来我们按照下面的步骤来验证金丝雀策略:

- 10个副本的版本1 应用提供服务

- 版本2 应用部署1个副本(意味着小于10%的流量)

- 等待足够的时间来确认版本2 应用足够稳定没有任何错误信息

- 将版本2 应用扩容到10个副本

- 等待所有实例完成

- 关闭版本1 应用

首先,创建版本1 的应用资源清单 app-v1-canary.yaml,内容如下:

apiVersion: v1

kind: Service

metadata:

name: my-app

labels:

app: my-app

spec:

type: NodePort

ports:

- name: http

port: 80

targetPort: http

selector:

app: my-app

---

apiVersion: apps/v1

kind: Deployment

metadata:

name: my-app-v1

labels:

app: my-app

spec:

replicas: 10

selector:

matchLabels:

app: my-app

version: v1.0.0

template:

metadata:

labels:

app: my-app

version: v1.0.0

annotations:

prometheus.io/scrape: "true"

prometheus.io/port: "9101"

spec:

containers:

- name: my-app

image: containersol/k8s-deployment-strategies

ports:

- name: http

containerPort: 8080

- name: probe

containerPort: 8086

env:

- name: VERSION

value: v1.0.0

livenessProbe:

httpGet:

path: /live

port: probe

initialDelaySeconds: 5

periodSeconds: 5

readinessProbe:

httpGet:

path: /ready

port: probe

periodSeconds: 5

其中核心的部分也是 Service 对象中的 label selector 标签,不在具有版本相关的标签了,然后定义版本2 的资源清单文件app-v2-canary.yaml,文件内容如下:

apiVersion: apps/v1

kind: Deployment

metadata:

name: my-app-v2

labels:

app: my-app

spec:

replicas: 1

selector:

matchLabels:

app: my-app

version: v2.0.0

template:

metadata:

labels:

app: my-app

version: v2.0.0

annotations:

prometheus.io/scrape: "true"

prometheus.io/port: "9101"

spec:

containers:

- name: my-app

image: containersol/k8s-deployment-strategies

ports:

- name: http

containerPort: 8080

- name: probe

containerPort: 8086

env:

- name: VERSION

value: v2.0.0

livenessProbe:

httpGet:

path: /live

port: probe

initialDelaySeconds: 5

periodSeconds: 5

readinessProbe:

httpGet:

path: /ready

port: probe

periodSeconds: 5

版本1 和版本2 的 Pod 都具有一个共同的标签app=my-app,所以对应的 Service 会匹配两个版本的 Pod。

首先,部署版本1 应用

kubectl apply -f app-v1-canary.yaml

然后测试版本1 应用是否正确部署了

[root@master ~]# kubectl get svc -l app=my-app

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

my-app NodePort 10.96.15.100 <none> 80:31950/TCP 13s

[root@master ~]# curl http://127.0.0.1:31950

Host: my-app-v1-6964668d64-8l9jz, Version: v1.0.0

同样,新开一个终端,查看 Pod 的变化:

kubectl get pod -l app=my-app -w

然后部署版本2 应用

kubectl apply -f app-v2-canary.yaml

然后在 watch 终端页面可以看到多了一个 Pod,现在一共 11 个 Pod,其中只有1 个 Pod 运行新版本应用

[root@master ~]# kubectl get pod -l app=my-app

NAME READY STATUS RESTARTS AGE

my-app-v1-6964668d64-24g6g 1/1 Running 0 102s

my-app-v1-6964668d64-6qgrr 1/1 Running 0 101s

my-app-v1-6964668d64-87ldv 1/1 Running 0 101s

my-app-v1-6964668d64-8l9jz 1/1 Running 0 102s

my-app-v1-6964668d64-b4lpw 1/1 Running 0 101s

my-app-v1-6964668d64-cv8hk 1/1 Running 0 101s

my-app-v1-6964668d64-sgfs4 1/1 Running 0 101s

my-app-v1-6964668d64-tnsnm 1/1 Running 0 101s

my-app-v1-6964668d64-vs9l2 1/1 Running 0 102s

my-app-v1-6964668d64-zhm87 1/1 Running 0 101s

my-app-v2-5c967c586b-p28d9 1/1 Running 0 29s

然后同样可以循环访问该应用,查看是否会有版本2 的应用信息:

[root@master ~]# while sleep 0.1; do curl http://127.0.0.1:31950; done

Host: my-app-v1-6964668d64-24g6g, Version: v1.0.0

Host: my-app-v1-6964668d64-tnsnm, Version: v1.0.0

Host: my-app-v1-6964668d64-zhm87, Version: v1.0.0

Host: my-app-v2-5c967c586b-p28d9, Version: v2.0.0

......

正常情况下可以看到大部分都是返回的版本1 的应用信息,偶尔会出现版本2 的应用信息,这就证明我们的金丝雀发布成功了,待确认了版本2 的这个应用没有任何问题后,可以将版本2 应用扩容到10 个副本

kubectl scale --replicas=10 deploy my-app-v2

其实这个时候访问应用的话新版本和旧版本的流量分配是1:1了,确认了版本2 正常后,就可以删除版本1 的应用了

kubectl delete deploy my-app-v1

最终留下的是 10 个新版本的 Pod 了,到这里我们的整个金丝雀发布就完成了。同样,最后执行下面的命令删除上面的资源对象

kubectl delete all -l app=my-app

A/B测试

A/B 测试实际上是一种基于统计信息而非部署策略来制定业务决策的技术,与业务结合非常紧密。但是它们也是相关的,也可以使用金丝雀发布来实现。除了基于权重在版本之间进行流量控制之外,A/B 测试还可以基于一些其他参数(比如 Cookie、User Agent、地区等等)来精确定位给定的用户群,该技术广泛用于测试一些功能特性的效果,然后按照效果来进行确定。

我们经常可以在今日头条的客户端中就会发现有大量的 A/B 测试,同一个地区的用户看到的客户端有很大不同。要使用这些细粒度的控制,仍然还是建议使用 Istio,可以根据权重或 HTTP 头等来动态请求路由控制流量转发。

下面是使用 Istio 进行规则设置的示例,因为 Istio 还不太稳定,以下示例规则将来可能会更改:

route:

- tags:

version: v1.0.0

weight: 90

- tags:

version: v2.0.0

weight: 10

关于在 Istio 中具体如何做 A/B 测试,我们这里就不再详细介绍了,我们在istio-book文档中有相关的介绍。

结论:

1、几个版本并行运行

2、完全控制流量分配

3、特定的一个访问错误难以排查,需要分布式跟踪

4、Kubernetes 没有直接的支持,需要其他额外的工具

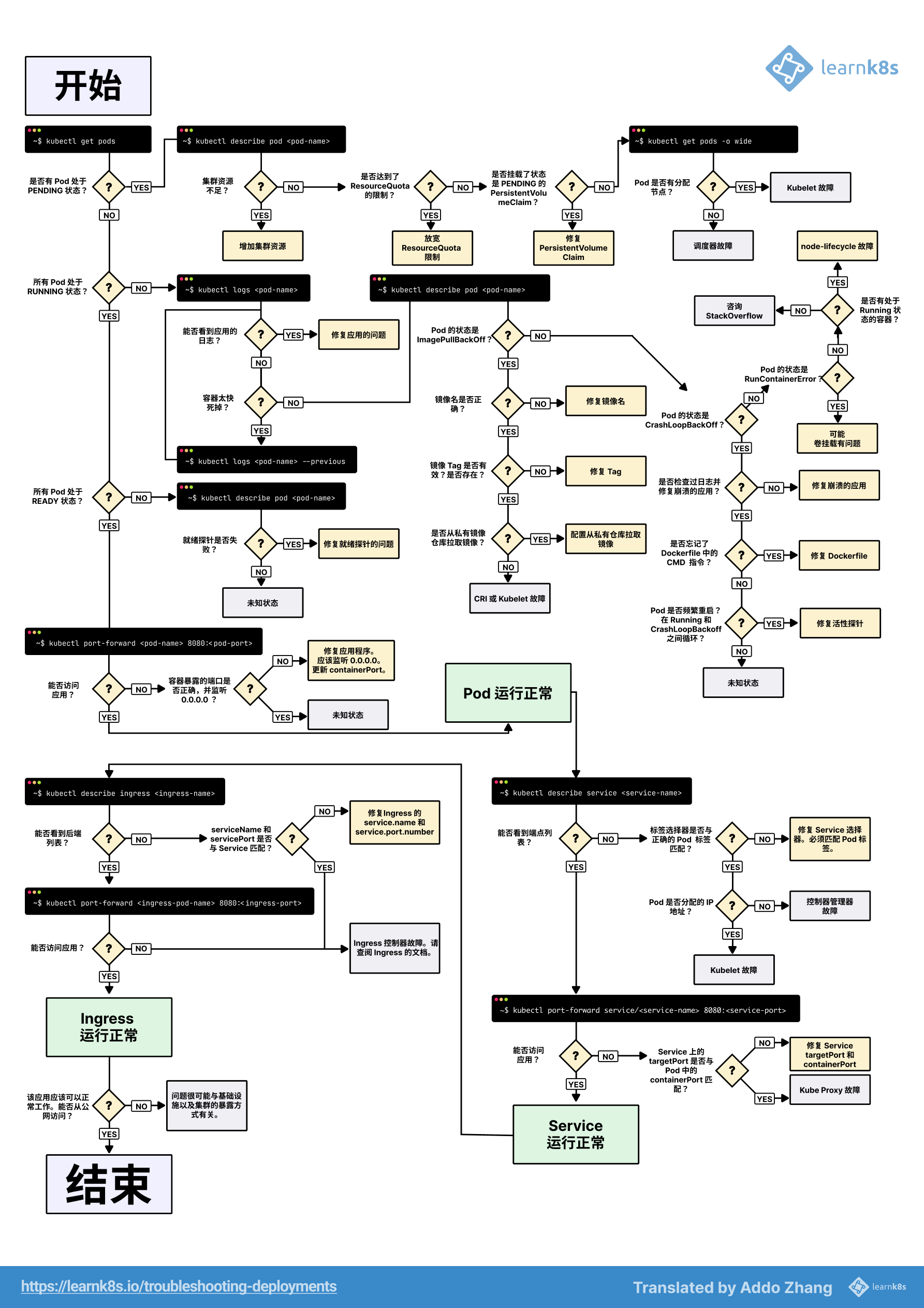

deployment排查拓扑图

DaemonSet

DaemonSet 的主要作用,就是让你在 Kubernetes 集群里每个节点只运行一个Pod,当有新节点加入到 Kubernetes 集群中,该 Pod 会自动在该节点上被创建出来,当节点从集群移除后,该节点上的这个 Pod 也会被回收。当然如果我们删除 DaemonSet,所有和这个对象相关的 Pod都会被删除。

使用DaemonSet的一些典型用法:

集群存储守护程序,如 glusterd、ceph 要部署在每个节点上以提供持久性存储;

节点监控守护进程,如 Prometheus 监控集群,可以在每个节点上运行一个 node-exporter 进程来收集监控节点的信息;

日志收集守护程序,如 fluentd 或 logstash,在每个节点上运行以收集容器的日志

节点网络插件,比如 flannel、calico,在每个节点上运行为 Pod 提供网络服务。

工作原理

DaemonSet 其实是一个非常简单的控制器。在它的控制循环中,只需要遍历所有节点,然后根据节点上是否有被管理 Pod 的情况,来决定是否要创建或者删除一个 Pod。DaemonSet首先从Etcd里获取所有节点的列表,然后遍历所有节点,检查每个节点是否有一个携带了 key=value 标签的pod在运行,如果没有这种pod,就在该节点创建该pod;如果有这种pod,但是数量大于1,则删除该节点上多余的pod。

正常情况下 Pod 运行在哪个节点上是由 Kubernetes 的调度器策略来决定的,然而由 DaemonSet 控制器创建的 Pod 实际上已经提前确定调度在哪个节点上了。DaemonSet控制器会在Pod创建时,自动在这个pod的API对象里加上nodeAffinity,需要绑定的节点名正是当前正在遍历的这个节点。同时还会自动加上Toleration,容忍标记污点为unschedulable的节点被调度,即使调度器还没有启动。而在正常情况下,被标记了 unschedulable 污点的 Node,是不会有任何 Pod 被调度上去的(effect: NoSchedule)。可是,DaemonSet 自动地给被管理的 Pod 加上了这个特殊的 Toleration,就使得这些 Pod 可以忽略这个限制,继而保证每个节点上都会被调度一个 Pod。当然,如果这个节点有故障的话,这个 Pod 可能会启动失败,而 DaemonSet 则会始终尝试下去,直到 Pod 启动成功。

系统日志收集fluentd-elasticsearch

例如,下面的 daemonset.yaml 文件描述了一个运行 fluentd-elasticsearch Docker 镜像的 DaemonSet,这个 DaemonSet 管理的是一个 fluentd-elasticsearch 镜像的 Pod。这个镜像的功能非常实用:通过 fluentd 将 Docker 容器里的日志转发到 ElasticSearch 中。

cat <<EOF | kubectl apply -f -

apiVersion: apps/v1

kind: DaemonSet

metadata:

name: fluentd-elasticsearch

namespace: kube-system

labels:

k8s-app: fluentd-logging

spec:

selector:

matchLabels:

name: fluentd-elasticsearch

template:

metadata:

labels:

name: fluentd-elasticsearch

spec:

tolerations:

- key: node-role.kubernetes.io/master

operator: Exists

effect: NoSchedule

containers:

- name: fluentd-elasticsearch

image: quay.io/fluentd_elasticsearch/fluentd:v4

resources:

limits:

memory: 200Mi

requests:

cpu: 100m

memory: 200Mi

volumeMounts:

- name: varlog

mountPath: /var/log

- name: varlibdockercontainers

mountPath: /var/lib/docker/containers

readOnly: true

terminationGracePeriodSeconds: 30

volumes:

- name: varlog

hostPath:

path: /var/log

- name: varlibdockercontainers

hostPath:

path: /var/lib/docker/containers

EOF

DaemonSet 跟 Deployment 其实非常相似,只不过是没有 replicas 字段。Pod 的模板,也是用 template 字段定义的。在这个字段中,我们定义了一个使用 fluentd:v4 镜像的容器,而且这个容器挂载了两个 hostPath 类型的 Volume,分别对应宿主机的 /var/log 目录和 /var/lib/docker/containers 目录。fluentd 启动之后,它会从这两个目录里搜集日志信息,并转发给 ElasticSearch 保存。这样,我们通过 ElasticSearch 就可以很方便地检索这些日志了。

需要注意的是,Docker 容器里应用的日志,默认会保存在宿主机的 /var/lib/docker/containers/{{. 容器 ID}}/{{. 容器 ID}}-json.log 文件里,所以这个目录正是 fluentd 的搜集目标。

查看DaemonSet发现每个node节点都会有一个pod

[root@master ~]# kubectl get ds -n kube-system -l k8s-app=fluentd-logging

NAME DESIRED CURRENT READY UP-TO-DATE AVAILABLE NODE SELECTOR AGE

fluentd-elasticsearch 3 3 3 3 3 <none> 65s

[root@master ~]# kubectl get pod -n kube-system -l name=fluentd-elasticsearch -owide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

fluentd-elasticsearch-5tn4g 1/1 Running 0 93s 10.244.104.6 node2 <none> <none>

fluentd-elasticsearch-85vkm 1/1 Running 0 93s 10.244.219.67 master <none> <none>

fluentd-elasticsearch-ksmdz 1/1 Running 0 93s 10.244.166.184 node1 <none> <none>

删除其中一个pod,pod被删除后自动被创建,因为DaemonSet确保一个节点一个pod

[root@master ~]# kubectl delete pod -n kube-system fluentd-elasticsearch-5tn4g

pod "fluentd-elasticsearch-5tn4g" deleted

[root@master ~]# kubectl get pod -n kube-system -l name=fluentd-elasticsearch -owide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

fluentd-elasticsearch-85vkm 1/1 Running 0 9m29s 10.244.219.67 master <none> <none>

fluentd-elasticsearch-d79bh 1/1 Running 0 108s 10.244.104.2 node2 <none> <none>

fluentd-elasticsearch-ksmdz 1/1 Running 0 9m29s 10.244.166.184 node1 <none> <none>

更新

DaemonSet 和 Deployment 一样,也有 DESIRED、CURRENT 等多个状态字段。这也就意味着,DaemonSet 可以像 Deployment 那样,进行版本管理。DaemonSet也有对应的更新策略,OnDelete和RollingUpdate两种方式:默认是滚动更新,在更新DaemonSet控制器模板后,旧的DaemonSet就会被终止,然后创建新的DaemonSet;OnDelete方式,只有手动删除旧的DaemonSet控制器pod后,才会创建新的DaemonSet控制器pod

[root@master ~]# kubectl get ds -n kube-system fluentd-elasticsearch -oyaml | grep -A4 updateStrategy

updateStrategy:

rollingUpdate:

maxSurge: 0

maxUnavailable: 1

type: RollingUpdate

接下来,我们来把这个 DaemonSet 的容器镜像版本更新到 v4.1

kubectl set image ds fluentd-elasticsearch fluentd-elasticsearch=quay.io/fluentd_elasticsearch/fluentd:v4.1 --record -n kube-system

这时候,我们可以使用 kubectl rollout status 命令看到这个“滚动更新”的过程,如下所示:

[root@master ~]# kubectl rollout status ds/fluentd-elasticsearch -n kube-system

Waiting for daemon set "fluentd-elasticsearch" rollout to finish: 0 out of 3 new pods have been updated...

Waiting for daemon set "fluentd-elasticsearch" rollout to finish: 0 out of 3 new pods have been updated...

Waiting for daemon set "fluentd-elasticsearch" rollout to finish: 1 out of 3 new pods have been updated...

Waiting for daemon set "fluentd-elasticsearch" rollout to finish: 1 out of 3 new pods have been updated...

Waiting for daemon set "fluentd-elasticsearch" rollout to finish: 1 out of 3 new pods have been updated...

Waiting for daemon set "fluentd-elasticsearch" rollout to finish: 2 out of 3 new pods have been updated...

Waiting for daemon set "fluentd-elasticsearch" rollout to finish: 2 out of 3 new pods have been updated...

Waiting for daemon set "fluentd-elasticsearch" rollout to finish: 2 out of 3 new pods have been updated...

Waiting for daemon set "fluentd-elasticsearch" rollout to finish: 2 out of 3 new pods have been updated...

Waiting for daemon set "fluentd-elasticsearch" rollout to finish: 2 of 3 updated pods are available...

daemon set "fluentd-elasticsearch" successfully rolled out

这一次我在升级命令后面加上了--record 参数,所以这次升级使用到的指令就会自动出现在 DaemonSet 的 rollout history 里面,如下所示:

[root@master ~]# kubectl rollout history daemonset fluentd-elasticsearch -n kube-system

daemonset.apps/fluentd-elasticsearch

REVISION CHANGE-CAUSE

1 <none>

2 kubectl set image ds fluentd-elasticsearch fluentd-elasticsearch=quay.io/fluentd_elasticsearch/:v4.1 --record=true --namespace=kube-system

有了版本号,你也就可以像 Deployment 一样,将 DaemonSet 回滚到某个指定的历史版本了。

接下来我们将更新策略改为OnDelete

kubectl patch ds fluentd-elasticsearch -n kube-system --type='json' -p='[{"op": "replace", "path": "/spec/updateStrategy/type", "value":"OnDelete"}]'

接下来,我们来把这个 DaemonSet 的容器镜像版本更新到 v4.2

kubectl set image ds fluentd-elasticsearch fluentd-elasticsearch=quay.io/fluentd_elasticsearch/fluentd:v4.2 --record -n kube-system

镜像更新完后,发现pod的镜像并没有更新

[root@master ~]# kubectl describe pod -n kube-system -l name=fluentd-elasticsearch | grep Image:

Image: quay.io/fluentd_elasticsearch/fluentd:v4.1

Image: quay.io/fluentd_elasticsearch/fluentd:v4.1

Image: quay.io/fluentd_elasticsearch/fluentd:v4.1

此时我们可以删除一个pod,再进行观察,可以看到,只有被删除的 pod 更新到指定的镜像版本

[root@master ~]# kubectl delete pod fluentd-elasticsearch-6rm99 -n kube-system

pod "fluentd-elasticsearch-6rm99" deleted

[root@master ~]# kubectl describe pod -n kube-system -l name=fluentd-elasticsearch | grep Image:

Image: quay.io/fluentd_elasticsearch/fluentd:v4.2

Image: quay.io/fluentd_elasticsearch/fluentd:v4.1

Image: quay.io/fluentd_elasticsearch/fluentd:v4.1

最后我们将所有的pod进行删除,完成所有的更新

kubectl delete pod -l name=fluentd-elasticsearch -n kube-system

查看pod镜像版本,发现已完成了更新

[root@master ~]# kubectl describe pod -n kube-system -l name=fluentd-elasticsearch | grep Image:

Image: quay.io/fluentd_elasticsearch/fluentd:v4.2

Image: quay.io/fluentd_elasticsearch/fluentd:v4.2

Image: quay.io/fluentd_elasticsearch/fluentd:v4.2

回滚

Kubernetes v1.7 之后添加了一个 API 对象,名叫 ControllerRevision,专门用来记录某种 Controller 对象的版本。DaemonSet 使用 ControllerRevision,来保存和管理自己对应的版本。这种 面向 API 对象 的设计思路,大大简化了控制器本身的逻辑,也正是 Kubernetes 项目 声明式 API 的优势所在。比如,你可以通过如下命令查看 fluentd-elasticsearch 对应的 ControllerRevision:

[root@master ~]# kubectl get controllerrevision -n kube-system -l name=fluentd-elasticsearch

NAME CONTROLLER REVISION AGE

fluentd-elasticsearch-547b7d98c5 daemonset.apps/fluentd-elasticsearch 1 37m

fluentd-elasticsearch-5ddccc9db9 daemonset.apps/fluentd-elasticsearch 2 4m56s

而如果你使用 kubectl describe 查看这个 ControllerRevision 对象,就会看到,这个 ControllerRevision 对象,实际上是在 Data 字段保存了该版本对应的完整的 DaemonSet 的 API 对象。并且,在 Annotation 字段保存了创建这个对象所使用的 kubectl 命令

fluentd-elasticsearch-547b7d98c5 fluentd-elasticsearch-5ddccc9db9

[root@master ~]# kubectl describe controllerrevision fluentd-elasticsearch-5ddccc9db9 -n kube-system

......

Annotations: deprecated.daemonset.template.generation: 2

kubernetes.io/change-cause:

kubectl set image ds fluentd-elasticsearch fluentd-elasticsearch=quay.io/fluentd_elasticsearch/:v4.1 --record=true --namespace=kube-system

API Version: apps/v1

Data:

Spec:

Template:

$patch: replace

Metadata:

Creation Timestamp: <nil>

Labels:

Name: fluentd-elasticsearch

......

将这个 DaemonSet 回滚到 REVISION=1 时的状态

[root@master ~]# kubectl rollout undo daemonset fluentd-elasticsearch --to-revision=1 -n kube-system

daemonset.apps/fluentd-elasticsearch rolled back

[root@master ~]# kubectl rollout history daemonset fluentd-elasticsearch -n kube-system

daemonset.apps/fluentd-elasticsearch

REVISION CHANGE-CAUSE

1 <none>

2 kubectl set image ds fluentd-elasticsearch fluentd-elasticsearch=quay.io/fluentd_elasticsearch/:v4.1 --record=true --namespace=kube-system

3 <none>

这个 kubectl rollout undo 操作,实际上相当于读取到了 REVISION=1 的 ControllerRevision 对象保存的 Data 字段。而这个 Data 字段里保存的信息,就是 REVISION=1 时这个 DaemonSet 的完整 API 对象。所以,现在 DaemonSet Controller 就可以使用这个历史 API 对象,对现有的 DaemonSet 做一次 PATCH 操作,等价于执行一次 kubectl apply -f 旧的 DaemonSet 对象 ,从而把这个 DaemonSet 更新到一个旧版本。这也是为什么,在执行完这次回滚完成后,你会发现 DaemonSet 的 REVISION 并不会从 REVISION=2 退回到 1,而是会增加成 Revision=3。这是因为,一个新的 ControllerRevision 被创建了出来。

Job/CronJob

为什么需要Job/CronJob

Kubernetes 的核心对象 Pod,用来编排一个或多个容器,让这些容器共享网络、存储等资源,总是共同调度,从而紧密协同工作。Pod 比容器更能够表示实际的应用,所以 Kubernetes 不会在容器层面来编排业务,而是把 Pod 作为在集群里调度运维的最小单位。

Kubernetes使用的是RESTful API,把集群中的各种业务都抽象为HTTP资源对象,那么在这个层次之上,我们就可以使用面向对象的方式来考虑问题。如果你有一些编程方面的经验,就会知道面向对象编程(OOP),它把一切都视为高内聚的对象,强调对象之间互相通信来完成任务。虽然面向对象的设计思想多用于软件开发,但它放到Kubernetes里却意外地合适。因为Kubernetes使用YAML来描述资源,把业务简化成了一个个的对象,内部有属性,外部有联系,也需要互相协作,只不过我们不需要编程,完全由Kubernetes自动处理,其实Kubernetes的Go语言内部实现就大量应用了面向对象。

面向对象的设计有许多基本原则,其中有两条我认为比较恰当地描述了Kubernetes对象设计思路:单一职责和组合优于继承

单一职责的意思是对象应该只专注于做好一件事情,不要贪大求全,保持足够小的粒度才更方便复用和管理

组合优于继承的意思是应该尽量让对象在运行时产生联系,保持松耦合,而不要用硬编码的方式固定对象的关系

应用这两条原则,我们再来看Kubernetes的资源对象就会很清晰了。因为Pod已经是一个相对完善的对象,专门负责管理容器,那么我们就不应该再画蛇添足地盲目为它扩充功能,而是要保持它的独立性,容器之外的功能就需要定义其他的对象,把Pod作为它的一个成员组合进去。这样每种Kubernetes对象就可以只关注自己的业务领域,只做自己最擅长的事情,其他的工作交给其他对象来处理,既不缺位也不越位,既有分工又有协作,从而以最小成本实现最大收益。

Job 和 CronJob,它们就组合了 Pod,实现了对离线业务的处理:

在线业务:比如Nginx、Node.js、MySQL、Redis等等,一旦运行起来基本上不会停,也就是永远在线。

离线业务:一般不直接服务于外部用户,只对内部用户有意义,比如日志分析、数据建模、视频转码等等,虽然计算量很大,但只会运行一段时间。离线业务的特点是必定会退出,不会无期限地运行下去,所以它的调度策略也就与“在线业务”存在很大的不同,需要考虑运行超时、状态检查、失败重试、获取计算结果等管理事项。而这些业务特性与容器管理没有必然的联系,如果由Pod来实现就会承担不必要的义务,违反了单一职责,所以我们应该把这部分功能分离到另外一个对象上实现,让这个对象去控制Pod的运行,完成附加的工作。

离线业务也可以分为两种。一种是临时任务,跑完就完事了,下次有需求了说一声再重新安排;另一种是定时任务,可以按时按点周期运行,不需要过多干预。对应到Kubernetes里,临时任务就是API对象Job,定时任务就是API对象CronJob,使用这两个对象你就能够在Kubernetes里调度管理任意的离线业务了。

Job

Job对象通常用于运行那些仅需要执行一次的任务,例如数据库迁移,批处理脚本等等。Job的本质是确保一个或多个Pod健康地运行直至运行完毕,如定时脚本意外退出是没办法再次重新执行的,job可以判断这个脚本是不是正常退出,如果不是正常退出job会重新执行该脚本直到正常退出为止。并且还可以设置正常退出的次数。运行一个脚本正常退出,以0为正常退出,job就会记录正常退出次数的个数,退出几次记录几次,比如定义job退出个数4,运行4次正常后,job达到4,job就退出

Job API 对象的定义非常简单,我来举个例子,在给定时间点只运行一次,周期性地在给定时间点运行。如下所示:

cat <<EOF | kubectl apply -f -

apiVersion: batch/v1

kind: Job

metadata:

name: pi

spec:

template:

spec:

containers:

- name: pi

image: busybox

command: ["sh", "-c", "echo 'scale=5000; 4*a(1)' | bc -l "]

restartPolicy: Never #重启策略

backoffLimit: 4 #失败时重试次数,默认为6

EOF

我们可以看到这个 Job 创建的 Pod 进入了 Running 状态,这意味着它正在计算 Pi 的值

[root@master ~]# kubectl get pod

NAME READY STATUS RESTARTS AGE

pi-mmjnd 1/1 Running 0 40s

跟其他控制器不同的是,Job 对象并不要求你定义一个 spec.selector 来描述要控制哪些 Pod。在成功创建后,我们来查看一下这个 Job 对象

[root@master ~]# kubectl describe jobs pi

......

Pod Template:

Labels: controller-uid=500d112e-df22-43f4-a6e0-49efc462f15b

job-name=pi

......

可以看到,这个 Job 对象在创建后,它的 Pod 模板,被自动加上了一个 controller-uid=< 一个随机字符串 > 这样的 Label。而这个 Job 对象本身,则被自动加上了这个 Label 对应的 Selector,从而保证了 Job 与它所管理的 Pod 之间的匹配关系。而 Job Controller 之所以要使用这种携带了 UID 的 Label,就是为了避免不同 Job 对象所管理的 Pod 发生重合。像这种离线job可能要执行多次,若是pod的标签一样,会出现错误选择的问题

我们可以看到很快 Pod 变成了 Completed 状态,这是因为容器的任务执行完成正常退出了,我们可以查看对应的日志

[root@master ~]# kubectl get pod

NAME READY STATUS RESTARTS AGE

pi-mmjnd 0/1 Completed 0 48s

[root@master ~]# kubectl logs pi-8xv5b

3.141592653589793238462643383279...

但是如果执行任务的 Pod 因为某种原因一直没有结束怎么办呢?同样我们可以在 Job 对象中通过设置字段 spec.activeDeadlineSeconds 来限制任务运行的最长时间,比如:

activeDeadlineSeconds: 10

那么当我们的任务 Pod 运行超过了 10s 后,这个 Job 的所有 Pod 都会被终止,并且 Pod 的终止原因会变成 DeadlineExceeded

cat <<EOF | kubectl apply -f -

apiVersion: batch/v1

kind: Job

metadata:

name: pi

spec:

activeDeadlineSeconds: 10

template:

spec:

containers:

- name: pi

image: busybox

command: ["sh", "-c", "echo 'scale=5000; 4*a(1)' | bc -l "]

restartPolicy: Never #重启策略

backoffLimit: 4 #失败时重试次数,默认为6

EOF

查看pod状态为Terminating

[root@master ~]# kubectl get pod

NAME READY STATUS RESTARTS AGE

pi-ws9gj 1/1 Terminating 0 16s

如果这个离线作业失败了要怎么办?比如,我们在例子中定义了 restartPolicy=Never,那么离线作业失败后 Job Controller 就会不断地尝试创建一个新 Pod。这也是我们需要在 Pod 模板中定义 restartPolicy=Never 的原因,离线计算的 Pod 永远都不应该被重启,所以想让任务进行就只能创新的Pod。如果你定义的 restartPolicy=OnFailure,那么离线作业失败后,Job Controller 就不会去尝试创建新的 Pod。但是,它会不断地尝试重启 Pod 里的容器。

重启策略为Never

cat <<EOF | kubectl apply -f -

apiVersion: batch/v1

kind: Job

metadata:

name: job-failed-demo

spec:

template:

spec:

containers:

- name: test-job

image: busybox

command: ["echo123", "test failed job!"]

restartPolicy: Never

backoffLimit: 4 #失败时重试次数,默认为6

EOF

查看pod,发现重新创建了4个新的pod

[root@master ~]# kubectl get pod

NAME READY STATUS RESTARTS AGE

job-failed-demo-58mnf 0/1 ContainerCannotRun 0 24s

job-failed-demo-g9r69 0/1 ContainerCannotRun 0 44s

job-failed-demo-mp9tv 0/1 ContainerCannotRun 0 39s

job-failed-demo-smsl2 0/1 ContainerCannotRun 0 34s

job-failed-demo-z9ggl 0/1 ContainerCannotRun 0 29s

可以看到当我们设置成 Never 重启策略的时候,Job 任务执行失败后会不断创建新的 Pod,但是不会一直创建下去,会根据 spec.backoffLimit 参数进行限制,通过该字段可以定义重建 Pod 的次数,这里我们设置的重试次数为4(即backoffLimit=4),而这个字段的默认值是 6。另外需要注意的是 Job 控制器重新创建 Pod 的间隔是呈指数增加的,即下一次重新创建 Pod 的动作会分别发生在 10s、20s、40s… 后。

重启策略为OnFailure

cat <<EOF | kubectl apply -f -

apiVersion: batch/v1

kind: Job

metadata:

name: job-failed-demo

spec:

template:

spec:

containers:

- name: test-job

image: busybox

command: ["echo123", "test failed job!"]

restartPolicy: OnFailure

EOF

重启策略改为 OnFailure,则当 Job 任务执行失败后不会创建新的 Pod 出来,只会不断重启 Pod

[root@master ~]# kubectl get pod

NAME READY STATUS RESTARTS AGE

job-failed-demo-9hsfx 0/1 RunContainerError 1 (21s ago) 33s

并行

在 Job 对象中,负责并行控制的参数有两个:

spec.parallelism:它定义的是一个 Job 在任意时间最多可以启动多少个 Pod 同时运行

spec.completions:它定义的是 Job 至少要完成的 Pod 数目,即 Job 的最小完成数

现在,我在之前计算 Pi 值的 Job 里,添加这两个参数,这样我们就指定了这个 Job 最大的并行数是 2,而最小的完成数是 4

cat <<EOF | kubectl apply -f -

apiVersion: batch/v1

kind: Job

metadata:

name: pi

spec:

parallelism: 2

completions: 4

template:

spec:

containers:

- name: pi

image: busybox

command: ["sh", "-c", "echo 'scale=5000; 4*a(1)' | bc -l "]

restartPolicy: Never

backoffLimit: 4

EOF

查看这个job,COMPLETIONS 定义的最小完成数

[root@master ~]# kubectl get job

NAME COMPLETIONS DURATION AGE

pi 0/4 79s 79s

我们可以看到,这个 Job 首先创建了两个并行运行的 Pod 来计算 Pi

[root@master ~]# kubectl get pod

NAME READY STATUS RESTARTS AGE

pi-8f766 1/1 Running 0 19s

pi-lzdbh 1/1 Running 0 19s

而在 59s 后,这两个 Pod 相继完成计算。每当有一个 Pod 完成计算进入 Completed 状态时,就会有一个新的 Pod 被自动创建出来

[root@master ~]# kubectl get pod

NAME READY STATUS RESTARTS AGE

pi-8f766 0/1 Completed 0 59s

pi-9rkfc 0/1 ContainerCreating 0 1s

pi-hzwmb 0/1 ContainerCreating 0 3s

pi-lzdbh 0/1 Completed 0 59s

当所有的 Pod 均已经成功退出,这个 Job 也就执行完了,所以你会看到它的 COMPLETIONS 字段的值变成了 4/4

[root@master ~]# kubectl get pod

NAME READY STATUS RESTARTS AGE

pi-8f766 0/1 Completed 0 107s

pi-9rkfc 0/1 Completed 0 49s

pi-hzwmb 0/1 Completed 0 51s

pi-lzdbh 0/1 Completed 0 107s

[root@master ~]# kubectl get job

NAME COMPLETIONS DURATION AGE

pi 4/4 104s 110s

Job Controller 控制的对象,直接就是 Pod。Job Controller在控制循环中进行调谐操作,根据实际运行的、已经退出的和设置的允许并行的和最少完成的这两个参数共同计算出在这个周期里应该创建或者删除的 Pod 数目,然后调用 Kubernetes API 来执行这个操作。以上面计算 Pi 值的这个例子为例,当 Job 一开始创建出来时,实际处于 Running 状态的 Pod 数目 = 0,已经成功退出的 Pod 数目 = 0,而用户定义的 completions,也就是最终用户需要的 Pod 数目 = 4。所以在这个时刻,需要创建的 Pod 数目 = 最终需要的 Pod 数目 - 实际在 Running 状态 Pod 数目 - 已经成功退出的 Pod 数目 = 4 - 0 - 0= 4。也就是说,Job Controller 需要创建 4 个 Pod 来纠正这个不一致状态。可是,我们又定义了这个 Job 的 parallelism=2。也就是说,我们规定了每次并发创建的 Pod 个数不能超过 2 个。所以,Job Controller 会对前面的计算结果做一个修正,修正后的期望创建的 Pod 数目应该是:2 个。这时候,Job Controller 就会并发地向 kube-apiserver 发起两个创建 Pod 的请求。类似地,如果在这次调谐周期里,Job Controller 发现实际在 Running 状态的 Pod 数目,比 parallelism 还大,那么它就会删除一些 Pod,使两者相等。

CronJob

CronJob 与 Job 的关系,正如同 Deployment 与 ReplicaSet 的关系一样。CronJob 是一个专门用来管理 Job 对象的控制器。只不过,它创建和删除 Job 的依据,是 schedule 字段定义的、一个标准的Unix Cron格式的表达式。

一个 CronJob 对象其实就对应linux系统中 crontab 文件中的一行,它根据配置的时间格式周期性地运行一个Job,格式和 crontab 也是一样的:分 时 日 月 周 要运行的命令

现在,我们用 CronJob 来管理我们上面的 Job 任务,

cat <<EOF | kubectl apply -f -

apiVersion: batch/v1beta1

kind: CronJob

metadata:

name: cronjob-demo

spec:

schedule: "*/1 * * * *"

jobTemplate: #CronJob 是一个 Job 对象的控制器

spec:

template:

spec:

restartPolicy: OnFailure

containers:

- name: busybox

image: busybox

args:

- "bin/sh"

- "-c"

- "for i in 9 8 7 6 5 4 3 2 1; do echo $i; done"

EOF

还有一些值得我们关注的字段 spec.successfulJobsHistoryLimit(默认为3) 和 spec.failedJobsHistoryLimit(默认为1),表示历史限制,是可选的字段,指定可以保留多少完成和失败的 Job。然而,当运行一个 CronJob 时,Job 可以很快就堆积很多,所以一般推荐设置这两个字段的值。如果设置限制的值为 0,那么相关类型的 Job 完成后将不会被保留。

查看创建的 Cronjob 资源对象

[root@master ~]# kubectl get cronjob

NAME SCHEDULE SUSPEND ACTIVE LAST SCHEDULE AGE

cronjob-demo */1 * * * * False 0 <none> 17s

稍微等一会儿查看可以发现多了几个 Job 资源对象,这个就是因为上面我们设置的 CronJob 资源对象,每1分钟执行一个新的 Job

[root@master ~]# kubectl get job

NAME COMPLETIONS DURATION AGE

cronjob-demo-28651212 1/1 7s 84s

cronjob-demo-28651213 0/1 24s 24s

[root@master ~]# kubectl get pod

NAME READY STATUS RESTARTS AGE

cronjob-demo-28651212-pg529 0/1 Completed 0 91s

cronjob-demo-28651213-469cp 0/1 ContainerCreating 0 31s

由于定时任务的特殊性,很可能某个 Job 还没有执行完,另外一个新 Job 就产生了。这时候,你可以通过 spec.concurrencyPolicy 字段来定义具体的处理策略。比如:

concurrencyPolicy=Allow这也是默认情况,这意味着这些 Job 可以同时存在;

concurrencyPolicy=Forbid这意味着不会创建新的 Pod,该创建周期被跳过;

concurrencyPolicy=Replace这意味着新产生的 Job 会替换旧的、没有执行完的 Job。

而如果某一次 Job 创建失败,这次创建就会被标记为“miss”。当在指定的时间窗口内,miss 的数目达到 100 时,那么 CronJob 会停止再创建这个 Job。这个时间窗口,可以由 spec.startingDeadlineSeconds 字段指定。比如 startingDeadlineSeconds=200,意味着在过去 200 s 里,如果 miss 的数目达到了 100 次,那么这个 Job 就不会被创建执行了。

Job 备份 MySQL 数据库

由于阿里云 RDS MYSQL 数据库没有开放外网连接权限,然后生产环境又没有安装 MYSQL 数据库,缺少 mysqldump 命令,所有决定使用 kubernetes 起一个 job 执行备份操作。k8s 的 Job 负责批量处理短暂的一次性任务 (short lived one-off tasks),即仅执行一次的任务,它保证批处理任务的一个或多个Pod成功结束。这里刚好可以用来备份 MYSQL 数据库

创建 job 文件 mysqldump-job.yaml,内容如下

cat > mysqldump-job.yaml <<EOF

apiVersion: batch/v1

kind: Job

metadata:

name: mysql-backup

spec:

template:

spec:

affinity:

nodeAffinity:

requiredDuringSchedulingIgnoredDuringExecution:

nodeSelectorTerms:

- matchExpressions:

- key: kubernetes.io/hostname

operator: In

values:

- k8s-prod-master01

tolerations:

- key: "groups"

operator: "Equal"

effect: "NoExecute"

value: "vbaas"

- key: "role"

operator: "Equal"

effect: "NoExecute"

value: "master"

containers:

- name: mysqldump

image: nacos/nacos-mysql-master:latest

imagePullPolicy: "IfNotPresent"

command:

- "/bin/sh"

- "-c"

- "/data/mysql/shell/mysqldump.sh"

volumeMounts:

- mountPath: "/etc/localtime"

name: "localtime"

- mountPath: "/data/mysql/shell"

name: mysql-backup-scripts

- mountPath: "/data/mysql/backup"

name: mysql-backup-data

- mountPath: "/etc/resolv.conf"

name: resolv

volumes:

- name: "mysql-backup-scripts"

hostPath:

path: "/data/mysql/shell"

- name: "mysql-backup-data"

hostPath:

path: "/data/mysql/backup"

- hostPath:

path: "/usr/share/zoneinfo/Asia/Shanghai"

name: "localtime"

- name: resolv

hostPath:

path: /etc/resolv.conf

restartPolicy: Never

backoffLimit: 2

EOF

创建数据备份存放目录以及脚本目录

mkdir -p /data/mysql/{backup,shell}

创建 mysqldump.sh 脚本文件,内容如下

#!/bin/bash

# 保存备份个数

number=3

# 备份保存路径

backup_dir=/data/mysql/backup

# 日期

datetime=</span><span class="token function">date</span> +%Y%m%d<span class="token variable">

# 备份工具

mysqldump=/usr/bin/mysqldump

# 用户名

username=‘root’

# 密码

password=‘xawdadasfadasdqadad’

# 主机地址

host=“vonebaas-prod.mysql.zhangbei.rds.aliyuncs.com”

# 将要备份的数据库

database_name=“nacos

vbaas_c_platform_prod

vbaas_c_custom_core_prod

vbaas_c_open_core_prod

vchain_order_prod

vbaas_s_platform_prod

vbaas_s_platform_node_prod

vbaas_c_platform_explorer_prod

vchain_base_msg_prod

xxl_job_vbaas4_prod

vbaas_c_ops_prod

vbaas_s_platform_explorer_prod

vchain_core_gateway_prod

vchain_core_xxl_prod

vbaas_c_cross_prod

chainmaker_ca_prod

chainmaker_explorer_prod”

# 备份文件名称

backupFileName=“allDatabases-${datetime}.sql”

# 备份所有数据库

#$tool -u

u

s

e

r

n

a

m

e

−

p

username -p

username−ppassword -hmysql-master -P3306 --databases $database_name >

b

a

c

k

u

p

d

i

r

/

backup_dir/

backupdir/database_name-

d

d

.

s

q

l

<

/

s

p

a

n

>

<

s

p

a

n

c

l

a

s

s

=

"

t

o

k

e

n

v

a

r

i

a

b

l

e

"

>

dd.sql</span> <span class="token variable">

dd.sql</span><spanclass="tokenvariable">{mysqldump} -u KaTeX parse error: Undefined control sequence: \< at position 51: …n punctuation">\̲<̲/span> -p<spa…{password} </span>

-hKaTeX parse error: Undefined control sequence: \< at position 47: …n punctuation">\̲<̲/span> <span …{database_name} </span>

–ignore-table=vchain_core_xxl_prod.xxl_job_log </span>

–ignore-table=xxl_job_vbaas4_prod.xxl_job_log >

b

a

c

k

u

p

d

i

r

<

/

s

p

a

n

>

/

<

s

p

a

n

c

l

a

s

s

=