RNN背景:RNN与FNN

在前馈神经网络中,信息的传递是单向的,这种限制虽然使得网络变得更容易学习,但在一定程度上也减弱了神经网络模型的能力。

在生物神经网络中,神经元之间的连接关系要复杂的多。前馈神经网络可以看着是一个复杂的函数,每次输入都是独立的,即网络的输出只依赖于当前的输入。

但是在很多现实任务中,网络的输入不仅和当前时刻的输入相关,也和其过去一段时间的输出相关。比如一个有限状态自动机,其下一个时刻的状态(输出)不仅仅和当前输入相关,也和当前状态(上一个时刻的输出)相关。

此外,前馈网络难以处理时序数据,比如视频、语音、文本等。时序数据的长度一般是不固定的,而前馈神经网络要求输入和输出的维数都是固定的,不能任意改变。因此,当处理这一类和时序相关的问题时,就需要一种能力更强的模型。

循环神经网络(Recurrent Neural Network,RNN) 是一类具有短期记忆能力的神经网络。在循环神经网络中,神经元不但可以接受其它神经元的信息,也可以接受自身的信息,形成具有环路的网络结构。和前馈神经网络相比,循环神经网络更加符合生物神经网络的结构。

基本循环神经网络

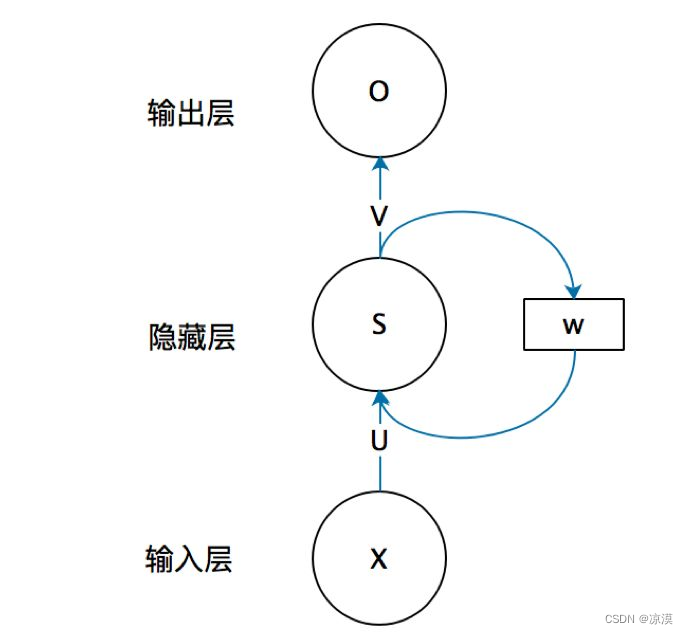

循环神经网络的基本结构包括输入层、隐藏层和输出层。

输入层的输入是序列数据,隐藏层的输出是经过循环神经网络计算得到的结果,输出层的输出是最终的预测结果。RNN模型的循环结构是指隐藏层的输出不仅可以传递给下一时刻的隐藏层,还可以作为输入层的输入。

因此,RNN模型可以处理序列数据,并将每个时刻的数据传递给下一个时刻,以便进行长时间的依赖关系分析。

- 输入层:RNN能够接受一个输入序列(例如文字、股票价格、语音信号等)并将其传递到隐藏层。

- 隐藏层:隐藏层之间存在循环连接,使得网络能够维护一个“记忆”状态,这一状态包含了过去的信息。这使得RNN能够理解序列中的上下文信息。

- 输出层:RNN可以有一个或多个输出,例如在序列生成任务中,每个时间步都会有一个输出。

RNN的优缺点

优点:

- 能够处理不同长度的序列数据。

- 能够捕捉序列中的时间依赖关系。

缺点:

- 对长序列的记忆能力较弱,可能出现梯度消失或梯度爆炸问题。

- 训练可能相对复杂和时间消耗大。

循环神经网络的工作原理:

循环神经网络(RNN)的工作原理是通过网络中的环状连接捕获序列中的时间依赖关系。

x是输入向量,o是输出向量,s表示隐藏层的值;U是输入层到隐藏层的权重矩阵,V是隐藏层到输出层的权重矩阵。循环神经网络的隐藏层的值s不仅仅取决于当前这次的输入x,还取决于上一次隐藏层的值s-1。权重矩阵W就是隐藏层上一次的值作为这一次的输入的权重。

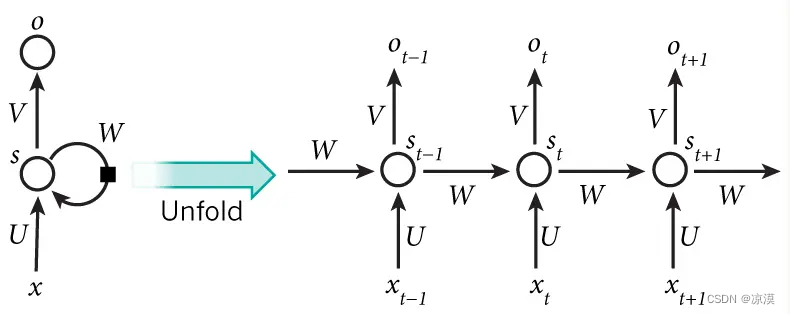

我们将上图的基本RNN结构在时间维度展开(RNN是一个链式结构,每个时间片使用的是相同的参数):

其中,t 是时刻, x 是输入层, s 是隐藏层, o 是输出层,矩阵 W 就是隐藏层上一次的值作为这一次的输入的权重。

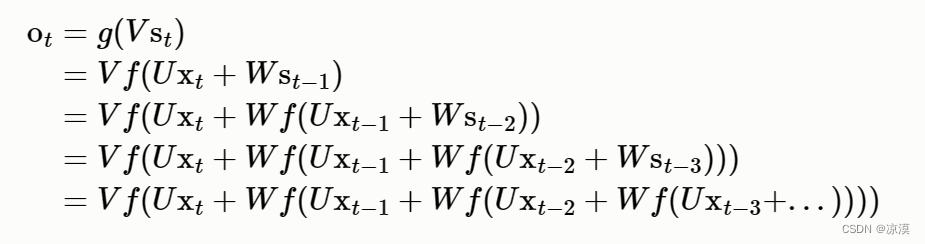

为什么循环神经网络可以往前看任意多个输入值呢?

![]()

![]()

如果反复把式 2 带入到式 1,将得到:

从上面的式子中可以看出:输出受前面历次输入值的影响

信息流动

- 输入到隐藏:每个时间步,RNN从输入层接收一个新的输入,并将其与之前的隐藏状态结合起来,以生成新的隐藏状态。

- 隐藏到隐藏:隐藏层之间的循环连接使得信息可以在时间步之间传播,从而捕捉序列中的依赖关系。

- 隐藏到输出:每个时间步的隐藏状态都会传递到输出层,以生成对应的输出。

训练算法

循环神经网络的训练过程比较复杂,需要更多的计算资源和时间。训练过程通常采用反向传播算法和梯度下降算法。反向传播算法(BPTT)是指通过计算输出层和隐藏层之间的误差,并将误差反向传递给隐藏层和输入层,以便更新网络的权重。梯度下降算法是指通过计算损失函数对权重的梯度,并将梯度下降的方向作为优化方向,以最小化损失函数。

反向传播算法(BPTT)

BPTT算法是针对循环层的训练算法,它的基本原理和BP算法是一样的,也包含同样的三个步骤:

1.前向计算每个神经元的输出值;

2.反向计算每个神经元的误差项δ j 值,它是误差函数E对神经元j的加权输入netj的偏导数;

3.计算每个权重的梯度。

最后再用随机梯度下降算法更新权重。

梯度爆炸和消失问题

- 梯度消失:梯度趋近于零,网络权重无法更新或更新的很微小,网络训练再久也不会有效果;

- 梯度爆炸:梯度呈指数级增长,变的非常大,然后导致网络权重的大幅更新,使网络变得不稳定。

实践中前面介绍的几种RNNs并不能很好的处理较长的序列,RNN在训练中很容易发生梯度爆炸和梯度消失,这导致梯度不能在较长序列中一直传递下去,从而使RNN无法捕捉到长距离的影响。

通常来说,梯度爆炸更容易处理一些。因为梯度爆炸的时候,我们的程序会收到NaN错误。我们也可以设置一个梯度阈值,当梯度超过这个阈值的时候可以直接截取。

梯度消失更难检测,而且也更难处理一些。总的来说,我们有三种方法应对梯度消失问题:

1、合理的初始化权重值。初始化权重,使每个神经元尽可能不要取极大或极小值,以躲开梯度消失的区域。

2、使用relu代替sigmoid和tanh作为激活函数。

3、使用其他结构的RNNs,比如长短时记忆网络(LTSM)和Gated Recurrent Unit(GRU),这是最流行的做法。

参考:

神经网络算法——反向传播 Back Propagation-腾讯云开发者社区-腾讯云 (tencent.com)

循环神经网络——RNN的训练算法:BPTT_rnn bptt-CSDN博客

循环神经网络(RNN)及衍生LSTM、GRU详解 - 凌逆战 - 博客园 (cnblogs.com)

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?