论文的其他章节解读可以通过目录找到:On the origin of deep learning 文章解读系列目录表

在这一部分,我们将开始讨论一个不同的模型家族:卷积神经网络( CNN )家族。与上一章节中的家族不同,卷积神经网络家族主要是从人类视觉皮层的知识进化而来。因此,在这一部分中,我们将首先介绍卷积神经网络在视觉问题上取得成功的一个最重要的原因:它的仿生设计复制了人类的视觉系统。现在的卷积神经网络可能更多地源于这样的设计,而不是来自早期的祖先。在这些背景设置下,我们接下来将简要介绍通过ImageNet挑战赛。最后,我们将提出视觉任务中的一些已知问题,这些问题可能会指导视觉任务中未来的研究方向

因为这部分内容大部分人都比较了解了,所以这里只对原始论文关键部分进行翻译。熟悉的人大家可以直接跳过本节

卷积神经网络和视觉皮层

卷积层和下采样层。然后将这些组件组装成卷积神经网络,以LeNet为例。

卷积操作通常被称为核。通过对核函数的不同选择,可以实现对图像的不同操作。操作通常包括识别、边缘检测、模糊、锐化等。通过引入随机矩阵作为卷积算子,可以发现一些有趣的性质。图16是应用于同一图形的一些示例内核的示意图。可以看到,不同的内核可以被应用来完成不同的任务。随机核也可以应用于将图像转化为一些有趣的结果。

皮层的中心任务之一,可以通过巧妙地选择核函数来完成。此外,巧妙地选择内核可以引导我们成功地复制视皮层。因此,在应用于视觉任务时,学习一个有意义的卷积核(即参数学习)是卷积神经网络的中心任务之一。许多受过良好训练的流行模型通常只需要有限的微调过程就可以在其他任务中表现良好:内核已经得到了很好的训练,可以普遍适用。随着对卷积操作在视觉任务中所扮演的重要角色的理解,我们开始研究一些重要的里程碑。

卷积神经网络的先驱者:LeNet

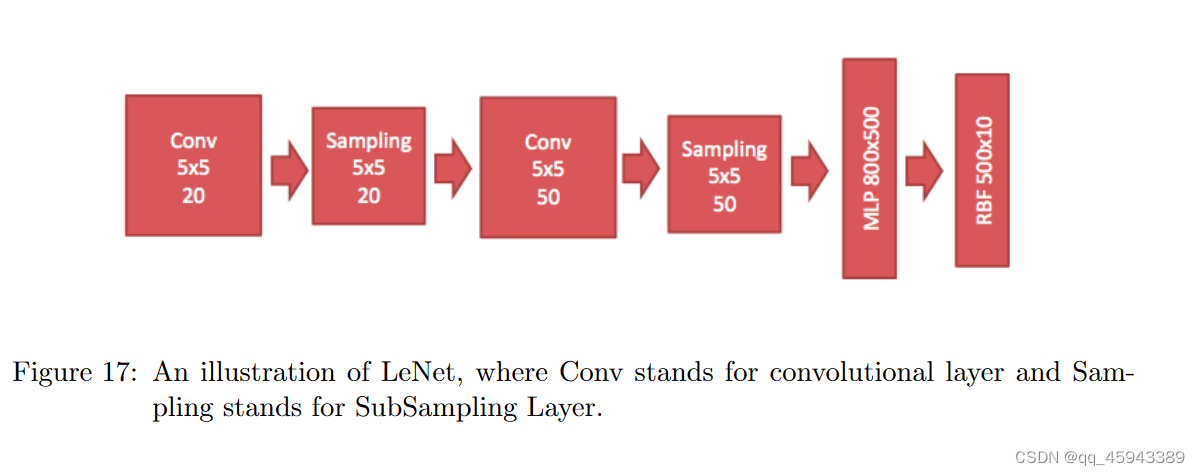

本部分介绍了一个被广泛认可的第一个卷积神经网络模型:LeNet ( Le Cun et al,1990 )。它的灵感来自于Neocogitron。在本节中,我们将通过引入Le Net来引入卷积神经网络。图17为Le Net的架构示意图。它由两对卷积层和下采样层组成,并进一步与全连接层和RBF层连接用于分类。

卷积层主要是执行卷积操作的一层。正如我们之前所讨论的,巧妙地选择卷积核可以有效地模拟视觉皮层的任务。卷积层在卷积之后引入了另一个操作来辅助模拟更加成功:非线性变换。考虑一种ReLU ( Nair和Hinton , 2010)非线性变换,它是一种变换,去掉了输入的负部分,从而使有意义的特征与内核产生的其他副产品形成了更清晰的对比。因此,这种非线性赋予了卷积更多提取有用特征的能力,使其能够更紧密地模拟视觉皮层的功能。

子采样层执行更简单的任务。它对所考察的每个区域只采样一个输入。可以考虑一些不同的采样策略,如最大池化(取输入量的最大值),平均池化(取输入的平均值),甚至概率池化(采取随机的方式。),( Lee et al , 2009)。采样将输入表示转化为更小和更易于管理的嵌入。更重要的是,采样使得网络对输入图像中的微小变换、扭曲和平移具有不变性。由于我们在局部邻域取最大值/平均值,输入中的一个小的失真不会改变池化的结果

在介绍了两个最重要的组件之后,我们可以将它们堆叠在一起,组装成一个卷积神经网络。我们将最终得到著名的LeNet。LeNet以其对数字的分类能力而著称,可以处理各种不同的数字问题,包括位置和尺度的变化、数字的旋转和挤压,甚至是数字的不同笔画宽度。同时,随着LeNet的引入,Le Cun等( 1998b )还引入了后来成为数字识别领域标准基准的MNIST数据库。

Imagenet中的里程碑挑战

随着Le Net的成功,卷积神经网络在解决视觉任务方面表现出了巨大的潜力。这些潜力吸引了大量研究人员致力于解决CIFAR分类( Krizhevsky和Hinton , 2009)和ImageNet挑战赛(鲁萨科夫斯基等, 2015)中物体识别的视觉任务。沿着这条路径,一些超星里程碑引起了极大的关注,并以良好的性能应用于其他领域。在这一部分,我们将简要讨论这些模型。

AlexNet

LeNet开启了卷积神经网络的时代,而由Krizhevsky等人( 2012 )发明的AlexNet开启了用于ImageNet分类的CNN时代。AlexNet是第一个证据表明CNN可以在这一历史困难的ImageNet数据集上表现良好,并且它的表现如此出色,使社会陷入了开发CNN的竞争中。AlexNet的成功不仅得益于这种独特的架构设计,还得益于其巧妙的训练机制。为了避免计算昂贵的训练过程,AlexNet被拆分为两个流,并在两个GPU上进行训练。它还使用了数据增强技术,包括图像平移,水平反射和补丁提取。

AlexNet的配方如图18所示。然而,尽管AlexNet的性能卓越,但很少能从其架构中吸取教训。更不幸的是,AlexNet的这种特殊架构并没有很好的理论支持,这使得许多研究人员盲目地烧录计算资源对新架构进行测试。这一时期引入了很多模型,但未来可能值得一提的只有少数几个。

VGG

在探索不同架构的盲目竞争中,西蒙尼扬和西塞曼( 2014 )用一个名为VGG的模型表明简约是一个很有前途的方向。虽然VGG比当时的其他模型更深( 19层),但其架构极其简化:所有层都是3 × 3卷积层,并有一个2 × 2池化层。这种简单的卷积层使用模拟了更大的滤波器,同时保留了更小滤波器尺寸的好处,因为两个3 × 3卷积层的组合具有5 × 5卷积层的有效感受野,但具有更少的参数。

由于卷积层和池化层的作用,每一层输入体的空间尺寸会减小,但由于滤波器(在VGG中,每个池化层之后的滤波器数量翻倍)数量的增加,体的深度会增加。这一行为强化了VGG收缩空间维度,但增长深度的想法。VGG不是当年ImageNet竞赛的优胜者( (获奖者是塞盖迪等人( 2015 )发明的谷歌公司) )。谷歌公司引入了几个重要的概念,如Inception模块和后来R - CNN使用的概念( Girshick et al . , 2014 ; Girshick , 2015 ;任军等, 2015),但架构的任意/创造性设计对社会的贡献几乎不超过VGG,特别是考虑到Residual Net,跟踪特别是考虑到残差网络沿袭了VGG的路径,以前所未有的水平赢得了ImageNet的挑战

Residual Net(ResNet)

残差网络( Residual Net,ResNet )是一个152层的网络,比He et al . ( 2015 )发明该网络时通常看到的要深10倍。继VGG引入的路径之后,ResNet以简单的层探索更深层次的结构。

ResNet引入的突破性技术被称为残差块( Residual Block ),它允许ResNet比之前的网络更深入。Residual Block的思想是,某个层(记为x)的某些输入可以通过传统的路径(包括卷积层和ReLU变换序列(我们把结果记为f ( x ) ) )传递到后面两层的组件,或者通过直He等人( 2016 )验证了残差块对于平滑地传播信息是必不可少的,因此简化了优化。

他们还将ResNet扩展到1000层版本,并在CIFAR数据集上取得成功。ResNet另一个有趣的视角是由( Veit et al , 2016)提供的。它们表明ResNet表现出类似于浅层网络的集成:引入的表达方式允许ResNet作为独立网络的集合来执行,每个网络明显比集成的ResNet本身更浅。这也解释了为什么梯度可以穿过超深的建筑而不至于消失。接传递x到那里的表达方式。因此,后面两层分量的输入为f ( x ) + x,而不是通常所说的f ( x )。

随着这些在这些挑战中取得成功的最先进的神经模型的引入,坎齐亚尼等( 2016 )对这些模型进行了全面的实验研究比较。通过比较,他们发现全连接层对于较小批量的图像表现出很强的低效性,仍有改进的空间。

基本视觉问题的挑战和机遇

ResNet并不是故事的终点。新的模型和技术每天都在出现,以进一步推动CNNs的极限。例如,Zhang et al ( 2016b )更进一步,将Residual Block放入Residual Block中。Zagoruyko和Komodakis ( 2016 )试图通过增加网络宽度来降低网络深度。然而,此类增量作品并不在本文的研究范围之内。我们希望结束卷积神经网络的故事,解决当前一些基本视觉问题的挑战,这些问题可能无法通过研究机器学习技术天真地解决。

他们可以简单地通过对图像添加扰动来迫使深度学习模型对图像进行错误分类。更重要的是,这些扰动甚至可能无法用肉眼观察到。换句话说,看起来与人类几乎相同的两个物体,可能会被一个训练好的神经网络(例如, AlexNet)识别为不同的物体。他们还表明,这种性质更可能是一个建模问题,而不是由训练不足引起的问题。通过构造,我们可以发现神经网络可能会将一个容易被人类识别的对象误分类为不寻常的东西。另一方面,神经网络也可能将一些不被人类认为是物体的怪异模式分类到我们熟悉的事物中。当需要可靠的预测时,这两种性质都可能限制深度学习在现实世界中的应用。

还有一些问题。

本文探讨了卷积神经网络的发展历程,从模仿人类视觉皮层的LeNet到深度学习的里程碑模型AlexNet、VGG和ResNet。文章详细介绍了这些模型如何通过创新设计解决ImageNet挑战,并提出了视觉任务中的挑战,如模型的不稳定性与误分类问题。

本文探讨了卷积神经网络的发展历程,从模仿人类视觉皮层的LeNet到深度学习的里程碑模型AlexNet、VGG和ResNet。文章详细介绍了这些模型如何通过创新设计解决ImageNet挑战,并提出了视觉任务中的挑战,如模型的不稳定性与误分类问题。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?