书生·浦语大模型全链路开源体系

1.大模型成为发展通用人工智能的重要途径

专用模型:针对特定任务,一个模型解决一个问题

通用大模型:一个模型应对多种任务、多种模态

2. 书生·浦语大模型开源历程

| 时间 | 动态活动 |

|---|---|

| 2023-6-7 | InternLM千亿参数语言大模型发布 |

| 2023-7-6 | InternLM千亿参数大模型全面升级,支持8K语境、26种语言,并全面开源,免费商用 |

| 2023-8-14 | 书生万卷1.0多模态预训练语料库开源发布 |

| 2023-8-21 | 升级版对话模型InternLM-Chat-7B v1.1发布,同时开源智能体框架Lagent,支持从语言模型到智能体升级转换 |

| 2023-8-28 | InternLM千亿参数模型参数量升级到123B |

| 2023-9-20 | 增强型InternLM-20B开源,开源工具链全线升级 |

| 2024-1-17 | InternLM2开源 |

3.书生·浦语2.0体系

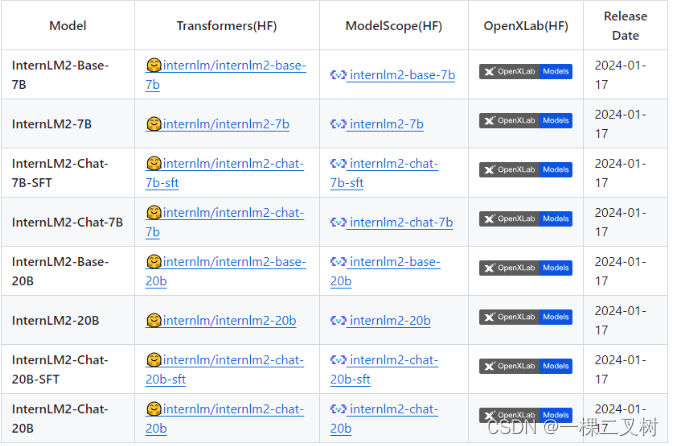

书生·浦语2.0开源链接

Github:https://github.com/InternLM/InternLM

HuggingFace:https://huggingface.co/internlm

ModelScope:https://modelscope.cn/organization/Shanghai_AI_Laboratory

OpenXLab:https://openxlab.org.cn/usercenter/OpenLMLab

InternLM2-Base:高质量和具有很强可塑性的模型基座,是模型进行深度领域适配的高质量起点;InternLM2:在Base基础上,在多个能力方向进行了强化,在评测中成绩优异,同时保持了很好的通用语言能力,是我们推荐的在大部分应用中考虑选用的优秀基座;InternLM2-Chat:在Base基础上,经过SFT和RLHF,面向对话交互进行了优化,具有很好的指令遵循、共情聊天和调用工具等的能力。

4.回归语言建模的本质

大模型的研究应回归语言建模本质,大模型各项性能提升的基础在于语言建模能力的增强。为此,书生·浦语2.0联合团队提出了新一代的数据清洗过滤技术,通过更高质量的语料以及更高的信息密度,筑牢大模型能力基础。

主要发展了以下几个方面的技术方法:

-

多维度数据价值评估:基于文本质量、信息质量、信息密度等维度对数据价值进行综合评估与提升; -

高质量语料驱动的数据富集:利用高质量语料的特征从物理世界、互联网以及语料库中进一步富集类似语料; -

针对性的数据补齐:针对性补充语料,重点加强现实世界知识、数理、代码等核心能力。

5.书生·浦语2.0的主要亮点

有效支持20万字超长上下文:模型在20万字长输入中几乎完美地实现长文“大海捞针”, 而且在 LongBench 和 L-Eval等长文任务中的表现也达到开源模型中的领先水平。综合性能全面提升:InternLM2 和 InternLM2-Chat 在各能力维度全面进步,在推理、数学、代码等方面的能力提升尤为显著,综合性能达到同量级开源模型的领先水平,在重点能力评测上 InternLM2-Chat-20B 甚至可以达到比肩 ChatGPT (GPT-3.5)的水平。优秀的对话和创作体验:InternLM2-Chat 可以精准地理解和遵循用户意图,具备较强的共情能力和丰富的结构化创作能力。在最新公布的 AlpacaEval2 英文主观对话榜单上,InternLM2-Chat-20B 超越了 GPT-3.5、 Gemini Pro 和 Claude-2 。工具调用能力整体升级:基于更强和更具有泛化性的指令理解、工具筛选与结果反思等能力,新版模型可以更可靠地支持复杂智能体的搭建,支持对工具进行有效的多轮调用,完成较复杂的任务。突出的数理能力和实用的数据分析功能:模型在不使用外部工具的条件下已具备不错的计算能力和推理能力,数理表现超过ChatGPT;在配合代码解释器(code-interpreter)的条件下,InternLM2-Chat-20B 在 GSM8K 和 MATH 上可以达到和 GPT-4 相仿的水平。 基于在数理和工具方面强大的基础能力,InternLM2-Chat 提供了实用的数据分析能力。

6.从模型到应用典型流程

7.书生·浦语全链路开源开放体系

数据: 书生万卷,具有2TB数据,涵盖多种模态与任务预训练: InternLM-Train,支持并行训练,进行了极致优化,速度达到3600 tokens/sec/gpu微调: XTuner,支持 全参数微调,支持LoRA等低成本微调部署: LMDeploy,支持全链路部署,性能领先,每秒生成2000+ tokens评测: OpenCompass,支持全方位评测,性能可复现,80套评测集,40万道题目应用: Lagent、AgentLego,支持多种智能体,支持代码解析器多种工具调用

数据

文本数据: 5亿个文档 ,数据量超 1TB

图像-文本数据集:超2200万个文件, 数据量超140GB

视频数据:超2200万个文件 ,数据量超140GB

预训练

高可扩展:支持从8卡到干卡训练千卡加速效率达 92%

极致性能优化:Hybrid Zero 独特技术+极致优化,加速 50%

兼容主流:无缝接入 HuggingFace等技术生态,支持各类轻量化技术

开箱即用:支持多种规格语言模型修改配置即可训练

微调

大语言模型的下游应用中,增量续训和有监督微调是经常会用到两种方式

增量续训

使用场景:让基座模型学习到一些新知识,如某个垂类领域知识

训练数据:文章、书籍、代码等

有监督微调

使用场景:让模型学会理解各种指令进行对话,或者注入少量领域知识

训练数据:高质量的对话、问答数据

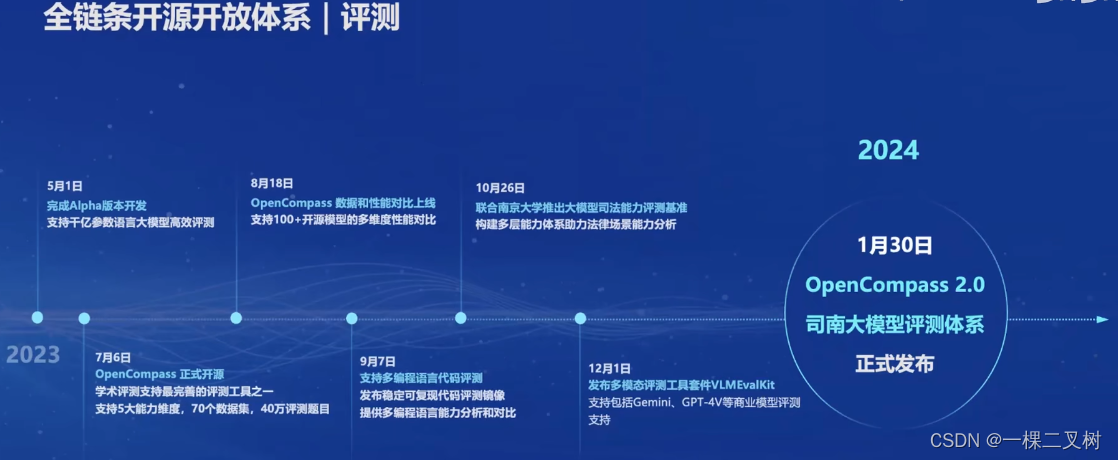

评测

| 时间 | 动态 |

|---|---|

| 2023-5-1 | 完成Alpha版本开发 |

| 2023-7-6 | OpenCompass正式开源 |

| 2023-8-18 | OpenCompass 数据和性能对比上线 |

| 2023-9-7 | 支持多编程语言代码评测 |

| 2023-10-26 | 联合南京大学推出大模型司法能力评测基准 |

| 2023-12-1 | 发布多模态评测工具客件VLMEvalKit |

| 2024-1-30 | OpenCompass 2.0司南大模型评测体系 |

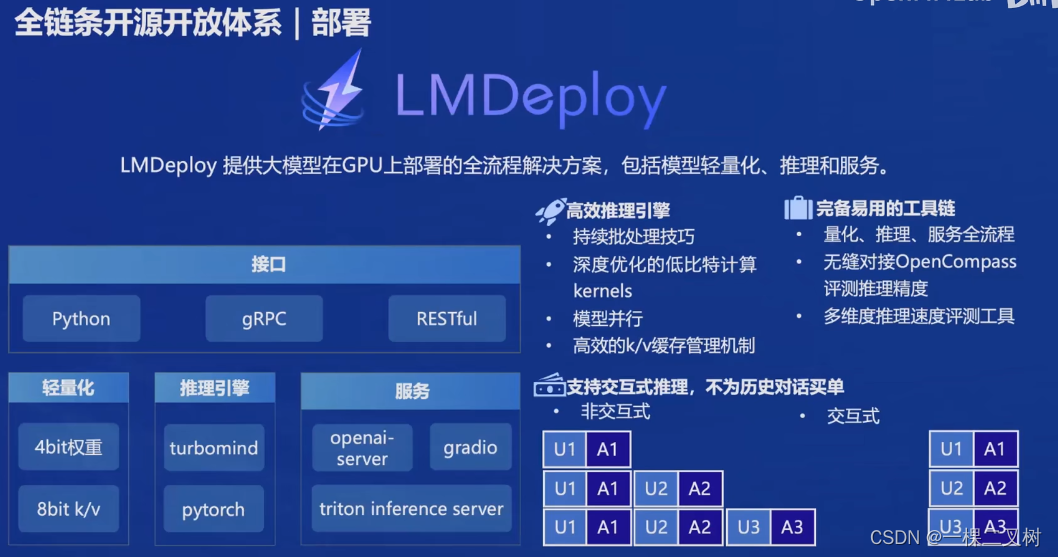

部署

LMDeploy 提供大模型在GPU上部署的全流程解决方案,包括模型轻量化、推理和服务。

应用

如:多模态智能体工具箱 AgentLego

1614

1614

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?