2023

摘要

基于提示的大型语言模型 (LLM) 在生成自然语言推理步骤或用于多步骤问答 (QA) 的思想链 (CoT) 方面具有惊人的强大功能。然而,当LLM无法获得必要的知识或在其参数范围内不是最新的知识时,他们就会陷入困境。虽然使用问题从外部知识源检索相关文本有助于LLM,但我们观察到这种一步检索和阅读方法不足以进行多步 QA。在这里,检索什么取决于已经导出的内容,而导出的内容又可能取决于先前检索的内容。 为了解决这个问题,我们提出了 IRCoT,一种多步骤 QA 的新方法,它将检索与 CoT 中的步骤(句子)交织在一起,用 CoT 指导检索,然后使用检索结果来改进 CoT。 将IRCoT 与 GPT3 结合使用可显着改善四个数据集上的检索(最多 21 个点)以及下游 QA(最多 15 个点):HotpotQA、2WikiMultihopQA、MuSiQue 和 IIRC。我们在分布外 (OOD) 设置以及较小的模型(例如 Flan-T5-large)中观察到类似的实质性收益,无需额外训练。 IRCoT 减少了模型幻觉,从而导致事实上更准确的 CoT 推理。

1 引言

在适当的提示下,大型语言模型能够通过生成逐步的自然语言推理步骤(所谓的思想链(CoT))来回答复杂的问题。当回答问题所需的所有信息要么作为上下文提供(例如代数问题),要么假设存在于模型参数中(例如常识推理)时,这种方法就成功了。然而,对于许多开放领域问题,所有必需的知识在模型参数中并不总是可用或最新的,从外部来源检索知识是有益的。

我们如何增强对需要复杂、多步骤推理的开放领域、知识密集型任务的思维链提示?

虽然仅基于问题从知识源中进行一次性检索可以成功地为语言模型增强许多基于事实的任务的相关知识,这种策略对于更复杂的多步骤推理问题有明显的局限性。对于此类问题,人们通常必须检索部分知识,执行部分推理,根据到目前为止完成的部分推理的结果检索其他信息,并进行迭代。例如,请考虑图 1 中所示的问题:“Lost Gravity 是在哪个国家制造的?”。使用该问题检索的维基百科文档(特别是Lost Gravity),因为查询没有提及Lost Gravity(失重力过山车)的制造地。相反,我们必须首先推断它是由一家名为 Mack Rides 的公司制造的,然后根据推断的公司名称进行进一步检索,以获得指向制造国的证据。

因此,检索和推理步骤必须相互通知。 如果没有检索,模型可能会由于幻觉而生成错误的推理步骤。此外,在不生成第一个推理步骤的情况下,由于缺乏与问题的词汇甚至语义重叠,因此无法轻松识别支持第二个步骤的文本。换句话说,我们需要检索事实以生成事实正确的推理步骤以及检索相关事实的推理步骤。

基于这种直觉,我们提出了一种解决该问题的交错方法,其思想是使用检索来指导思想链(CoT)推理步骤,并使用 CoT 推理来指导检索。 图 1 显示了我们的检索方法的概述,我们称之为 IRCoT.2 我们首先使用问题作为查询来检索一组基本段落。随后,我们交替执行以下两个步骤:

(i) 扩展 CoT:使用问题、迄今为止收集的段落以及迄今为止生成的 CoT 句子来生成下一个 CoT 句子;

(ii)扩展检索到的信息:使用最后一个 CoT 句子作为查询来检索其他段落以添加到收集的集合中。

我们重复这些步骤,直到 CoT 报告答案或达到允许的最大推理步骤数。终止后,所有收集的段落将作为检索结果返回。最后,我们使用这些作为通过直接 QA 提示或 CoT 提示回答问题的上下文。

我们在开放域设置下评估了我们的系统在 4 个多步推理数据集上的功效:HotpotQA 、2WikiMultihopQA、MuSiQue 和 IIRC。我们使用 OpenAI GPT3(代码-davinci-002)进行的实验表明使用 IRCoT 进行检索比基线、一步式、基于问题的检索在固定预算最佳回忆设置下通过 11-21 个回忆点更有效。当 IRCoT 与基于提示的阅读器结合使用时,它还会导致下游小样本 QA 性能得到显着改善(最多 15 个 F1 点),并将生成的 CoT 中的事实错误减少高达 50%。我们的方法也适用于更小的 Flan-T5 模型(11B、3B 和 0.7B),显示出类似的趋势。特别是,我们发现使用 Flan-T5-XL (3B) 和 IRCoT 进行 QA 的性能甚至优于基于一步问题检索的 58 倍大的 GPT3。此外,这些改进也适用于分布外 (OOD) 设置,其中在另一个数据集上进行测试时使用一个数据集的演示。最后,我们注意到我们的 QA 分数超过了最近关于开放域 QA 的小样本提示(ODQA)的研究报告的分数,尽管不可能与它们进行公平的同类比较(参见附录 C)。

总之,我们的主要贡献是一种新颖的检索方法 IRCoT,它利用 LM 的思想链生成功能来指导检索,并反过来使用检索来改进 CoT 推理。我们证明了 IRCoT:

- 在 IID 和 OOD 设置中,提高了多个多步骤开放域 QA 数据集上的检索和少样本 QA 性能;

- 减少生成的 CoT 中的事实错误;

- 无需任何训练即可提高大规模(175B 模型)和较小规模模型(Flan-T5-*,≤11B)的性能。

2 相关工作

提示进行开放域 QA。LLM只需使用几个示例作为提示即可学习各种任务。它们还被证明可以在几次或零次演示的提示下通过逐步推理(思维链,或 CoT)来回答复杂的问题。提示已应用于开放域 QA,但其在改进多步骤开放域问题的检索和 QA 方面的价值仍然相对未被充分开发。

最近提出了三种用于多步骤开放域 QA 的方法。 SelfAsk提示LLM将问题分解为子问题,并通过调用 Google Search API 回答子问题。 DecomP是一个通用框架,它分解任务并将子任务委托给适当的子模型。他们还分解问题,但将检索委托给基于 BM25 的检索器。这两种方法都不是为 CoT 推理而开发的,不关注检索问题,并且需要单跳 QA 模型来回答分解的问题。最近提出的 ReAct系统将问题规范为生成一系列推理和行动步骤。这些步骤要复杂得多,依赖于更大的模型 (PaLM-540B),并且需要进行微调以超越多步骤 ODQA 的 CoT。此外,这些工作都没有被证明对未经任何训练的较小模型有效。虽然与这些方法的直接比较并不简单(知识库、LLM、示例的差异),但我们发现我们的 ODQA 性能远高于所有可用的报告数据(§5)。

监督的多步骤开放域质量检查。

之前的工作已经探索了在完全监督的环境中开放域 QA 的迭代检索。达斯等人 (2019) 提出了一种迭代检索模型,该模型使用神经查询表示进行检索,然后根据阅读理解模型的输出进行更新。 Feldman 和 El-Yaniv (2019) 将类似的神经查询重构思想应用于多跳开放域 QA。熊等人(2021)将广泛使用的密集通道检索(DPR)扩展到多跳设置,此后由 Khattab 等人改进。浅井等人(2020) 利用维基百科段落中存在的实体链接诱导的图结构来执行迭代多步骤检索。 GoldEn(黄金实体)检索器根据从现成检索器检索的段落迭代生成文本查询,但需要为下一个查询生成器提供训练数据。中野等人 (2021) 使用 GPT3 通过与浏览器交互来回答长格式问题,但依赖于这些交互的人工注释。所有这些方法都依赖于大规模数据集的监督训练,并且不能轻易扩展到少样本设置。

3 思想链引导检索和开放域 QA

我们的目标是通过使用包含大量文档的知识源,在少样本设置中回答知识密集型多步骤推理问题 Q。 为此,我们遵循检索和阅读范式,检索器首先从知识源检索文档,QA 模型读取检索到的文档和问题以生成最终答案。 我们的贡献主要在于检索步骤(第 3.1 节),并且我们在阅读步骤(第 3.2 节)中使用标准提示策略。

如前所述,对于多步骤推理,检索可以帮助指导下一个推理步骤,进而可以告知下一步要检索什么。这激发了我们接下来讨论的交错策略。

3.1 交错检索与思维链推理

我们提出的检索器方法 IRCoT 可以通过以下三个要素进行实例化:

(i) 一个基本检索器,可以接受查询并从语料库或知识源返回给定数量的段落;

(ii) 具有零/少样本思想链(CoT)生成能力的语言模型;

(iii)少量带有推理步骤的带注释的问题,解释如何用自然语言(思想链)得出答案,以及来自知识源的一组段落,共同支持推理链和答案。

IRCoT 的概述如图 2 所示。我们首先通过使用问题 Q 作为查询检索 K 个段落来收集一组基本段落。然后,我们迭代地交错两个步骤(推理和检索),直到满足终止标准。

检索引导推理步骤(“Reason”)使用问题、迄今为止收集的段落以及迄今为止生成的 CoT 句子生成下一个 CoT 句子。该任务的提示模板如下所示:

对于上下文演示,我们使用上述格式的完整 CoT。对于测试实例,我们只向模型展示迄今为止生成的 CoT 句子,并让它完成其余的部分。尽管模型可能输出多个句子,但对于每个原因步骤,我们只采用第一个生成的句子并丢弃其余的。

对于上下文演示中的段落,我们使用ground-truth支持的段落和 M 个随机采样的段落,按照上述格式打乱并连接在一起。对于测试实例,我们显示迄今为止在所有先前检索步骤中收集的所有段落。如果生成的 CoT 句子包含“answer is:”字符串或已达到最大步骤数 4,则我们终止该过程并返回所有收集的段落作为检索结果。 CoT 引导的检索步骤(“检索”)使用最后生成的 CoT 句子作为查询来检索更多段落并将它们添加到收集的段落中。我们限制收集的段落总数5,以便在模型的上下文限制中至少容纳一些演示。

3.2 问答阅读器

QA阅读器使用从检索器中检索到的段落来回答问题。 我们认为QA 阅读器的两个版本通过两种提示策略实现:CoT 提示和直接提示。对于 CoT 提示,我们使用与第 3.2 节中所示相同的模板,但在测试时我们要求模型从头开始生成完整的 CoT。 CoT 的最终句子预计采用“答案是:…”的形式,以便可以通过编程方式提取答案。如果不是这种形式,则返回完整的一代作为答案。对于直接提示,我们使用与 CoT 提示相同的模板,但答案字段(“A:”)仅包含最终答案而不是 CoT。参见应用程序G了解详情。

4 实验设置

我们在开放域设置中的 4 个多步骤 QA 数据集上评估我们的方法:HotpotQA、2WikiMultihopQA、MuSiQue 的可回答子集,以及 IIRC 的可负责子集。对于 HotpotQA,我们使用它附带的维基百科语料库进行开放域设置。对于最初来自阅读理解或混合设置的其他三个数据集,我们使用相关的上下文来构建一个我们的开放域设置的语料库(有关详细信息,请参阅 App. A)。对于每个数据集,我们使用原始开发集中的 100 个随机抽样问题来调整超参数,并使用其他 500 个随机抽样问题作为我们的测试集。

4.1 模型

检索器。 我们使用 Elasticsearch6 中实现的 BM25作为我们的基础检索器。我们比较两种检索系统:

(i) 一步检索器 (OneR) 使用问题作为查询来检索 K 个段落。我们选择开发集上最好的 K ∈ {5, 7, 9, 11, 13, 15}。

(ii)IRCoT Retriever 是我们在第 3 节中描述的方法。我们使用 BM25 作为其底层检索器,并使用 OpenAI GPT3(代码 davinci-002)和不同大小的Flan-T5作为CoT 生成器进行实验。

为了向这些 LM 演示上下文中的示例,我们为所有数据集编写了 20 个问题的 CoT(参见 App.§G)。然后,我们通过对每个数据集的每个问题采样 15 个问题来创建 3 个演示(“训练”)集。对于每个实验,我们使用第一个演示集搜索开发集的最佳超参数,并使用选定的超参数评估测试集上的每个演示集。我们报告每个实验的这 3 个结果的平均值和标准差。

在测试时,我们在模型的上下文长度限制内打包尽可能多的演示。 GPT3 (code-davinci-002) 的上下文限制是 8K 字片。 Flan-T5-* 没有任何硬限制,因为它使用相对位置嵌入。但我们将 Flan-T5 的上下文限制为 6K 字片,这是我们 80G A100 GPU 内存所能容纳的最大值。

IRCoT Retriever 有一个关键的超参数:K ∈ {2, 4, 6, 8},即每一步要检索的段落数。此外,在为 IRCoT 的 Reasoner 模块创建“训练”演示时,我们使用黄金段落和较少数量的 M ∈ {1, 2, 3} 干扰段落(第 3.1 节)。

检索指标: 我们允许所有检索系统最多包含 15 个段落,并衡量检索到的段落集中黄金段落的召回率。我们搜索能够最大化开发集召回率的超参数 K(以及 IRCoT 的 M),并将其用于测试集。因此,报告的指标可以被视为所考虑的每个系统的固定预算最佳召回率。

QA阅读器。 为了实现阅读器,我们使用与 IRCoT Retriever 的推理步骤中使用的相同的 LM。我们发现使用 Flan-T5-* 实现的 QA 阅读器在直接提示策略下表现更好,而 GPT3 在 CoT 提示策略下表现更好(参见附录 E)。因此,我们在实验中使用 Flan-T5-* 的 QA 直接提示策略和 GPT3 的 CoT 进行实验。

QA 阅读器有一个超参数 M:上下文演示中干扰段落的数量。我们在{1,2,3}中搜索M。当与 IRCoT 检索器结合使用时,M 与 CoT 生成器和读取器绑定。

开放域 QA (ODQA) 模型。 将检索器和阅读器放在一起,我们尝试使用由 OneR QA 和 IRCoT QA 表示的各种语言模型构建的 ODQA 模型。对于 IRCoT QA,CoT 生成器和读取器的 LM 选择保持不变。我们还用无检索器的 QA 阅读器 NoR QA 进行实验,以评估 LM 仅从其参数知识回答问题的能力。为了为 ODQA 模型选择最佳超参数,我们搜索使开发集上的答案 F1 最大化的超参数 K 和 M。

IIRC 的结构与其他数据集略有不同,因为它的问题基于主要段落,其他支持段落来自该段落中提到的实体的维基百科页面。我们稍微修改了检索器和阅读器来解决这个问题(参见 App.B)。

5 结果

IRCoT检索优于一步检索 图3比较了OneR与IRCoT检索器,关于Flan-T5-XXL和GPT 3 LM。对于这两种模型,IRCoT在所有数据集上的性能都明显优于一步检索。对于Flan-T5-XXL,IRCoT相对于一步检索提高了我们的召回指标,在HotpotQA上提高了7.9,在2 WikiMultihopQA上提高了14.3,在MuSiQue上提高了3.5,在IIRC上提高了10.2点。对于GPT 3,这一改善分别为11.3、22.6、12.5和21.2点。

IRCoT QA优于NoR和OneR QA。 图4比较了使用由Flan-T5-XXL和GPT 3 LM制成的NoR、OneR和IRCoT回收器的ODQA性能。对于Flan-T5-XXL,IRCoT QA在HotpotQA上的表现优于OneR QA 9.4分,在2 WikiMultihopQA上的表现优于OneR QA 15.3分,在MuSiQue上的表现优于OneR QA 5.0分,在IIRC上的表现优于OneR QA 2.5分。对于GPT 3,相应的数字(IIRC除外)为7.1,13.2和7.1 F1点。对于GPT 3,IRCoT没有改善IIRC的QA评分,尽管检索显著改善(如图3所示的21分)。这可能是因为IIRC相关知识可能已经存在于GPT 3中,其NoR QA评分相似也证明了这一点。对于其他数据集和模型组合,NoR QA比IRCoT QA差得多,表明模型参数知识的局限性。

IRCoT在OOD设置中是有效的。 由于CoT可能并不总是很容易为新数据集编写,因此我们评估了NoR,OneR和IRCoT对新数据集的推广,即OOD设置。为此,我们使用来自一个数据集的即时演示来评估另一个数据集。对于所有数据集对10以及Flan-T5-XXL和GPT 3,我们发现与IID设置相同的趋势:IRCoT检索优于OneR(图5),IRCoT QA优于OneR QA和NoR QA(图6)。

IRCoT生成的CoT具有较少的事实错误。 为了评估我们的方法是否也提高了生成的CoT的真实性,我们使用GPT 3手动注释了NoR QA,OneR QA和IRCoT QA生成的CoT,用于四个数据集中的40个随机抽样问题。如果至少有一个事实不为真,我们则认为CoT存在事实错误。如图7所示,NoR犯的事实错误最多,OneR犯的错误较少,IRCOT最少。特别是,IRCoT在HotpotQA和2WikiMultihopQA上分别将OneR的事实错误减少了50%和40%。

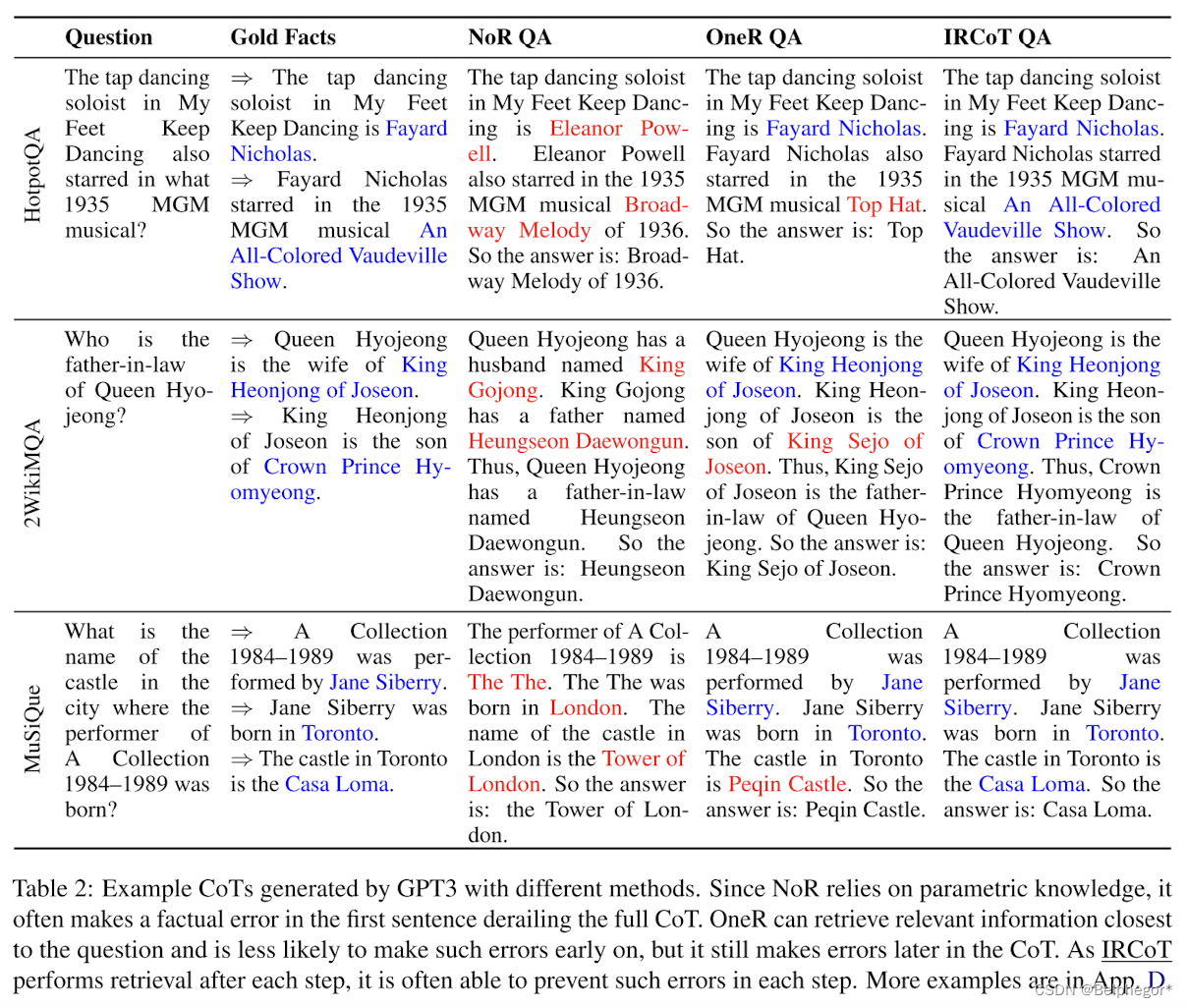

表2说明了不同的CoT预测方法在性质上有所不同。由于NoR完全依赖于参数知识,它经常在第一句话中犯一个事实错误,这会使整个CoT脱轨。OneR可以检索最接近问题的相关信息,并且在早期不太可能犯这样的错误,但在CoT后期仍然会犯错误。另一方面,IRCoT通常能够在每个步骤中防止此类错误。

IRCoT对较小的模型也有效。 为了了解IRCoT在不同LM尺寸下的有效性,我们在图8 中展示了缩放图,我们使用Flan-T5 {base(0.2B),large(0.7B),XL(3B),XXL(11B)}和GPT 3 code-davinci-002(175 B)比较了OneR和IRCoT的召回率。即使是最小的模型(0.2B)的IRCoT也优于OneR,性能大致随着模型大小而提高。这表明即使是小模型的CoT生成功能也可以用于改进检索。此外,我们在图9 中显示了模型大小对QA评分的影响。对于除最小尺寸(0.2B)外的所有尺寸,我们看到IRCoT QA优于OneR QA。此外,在所有数据集中,具有3B模型的IRCoT甚至优于具有58倍大的175B GPT3模型的OneR和NoR。

IRCoT是用于少射多步ODQA的SOTA。 我们将IRCoT QA与最近使用LLM进行ODQA的五种方法进行比较:Internet-Augmented QA、RECITE、ReAct、SelfAsk和DecomP。虽然这些不是直接比较,因为不同的方法使用不同的API,知识来源,甚至LLM(有关详细信息,请参阅App.C),但以排行榜风格探索IRCoT相对于这些最新系统发布的最佳数字的表现仍然是有益的。

如表1所示,IRCoT QA在很大程度上优于所有这些最新系统,在通过检索增强LLM(无监督训练)可实现的方面设定了一个新的最新技术水平。

6 总结

A 构建检索语料库(Corpora)

HotpotQA已经为开放域设置提供了相关的维基百科语料库,所以我们直接使用它。然而,2 WikiMultihopQA和MuSiQue最初是阅读理解数据集。2 WikiMultihopQA和MuSiQue中的问题分别与10和20个段落相关联,其中2-4个是支持性的,其他是不支持性的。为了将这些数据集转换为开放域设置,我们制作了两个语料库,每个数据集一个,通过组合训练集、开发集和测试集中所有问题的所有支持和非支持段落。IIRC最初是阅读理解和开放域设置的混合。每个问题都基于一个主要段落,其中包含多个维基百科页面的链接,每个页面有几个段落。我们从维基百科的所有段落中创建了一个语料库。18我们假设主要段落的可用性,不需要检索并且总是存在。然而,为了保持检索问题的挑战性,我们并不假设在主要段落中有维基百科的链接。

B IIRC模型的特殊处理

IIRC模型的特殊处理IIRC与其他数据集略有不同,因为问题基于主要段落,其他支持段落来自本文中提到的实体的维基百科页面。我们修改检索器和阅读器来解释这种差异:

(i)无论使用何种检索策略,我们总是将主要段落作为模型输入的一部分。

(ii)对于所有检索方法,我们首先提示模型使用主要段落和问题生成维基百科页面标题列表。

我们将这些生成的标题映射到语料库中最近的维基百科页面标题(使用BM 25找到),然后将其余段落检索查询的范围仅限于这些维基百科页面。

为了提示模型使用主要段落和问题为IIRC生成维基百科页面标题,我门使用以下模板:

对于“training”,即对于演示(demonstrations),N(≤ 3)是支持问题的维基百科页面标题的数量。在测试时,由于支持页面标题的数量是未知的,我们使用固定值3。我们发现,这种在测试时提示模型生成更多标题的技巧比让模型自己决定生成多少标题更能提高其召回率。

C 与以前使用LLM的ODQA系统的比较

我们在第5节中展示了与以前使用大型语言模型进行开放域QA的方法的排行榜风格的比较。我们注意到,尽管存在各种差异,但这种比较并不是头对头的。我们简要介绍每种方法以及API、LLM、检索语料库和其他选择的差异。

互联网增强的QA进行(一步)谷歌搜索检索,对其执行额外的基于LLM的过滤,然后提示LLM使用结果上下文回答问题。它使用Gopher 280 B语言模型。RECITE绕过检索,而是提示LLM首先从其自己的记忆中生成(背诵)一个或多个相关段落,并以该生成为条件生成答案。他们用许多LLM进行实验,其中性能最高的是我们在这里报告的代码-davinci-002。ReAct提示LLM产生推理和动作跟踪,其中动作是对维基百科API的调用,以返回给定维基百科页面标题的摘要。它使用PALM 540 B型号。SelfAsk提示LLM将问题分解为子问题,并通过向Google Search API发出单独的调用来回答这些子问题。它使用GPT 3(text-davinci-002)模型。最后,DecomP是一个通用框架,它分解任务并将子任务委托给适当的子模型。与我们的系统类似,它使用BM 25搜索和GPT 3(code-davinci-002)模型。以及最后DSP提供了一种以编程方式定义LLM和ODQA检索之间的交互的方法(例如,通过问题分解),引导这样一个程序的演示,并使用它们来预测答案。它使用GPT3.5 LLM和基于ColBERT的检索。由于这些方法中的大多数使用不同的知识源或API,并且使用不同的LLM和检索模型构建,因此很难在这些系统之间进行公平的科学比较。此外,在各自的论文中的评估是在不同的随机子集(来自相同的分布)的测试实例。

尽管存在这些差异,但以排行榜风格探索IRCoT相对于这些最新系统发布的最佳数字的表现仍然是有益的。表3显示了不同系统的结果,包括同期和更新的数字。本表中的两个新系统(相对于表1)是DecomP(较新版本)和DSP。虽然IRCoT在MuSiQue上仍然是SOTA,但DSP在HotpotQA上的表现优于它2.0分,而Decomp的新版本在2WikiMultihopQA上的表现优于IRCoT 2.8分。

我们推测DecomP在2WikiMultihopQA上表现良好,因为它只有几个易于预测的分解模式,DecomP的问题分解可以利用这些模式。HotpotQA和MuSiQue中缺乏这种模式导致其与IRCoT相比表现不佳。最后,评估DSP是否适用于像HotpotQA这样的2跳问题,这将是有用的,它将适用于像MuSiQue这样具有不同跳数的数据集。我们把这个进一步的调查留给未来的工作。

D 其他CoT生成示例

除了表2中提供的示例之外,表5还提供了关于NoR QA、OneR QA和IRCoT QA方法的CoT生成如何变化的示例。这让我们深入了解IRCoT如何提高QA性能。由于NoR完全依赖于参数知识,它经常在第一句话中犯一个事实错误,这会使整个推理链脱轨。其中一些事实信息可以由OneR修复,特别是最接近问题的信息(即,可以通过提问的方式来回答)。这不足以修复所有的错误。因为IRCoT在每个步骤之后都涉及检索,所以它可以在每个步骤中修复错误。

E Direct vs CoT提示阅读器

表4比较了Flan-T5-XXL和GPT3的阅读器选择(direct vs CoT提示阅读器)。我们发现,Flan-T5-XXL作为阅读器与直接阅读器一起工作得更好,而GPT3作为阅读器与CoT阅读器一起工作的更好。因此,对于论文中的主要实验,我们采用这种选择。请注意,第5节中讨论的趋势(IRCoT QA>OneRQA>ZeroRQA)与阅读器的选择无关。

F IRCoT QA中的单独读取器

IRCoT通过构造产生CoT作为其检索过程的一部分。因此,我们也可以从检索过程中生成的CoT中提取答案,而不是使用单独的事后阅读器。如表6所示,这种消融的效果。对于Flan-T5-XXL来说,拥有一个单独的阅读器明显更好。对于GPT 3,这并不总是正确的,但至少有一个单独的阅读器的模型总是更好或接近没有的模型。因此,总的来说,我们选择在本文中使用阅读器进行实验。

G 提示

我们为HotpotQA、2 WikiMultihopQA、MuSiQue和IIRC手动编写的思想链注释分别在Listing1、2、3和4中给出。我们的GPT 3 CoT测试提示与这些相同,除了它们在问题的顶部有维基百科段落,如§ 3.1所示。我们对GPT 3直接验证的提示与CoT提示相同,除了直接在“A:“之后有答案。我们对Flan-T5-* 的提示与GPT 3略有不同。对于CoT验证,我们将问题第一行:“问:通过逐步推理回答以下问题。“.对于直接提问,我们在问题行前面加上前缀:“Q:回答以下问题。“.我们这样做是为了遵循Flan-T5-* 的训练格式,并发现它有助于其CoT生成。

Listing

1 CoT 注释 HotPotQA

Q:Jeremy Theobald和Christopher Nolan的职业是什么?

A:杰里米·西奥博尔德是一名演员和制片人。克里斯托弗·诺兰是一位导演、制片人和编剧。因此,他们都是生产者。答案是:生产者。

Q:布赖恩帕特里克巴特勒导演的哪部电影的灵感来自于F. W.穆瑙?

A:布赖恩帕特里克巴特勒导演的电影幻影小时。《幻影时刻》的灵感来自于《诺斯费拉图》和《卡里加里博士的内阁》等电影。其中Nosferatu由F.W.执导。莫瑙答案是:幻影时刻。

Q:在韩国电视连续剧中,柳惠英扮演了多少集?

A:柳惠英扮演宝拉的韩国电视连续剧是《回答1988》。《1988》的剧情数量是20集。答案是:20。

问:《垂直极限》中哪位演员也在《正确的东西》中扮演宇航员艾伦谢泼德?

答:在《正确的东西》中扮演宇航员艾伦谢泼德的演员是斯科特·格伦。电影《垂直极限》也由斯科特·格伦主演。所以答案是:斯科特·格伦。

问:威尔士湖医疗中心所在城市2014年的人口是多少?

答:威尔士湖医疗中心位于佛罗里达州波尔克县。2014年,波尔克县的人口为15,140人。答案是:15140。

Q:谁是第一个出生的?简·德·邦特还是拉乌尔沃尔什?

答:Jan de Bont出生于1943年10月22日。拉乌尔沃尔什出生于1887年3月11日。因此,拉乌尔沃尔什是第一个出生的。所以答案是:拉乌尔沃尔什。

问:《失去的重力》是在哪个国家制造的?

答:失去的重力(过山车)是由麦克游乐设施。Mack Rides是一家德国公司。所以答案是:德国。

问:以下哪一个有一个首张专辑题为“我们有一个紧急情况”:热或操作医学博士?

答:乐队“热”的首张专辑是“弥补故障”。The Operation M.D.乐队的首张专辑“我们有紧急情况”所以答案是:医学博士行动。

Q:这位被关押在关塔那摩湾拘留营并出版了《关塔那摩:我的旅程》的澳大利亚人是在哪个国家接受帕拉军事训练的?

答:被关押在关塔那摩湾拘留营并出版《关塔那摩:我的旅程》的澳大利亚人是大卫希克斯。大卫希克斯在阿富汗接受了帕拉军事训练。答案是:阿富汗。

…

2 CoT注释for 2WikiMultihopQA.

问:电影《伪君子》的导演是什么时候去世的?

答:电影《伪君子》是由米格尔·莫雷塔导演的。2013年6月19日,Miguel Morayta去世。答案是:2013年6月19日。

问:电影《苦力一号》(1995年电影)的导演和电影《耸人听闻的审判》的导演是同一国籍吗?

答:《苦力1号》(1995年电影)由大卫·达万执导。《耸人听闻的审判》由卡尔·弗罗因德执导。大卫达万的国籍是印度。卡尔·弗罗因德的国籍是德国。因此,他们没有相同的国籍。所以答案是:不。

问:库拉姆加希和特洛伊克斯蒂都位于同一个国家吗?

答:库拉姆加希位于巴基斯坦。Trojkrsti位于马其顿共和国。因此,他们不在同一个国家。所以答案是:不。

问:马丁·霍奇和伊万尼娅·马丁尼奇谁是第一个出生的?

答:马丁·霍奇出生于1959年2月4日。Ivania Martinich出生于1995年7月25日。马丁·霍奇是第一个出生的。所以答案是:马丁·霍奇。

问:哪部电影最先上映,《诡计之夜》还是《家谱》?

答:《诡计之夜》出版于1939年。《家谱》出版于1979年。于是,《恶作剧之夜》就先出来了。所以答案是:恶作剧之夜。

问:电影《地狱的笑声》的导演是什么时候去世的?

答:电影《地狱的笑声》是由爱德华·L.卡恩Edward L.卡恩于1963年8月25日去世。答案是:1963年8月25日。

…

3 for MuSiQue

问:第一个大型冬季嘉年华是什么时候在CIMI-FM获准广播的城市举行的?

答:CIMI-FM获准在魁北克市广播。魁北克市的第一个大型冬季狂欢节于1894年举行。答案是:1894年。

问:内维尔·A是什么时候?斯坦顿的雇主创立的?

答:内维尔·A的雇主。斯坦顿是南安普顿大学。南安普顿大学成立于1862年。答案是:1862年。

问:希伯伦位于哪个县,在同一个省的遗产地保护法适用?

答:《遗产地保护法》适用于爱德华王子岛的管辖范围。希布伦位于爱德华王子岛的王子郡。答案是:王子郡。

问Q:在康涅狄格州拥有最多Zagat评级餐厅的城市,美国大学出版了哪本周刊-Lite:帝国学术界如何拆除我们的文化?

答:《美国-轻松:帝国学院如何拆除我们的文化》的作者是大卫·格勒恩特。大卫格勒恩特在耶鲁大学接受教育。康涅狄格州拥有最多Zagat评级餐厅的城市是纽黑文。耶鲁大学在纽黑文发行的周刊是《耶鲁先驱报》。所以答案是:耶鲁先驱报。

问:制定ISO 21500标准的组织总部在哪里?

答:ISO 21500的标准是由国际标准化组织制定的。国际标准化组织总部设在日内瓦。所以答案是:日内瓦。

…

4 for IIRC

问:充电器的踢球者和四分卫之间的年龄差是多少?

A:充电器的踢球者是内特·卡丁。充电器的四分卫(QB)是菲利普里弗斯。Nate Kaeding出生于1982年。菲利普·里弗斯出生于1981年。因此,他们之间的年龄差为1岁。所以答案是:1.

问:把这个营从新南威尔士带到锡兰的那艘船服役了多少年?

答:把这个营从新南威尔士带到锡兰的船是休伊特将军的。休伊特将军于1811年在加尔各答下水。休伊特将军在1864年被卖为绿巨人或被分解。因此,她总共服役了1864 - 1811 = 53年。答案是:53。

问:举办2016年NFL选秀的剧院是哪一年建成的?

答:举行2016年NFL选秀的剧院是礼堂剧院。大礼堂剧院建于1889年。答案是:1889年。

问:到纳瓦作为一线队防守的替补回到米兰的那一年,米兰成立了多久?

答:纳瓦在1990年回到米兰,作为一队防守的替补。米兰成立于1899.因此,当米兰回到米兰作为一线队防守的预备队时,米兰已经成立了1990 - 1899 = 91年。答案是:91。

问:斯科特出生的城市是什么时候建立的?

答:斯科特出生在伊利诺斯州的库克斯维尔镇。库克斯维尔成立于1882年。答案是:1882年。

…

773

773

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?