1.全连接层

全连接层就是该层的所有节点与输入节点全部相连,如图所 示。假设输入节点为X1,

X

2,

X

3,输出节点为

Y

1,

Y

2,

Y

3,

Y

4。令

矩阵

W

代表全连接层的权重,

W

12也就代表

X

2对

Y

1的贡献,令

b

为全 连接层的偏置项,b

1代表

Y

1的偏置,有如下关系。

Y

1=

W

11×

X

1+

W

12×

X

2+

W

13

X

3+

b

1

Y

2=

W

21×

X

1+

W

22×

X

2+

W

23×

X

3+

b

2

Y

3=

W

31×

X

1+

W

32×

X

2+

W

33×

X

3+

b

3

Y

4=

W

41×

X

1+

W

42×

X

2+

W

43×

X

3+

b

4

完全使用全连接层搭建的网络称为全连接网络。但一般而言,全 连接层通常是在深度神经网络最后阶段使用,用来将卷积网络或者循 环神经网络提取得到的局部或全局信息,进行综合考量,将总体信息 映射到分类空间。全连接层的缺点是参数量较大,例如,当输入层维 度为1024,输出层维度为100时,那么全连接层拥有的参数量为 1024×100+100=102500。

2.卷积层

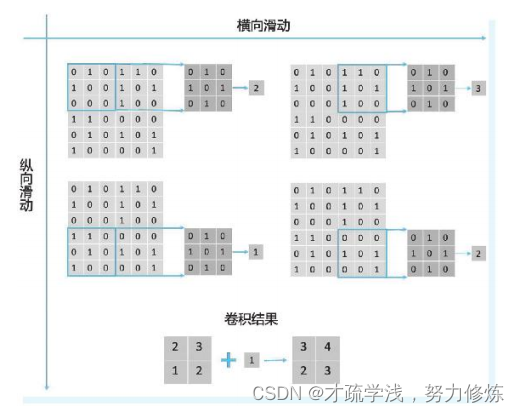

在数字信号处理中,卷积常被用来进行低通滤波和高通滤波的操 作,因此在神经网络中卷积层也常常与滤波器和过滤器这两个名词混 用。在深度学习中,卷积层的计算是使用一个预定义大小的卷积核在 输入数据上做滑动相乘处理,将所得乘积之和加上偏置项作为当前位置的响应,如图1.8所示。令输入信号的高和宽为6,卷积核的高和宽 为3时,左上方的计算过程为(0×0)+(1×1)+(0×0)+(1×1)+(0×0)+ (0×1)+(0×0)+(0×1)+(0×0)=2,将卷积核进行图1.8所示的横纵向移动,重复对应位置相乘并求和的操作,得到剩下的三个值为3,1, 2。加上偏置项,在下例中偏置项为1,所以卷积操作最终得到的结果 为[3,4,2,3]。

下面引入卷积步长的概念,在上图中,无论是横向还是纵向移 动,卷积核与上次所在位置的距离均为3,这就是所谓的卷积步长。 对于本例来说,卷积步长为3,横纵向均只需要移动两次即可完成对 输入信号的卷积。若卷积步长为1,则横纵向分别需要移动4次。这里 给出一般形式下的表达,令输入信号的大小为H×

W

,卷积核的大小 为k

×

k

,卷积步长为

s

,那么完成卷积需要的移动次数也就是[(

H-

k

)

/s

+1]×[(

W-k

)

/s

+1]。因为每移动一次就会得到一个结果,所 以卷积后的特征大小也就为[(H-k

)

/s

+1]×[(

W-k

)

/s

+1]。在深度 学习中常见的卷积步长为1和2。

上面的计算公式中存在一个细节问题,即得到的移动次数为小数时如何处理?比如当本例中输入大小变为7×7,其他条件不变,上式 得到的移动次数为2.33×2.33。最简单的方法是取整,只移动两次, 剩余的数据不处理,但是这样会造成数据丢失。在深度学习中,一般 采用边缘填充的方法,可以在输入特征的四周填上一圈数值,令输入特征的大小变为9×9,重复之前的运算过程可以得到大小为3×3的 卷积结果。因此上面的公式中一般还需要引入边缘填充,令边缘填充 的大为p

,卷积后的大小可以表示为[(

H-k

+2×

p

)

/s

+1]×[(

W-

k

+2×

p

)

/s

+1]。 事实上,在深度学习中,特征除了高和宽外,还有通道维度,令 特征通道数为C

,则输入特征的维度可表示为

C

×

H

×

W

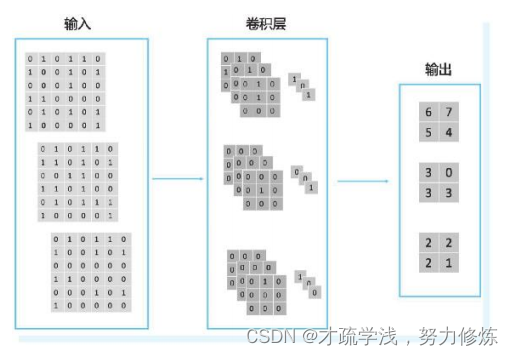

。举例来说, 当输入特征维度为3×7×7时,可以认为上图仅代表三个通道中第一 个通道上的计算过程,实际上还有两个通道在进行类似的运算,如下图所示。可以看到卷积核需要和输入特征拥有相同的通道数,这样才 能满足输入特征和卷积核在对应通道上相乘的要求。最后所有通道的

运算结果相加在一起,形成输出[6,7,5,4]。

然而上图中存在一个问题,即无论输入特征通道数为多少,输出 特征通道数一定为1,如上图中卷积运算后得到的输出特征维度为 1×2×2。如何改变输出特征的通道数呢?深度学习中采用的方法是堆叠卷积核,即一个卷积层存在多个卷积核,卷积核的数目对应了输出特征的通道数。举例来说,若需要一个维度为3×2×2的输出,则该卷 积层需要有3个上图中的卷积核,如下图所示。 总结来说,卷积层中卷积核的数目等于输出特征的通道数,卷积核的通道数等于输入特征的通道数。现在给出一般性的表达,若输入 特征的维度为C×H

×

W

,输出特征通道数为

D

,卷积核大小为

K

×

K

, 则该卷积层的权重维度为D

×

C

×

K

×

K

,偏置维度为

D

×

C

,总参数量为两者之和,即

D

×

C

×(

K

×

K

+1)。

从上面的计算过程可以得到卷积层相对于全连接层的一些优势, 比如卷积层保留了空间位置信息,充分利用了自然图片中空间局部的相关性。在卷积操作中通过参数共享的方式大大减小了参数量。此外 卷积层能够很好地表达多种特征,可以将卷积层中的多个卷积核视为不相关的特征提取器。假设存在一个人脸识别模型,其第一个卷积核判断该人物是否为女性,第二个卷积核判断其是否为长发,第三个卷积核判断其肤色,多个卷积核结合在一起,综合得到该人物不同属性的输出特征,其可以作为身份判别的依据。值得注意的是,上例只是理想情况,实际上卷积层会存在信息冗余,导致输出特征在两个不同的通道上具有高度的相关性。

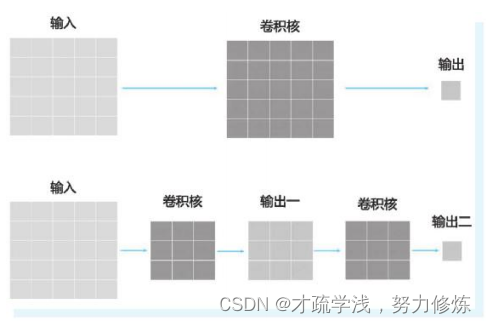

在实际应用中,卷积核的大小一般为3,5,7等奇数,小尺寸卷 积在网络中更为常见。小卷积将会导致卷积层看到的输入范围变小 了,比如对于人脸图像而言,可能3×3的大小内所有像素的颜色都是一样的,卷积核看到的也就是一个单纯的色块,而不包含有助于分类 的信息。相反的,如果卷积的尺寸变大,它能够看到整张人脸,这时 候才可以学习到一些有价值的信息,这就是感受野的重要性。但小卷 积带来的感受野问题可以通过堆叠卷积层来实现。举例来说,如下图所示分别是一个大小为5×5的卷积核和两个大小为3×3的卷积核。可以看到,它们的运算结果尺寸相同,因此最后两者输出特征的感受野是相同的,所以堆叠小卷积能够取得和大卷积相同的感受野。

但是小卷积的优势在于其参数量更小,比如在不考虑偏置项时,大小为5×5的卷积核的参数为25个,两个大小为3×3的卷积核的参数一共为18个。随着深度的堆叠,小卷积参数量的优势将体现得更加明显,所以采用小尺寸卷积是非常常见的做法。

3.池化层

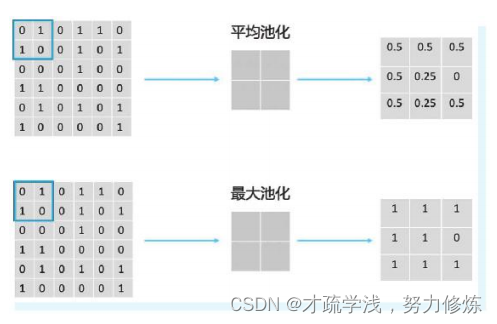

池化层又被称为下采样层,它一般处于连续的卷积层之间,

用来降低信息冗余,实现特征压缩

。常见的池化操作分为最大池化和平均池化两种,如下图所示。图中选用的池化窗口大小为2×2,步长为2。池化层和卷积层同理,在宽和高为6×6的输入特征上,横纵向只需要移动3次即可完成池化操作。平均池化是选择窗口中所有值的平均值作为当前位置的响应,最大池化是选择当前窗口中的最大值作为当前位置的响应,所以池化层是一个无参数的层。在池化步长方面,一般取2较为常见,池化窗口的大小可按需设定。当池化窗口大小等于输入信号的大小时,又被称为全局池化。

值得注意的是,在图像上常使用的池化为二维池化,即不对通道维进行池化。举例来说,当输入特征大小为4×6×6,池化窗口大小为2×2,池化步长为2时,得到的输出特征大小为4×3×3,输出特征的通道维数仍然和输入特征保持一致。

除上述下采样和降维的作用外,池化层也引入了不变性。这里的不变性代指平移不变性和旋转不变性等。举例来说,假设存在两张图片,它们的内容一致,但第二张图片相对第一张图片向右平移了一 些。对于卷积特征来说,其结果就是第一张图片的特征相对于第二张图片的特征也向右平移了一些。但如果应用最大池化,虽然最大值向右平移了,但只要它仍然位于池化窗口的范围内,那么经过池化层,第一张图片的特征能够和第二张图片保持一致。同时因为深度特征的感受野比较大,对大感受野的输入特征进行平均池化或最大池化,一 定程度上相当于允许了输入图片在经过平移和旋转后仍能获得相对固定的表达。

1936

1936

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?