💥💥💞💞欢迎来到本博客❤️❤️💥💥

🏆博主优势:🌞🌞🌞博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。

⛳️座右铭:行百里者,半于九十。

📋📋📋本文目录如下:🎁🎁🎁

目录

⛳️赠与读者

👨💻做科研,涉及到一个深在的思想系统,需要科研者逻辑缜密,踏实认真,但是不能只是努力,很多时候借力比努力更重要,然后还要有仰望星空的创新点和启发点。当哲学课上老师问你什么是科学,什么是电的时候,不要觉得这些问题搞笑。哲学是科学之母,哲学就是追究终极问题,寻找那些不言自明只有小孩子会问的但是你却回答不出来的问题。建议读者按目录次序逐一浏览,免得骤然跌入幽暗的迷宫找不到来时的路,它不足为你揭示全部问题的答案,但若能让人胸中升起一朵朵疑云,也未尝不会酿成晚霞斑斓的别一番景致,万一它居然给你带来了一场精神世界的苦雨,那就借机洗刷一下原来存放在那儿的“躺平”上的尘埃吧。

或许,雨过云收,神驰的天地更清朗.......🔎🔎🔎

💥1 概述

核主成分分析(Kernel Principal Component Analysis,简称KPCA)是一种基于核方法的主成分分析(PCA)技术。它是PCA在非线性映射空间中的推广,可以用于数据的降维和特征提取。在KPCA中,通过选择合适的核函数(如径向基函数、多项式核等),可以将原始数据映射到一个高维的特征空间中,在这个空间中进行PCA。

KPCA的主要步骤如下:

1. 选择一个核函数K,该函数将原始数据点之间的内积转换为特征空间中的点之间的内积。

2. 计算核矩阵K,该矩阵包含了所有数据点之间的核函数值(即内积在特征空间中的表示)。

3. 对核矩阵K进行中心化处理,得到中心化核矩阵K'。

4. 对中心化核矩阵K'进行特征分解,得到特征值和特征向量。

5. 选择前m个最大的特征值对应的特征向量,作为新的低维空间的基。

KPCA的优势在于它可以处理非线性数据,因为将数据映射到高维空间后,在新的空间中可能可以找到更好的线性结构。但是,KPCA的缺点是计算复杂度较高,特别是在数据集较大时,因为需要计算整个核矩阵,这通常是O(n^2)的操作。此外,KPCA的选择核函数和参数超参数的调整也是一个挑战。

KPCA在模式识别、图像处理、生物信息学等领域有着广泛的应用。

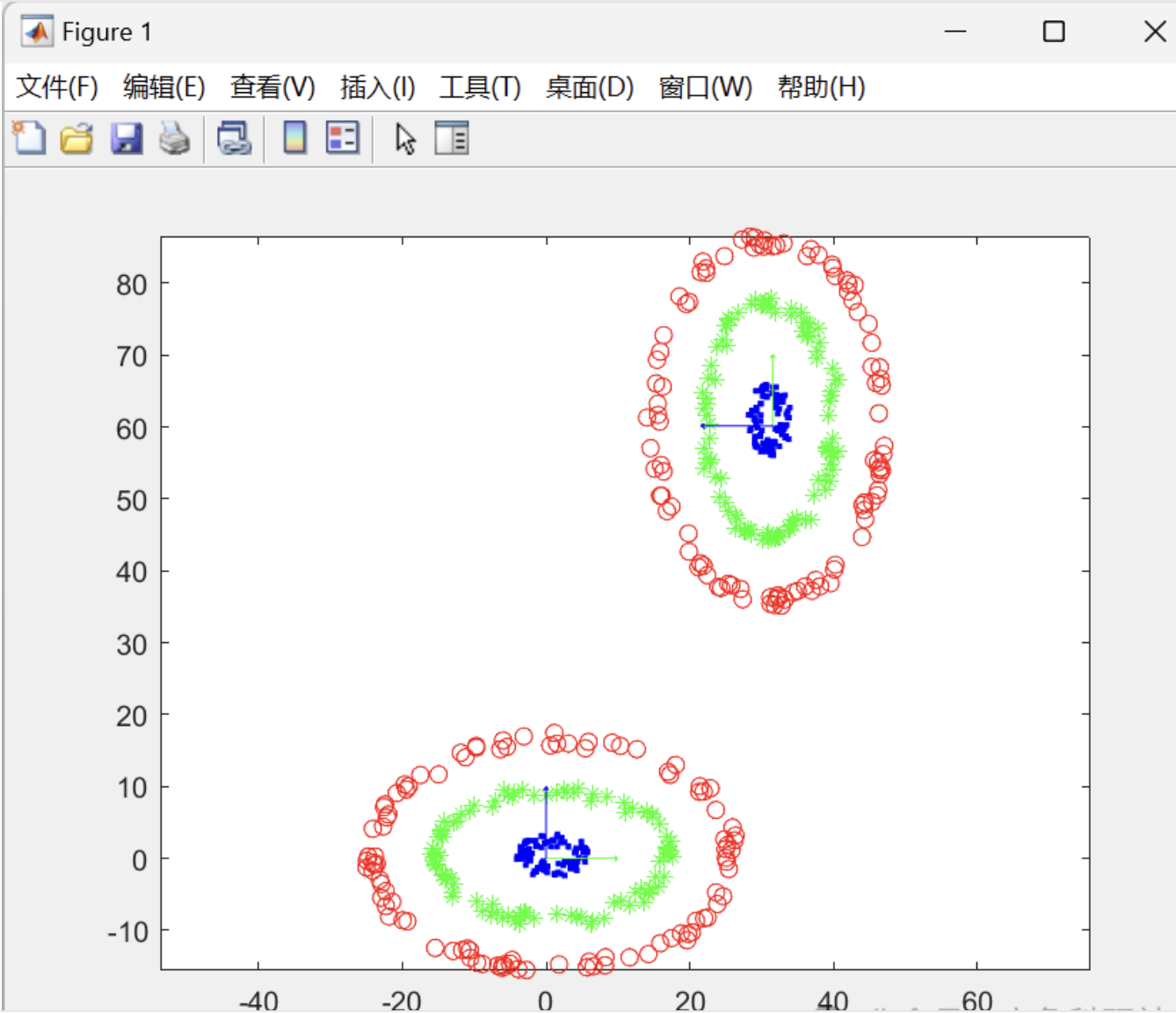

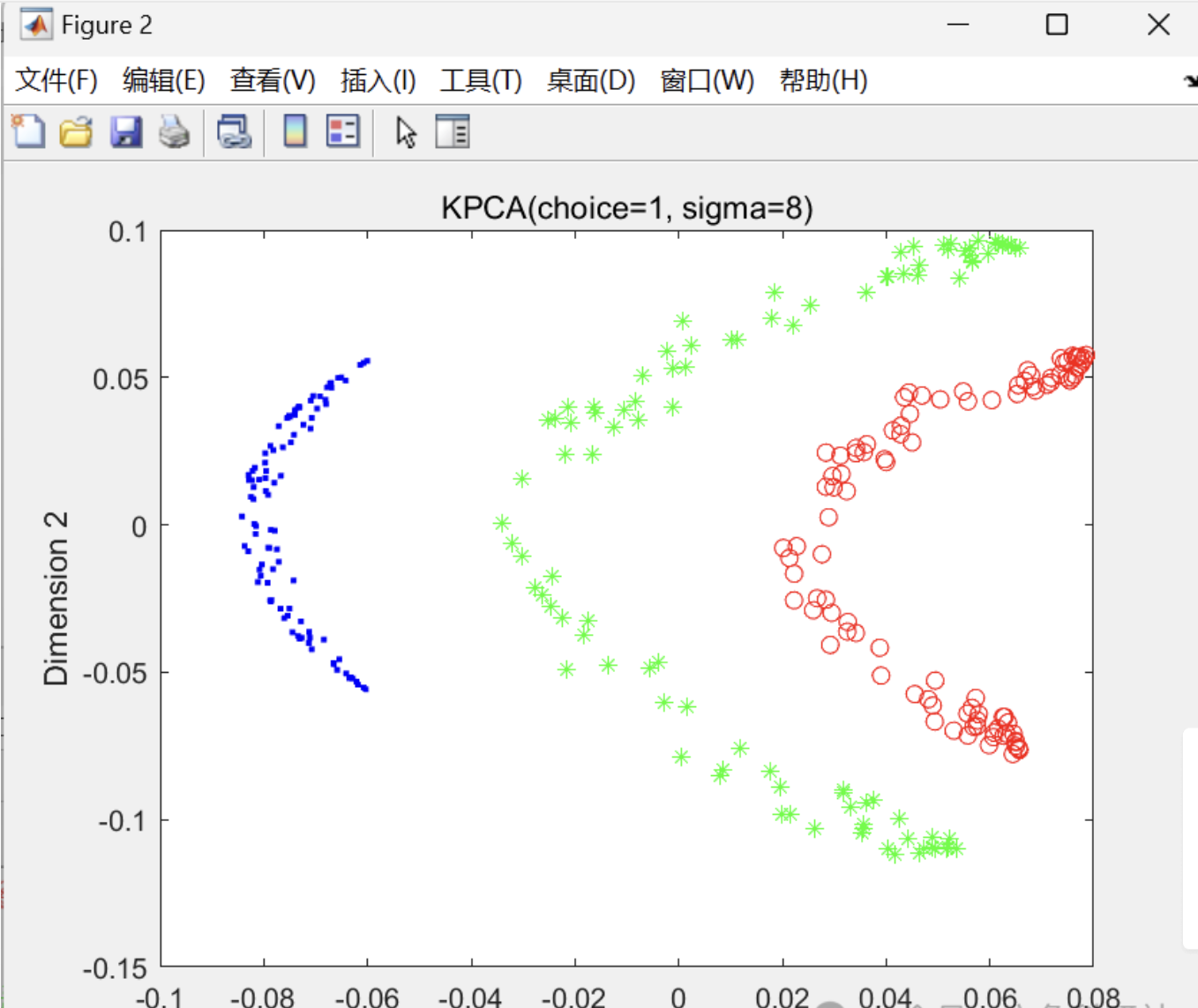

📚2 运行结果

🎉3 参考文献

文章中一些内容引自网络,会注明出处或引用为参考文献,难免有未尽之处,如有不妥,请随时联系删除。

[1]孙新程,孔建寿,刘钊.基于核主成分分析与改进神经网络的电力负荷中期预测模型[J].南京理工大学学报,2018,42(03):259-265.

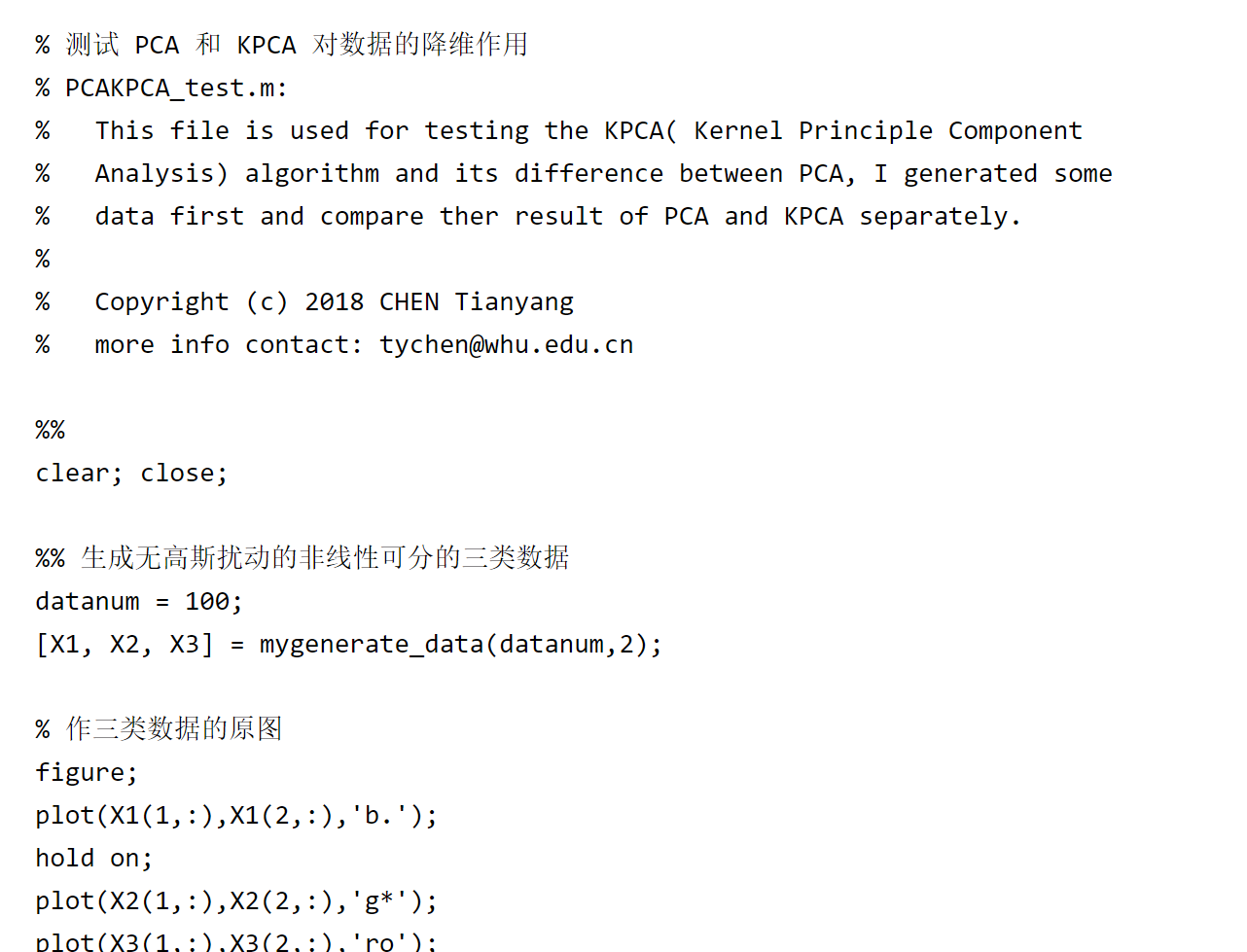

🌈4 Matlab代码实现

资料获取,更多粉丝福利,MATLAB|Simulink|Python资源获取

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?