一. 功能:

功能:本代码简单爬取了某东商品的所有评论,并对评论进行TF-IDF词频分析,绘制不同词性的词云和统计条形图饼图,以及对评论进行情感分析,找到好评并绘制出好评词云词频

二. 使用方法:

-

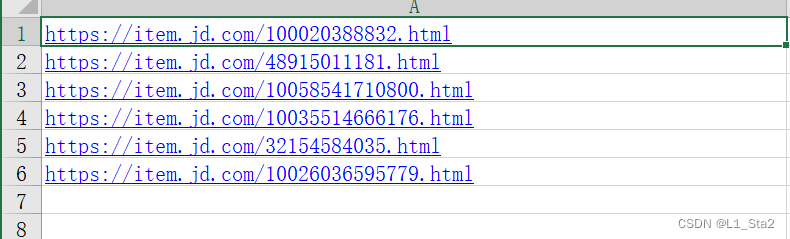

将需要爬取的所有链接放在根目录下的/urls文件夹中的urls.xlsx文件中按列排好(不需要名称等,只需要放链接)如图:

-

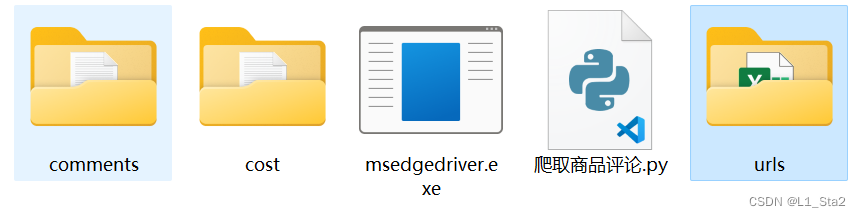

将EdgeDriver放在爬取商品评论.py中相应的位置(我指定的是根目录下),在根目录下新建几个文件夹“comments”,“cost”用于储存返回的结果(也可以修改代码,使用mkdir和判断语句来判断当前是否存在上述文件夹并按情况新建。目录如下

-

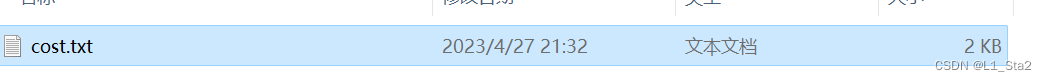

运行爬取商品评论.py,等待爬虫结束就可以在上述新建的文件夹中comments的对应商品名称里找到当前商品的所有评论。运行后comments和cost中的txt文件如下:

-

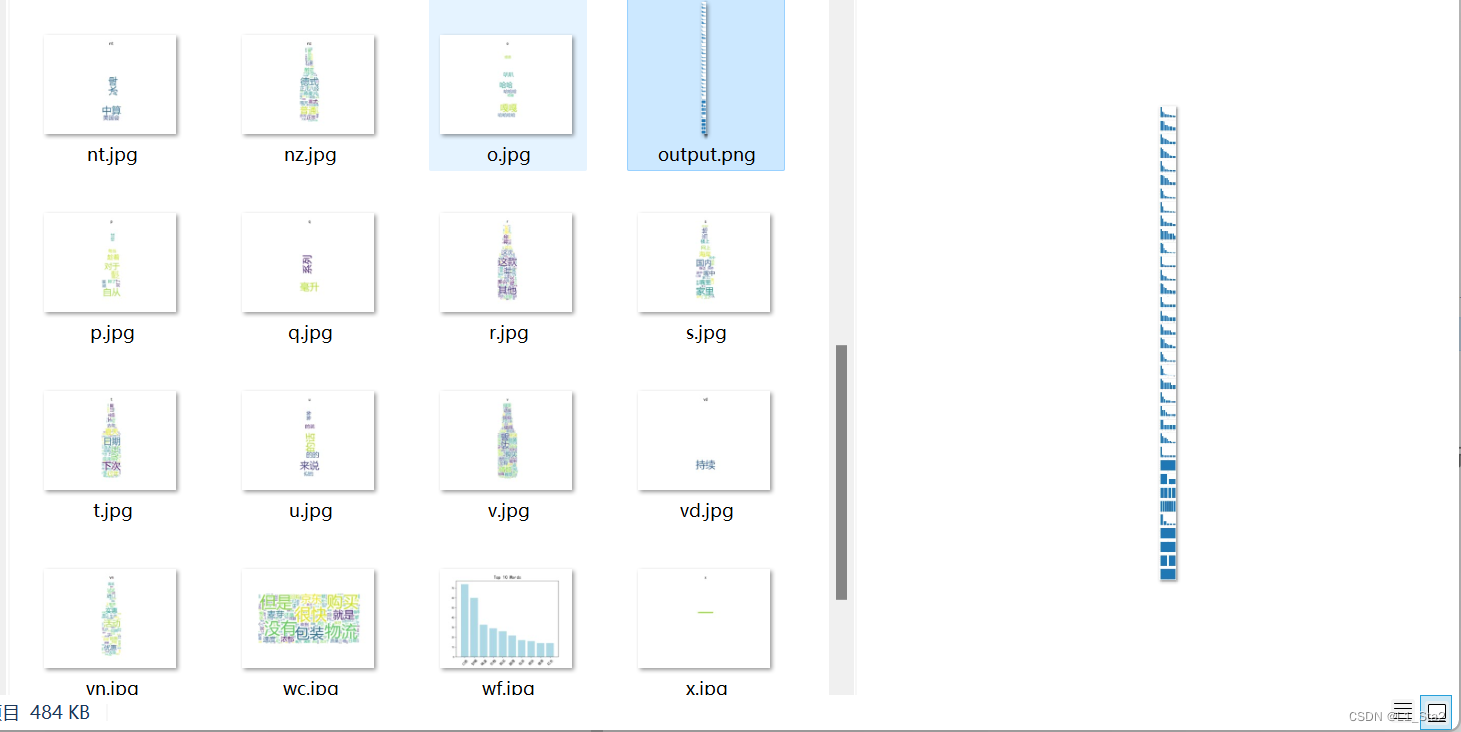

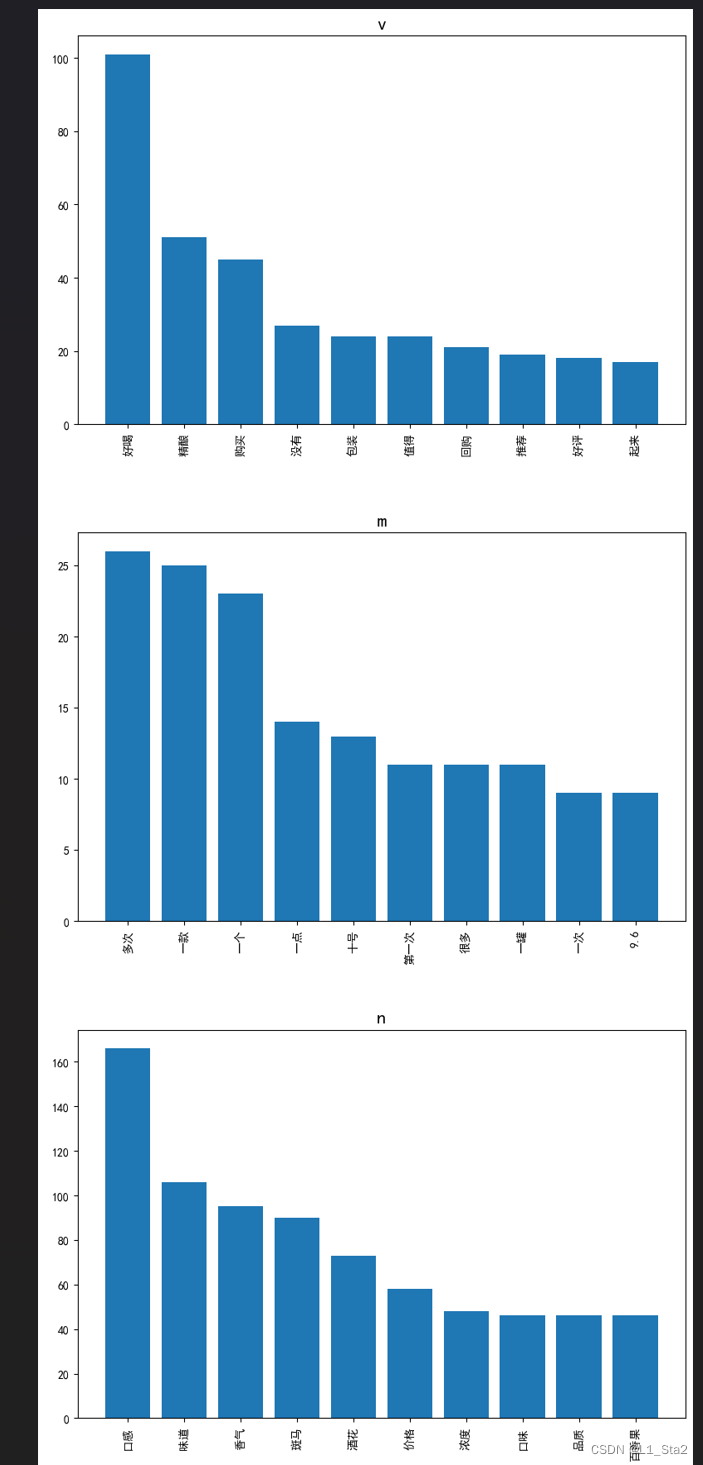

在根目录下新建文件夹”词性分析“,新建一个停用词表”stopwords.txt“,其中内容按照自己的需要修改,按行间隔两个词,运行词性分析.py,得到的运行结果是所有词性词语的词云,以及一张整合了所有词性的词频图,如下图所示

-

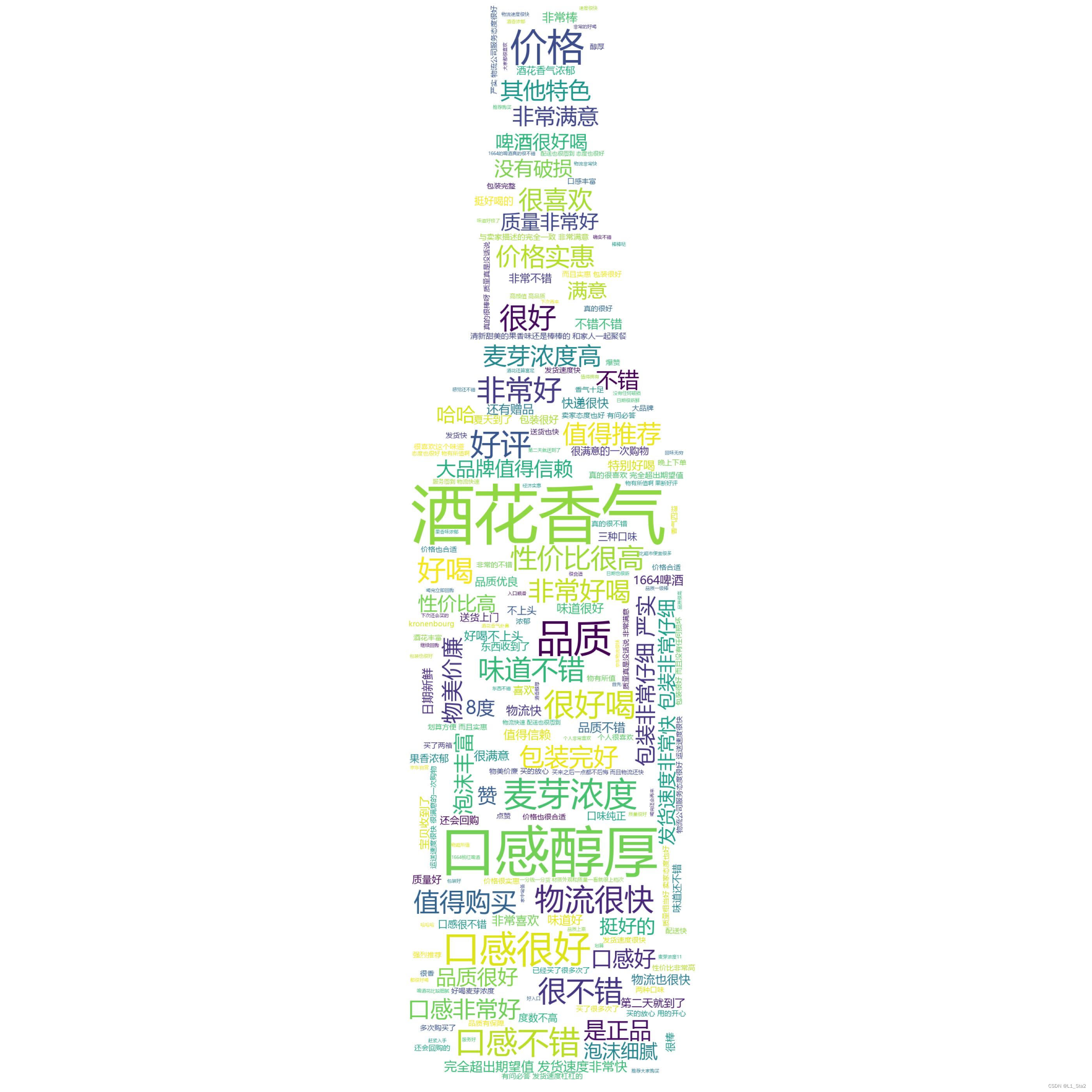

新建文件夹”好评分析“,运行情感分析.py,得到最后的情感分析结果,最后整个根目录结构如下

情感分析结果示例如下(以某品牌啤酒为例)

643

643

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?