具体请看智谱仓库github:GitHub - THUDM/ChatGLM3: ChatGLM3 series: Open Bilingual Chat LLMs | 开源双语对话语言模型

或者Huggingface:https://huggingface.co/THUDM/chatglm3-6b

1. 利用Anaconda建立一个虚拟环境:

conda create -n chatglm3 python=3.11 (版本太低安装streamlit会出问题)

conda activate chatglm32. 安装torch的GPU版:

根据自己本地计算机显卡和系统选择官方上相应的指令:

conda install pytorch torchvision torchaudio pytorch-cuda=12.1 -c pytorch -c nvidia这块安装时间较长,耐心等待,反复尝试,直到安装成功为止。其中,需要测试一下GPU的CUDA功能是否可以正常使用:

print(torch.version.cuda) #查看cuda版本

print(torch.cuda.is_available()) # 查看cuda是否可用

print(torch.cuda.device_count()) # 查看可行的cuda数目如果以上指令运行没问题,显示True,说明可以GPU可以正常使用。

3.开始安装ChatGLM3,根据以上官网地址的说明进行如下操作:

选择D盘或者其他盘建立一个本地文件,利用管理员权限打开一个cmd窗口运行如下命令:

git clone https://github.com/THUDM/ChatGLM3

cd ChatGLM3然后使用 pip 安装依赖:

pip install -r requirements.txt此外,使用 Code Interpreter 还需要安装 Jupyter 内核:

ipython kernel install --name chatglm3-demo --user

然后,进入basic_demo目录下,实现三种新的样例测试

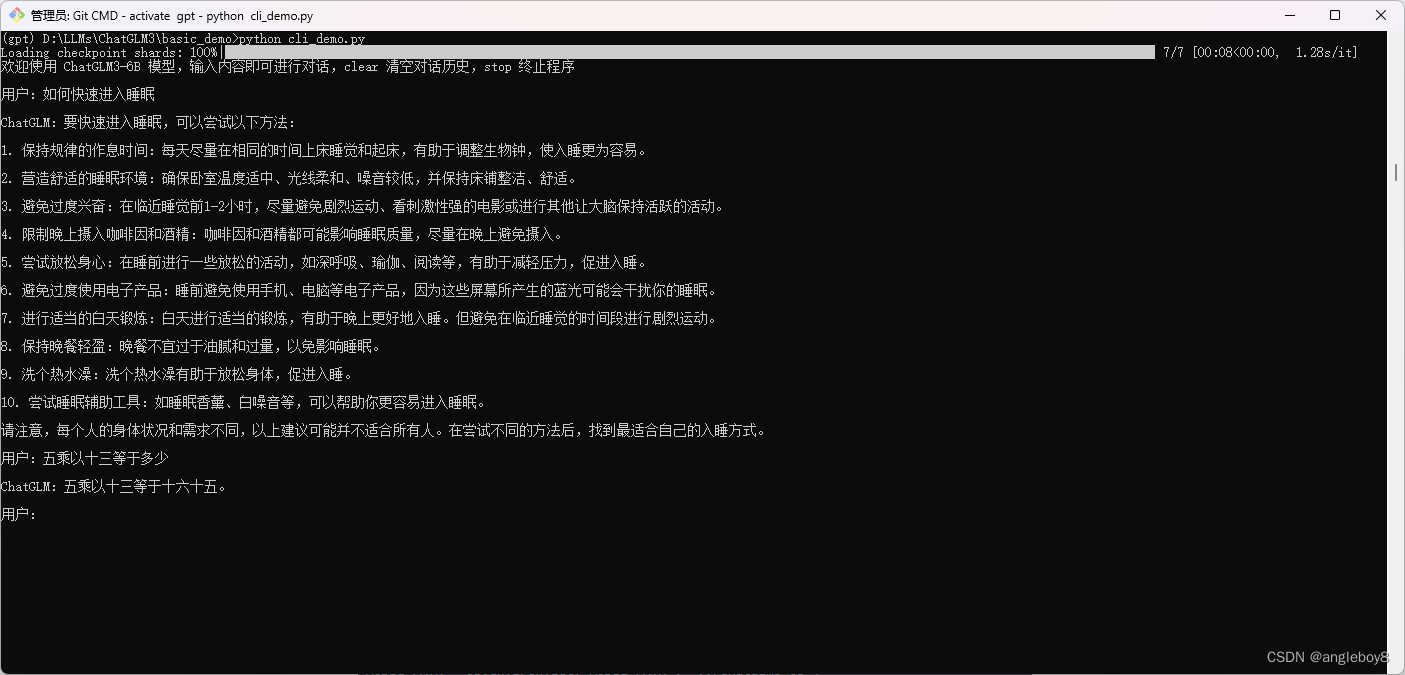

1)案例1——指令窗口

运行如下指令:

python cli_demo.py

指令对话窗口案例2:

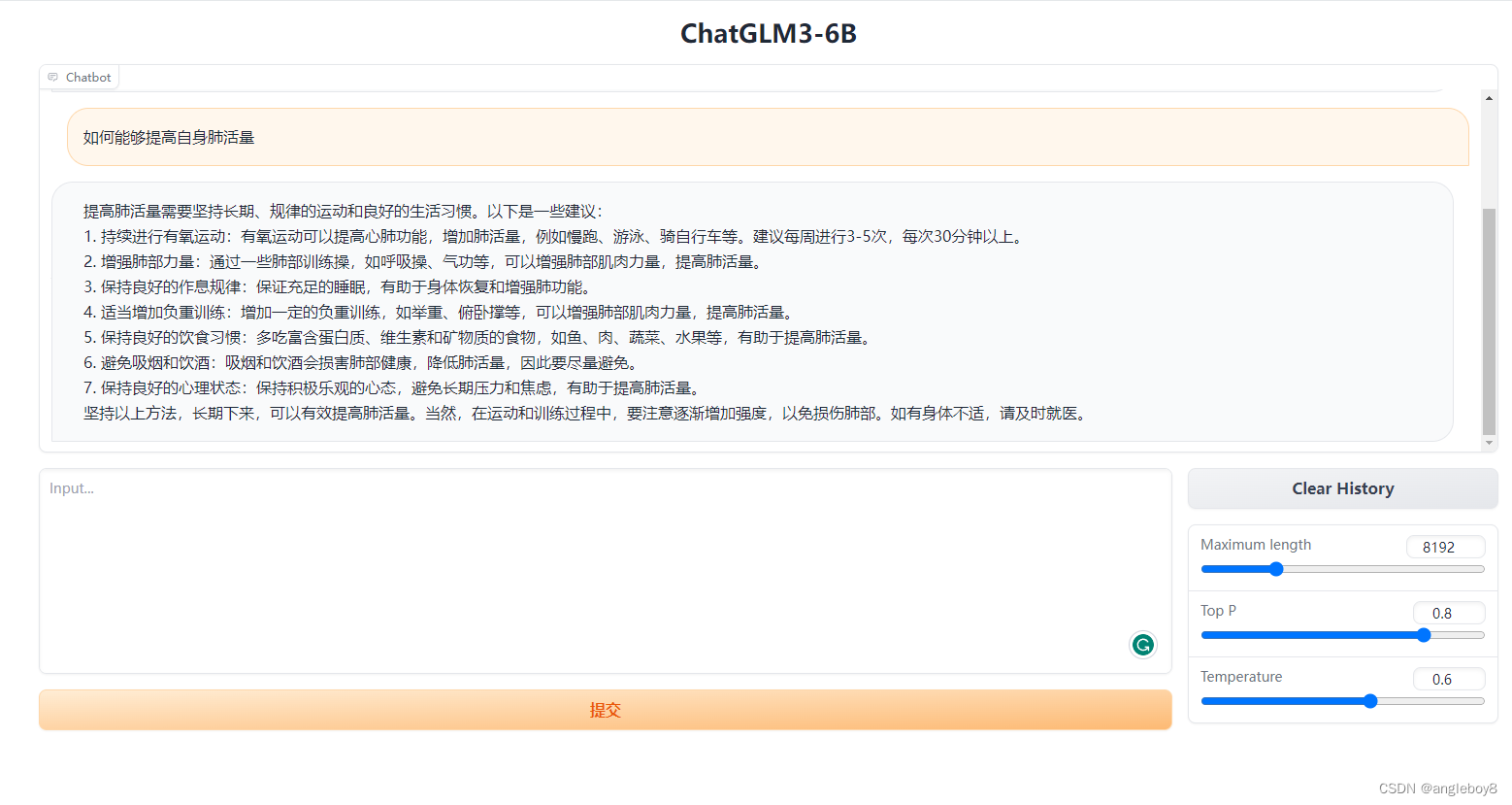

2) 案例2——Gradio

运行如下命令:

python web_demo.py

注意:如果不输出结果,是由于Gradio的版本过高,建议安装pip install gradio==3.40版本。太低会报错,比如3.39版本。

3) 案例3——streamlit

运行如下命令:

streamlit run web_demo2.py

其中,需要修改一下路径,将下载好的模型放到本目录下,将第6行程序改为

将MODEL_PATH = os.environ.get('MODEL_PATH', 'THUDM/chatglm3-6b')改为

MODEL_PATH = os.environ.get('MODEL_PATH', '../chatglm3-6b')这样所有的程序和模型都在一起,方便管理。

程序启动之后,浏览器显示如下:

安装过程中一些注意事项:

- 遇到“RuntimeError: nvrtc: error: failed to open nvrtc-builtins64_121.dll.

Make sure that nvrtc-builtins64_121.dll is installed correctly.”

需要将虚拟环境下的“nvrtc-builtins64_121.dll”文件拷贝到C:\Windows\System32目录下,即可解决。

8万+

8万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?