RNN,循环神经网络是一种最新的神经网络结构,和CNN不同的是,它不光在spatial上有一个forward的方向,同时还有一个依赖于时间的传播方向。其中最出名的,当属LSTM(long short time memory)长短期记忆网络。

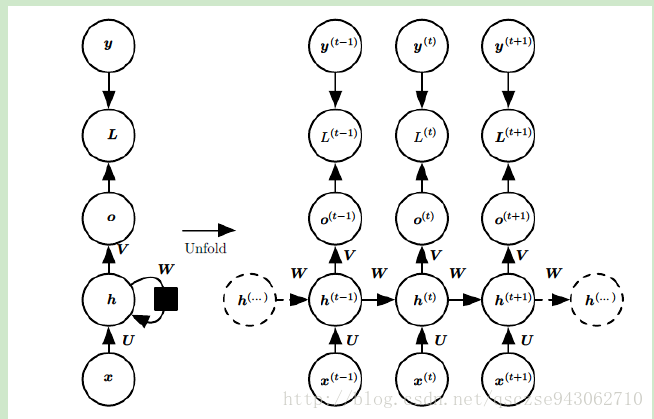

RNN architecture

传统的RNN的结构如上所示(左边的图为原始结构,右边的为按照时间序列展开后的结构,这里一个圆圈代表一层,是一系列神经元的集合,这里只画了一个隐藏层),这里纵向方向为FNN中的空间索引防线,横向方向为时间方向,需要注意的是,在所有时间方向上的参数矩阵W是相同的,空间方向上V和U亦是如此,这也体现了RNN“循环反馈”的思想。

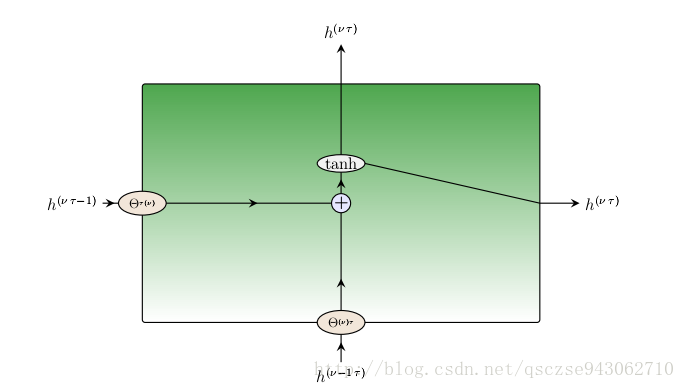

每个隐藏单元按照如上的方式进行操作,隐藏层的激活函数为tanh函数(现也常用ReLU)。

Input layer

上图中的 x(t) ,不同的时刻有不同的输入。

Out layer

每一个时刻都有一个对应的输出,这个跟FNN是一致的,因此最终的输出也是一个时间序列。回归问题使用均方误差,分类问题使用交叉熵。

Forward propagation in RNN

RNN的前向传播和FNN基本一致,唯一不同的就是在空间方向上的每个节点不光与前一个空间节点有关,还与前一个时间节点有关。

我们有:

Backpropagation in RNN

同FNN,反向传播的基点即是损失函数对输入求导,采用梯度方法更新参数。这里我们需要求解的有 U,W,V,b,c 共5个参数。

在每个时间

t

,我们的输出都有一个损失

可以看到

V,c

,只与前一个空间方向的节点有关:

根据损失函数的不同,上式的第一项有不同的结果,接下来求解 W,U,b ,这三项既跟空间上的前一个单元有关,还和时间方向的上一个单元有关。同样地,我们定义在索引t位置的隐藏状态的梯度为:

求解最后一个时刻 T 的梯度:

递推:

上述式子可以直接化简,然后我们求解:

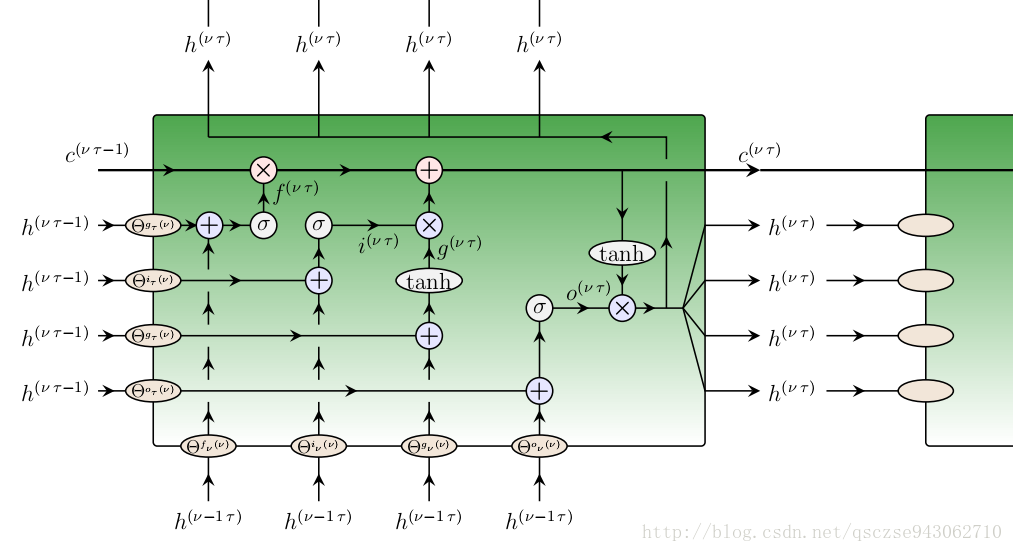

RNN-LSTM architecture

长短期记忆网络是RNN的一个变体,也是目前应用最多的RNN结构。它的核心是在每个隐藏层,有三个门:

1.input,用来控制是否让当前时间的新信息进入。

2.output,输出。

3.forget,用来控制遗忘哪些历史信息。

图中的

σ

为sigmoid激活函数,它将结果映射为0-1之间的数,这也是为什么称之为“门”:值在0-1从而决定是否让信息通过。

LSTM的前向传播过程在图中已经说的很清楚了,至于反向传播,类似RNN,只不过这里的每个梯度需要考虑更多的信息来源,

2807

2807

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?