上一篇文章介绍了Attention机制在语音识别和MNT中的应用,由于上篇文章篇幅较长,所以分出本章对Attention进行继续介绍。

接下里会介绍2篇文章。

第一篇为William Chan 等人在2015年8月份提出的比较经典的Listen, Attend and Spell[1],

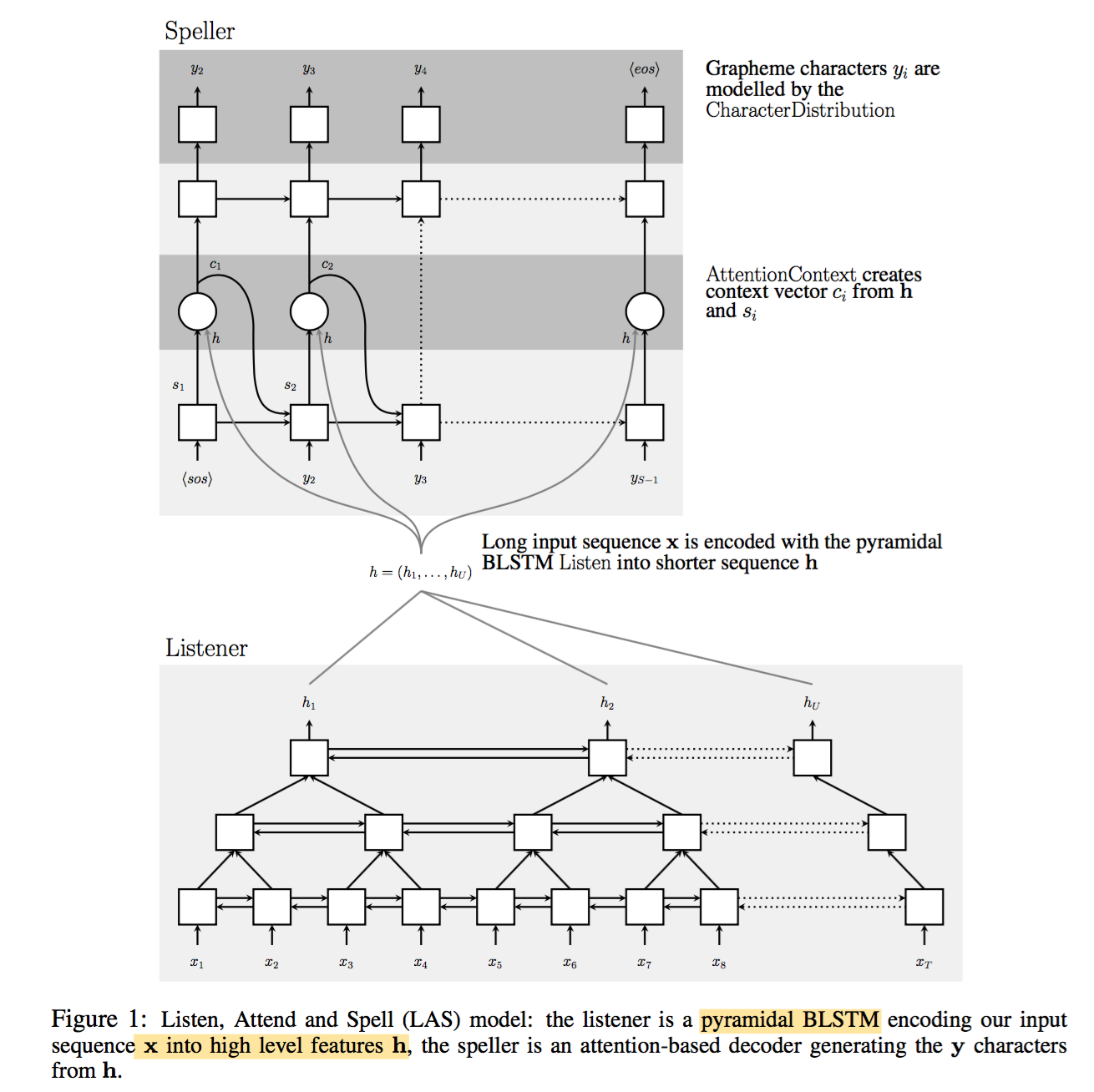

其中Encoder RNN 别名为listener,Decoder RNN别名为speller

listener具体架构为一个金字塔RNN结构,用来把低维的语音信号转成高维的特征,其中金字塔RNN加速了训练收敛的速度。

speller为RNN结构,借助于Attention机制,把高维的特征转成对应的文本句子。其架构如下所示:

其输入x为40-dimensional log-mel filter bank features,输出y为英文字符和标点,空格等字符。

本文深入探讨了Attention在语音识别中的应用,通过分析William Chan等人在2015年和2016年的两篇研究,阐述了Attention如何提升模型性能。文章指出,尽管Attention机制在不同长度句子的识别上存在局限性,但其在无需解码器和语言模型的实时语音识别中展现出潜力,为后续研究提供了方向。

本文深入探讨了Attention在语音识别中的应用,通过分析William Chan等人在2015年和2016年的两篇研究,阐述了Attention如何提升模型性能。文章指出,尽管Attention机制在不同长度句子的识别上存在局限性,但其在无需解码器和语言模型的实时语音识别中展现出潜力,为后续研究提供了方向。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?