本文简单记录下几篇基于SMPLX模板的完整三维人体动作捕捉算法(即同时包含人脸、人手和身体部位),不涉及具体细节。其中,前三篇为Top-Down, Multi-Stage,中间两篇为Top-Down, One-Stage,最后一篇为All-in-One-Stage Method。如有错误,欢迎评论指正。

一.方法

1.ExPose

训练数据集

-

LSP、MPII:伪GT数据,由SMPlify-X拟合得到;

-

Human3.6M:身体

-

FreiHAND:人手

-

FFHQ:人脸,伪GT数据,由RingNet预测,再进一步拟合得到

算法简述

![图1.ExPose[1]](https://img-blog.csdnimg.cn/img_convert/cdbd50b7e5d886e6188ea41bb8398f8b.png)

图1.ExPose[1]

由粗到精,先由人体图像预测初始的人体,人手,人体参数,据此裁剪出人手人脸图像,然后送到人手人脸网络预测偏移参数进行优化。注意人体、人脸、人手网络先单独训练,最后再一起微调。

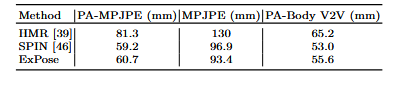

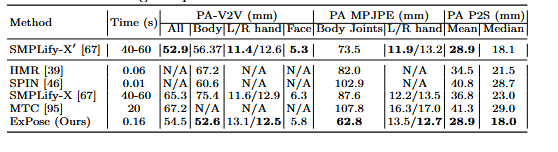

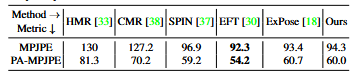

结果

-

3DPW

-

EHF

2.FrankMocap

训练数据集

-

FreiHAND

-

Human3.6M

-

EFT: 伪GT, SMPL模型

-

私有数据:用于下述用于处理手腕姿态的集成网络的训练,由下述的优化框架拟合得到

算法

![图2.FrankMocap[2]](https://img-blog.csdnimg.cn/img_convert/941cebf5db2d16a633b77ec5bdd97438.png)

图2.FrankMocap[2]

人体、人脸、人手模块单独估计参数,然后集成到一起联合估计。注意,人头模型采用FLAME(直接用的开源项目RingNet),与SMPLX参数完全兼容,而人体和人手模型虽然由SMPLX采样而来,但两个模型的手腕姿态不在同一空间所以需要进行进一步处理。本算法核心提出了三种策略:简单的复制粘贴(CP)、优化框架(OPT)、集成网络(WI),来处理手腕姿态。

结果

-

3DPW

-

EHF

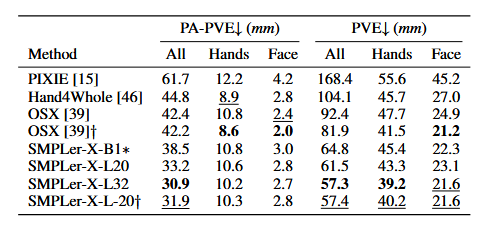

3.Hand4Whole

训练数据集

-

Human3.6M

-

MSCOCO

-

MPII

-

FreiHAND

-

3DPW

-

FreiHAND

算法

![图3.Hand4Whole[3]](https://img-blog.csdnimg.cn/img_convert/c923be7d01f9e97e3abe0fa8c4f6acf7.png)

图3.Hand4Whole[3]

人脸模块直接裁剪人脸图像送入网络直接进行回归,而人手和人体模块会预测3D关节点并提取每个关节点的细粒度特征,而不是像ExPose和FrankMocap的整幅输入图像的特征。特别地,对于人手模块只利用几个手指3D关节点(Finger)+关节点对应的特征回归手指的姿态参数(因为手指动作与躯干联系不大),对于人体模块会同时利用掌指关节(MCP)和人体两种3D关节点+关节点对应的特征回归人体姿态参数(因为掌指关节对于预测手腕姿态有益)。这种方法人体和人手连接更为自然,在由遮挡和拍摄图像不完整时可以生成更加合理的手部动作。

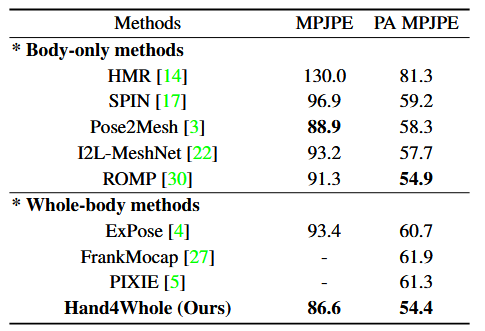

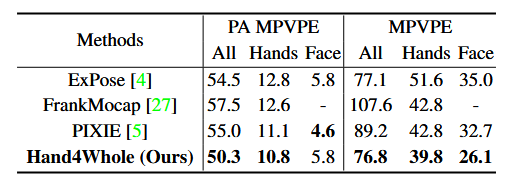

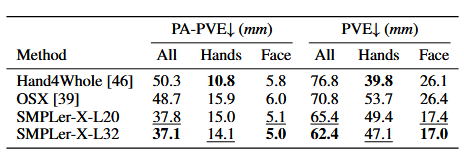

结果

-

3DPW

-

EHF

-

AGORA

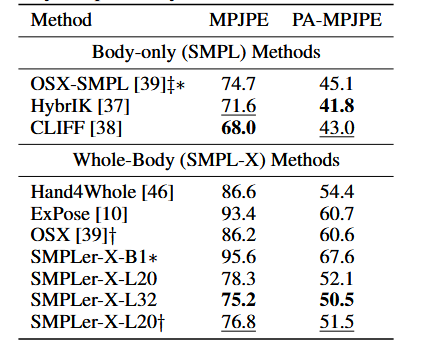

4.HybrIK-X

训练数据集

-

3DPW

-

MPI-INF-3DHP:人体3D关键点数据

-

Human3.6M

-

MSCOCO:2D人体姿态数据

-

AGORA:合成数据集

-

FreiHAND

-

HO3D-v2:人手与物体交互的3D姿态数据

算法

![图4.HybrIK-X[4]](https://img-blog.csdnimg.cn/img_convert/70138ef77aa246718dd94122e4873c64.png)

该算法是对仅人体动作捕捉的HybrIK算法的进一步扩展。HybrIK算法的基本思想是先预测3D关节点坐标,然后将IK集成进来恢复得到SMPL的姿态参数,进一步可以FK或者SMPL的关节点回归矩阵得到3D关节点坐标。此时的3D关节点坐标由于掺杂了SMPL的语义信息,所以相比中间直接预测的3D关节点要更准确。而HybrIK-X则是将人脸、人手、人体分开都输入到一个HybrIK框架里,最后再将结果融合到一起,当然算法在融合过程中也会解决FrankMocap算法提到的类似问题。

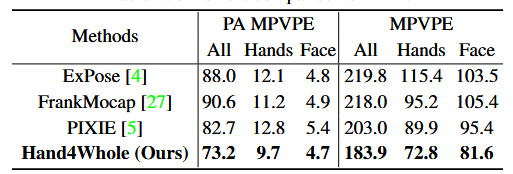

结果

-

3DPW、Human3.6M、MPI-INF-3DHP

-

AGORA

5.OSX

训练数据集

-

COCO-Wholebody

-

MPII [3]

-

Human3.6M

算法

![图5.OSX[5]](https://img-blog.csdnimg.cn/img_convert/adbc8f3db1ed826581bab1211e28932b.png)

整个结构就是原始Transformer的结构。编码部分引入一个可学习的Body Tokens,用于回归人体参数。解码部分包含两个输入,一个是对编码部分的特征进行上采样并利用人脸人手框得到对应的特征(KV),另一个是2D关节点的Tokens(Q,注意这里应该没有Mask Head Attention结构了),用于回归人手和人脸参数。该算法最大好处是one-stage,因为直接在特征层面"裁剪"了人脸人手。

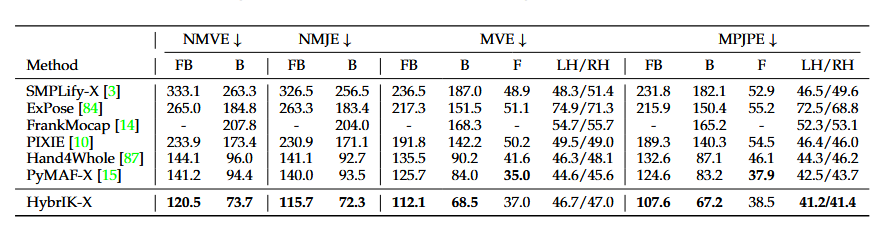

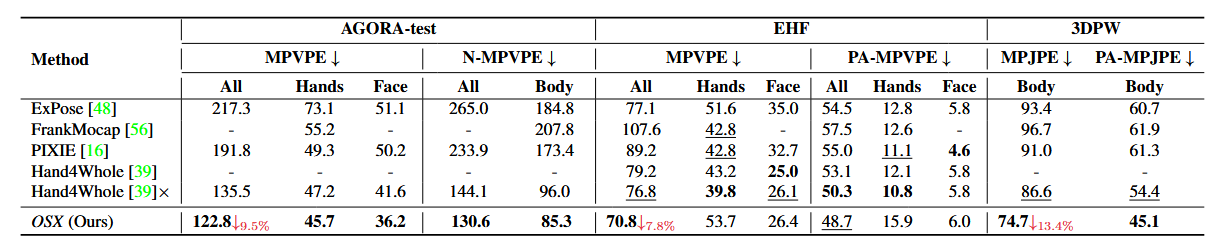

结果

-

AGORA、3DPW、EHF

-

UBody

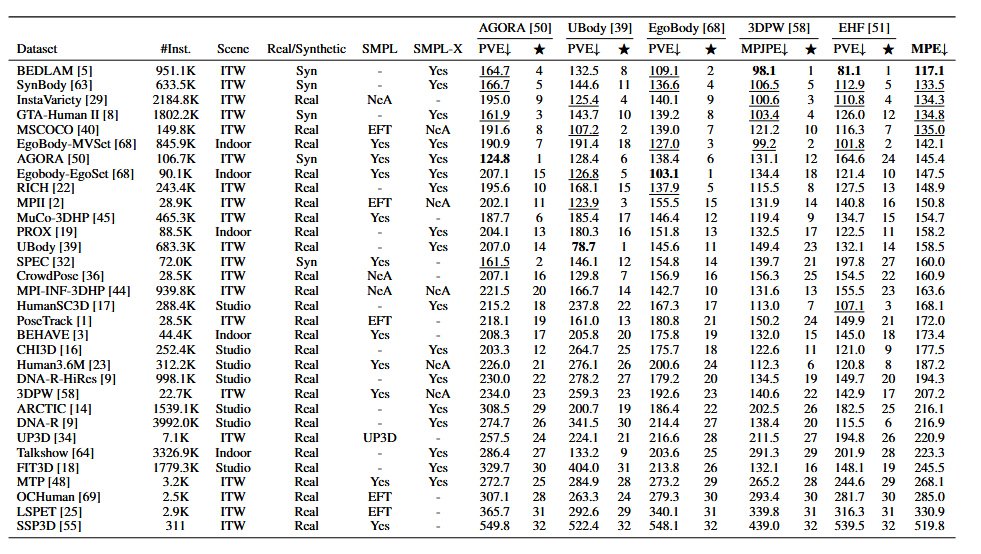

6.SMPLer-X

训练数据集

注:仅列举,原文描述不是很详细。

算法

![图6.SMPLer-X[6]](https://img-blog.csdnimg.cn/img_convert/de2e8b2a3c6547d4d757a9d2e67ea11c.png)

图6.SMPLer-X[6]

核心在于利用了所有可用的人体数据集进行大规模训练,相比之下网络结构比较简单,主要是引入了可学习的task tokens用来回归人脸人手框,并进一步利用ROI模块直接在特征图上采样得到人脸人手特征进而回归相应的人脸人手参数,人体参数则是同时利用img tokens和task tokens回归。

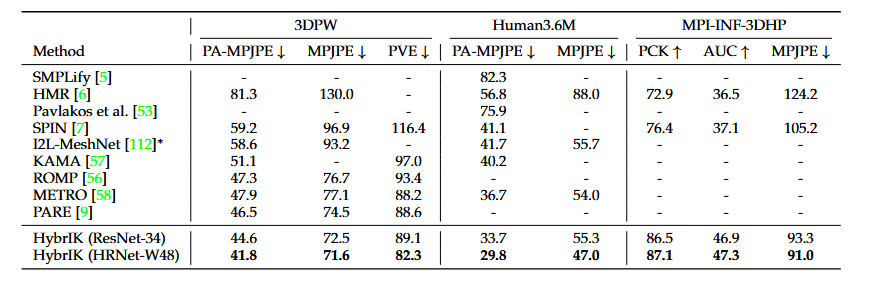

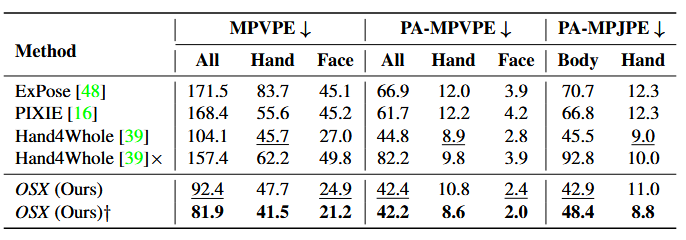

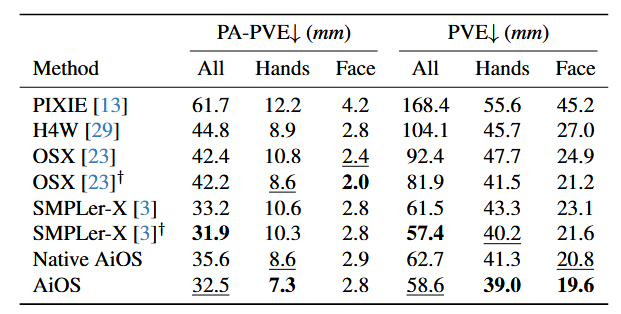

结果

-

AGORA

-

EHF

-

3DPW

-

UBody

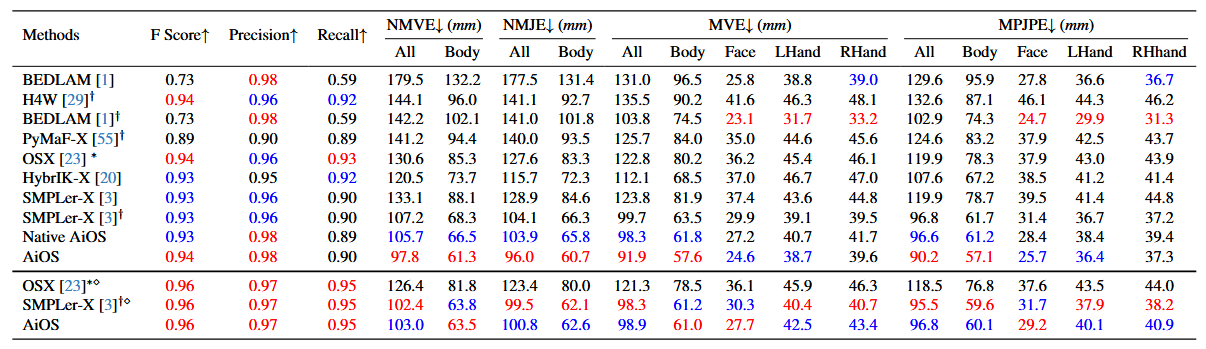

7.AiOS

训练数据集

-

AGORA

-

BEDLAM

-

COCO

-

UBody

-

ARCTIC

-

EgoBody

算法

![图7.AiOS[7]](https://img-blog.csdnimg.cn/img_convert/5ba066684a8a4795476ec853ea8876ef.png)

图7.AiOS[7]

无需人体框,直接同时完成多人的人体检测和3D动作捕捉。设计了一个渐进式的框架,首先定位粗糙的人体位置并提取人体的整体特征,然后优化人体位置,提取人体局部特征,定位粗糙的人手和人脸位置,提取人脸和人手的整体特征,最后 优化人手和人脸位置,提取全身局部特征,进而回归SMPLX参数。

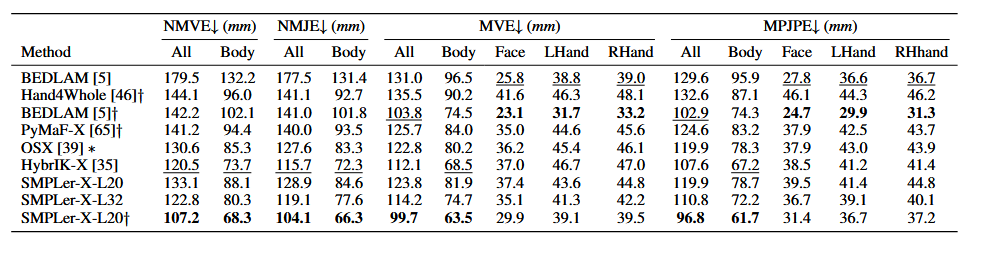

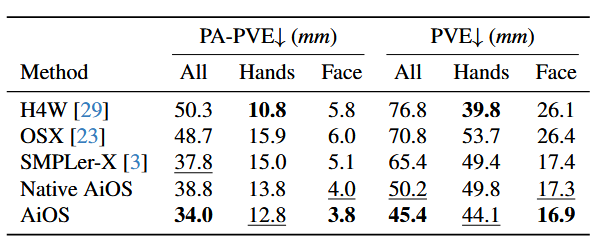

结果

-

AGORA

-

UBody

-

EHF

二.参考

-

[1] Monocular Expressive Body Regression through Body-Driven Attention

-

[2] FrankMocap: A Monocular 3D Whole-Body Pose Estimation System via Regression and Integration

-

[3] HybrIK-X: Hybrid Analytical-Neural Inverse Kinematics for Whole-body Mesh Recovery

-

[4] Accurate 3D Hand Pose Estimation for Whole-Body 3D Human Mesh Estimation

-

[5] One-Stage 3D Whole-Body Mesh Recovery with Component Aware Transformer

-

[6] SMPLer-X: Scaling Up Expressive Human Pose and Shape Estimation

-

[7] AiOS: All-in-One-Stage Expressive Human Pose and Shape Estimation

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?