云服务器搭建伪分布式hadoop实现远程连接

环境配置概述

本文章基于腾讯云服务器环境进行安装部署hadoop3.1.3伪分布式环境,

前提是默认服务器已经配置好了JDK和SSH免密

安装配置

1.下载压缩包

可以去官网下载,也可领取我的百度云链接文件

链接:https://pan.baidu.com/s/1424B3OYg35A47b-R3CIZ0Q

提取码:1234

2.解压

进入压缩包路径进行解压:

tar -zxvf hadoop-3.1.3.tar.gz

文件重命名:

mv hadoop-3.1.3 hadoop

3.主机映射

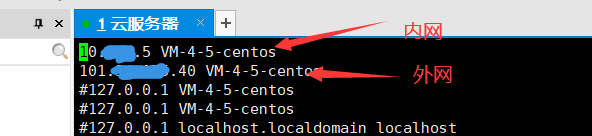

1.服务器上修改/etc/hosts内容:

vi /etc/hosts

这里很关键,要配置远程访问云服务需要对服务器内外网ip都要映射

格式就是ip 加上空格,加上主机名,你可以自定义主机名,也可以像我一样使用默认的主机名,查看主机的主机名使用命令 hostname,并且我把其他一样的127.0.0.1后面有相同主机名都注释掉了

#### 2.本地添加映射

#### 2.本地添加映射

我使用的是Windows10系统,本地远程连接云服务器前,在本地添加上云服务外网的IP映射

windows系统找到hosts文件,一般在这个路径:

C:\Windows\System32\drivers\etc

将hosts文件用记事本打开,添加上你的云服务器外网ip和名称即可,记得保存再退出

4.修改配置文件

1.环境配置

打开配置文件:

vi ~/.bashrc

如果你之前配置了PATH,在这里就把hadoop下sbin的路径添加进去即可,注意不同的软件配置用冒号分隔开

使文件生效:

source ~/.bashrc

2.core-site.xml修改

core-site.xml位于hadoop路径下./etc/hadoop 中

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/root/usr/local/usr/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://ip:9000</value>

</property>

</configuration>

注意这里的ip填的是服务器内网的ip,记得修改为你的服务器ip,别直接复制就没了

3.hdfs-site.xml修改

- 注意这里的名称节点和数据节点的位置要改成你自己的文件位置

,其他的复制就好不用改

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/root/usr/local/usr/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/root/usr/local/usr/hadoop/tmp/dfs/data</value>

</property>

<property>

<name>dfs.http.address</name>

<value>0.0.0.0:50070</value>

</property>

<property>

<name>dfs.secondary.http.address</name>

<value>0.0.0.0:50090</value>

</property>

<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</property>

<property>

<name>dfs.client.use.datanode.hostname</name>

<value>true</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value> </property>

</configuration>

4.workers 修改

workers文件里面就填服务器外网的ip即可,把原来存在的localhost删掉

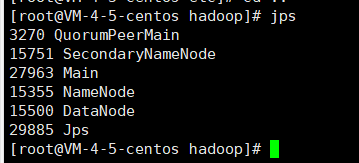

5.启动

进入hadoop路径后

启动命令:./sbin/start-dfs.sh

停止命令:./sbin/stop-dfs.sh

查看进程,出现NameNode,DataNode,SecondaryNameNode表示启动成功

6.远程访问服务器端口

直接在本机浏览器输入服务器外网ip:50070,出现下面的显示就OK了,

访问此端口的时候记得把防火墙的这个端口打开~~~

979

979

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?