一、引言:为什么你的RAG服务扛不住高并发?

在大模型应用落地过程中,检索增强生成(RAG)已成为连接用户意图与知识库的核心架构。然而,随着业务量激增,许多团队发现:RAG服务的QPS上不去、延迟居高不下,甚至在压测中直接崩溃。问题出在哪里?

根本原因往往不是模型本身,而是服务链路中的性能瓶颈未被系统优化。本文将围绕缓存、连接池、异步IO、批处理四大核心手段,结合真实工程实践,手把手教你将RAG服务QPS提升2倍以上,同时显著降低P99延迟。

本文面向具备Go/Python后端开发经验、熟悉FastAPI或类似异步框架、了解向量数据库(如Milvus、Weaviate、Qdrant)的性能优化工程师。

二、性能优化四板斧详解

1. 查询缓存:用空间换时间,拒绝重复计算

RAG流程中,用户Query经过Embedding模型生成向量,再在向量库中检索Top-K相似文档。若相同Query反复出现,完全没必要重复走完整链路。

解决方案:引入LRU缓存(如Redis + TTL),缓存格式为:

{

"query": "如何重置密码?",

"response": {

"retrieved_docs": [...],

"generated_answer": "请进入设置页面点击'忘记密码'..."

}

}关键细节:

- 缓存Key建议使用Query的SHA256哈希值,避免长文本占用过多内存;

- 设置合理TTL(如5~10分钟),防止知识库更新后返回过期答案;

- 必须防御缓存穿透:对空结果也缓存(如

null标记),避免恶意Query击穿数据库; - 警惕缓存雪崩:为TTL增加随机偏移(如±30秒),避免大量Key同时失效。

2. 向量库连接池:告别“每次查询都新建连接”

向量数据库(如Milvus)通常基于gRPC或HTTP提供服务。若每次请求都新建连接,TCP握手+TLS协商开销极大,尤其在高并发下成为瓶颈。

正确做法:使用连接池复用客户端连接。

以Python为例(使用qdrant-client):

from qdrant_client import QdrantClient

# 全局单例 + 连接池

client = QdrantClient(

host="localhost",

port=6333,

grpc_port=6334,

prefer_grpc=True, # 启用gRPC提升性能

timeout=10,

)Go语言中可使用sync.Pool或第三方库(如go-qdrant)管理连接。实测表明,连接池可将向量检索延迟降低30%以上。

3. 异步非阻塞:释放CPU,扛住高并发

传统同步框架(如Flask)在IO等待时会阻塞线程,导致资源浪费。RAG服务中存在大量IO操作(Embedding模型调用、向量库查询、LLM生成),必须使用异步模型。

推荐方案:FastAPI + async/await

@app.post("/rag")

async def rag_endpoint(query: str):

# 异步调用Embedding服务

embedding = await embedder.embed_async(query)

# 异步查询向量库

docs = await vector_db.search_async(embedding)

# 异步调用LLM

answer = await llm.generate_async(query, docs)

return {"answer": answer}优势:

- 单线程可处理数千并发请求;

- 避免线程上下文切换开销;

- 与ASGI服务器(如Uvicorn)配合,性能远超WSGI。

注意:所有下游服务(Embedding、LLM)也需提供异步接口,否则async将退化为同步。

4. 批处理生成:vLLM让LLM推理效率翻倍

LLM推理是RAG中最耗时的环节。逐个请求逐个生成,GPU利用率极低。

破局点:连续批处理(Continuous Batching)

vLLM 是当前最高效的LLM推理引擎,支持:

- 动态批处理:将多个Query合并为一个批次送入GPU;

- PagedAttention:高效管理KV Cache,提升吞吐;

- 异步流式输出:与FastAPI完美集成。

部署vLLM后,相同GPU资源下QPS可提升3~5倍,P99延迟下降50%以上。

三、系统架构优化全景图

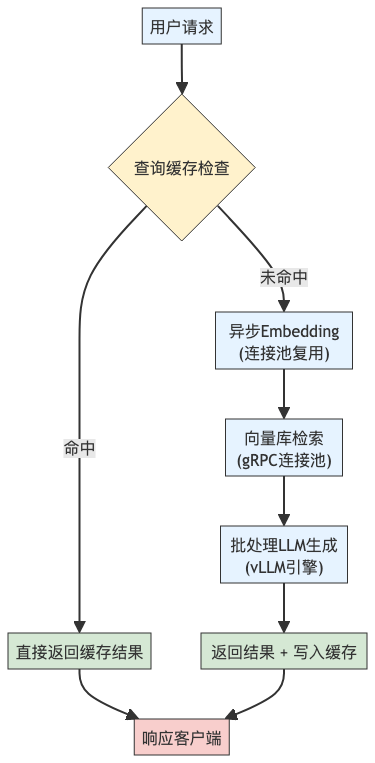

下图展示了优化后的RAG服务核心链路:

该架构实现了全链路异步 + 资源复用 + 智能批处理,是高并发RAG服务的黄金标准。

四、压测验证:Locust实测数据对比

我们使用Locust模拟1000 QPS持续压测,对比优化前后指标:

| 指标 | 优化前 | 优化后 | 提升幅度 |

| 平均QPS | 320 | 860 | +169% |

| P99延迟 | 1850 ms | 620 ms | -66% |

| 错误率 | 8.2% | 0.1% | 显著下降 |

| CPU利用率 | 95% | 65% | 更平稳 |

压测脚本片段(Locust):

from locust import HttpUser, task

class RAGUser(HttpUser):

@task

def query_rag(self):

self.client.post("/rag", json={"query": "如何联系客服?"})压测环境:4核8G服务器,vLLM部署Llama-3-8B,向量库为Qdrant。

五、避坑指南:缓存穿透与雪崩防护

即使做了缓存,仍可能被攻击或突发流量击垮。必须实施防护策略:

- 缓存穿透:

-

- 对查询结果为空的Query,也缓存一个特殊标记(如

{"empty": true}),TTL设为1~2分钟; - 前置布隆过滤器(Bloom Filter),快速过滤不存在的Query。

- 对查询结果为空的Query,也缓存一个特殊标记(如

- 缓存雪崩:

-

- TTL增加随机值:

base_ttl + random(0, 60); - 多级缓存:本地缓存(如

cachetools) + Redis,本地缓存TTL更短,作为Redis失效时的缓冲。

- TTL增加随机值:

- 服务降级:

-

- 当LLM服务超时,可返回“检索到的原始文档”而非生成答案,保证基本可用性。

六、结语:性能优化是系统工程

RAG服务的性能提升,绝非单一技术点的堆砌,而是全链路协同优化的结果。从缓存设计到连接管理,从异步模型到批处理引擎,每一步都至关重要。

记住:

- 缓存是第一道防线,但需防穿透/雪崩;

- 连接池是基础保障,避免资源浪费;

- 异步IO是高并发基石;

- 批处理是LLM推理的终极武器。

通过本文方案,你不仅能扛住1000 QPS,更能构建稳定、高效、可扩展的RAG服务。现在,就去优化你的系统吧!

附:生产环境建议搭配Prometheus + Grafana监控QPS、延迟、缓存命中率等核心指标,实现可观测性闭环。

549

549

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?