1、论文的提出(目的)

现有的依赖全卷积网络进行显著性检测的方法存在边缘检测模糊的问题,所以提出EGNet网络,试图解决该问题。

早期的视觉认知项目的方法主要得益于全局或者局部对比度以及学习权重,但这种利用人工标识特征的方法即使偶尔能够定位准确,但是使用不可靠的分割方法使得前向和后向对比不可靠时,所产生的显著性特征图也不规律。

最近卷积网络也很盛行,特别是全卷积网络的提出后,该网络效率很高,全卷积网络解决了显著性中的像素标志问题,它着重于每个像素的显著性值,但是忽略了结构信息。随着网络感受野的增加,显著性物体的位置检测越来越准确,但是忽略了空间相干性(各像素点之间的相关性)。随着网络感受野的扩大,目标定位越来越准确,空间相干性依然没有提高。也有一种基于U-net利用双向或递归的方法来得到好的边缘特征,但依然没有明确的建模。也有一些方法利用预处理和后处理来解决这一问题,但推理速度太慢了。

2、解决问题的方法

解决时分为三步:

第一步是,通过一种渐进融合的方法来提取显著性目标特征。

第二步是,通过整合局部边缘信息和全局信息来得到显著性边缘特征。

第三步是,充分利用互补性特征,使用各种方法来结合同一个目标的边缘特征信息和物体特征信息。

3、创新点

该论文的创新点利用显著性边缘信息和显著性目标信息的互补性实现更好的边缘特征提取。

该论文的网络结构:

本网络结构使用VGG为基础,先截断了最后三个全连接层,然后将另外的路径与采样层连接,就在骨干网络得到了6个特征卷积Conv1-2,Conv2-2, Conv3-3, Conv4-3, Conv5-3, Conv6-3.。由于Conv1-2离输入太近并且感受野太小了,所以舍弃,剩余的5条通道表示为C = {C(2);C(3);C(4);C(5);C(6)};Conv2-2保留了更好的边缘信息,所以利用S(2)来提取边缘信息,其它通道提取目标显著性信息。

渐进显著性目标提取:

图中的PSFEM是为了得到更丰富的上下文语义特征,利用U-Net产生多分辨率特征,也在每个通道上加了3层卷积层增强显著性特征,末尾都加了RELU激活函数确保非线性。并且在每个通道上都有深度监督,采用了一个卷积层来将特征图转换为单通道预测值D。

非局部显著边缘特征提取:

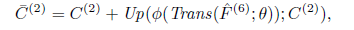

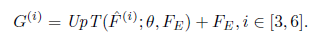

Conv2-2可以提取局部边缘信息,但仅此是不够的,我们也需要高层语义信息或者局部信息。当信息从高层次向低层次网络返回时,高层网络的局部信息逐渐稀释了,高层的感受野是最大的,定位也是最准确的,因此要设计一个从上到下的传播高层信息到S(2)的通道来限制非显著性边缘,公式为

Trans(; )是一个卷积层,它可以改变通道特征,

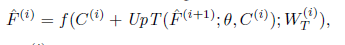

()表示的是RELU激活函数。Up(;C(2))是一个双线性插值运算,对同一大小的卷积层C(2)进行上采样。等式右边第二项表示来自更高路径的特征,F(6)表示S(6)中加强的特征,加强后的特征可以被归纳为

f(;W(i)T )表示一系列有关T的卷积和非线性方程。

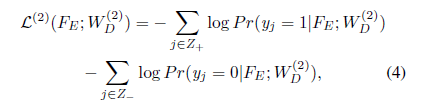

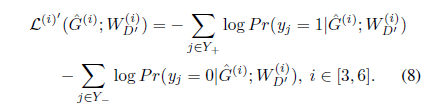

得到引导性特征C(2)后,与同侧通道相同,S(2)中最后的显著性边缘特征表示为f( C(2);W(2)T ).同时我们使用了一个交叉熵损失函数,

Z+ 和Z-表示边缘像素组和背景像素组,WD表示预测图。经过一系列变换后总损失表示为

(3)一对一的引导模型

(3)一对一的引导模型

使用FE 和 ^ F(3)从下到上得到边缘特征信息也是稀释的,所以提出了一对一引导模型。

在S(3), S(4), S(5),S(6)上加了副边路径,能够使高层次的预测更加准确

同时,在每一个卷积层上都加了副边通道加强S特征。在S特征上我们还加了深度传播,每一个副边输出预测图的损失值可以用该公式表示

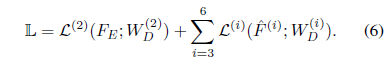

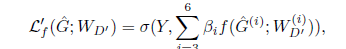

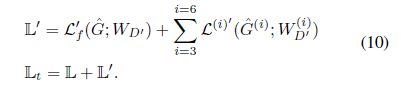

然后得到多层次的预测图,损失函数是

(; )代表预测值和真实值之间的交叉熵损失

最后,整个网络的损失值就可以表示为

4、方法的效果与局限

利用目标特征中丰富的边缘信息和位置信息,这些融合的特征能够有利于定位目标,使其边界更加准确。实验结果也证明了在没有预处理和后处理的条件下,该方法的效果比目前最好地模型更好。

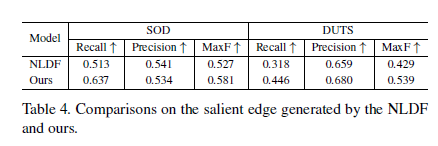

实验分析:

为了公平的比较,使用VGG和ResNet作为骨干网络,加入卷积网络的权重是正常截断下随机初始化的,起始值为0.超参数设置如下:学习速度=5e-5,重量衰减=0.0005,动量=0.9,每一输出通道的损失权重=1。每一个反向传播用于加工10张图片,训练过程中没有使用测试数据集。模型总的训练时间是24个epochs,在第15个epochs之后学习速率达到10.在推导过程中得到的显著性预测边缘图和显著图统称为融合预测图,也就是最终的显著性图。

常用训练集:ECSSD [56],PASCAL-S [30], DUT-OMRON [57], SOD [36, 44], HKUIS[27], DUTS [46]. ECSSD [56]

测试集:PASCAL VOC

评价指标:

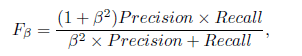

F-measure:

precision-recall(召回率)

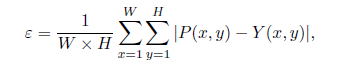

mean absolute error (MAE):

W和H分别是高度和宽度

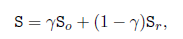

S-measure :

消融实验分析:证明了假设网络不同组成成分针对相关数据集的效果。

互补信息建模:以U-Net为基线,结合PRFEM,将S(2)一侧的通道移开,然后融合最后的显著性特征F(3)(Conv3-3一侧),Conv2-2获得局部边缘信息,最后结合边缘信息和显著性目标特征F(3)来获得预测图,称之为edge_PROG,

自顶向下的位置传播:利用自顶向下的位置传播从高岑信息开始而不是S(3)的侧输出提取更加准确的位置信息。

边缘线索的使用机制:

在网络结尾加入了IOU损失函数来消除边缘错误,baseline中同样也加入了IOU,与baseline模型相比,该网络效果的提升有一定的限制,

加入边缘处罚机制后可以加强边缘信息,也可以大大加强去除冗余部分,或弥补缺失部分。与之相反的是,假设的模型在边缘信息与目标显著性特征上分类和定位都更好。

互补特征融合:

融合边缘信息特征和目标信息特征中分别比较了三种方法。第一,融合边缘特征FE和U-Net中最高层的目标特征F(3),但是失败了;第二,逐步融合多分辨率特征F(3), ^ F(4),

^ F(5), ^ F(6);第三种,假设了一种一对一引导模型。

结果:

F-measure, MAE,和S-measure使用了不同的骨干网络,与最新的实验对比表现优越。

召回率曲线:

红色曲线表现超过了其它曲线,表现了利用边缘信息特征和目标信息特征互补性模型的优越性。

视觉上,本模型的效果也远优于其它模型

5、缺点和不足

(1).计算量大 占用的显存非常大,计算的很慢

(2).基本是使用堆积卷积的方式来获取特征的,导致计算量很大

概念:

Epoch:一个epoch指代所有的数据送入网络中完成一次前向计算及反向传播的过程。

Batch Size:所谓Batch就是每次送入网络中训练的一部分数据,而Batch Size就是每个batch中训练样本的数量上文提及,每次送入训练的不是所有数据而是一小部分数据

Iterations:所谓iterations就是完成一次epoch所需的batch个数。

夜深了,有时间再改吧,拜拜~~

3688

3688

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?