在上一篇文章中介绍了BPNN-Adaboost算法的原理及其实现,Adaboost算法可以将多个BPNN作为弱分类器进行训练,使其相互补充,集成为具有较强鲁棒性的强分类器。但由于BPNN对于初始权值和阈值的选取具有随机性,这将导致模型精度的不定性,因此若要进一步提升BPNN-Adaboost算法的可靠性,可以引入优化算法优化BPNN的初始权值和阈值,考虑到灰狼算法GWO较之传统的粒子群和遗传算法的全局搜索能力更强,且需调整的参数少,因此本文采用灰狼算法进行优化,具体实现见下文。

00 目录

01 BPNN-Adaboost算法与灰狼优化算法介绍

02 GWO-BPNN-Adaboost融合模型

03 代码目录

04 性能对比

05 源码获取

01 BPNN-Adaboost算法与灰狼优化算法介绍

BPNN-Adaboost原理及其MATLAB代码获取方式在下方文章链接中:

BPNN-Adaboost原理及代码

灰狼优化算法原理及其MATLAB代码获取方式在下方文章链接中:

灰狼算法原理及代码

02 GWO-BPNN-Adaboost融合模型

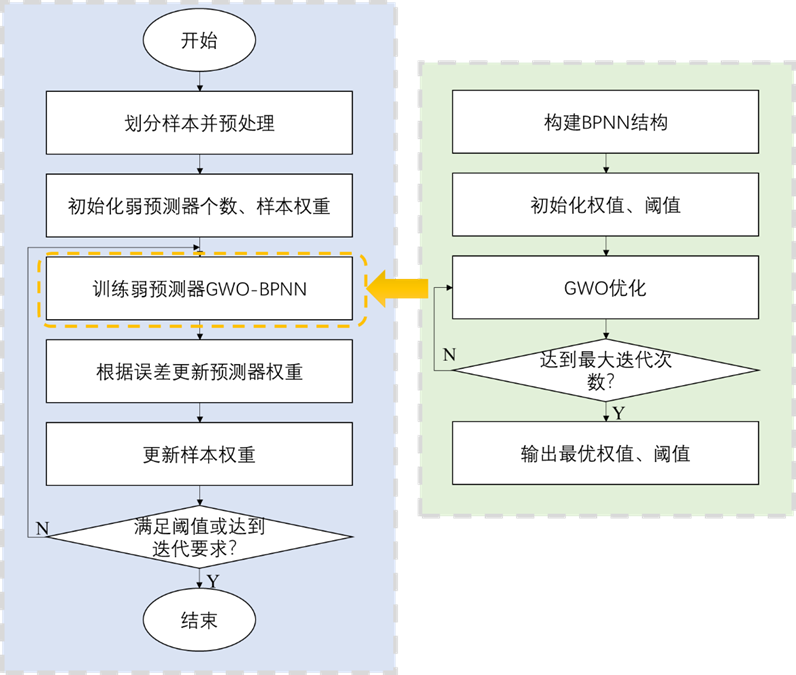

GWO-BPNN-AdaBoost融合模型是通过使用AdaBoost算法训练和集成多个弱预测器(GWO-BPNN)来构建的。该算法能够在BPNN-AdaBoost算法基础上进一步增强其拟合能力、泛化能力和鲁棒性。实现GWO-BP-AdaBoost的流程图如下:

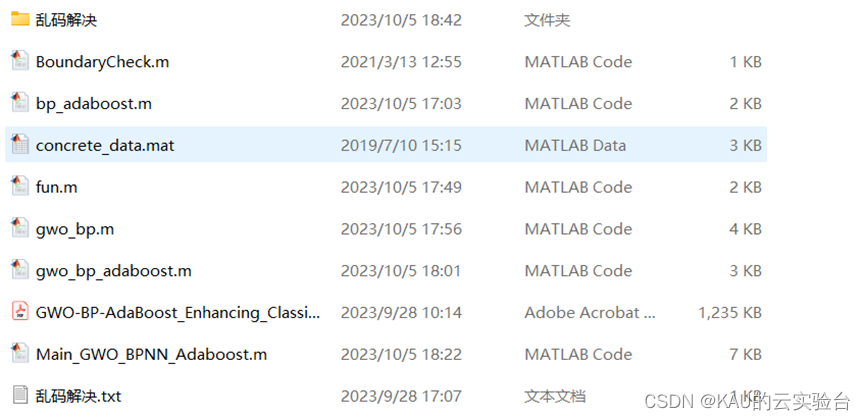

03 代码目录

包含程序、乱码解决以及一篇参考文献,其中Main_GWO_BPNN_Adaboost.m为主程序

考虑到很多同学获取代码后有乱码(matlab版本问题),可以将matlab版本改为2020或2021,或使用乱码解决文件夹中的txt文件即可。

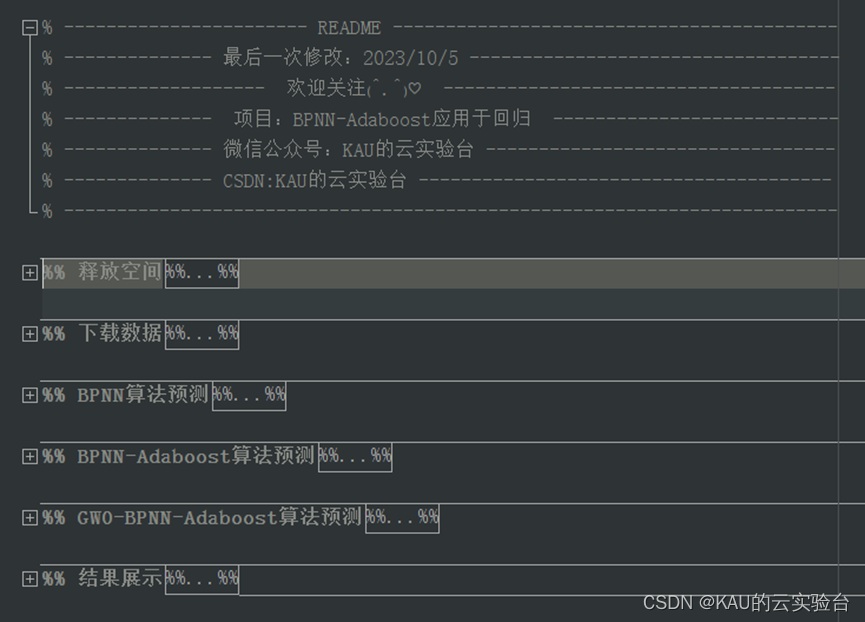

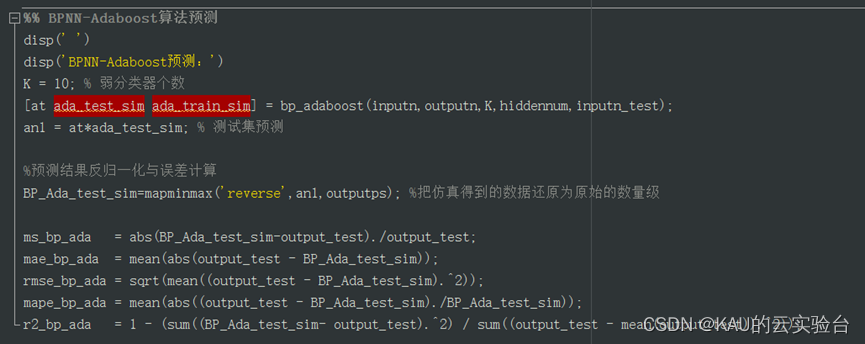

主程序代码都进行了模块化:

部分代码如下:

04性能对比

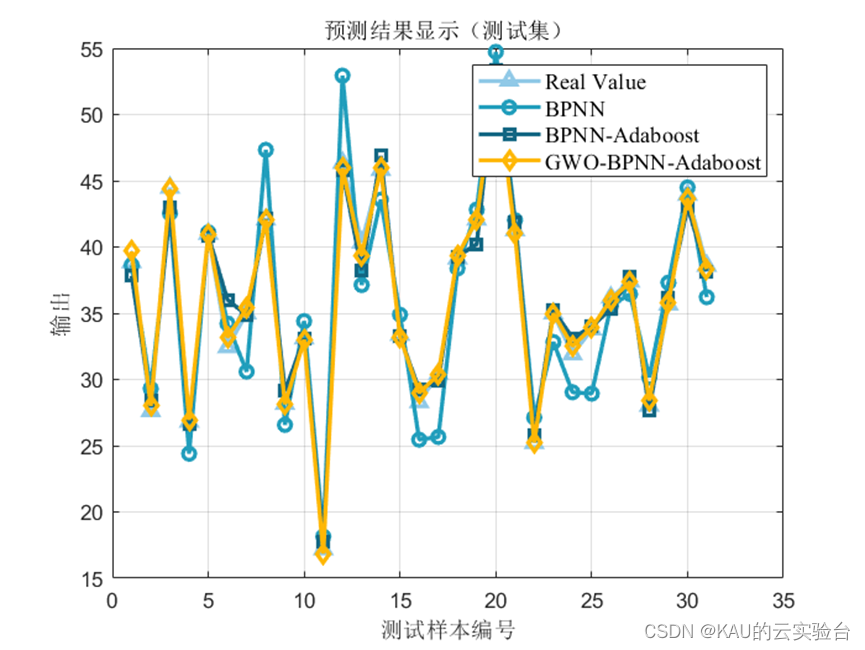

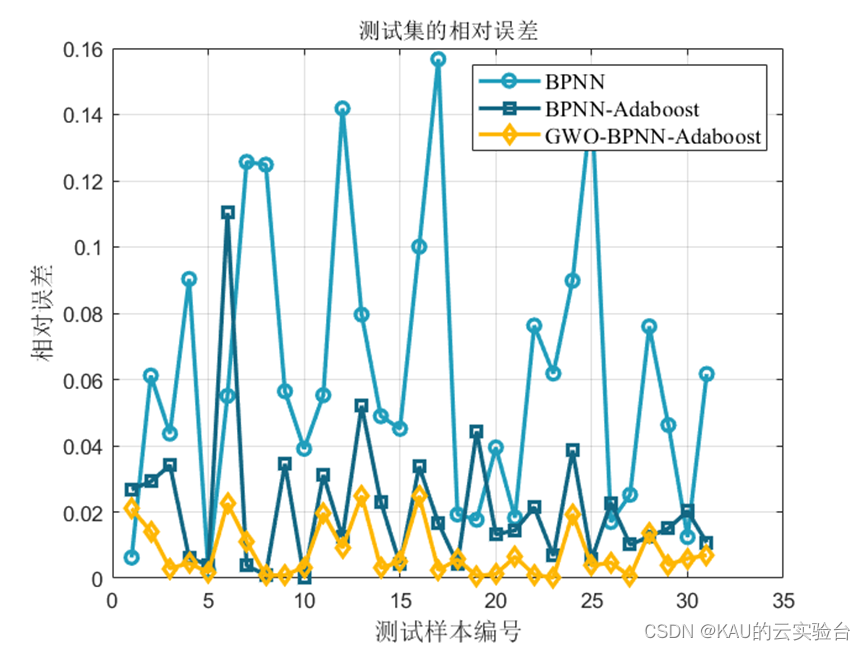

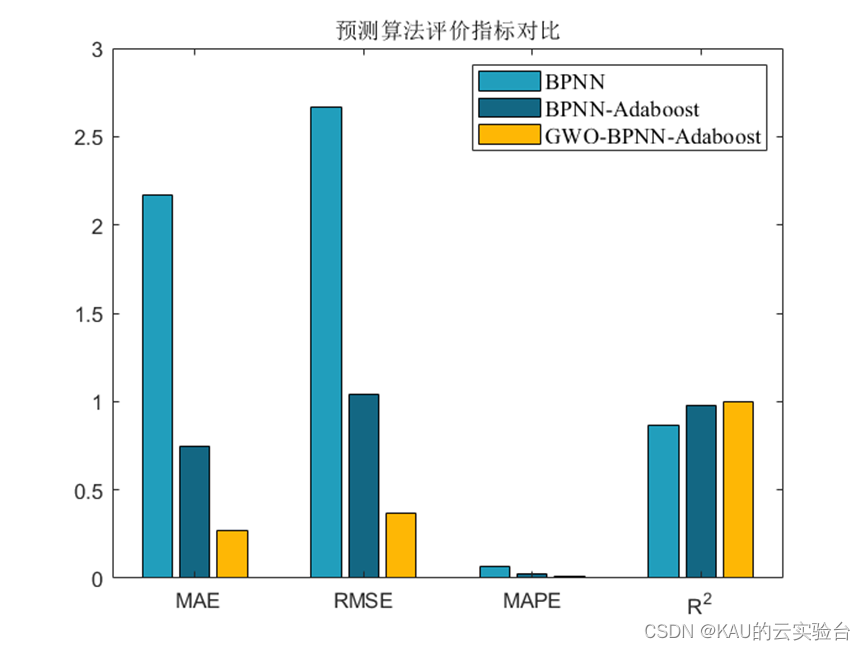

选用平均绝对误差(MAE)、平均绝对误差率(MAPE)、均方根误差(RMSE)、决定系数(R^2)来衡量预测性能优劣。

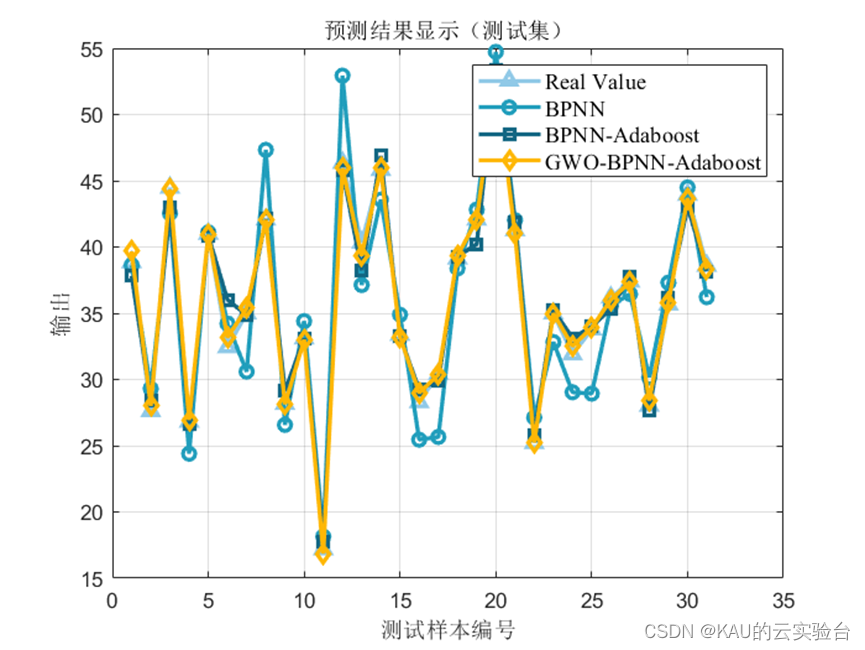

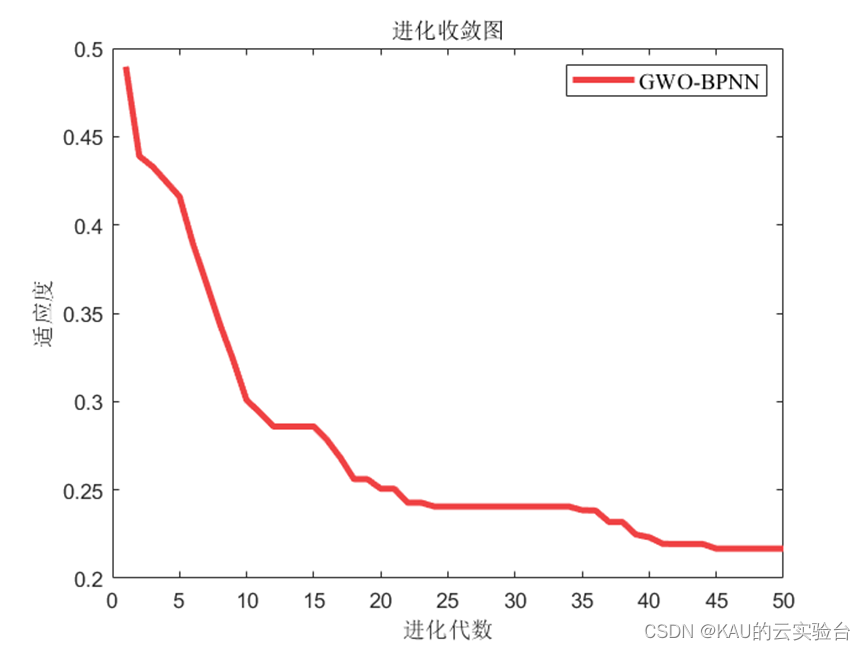

运行代码,得到预测结果如下:

从图中可以得出结论,BPNN-Adaboost算法提高了BPNN的性能,而GWO-BPNN-Adaboost算法则进一步提升了BPNN-Adaboost的预测性能,能够满足某些精度要求较高的场合,其预测结果可靠性高。

05 源码获取

可私信作者或在微信公众号:KAU的云实验台获取

本文用了GWO优化BPNN-Adaboost算法,除此之外,还可以采用其他优化算法,同时Adaboost的思想也适用于其他的预测算法,如ELM、SVM等。

另:如果有伙伴有待解决的优化问题(各种领域都可),可以发我,我会选择性的更新利用优化算法解决这些问题的文章。

如果这篇文章对你有帮助或启发,可以点击右下角的赞/在看(ง •̀_•́)ง(不点也行),若有定制需求,可私信作者。

116

116

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?