理论东西比较多,里面涉及很多CV很热点的模型或者算法。(太难了!!!)

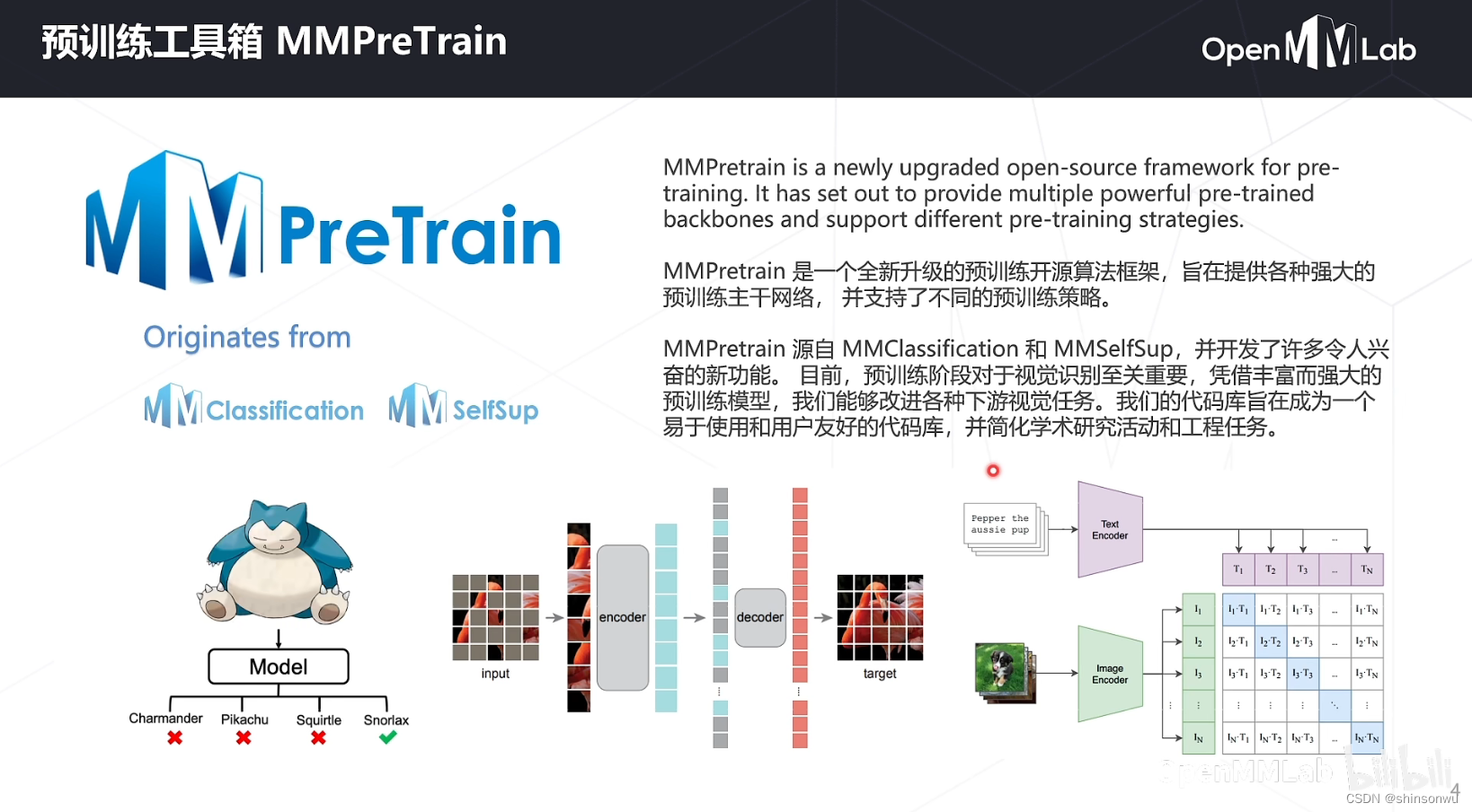

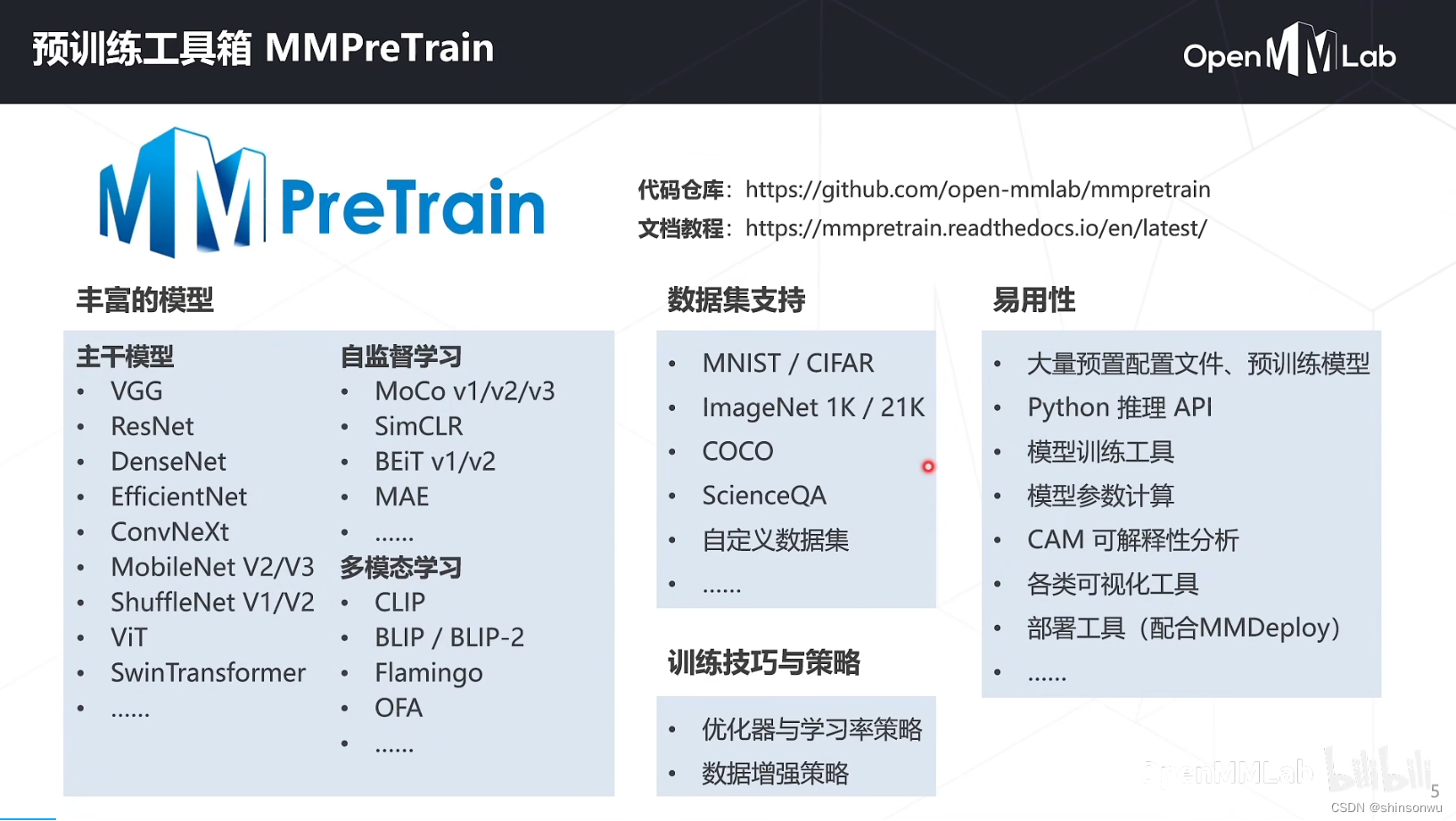

MMPreTrain是一个全面的预训练模型算法库,支持多种任务和框架。它包含了多种前沿的预训练模型算法,包括自监督学习、多模态学习等,广泛应用于各种视觉和自然语言处理任务。MMPreTrain基于PyTorch,便于研究人员快速实现、训练和测试新的预训练模型。它提供了灵活的配置系统和丰富的预训练模型组件。

MMPreTrain预训练工具箱是MMPreTrain算法库的一个重要组成部分。它是一个强大的预训练模型工具箱,支持多种预训练模型算法,包括自监督学习、多模态学习等。MMPreTrain预训练工具箱基于PyTorch,提供了一个简单易用的API和丰富的功能,可以方便地进行模型定义、训练和评估。它还包括了许多预训练模型的组件,如数据加载器、损失函数、评估指标等。使用MMPreTrain预训练工具箱,您可以快速实现预训练模型,并在各种视觉和自然语言处理任务上获得优秀的性能表现。

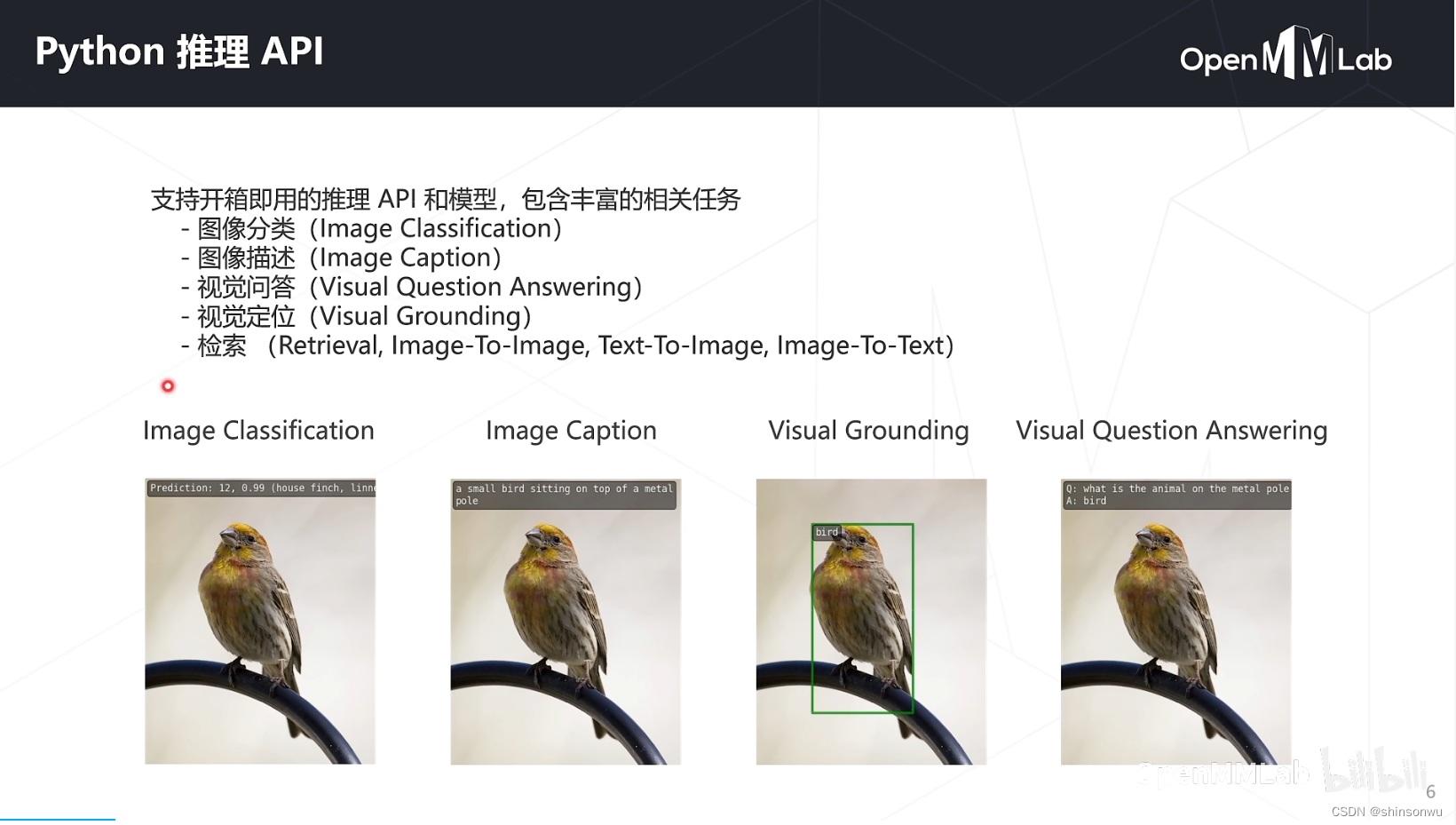

支持开箱即用的推理,很方便,包括各类CV任务

整个的环境安装,按照之前的推荐,使用conda创建对应环境,注意有多模态以来可以使用下图的指令。

深度学习模型的训练涉及几个方面:

模型结构:模型有几层、每层多少通道数等

数据:数据集划分、数据文件路径、批大小、数据增强策略等

训练优化:梯度下降算法、学习率参数、训练总轮次、学习率变化策略等GPU、分布式环境配置等

运行时:辅助功能如打印日志、定时保存 checkpoint 等

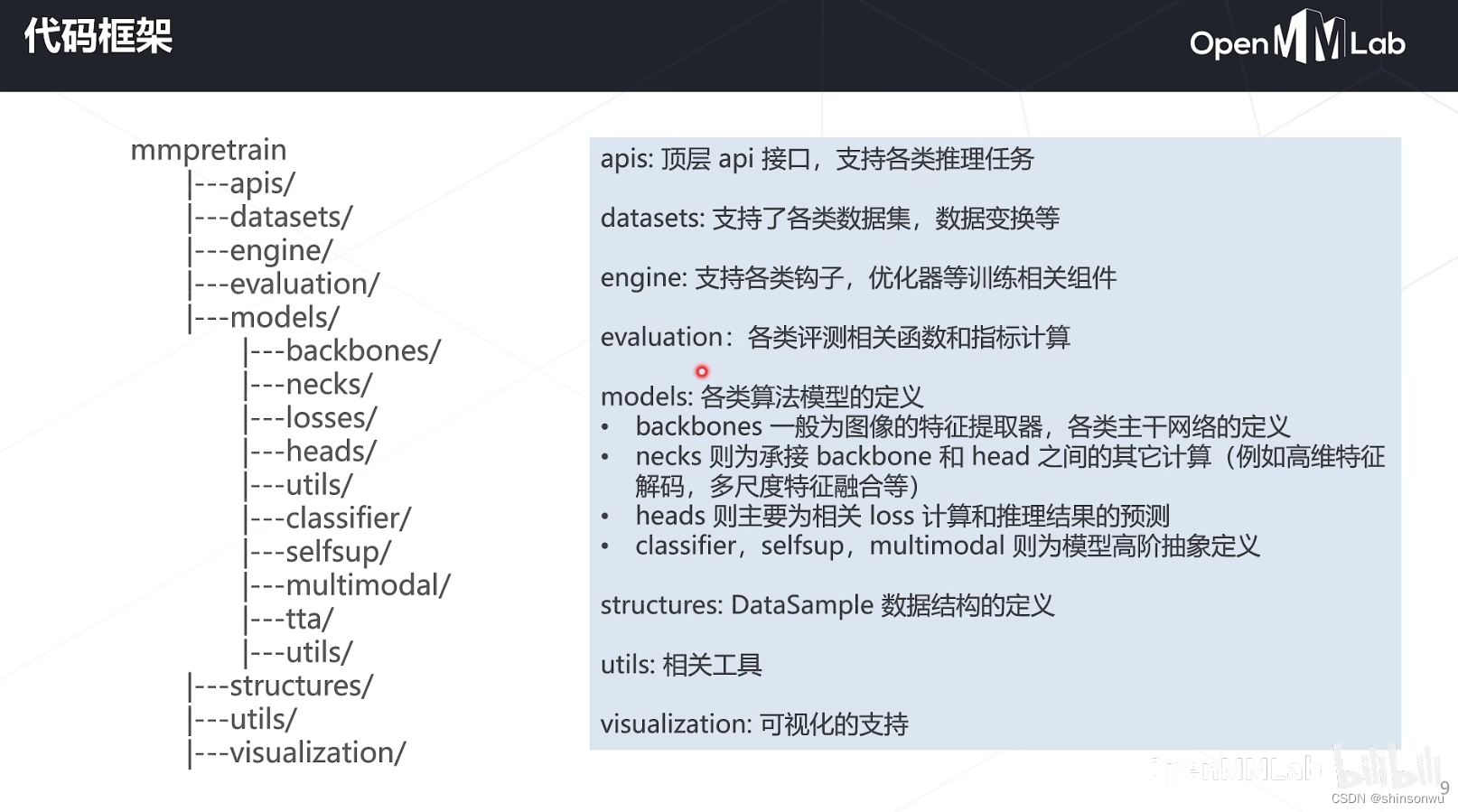

下载下来的项目结构图如下所示,还是比较清洗:

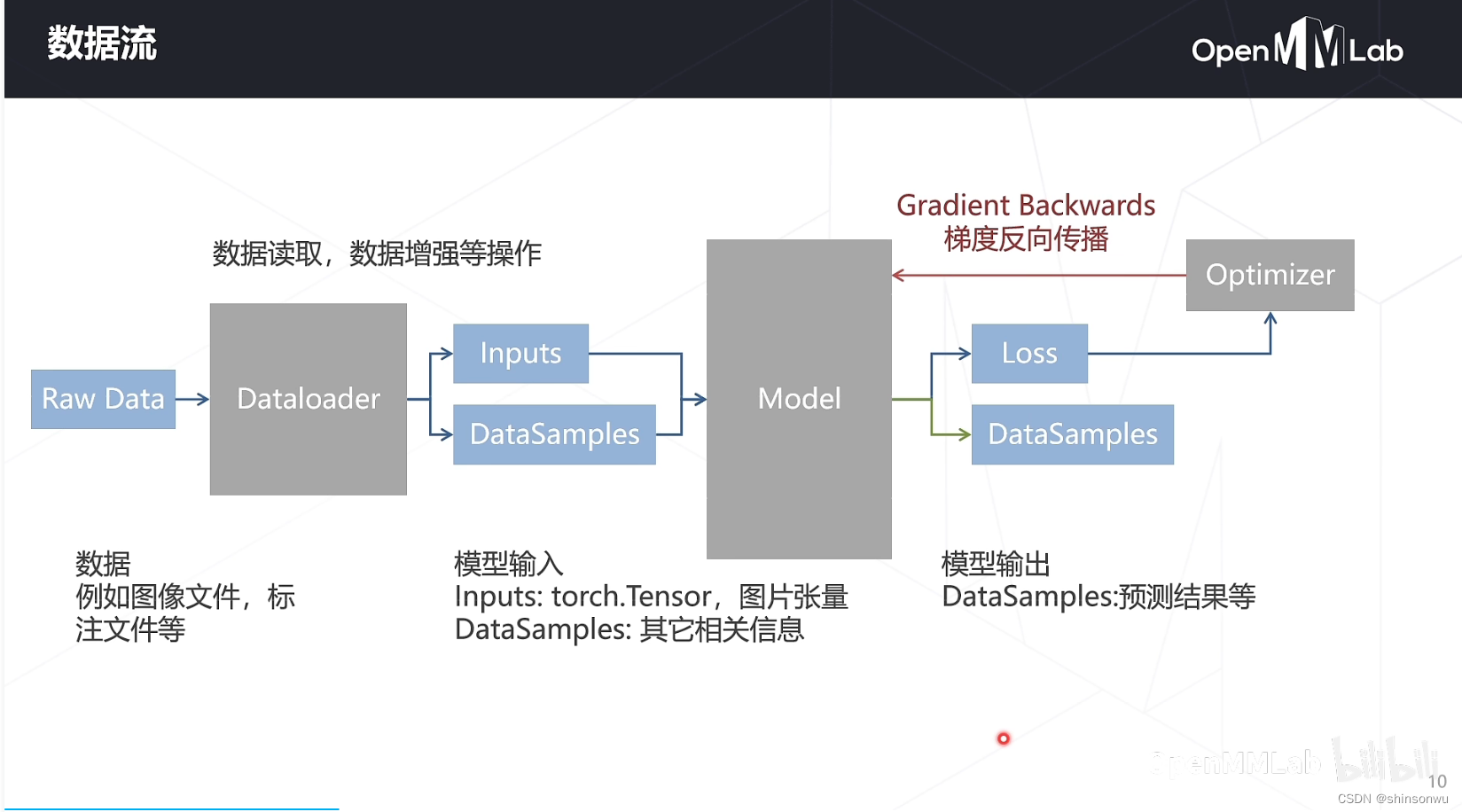

整个数据流从Dataloader开始接入,进行采样,模型训练和梯度反向传播

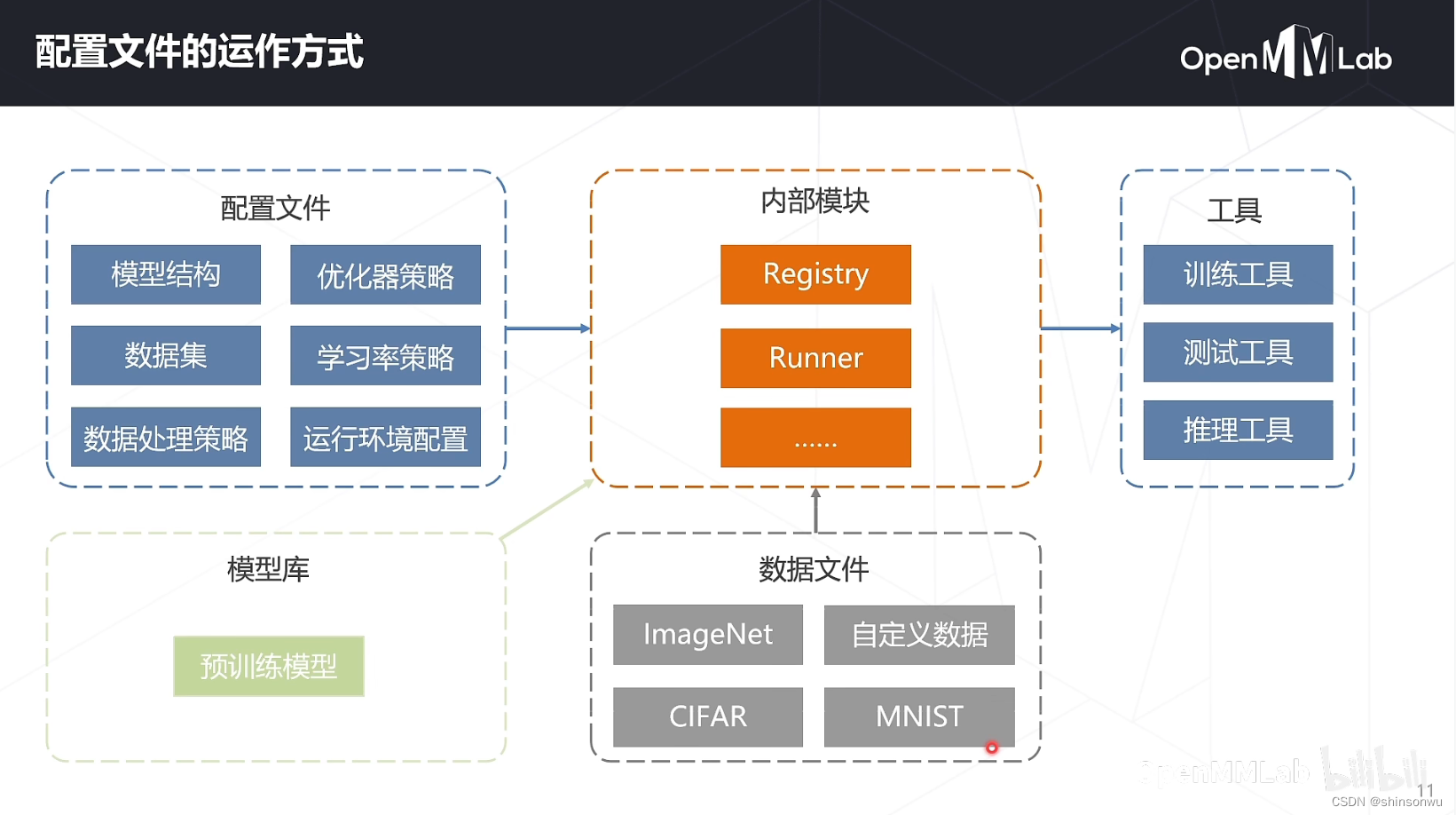

配置的方式,主要是对接到内部的一些模块和一些工具,可以参考下图介绍的方式

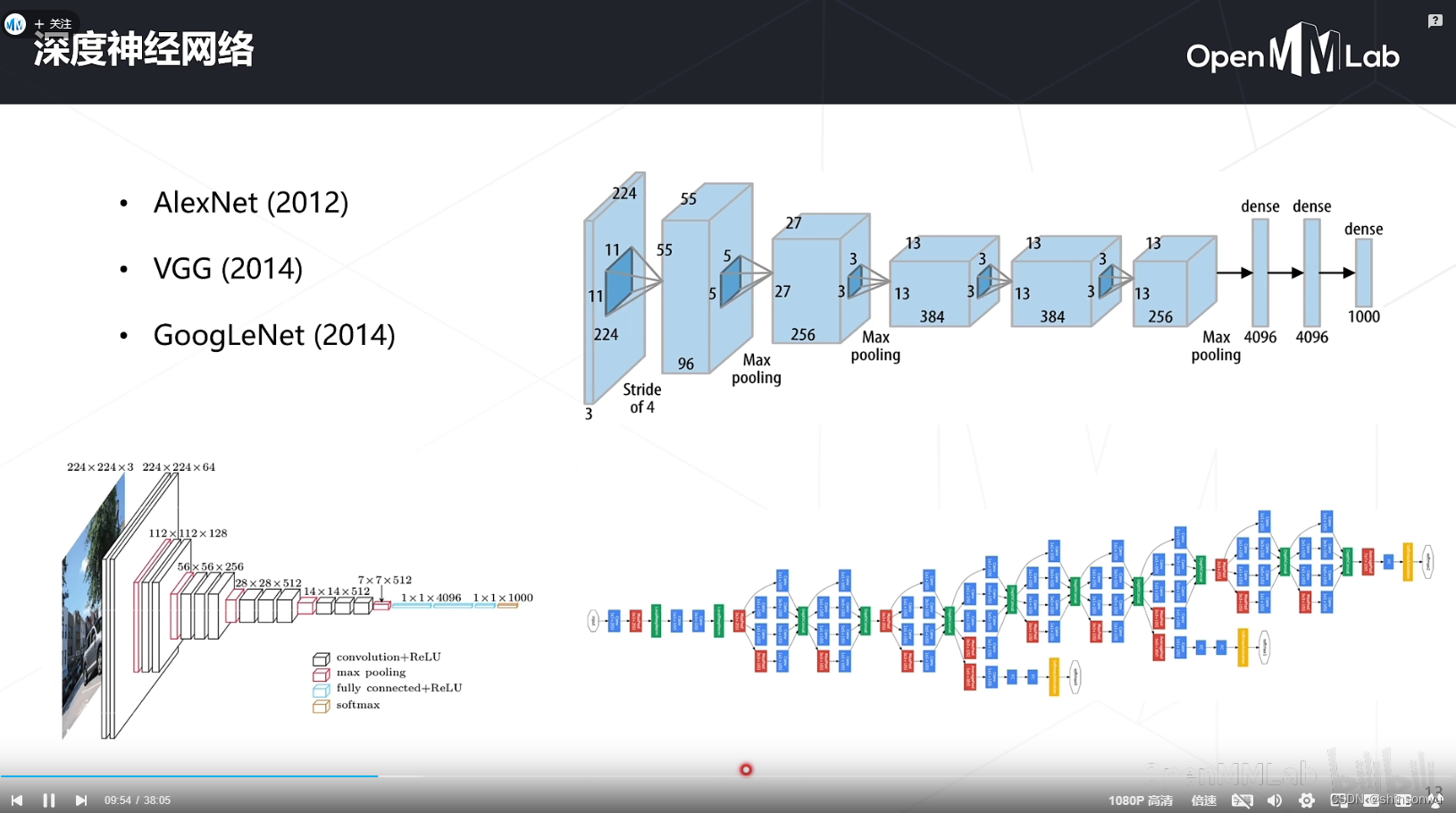

经典主干网络

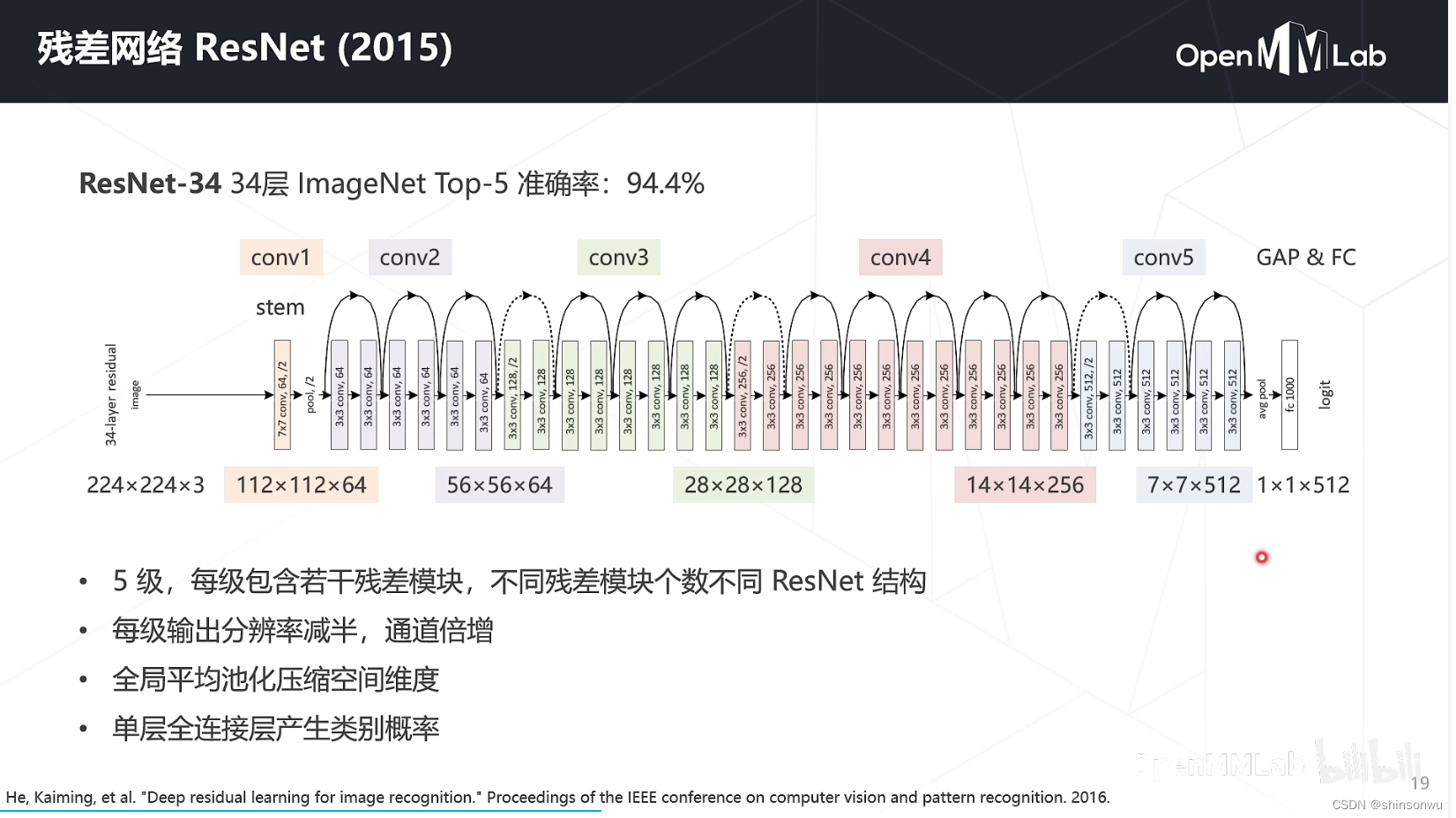

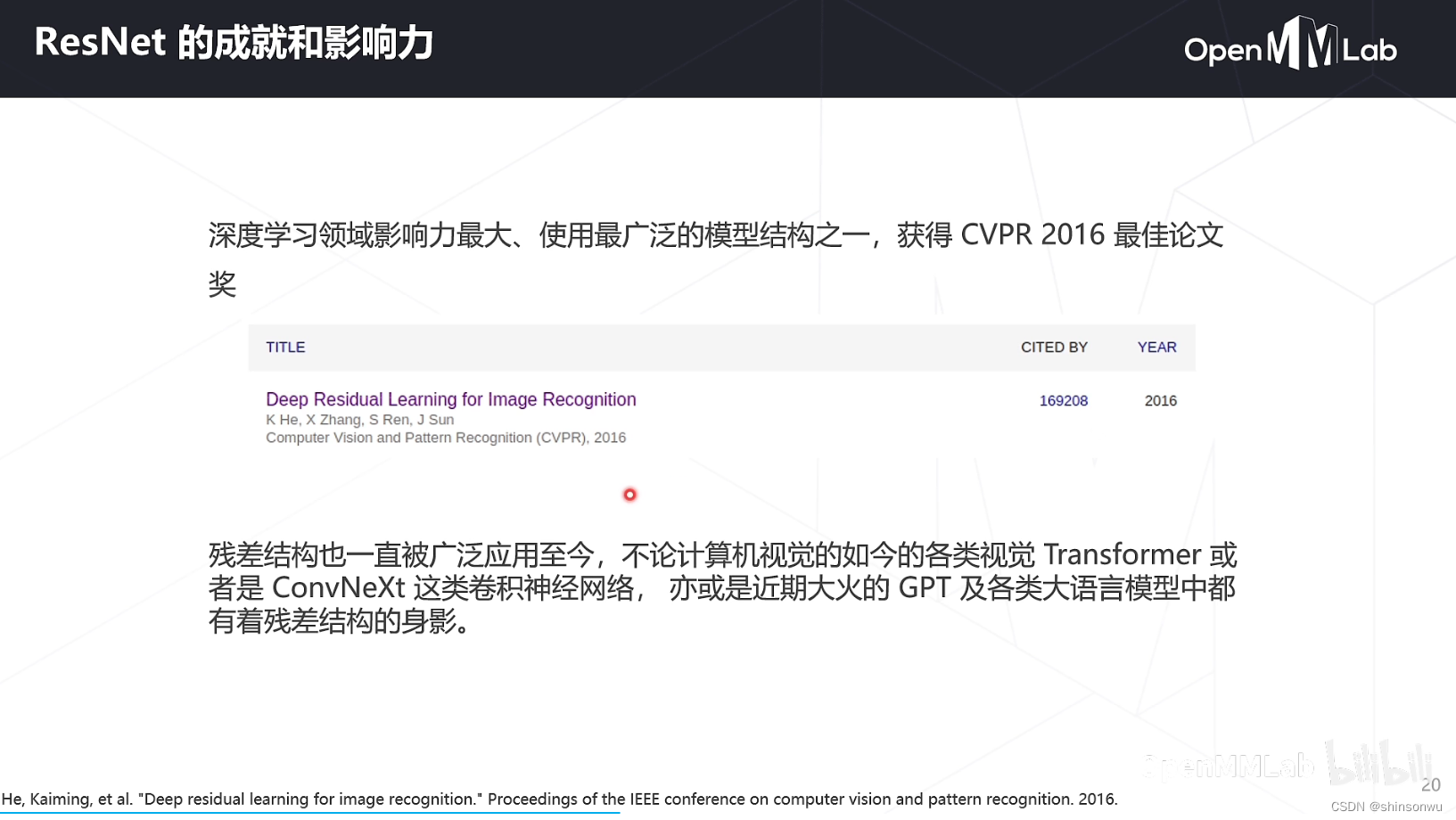

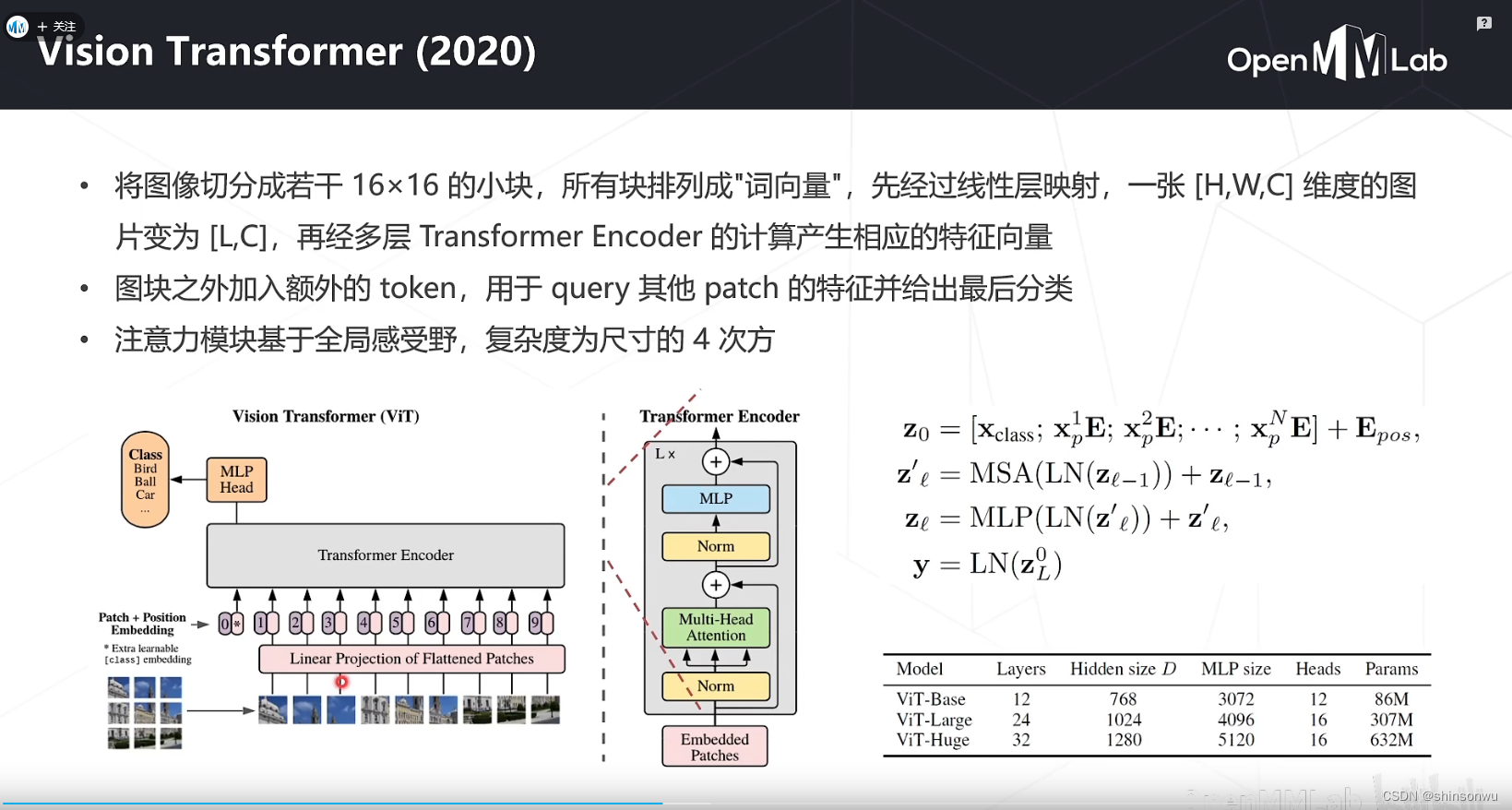

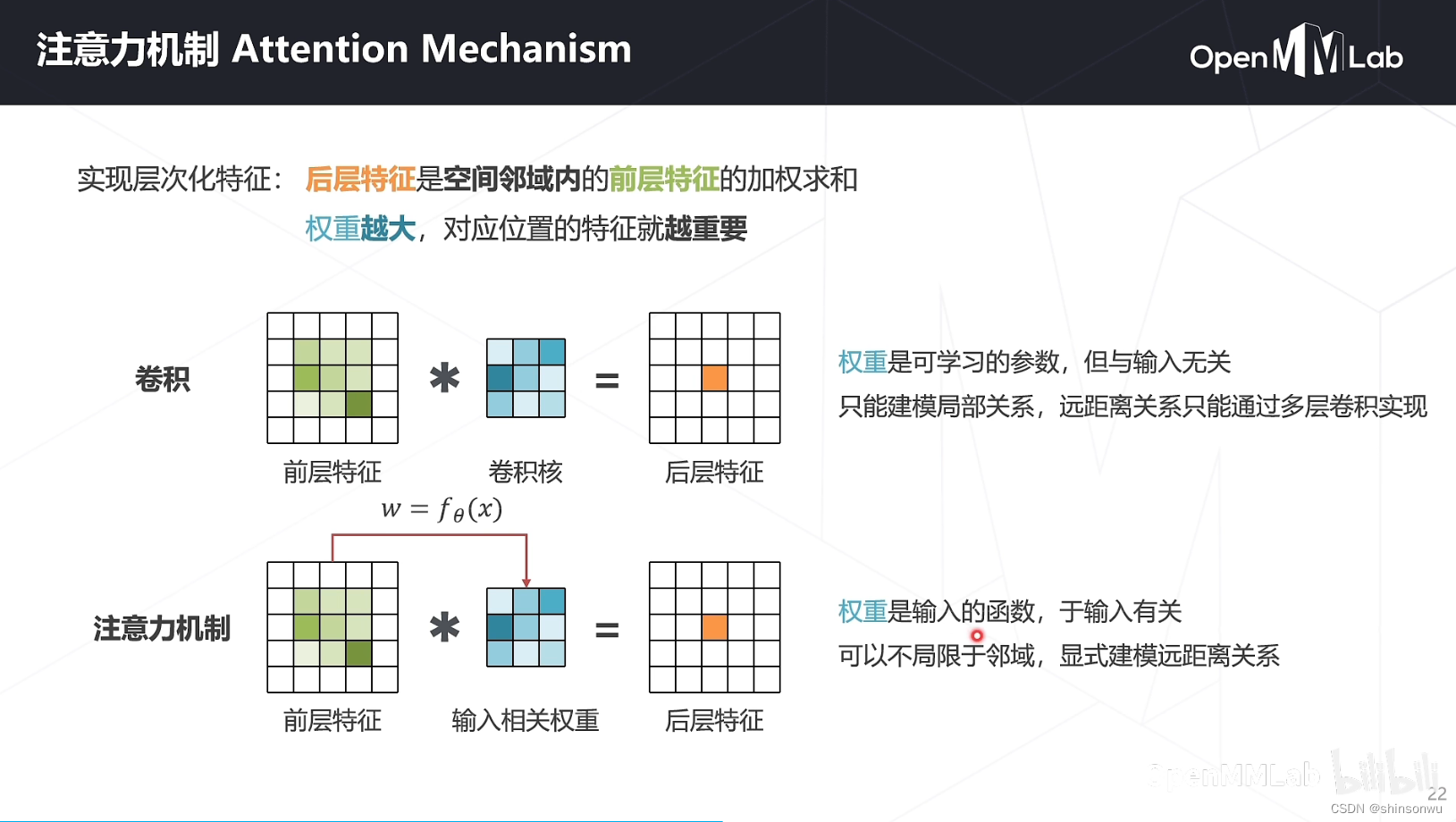

经典的主干网络是在视觉和自然语言处理任务中最常用的网络之一。其中,ResNet和Vision Transformer是两个最著名的主干网络。ResNet,即深度残差网络,通过引入“残差块”来解决深度神经网络中的梯度消失和表示瓶颈问题。Vision Transformer (ViT) 从Transformer模型中借鉴思想,直接将图像像素处理为序列数据,进行端到端的图像分类学习。这些主干网络在各种预训练任务中都表现出了出色的性能,是深度学习领域中不可或缺的重要组成部分。

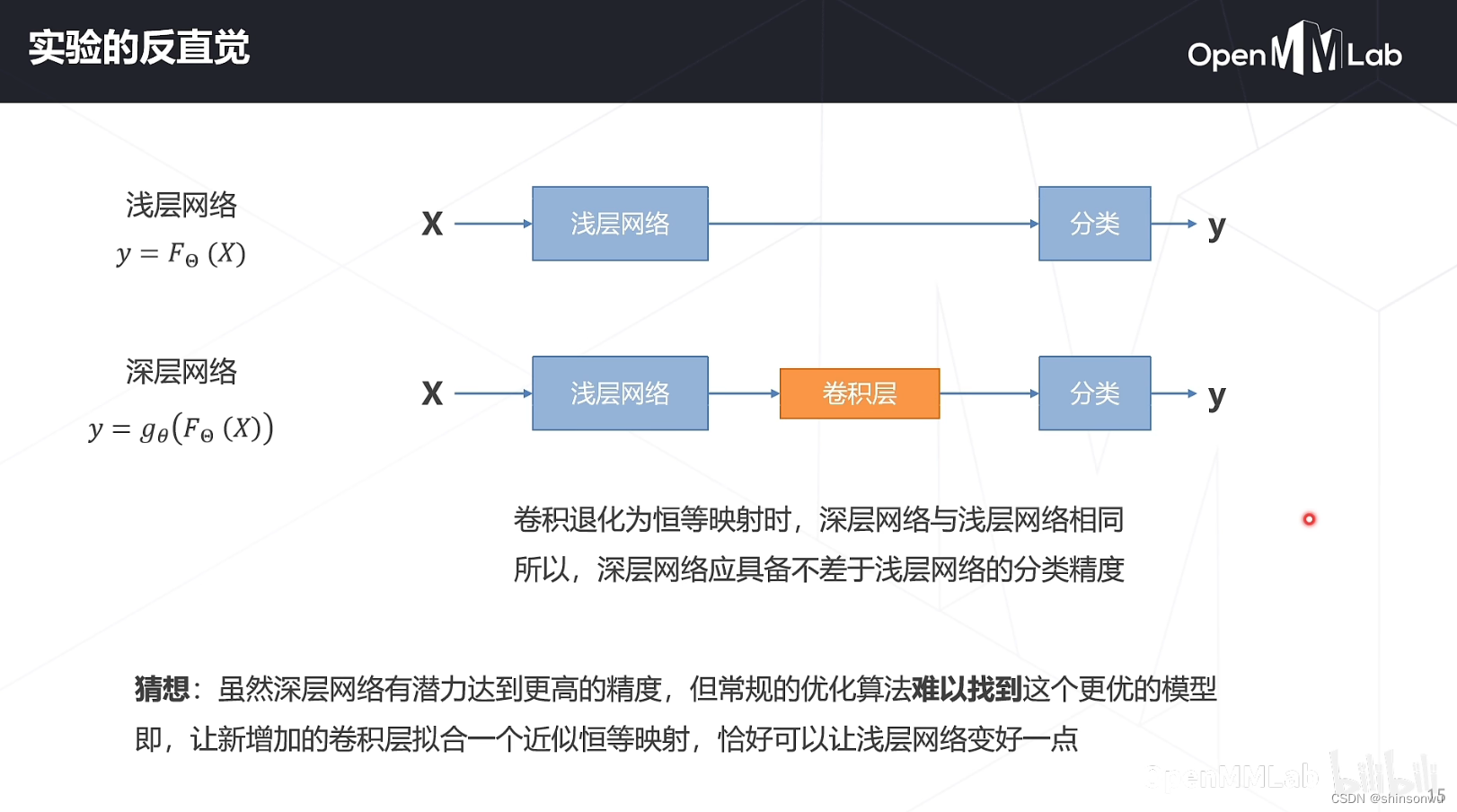

理论上增加模型层数到阈值后,会让模型精度不升反降,引出残差的思想。

ResNet2015,论文引用让人惊叹啊!!!!

VIT(2020)

不太熟悉,但是知道CV很重要,经常看到VIT缩写。这边也学习了一下,看的云里雾里。需要后面再查查资料

Attention机制

同上,经常看到,做了简单了解。

自监督学习

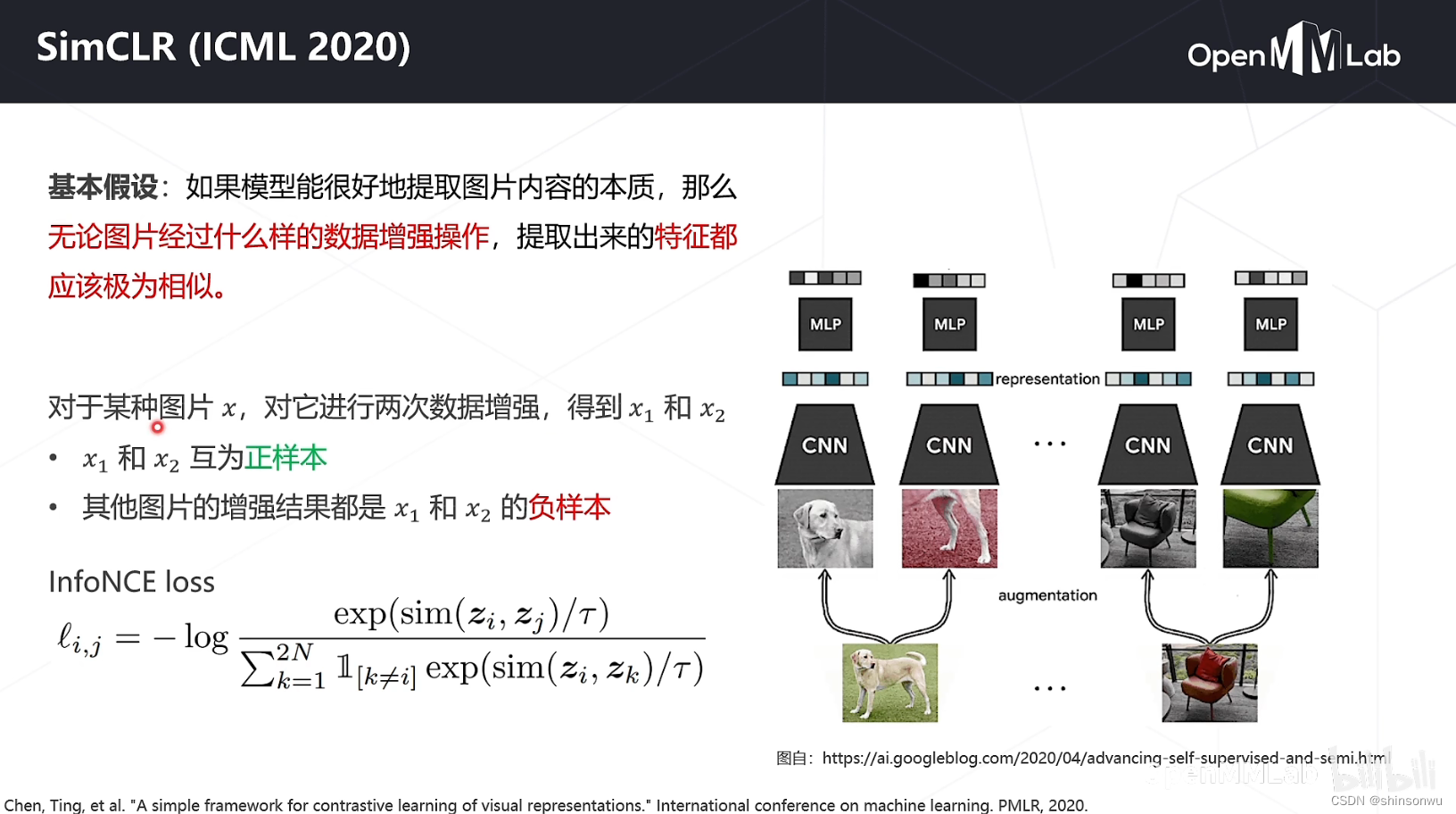

重点看了一下SimCLR(ICML2020)

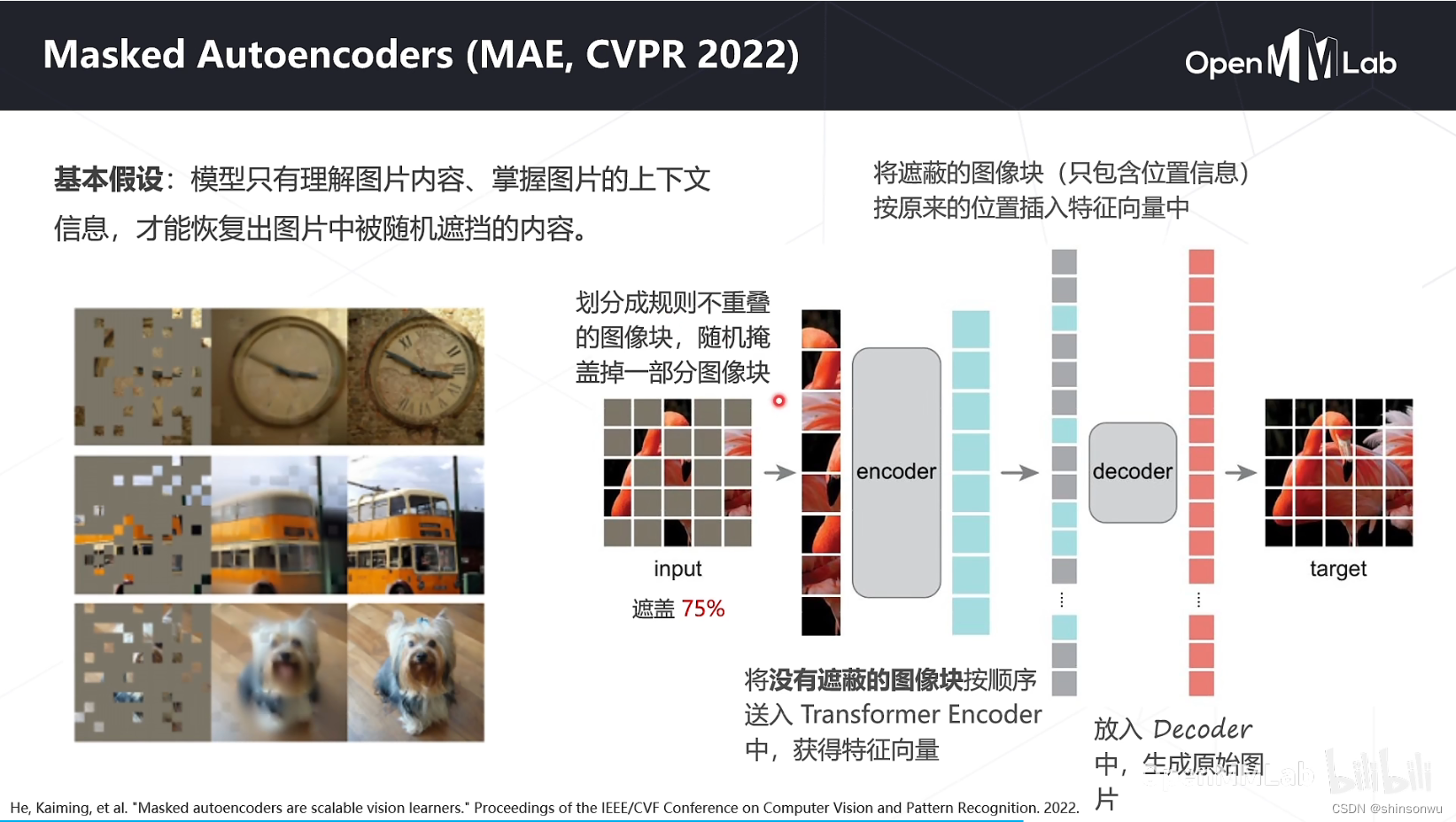

MAE(2022)

这个并非机器学习指标MAE,而是掩码自编码

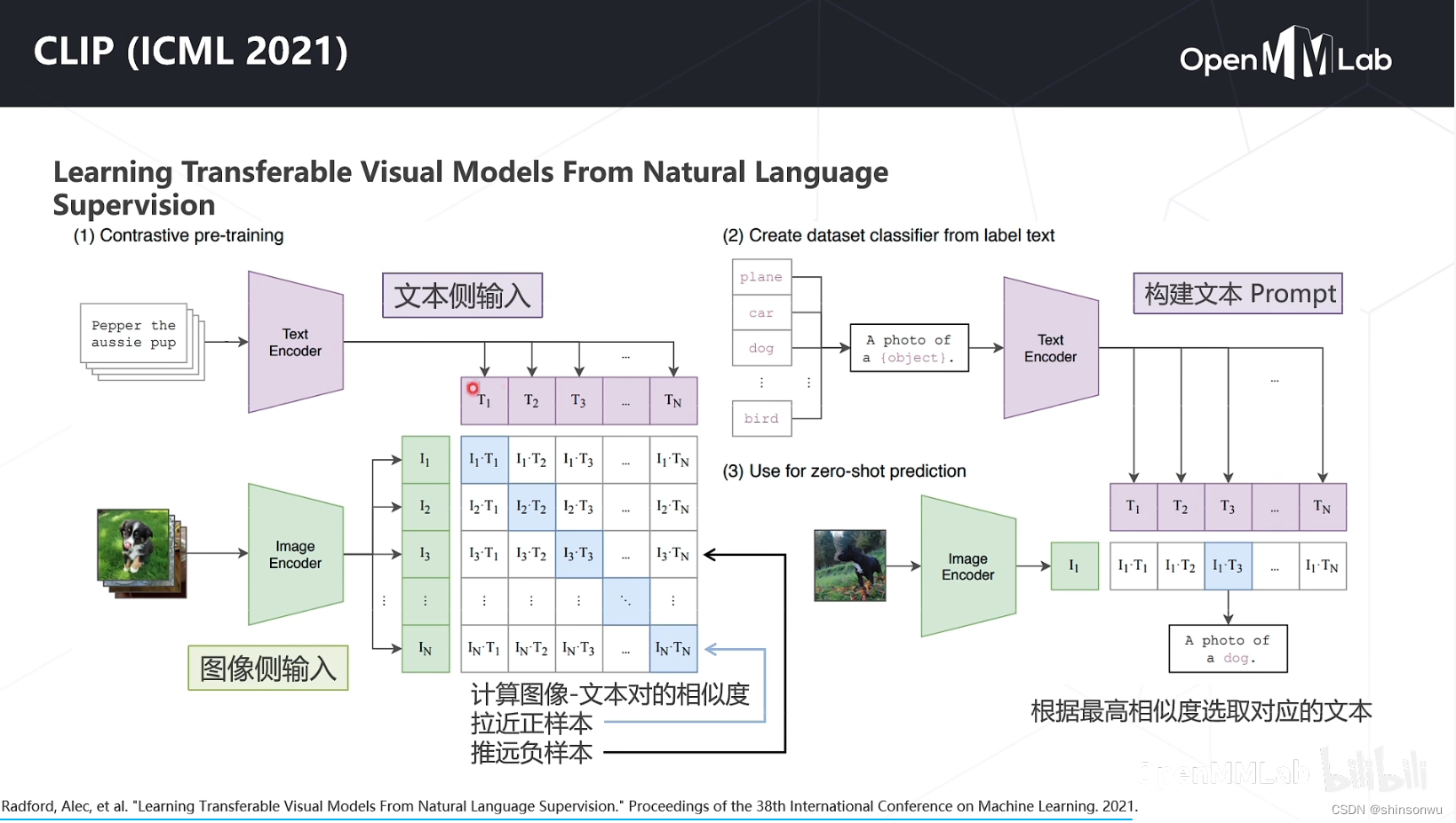

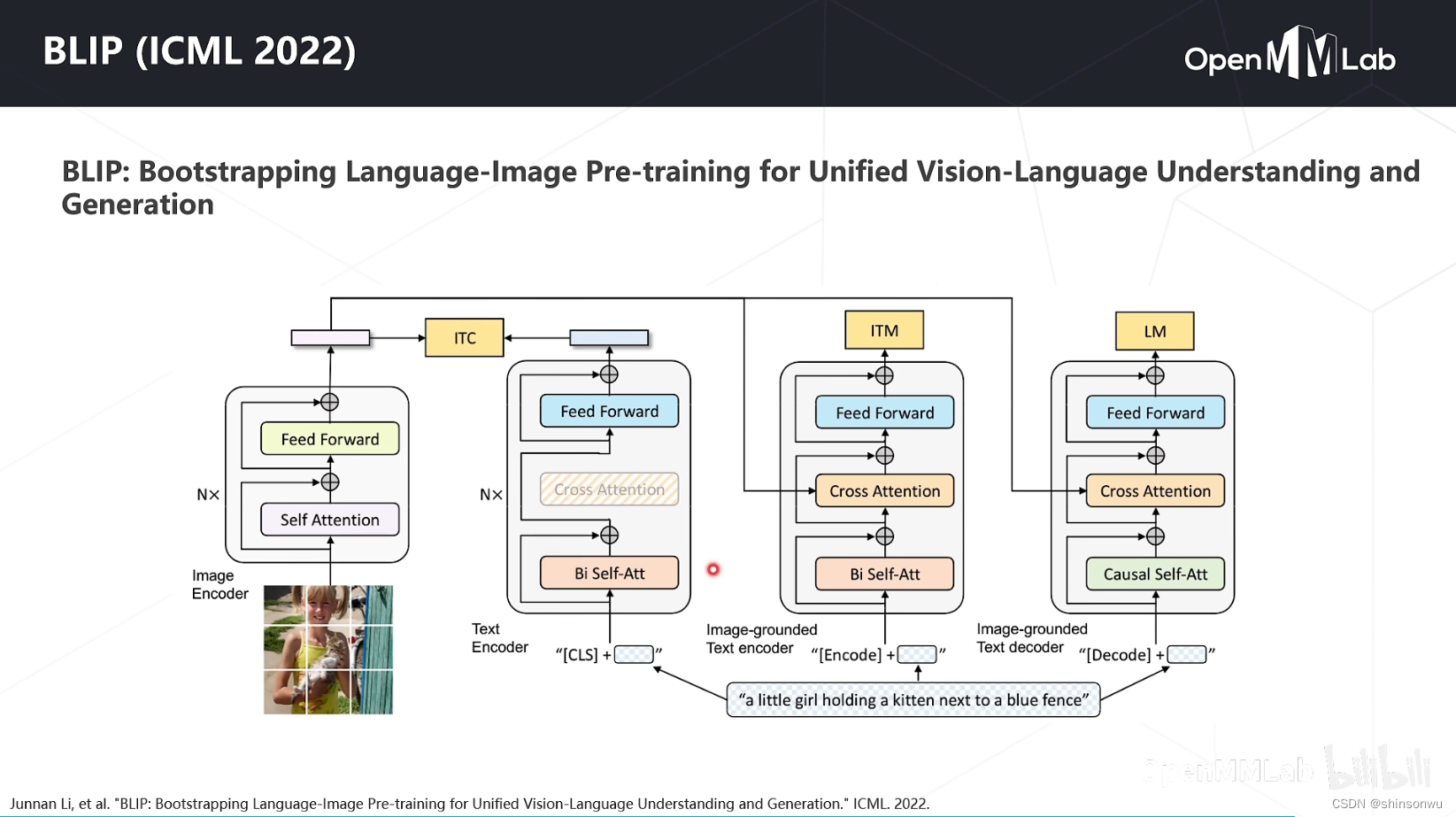

多模态算法

越看越迷糊(深度学习太多东西要补了)

562

562

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?