1、语料相关说明

第一种方法是去网上下载相关语料,我这里有一个英文语料模型点我下载,它适合于使用word2vec英文训练的语料,约96M,包括常用的英文词汇。

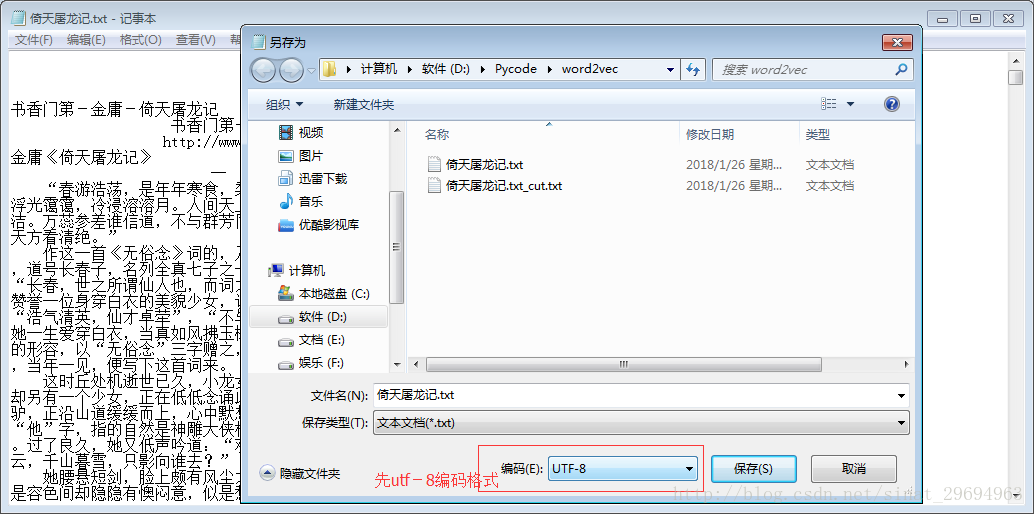

而由于中文语料比较少,暂时也是写前期代码测试,就去网上下载了《倚天屠龙记》小说全集,为txt格式,作为训练文本,此文件较小,不能达到很好的训练效果。

2、中文训练语料的处理

首先去网上下载了这本小说,然后将其打开后另存为,注意选utf-8编码格式。

文本文件准备好,现在开始用python对此txt文档进行处理。

# 此函数作用是对初始语料进行分词处理后,作为训练模型的语料

def cut_txt(old_file):

import jieba

global cut_file # 分词之后保存的文件名

cut_file = old_file + '_cut.txt'

try:

fi = open(old_file, 'r', encoding='utf-8')

except BaseException as e: # 因BaseException是所有错误的基类,用它可以获得所有错误类型

print(Exception, ":", e) # 追踪错误详细信息

text = fi.read() # 获取文本内容

new_text = jieba.cut(text, cut_all=False) # 精确模式

str_out = ' '.join(new_text).replace(',', '').replace('。', '').replace('?', '').replace('!', '') \

.replace('“', '').replace('”', '').replace(':', '').replace('…', '').replace('(', '').replace(')', '') \

.replace('—', '').replace('《', '').replace('》', '').replace('、', '').replace('‘', '') \

.replace('’', '') # 去掉标点符号

fo = open(cut_file, 'w', encoding='utf-8')

fo.write(str_out)注意open中必须指明编码方式,否则就会报错;上面的函数若要单独运行,须要更改old_file变量为原文件名。

3、训练模型

准备好训练语料(注意训练语料文件越大越好,越大最后的训练效果越好),之后就开始写训练模型了,训练模型的代码如下所示:

def model_train(train_file_name, save_model_file): # model_file_name为训练语料的路径,save_model为保存模型名

from gensim.models import word2vec

import gensim

import logging

# 模型训练,生成词向量

logging.basicConfig(format='%(asctime)s : %(levelname)s : %(message)s', level=logging.INFO)

sentences = word2vec.Text8Corpus(train_file_name) # 加载语料

model = gensim.models.Word2Vec(sentences, size=200) # 训练skip-gram模型; 默认window=5

model.save(save_model_file)

model.wv.save_word2vec_format(save_model_name + ".bin", binary=True) # 以二进制类型保存模型以便重用训练后的模型用普通方式和二进制方式进行保存,以便下次直接使用,避免每次训练耗费大量时间。

4、word2vec模型调用

两个功能都以函数方式实现了,现在准备编写主函数代码,在主函数中负责调用各个方法实现预处理和模型训练,以此做后面的相关计算。

from gensim.models import word2vec

import os

import gensim

# if not os.path.exists(cut_file): # 判断文件是否存在,参考:https://www.cnblogs.com/jhao/p/7243043.html

cut_txt('倚天屠龙记.txt') # 须注意文件必须先另存为utf-8编码格式

save_model_name = '倚天屠龙记.model'

if not os.path.exists(save_model_name): # 判断文件是否存在

model_train(cut_file, save_model_name)

else:

print('此训练模型已经存在,不用再次训练')

# 加载已训练好的模型

model_1 = word2vec.Word2Vec.load(save_model_name)

# 计算两个词的相似度/相关程度

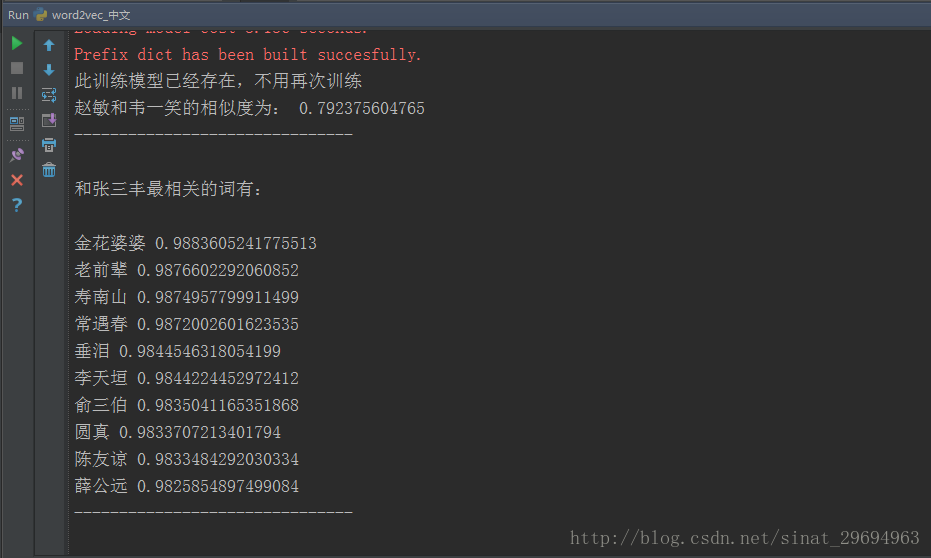

y1 = model_1.similarity("赵敏", "韦一笑")

print(u"赵敏和韦一笑的相似度为:", y1)

print("-------------------------------\n")

# 计算某个词的相关词列表

y2 = model_1.most_similar("张三丰", topn=10) # 10个最相关的

print(u"和张三丰最相关的词有:\n")

for item in y2:

print(item[0], item[1])

print("-------------------------------\n")最后的运行结果如下所示:

最终的结果一定程序上还是取决于分词的准确率,使用jieba分词时可以针对性的加入用户自定义词典(jieba.load_userdict(“userDict.txt”) # 加载用户自定义词典),可以提高对人名,地名等未登陆词的识别效果,提高分词性能。

如有问题,欢迎留言指出,共同进步。

272

272

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?